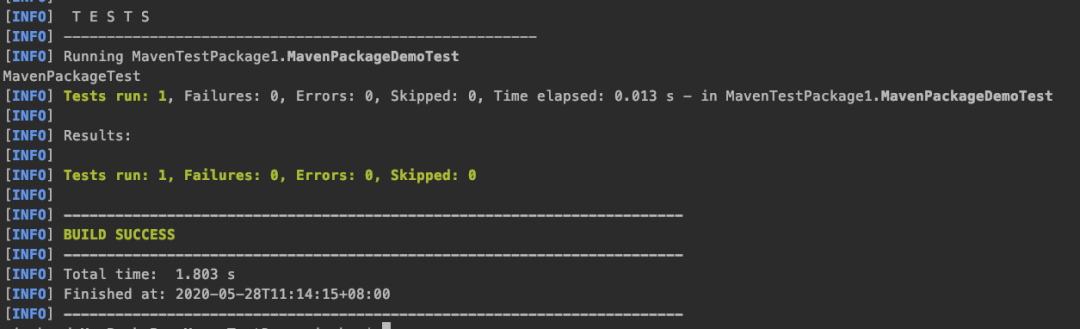

docker复杂安装

之前是单机版,自娱自乐还是不错滴,但是如果是生产开发环境中是需要复杂集群安装的

1.安装mysql主从复制

1.1主从复制原理(记得补)

1.2主从搭建步骤

-

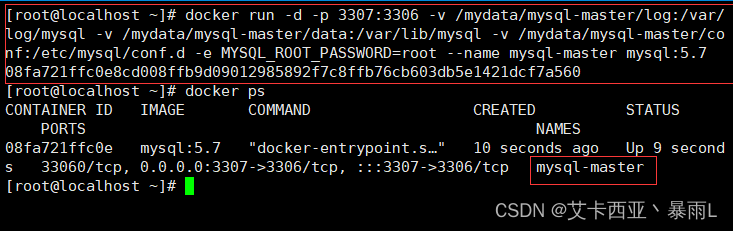

新建主服务器容器实例3307

命令:

docker run -d -p 3307:3306 -v /mydata/mysql-master/log:/var/log/mysql -v /mydata/mysql-master/data:/var/lib/mysql -v /mydata/mysql-master/conf:/etc/mysql -e MYSQL_ROOT_PASSWORD=root --name mysql-master mysql:5.7//不要直接复制该代码,只是为了观察方便 docker run -d -p 3307:3306 -v /mydata/mysql-master/log:/var/log/mysql -v /mydata/mysql-master/data:/var/lib/mysql -v /mydata/mysql-master/conf:/etc/mysql -e MYSQL_ROOT_PASSWORD=root --name mysql-master mysql:5.7注意:路径前面的/记得加

-

进入

/mydata/mysql-master/conf目录下新建my.cnf[mysqld] ## 设置server_id,同一局域网中需要唯一 server_id=101 ## 指定不需要同步的数据库名称 binlog-ignore-db=mysql ## 开启二进制日志功能 log-bin=mall-mysql-bin ## 设置二进制日志使用内存大小(事务) binlog_cache_size=1M ## 设置使用的二进制日志格式(mixed,statement,row) binlog_format=mixed ## 二进制日志过期清理时间。默认值为0,表示不自动清理。 expire_logs_days=7 ## 跳过主从复制中遇到的所有错误或指定类型的错误,避免slave端复制中断。 ## 如:1062错误是指一些主键重复,1032错误是因为主从数据库数据不一致 slave_skip_errors=1062 -

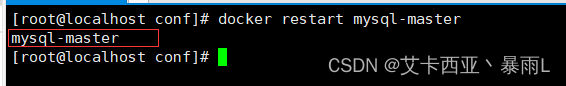

修改配置后重启master实例

命令:

docker restart mysql-master

-

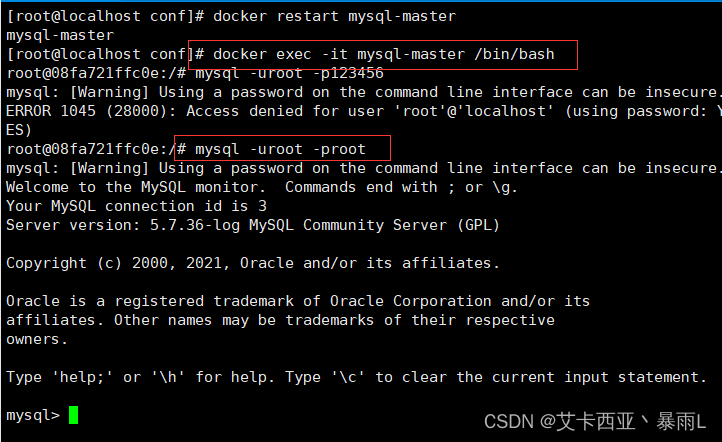

进入mysql-master容器

命令1:

docker exec -it mysql-master /bin/bash

命令2:mysql -uroot -proot

-

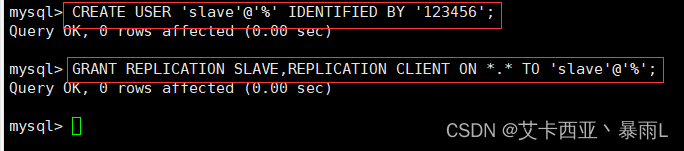

master容器实例内创建数据同步用户

命令1:

CREATE USER 'slave'@'%' IDENTIFIED BY '123456';

命令2:GRANT REPLICATION SLAVE,REPLICATION CLIENT ON *.* TO 'slave'@'%';

-

新建服务器容器实例3308

命令:

docker run -d -p 3308:3306 -v /mydata/mysql-slave/log:/var/log/mysql -v /mydata/mysql-slave/data:/var/lib/mysql -v /mydata/mysql-slave/conf:/etc/mysql -e MYSQL_ROOT_PASSWORD=root --name mysql-slave mysql:5.7//不要直接复制该代码,只是为了观察方便 docker run -d -p 3308:3306 -v /mydata/mysql-slave/log:/var/log/mysql -v /mydata/mysql-slave/data:/var/lib/mysql -v /mydata/mysql-slave/conf:/etc/mysql -e MYSQL_ROOT_PASSWORD=root --name mysql-slave mysql:5.7注意:就是将上面主机的master改成了slave

-

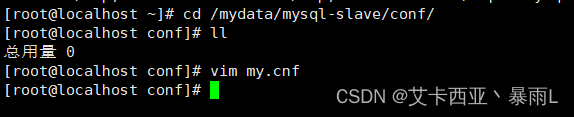

进入

/mydata/mysql-slave/conf目录下新建my.cnf[mysqld] ## 设置server_id,同一局域网中需要唯一 server_id=102 ## 指定不需要同步的数据库名称 binlog-ignore-db=mysql ## 开启二进制日志功能,以备Slave作为其它数据库实例的Master时使用 log-bin=mall-mysql-slave1-bin ## 设置二进制日志使用内存大小(事务) binlog_cache_size=1M ## 设置使用的二进制日志格式(mixed,statement,row) binlog_format=mixed ## 二进制日志过期清理时间。默认值为0,表示不自动清理。 expire_logs_days=7 ## 跳过主从复制中遇到的所有错误或指定类型的错误,避免slave端复制中断。 ## 如:1062错误是指一些主键重复,1032错误是因为主从数据库数据不一致 slave_skip_errors=1062 ## relay_log配置中继日志 relay_log=mall-mysql-relay-bin ## log_slave_updates表示slave将复制事件写进自己的二进制日志 log_slave_updates=1 ## slave设置为只读(具有super权限的用户除外) read_only=1

-

修改完配置后重启slave实例

命令:

docker restart mysql-slave -

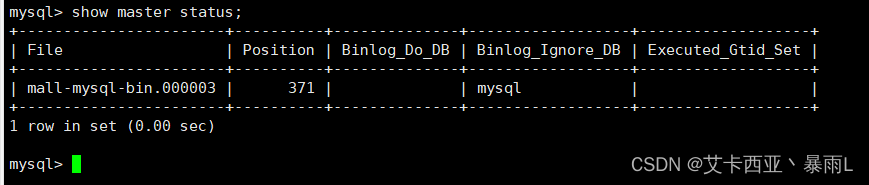

在主数据库中查看主从同步状态

在主机的mysql内部执行命令:

show master status;

-

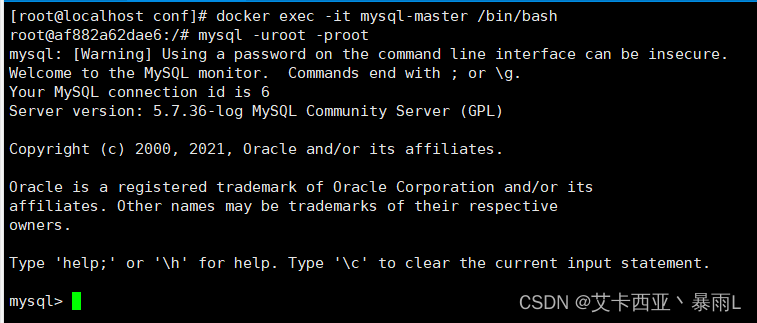

进入mysql-slave容器

命令1:

docker exec -it mysql-slave /bin/bash

命令2:mysql -uroot -proot

-

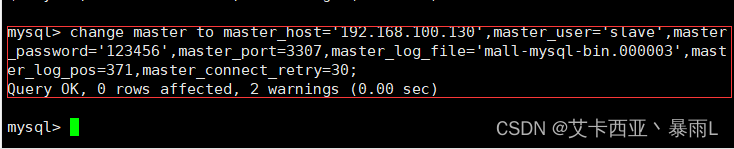

在

从数据库中配置主从复制命令:

change master to master_host='宿主机ip',master_user='slave',master_password='123456',master_port=3307,master_log_file='mall-mysql-bin.000003',master_log_pos=371,master_connect_retry=30;

注意这一步的master_log_file='mall-mysql-bin.000003',master_log_pos=371是根据第九步查看主从同步状态而来的

master_host:主数据库的IP地址;

master_port:主数据库的运行端口;

master_user:在主数据库创建的用于同步数据的用户账号;

master_password:在主数据库创建的用于同步数据的用户密码;

master_log_file:指定从数据库要复制数据的日志文件,通过查看主数据的状态,获取File参数;

master_log_pos:指定从数据库从哪个位置开始复制数据,通过查看主数据的状态,获取Position参数;

master_connect_retry:连接失败重试的时间间隔,单位为秒。 -

在

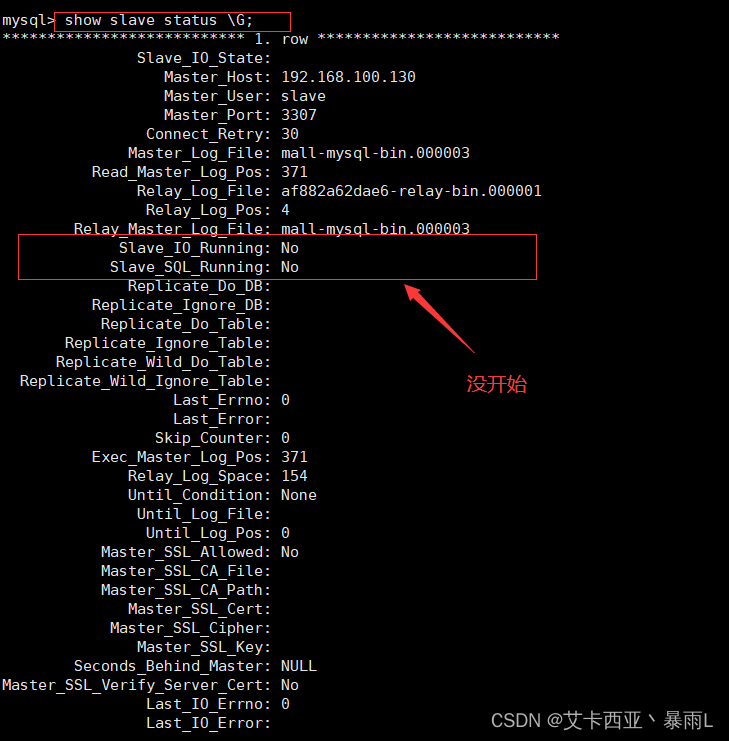

从数据库中查看主从同步状态命令:

show slave status \G;show slave status是横着的表格形式

show slave status \G;是竖着的键值对形式

-

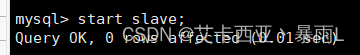

在

从数据库中开启主从同步命令:

start slave;

-

查看从数据库状态发现已经同步

命令:

show slave status \G;

这里之前的操作有误,所以重新配置了一下,然后有些参数有些变化,

-

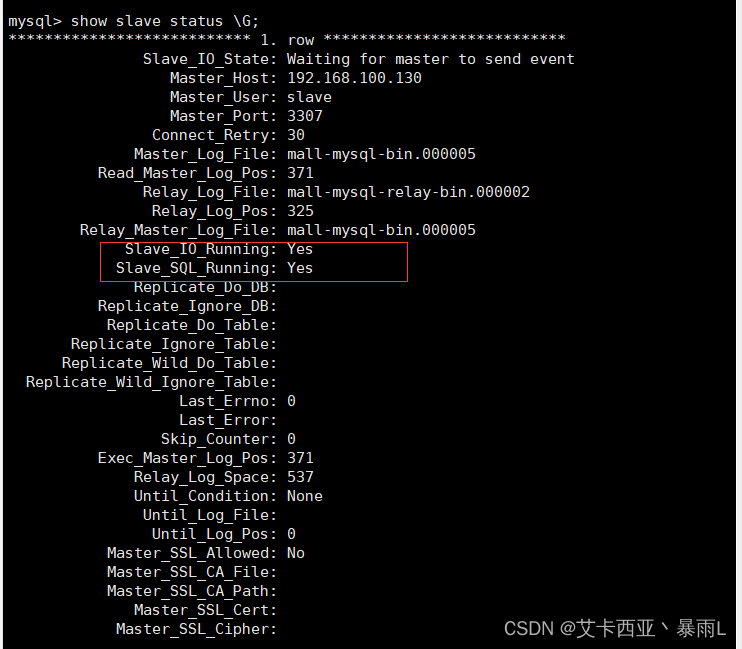

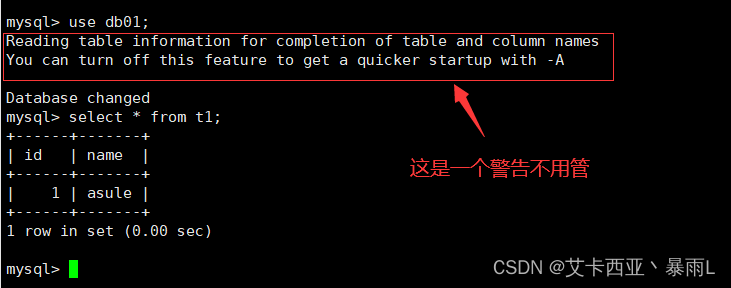

主从复制测试

主机新建库-使用库-新建表-插入数据

从机使用库-查看记录

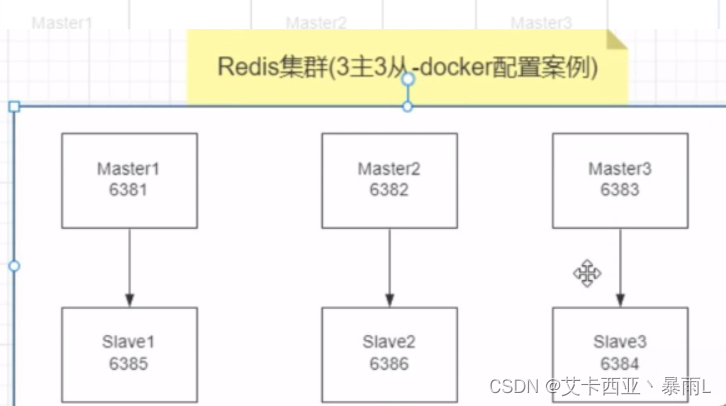

2.安装redis集群

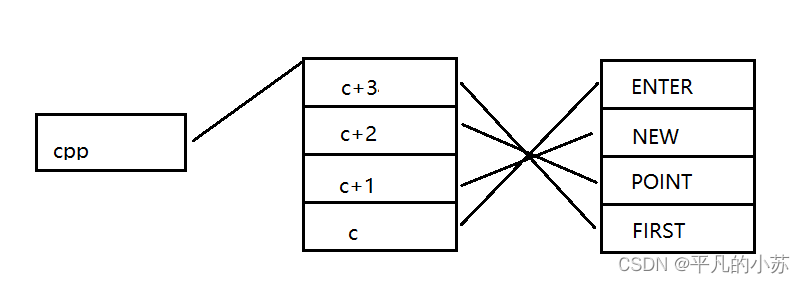

3主3从redis集群扩缩容配置案例架构说明

2.1三主三从redis集群配置

-

关闭防火墙+启动docker后台服务

命令:systemctl start docker -

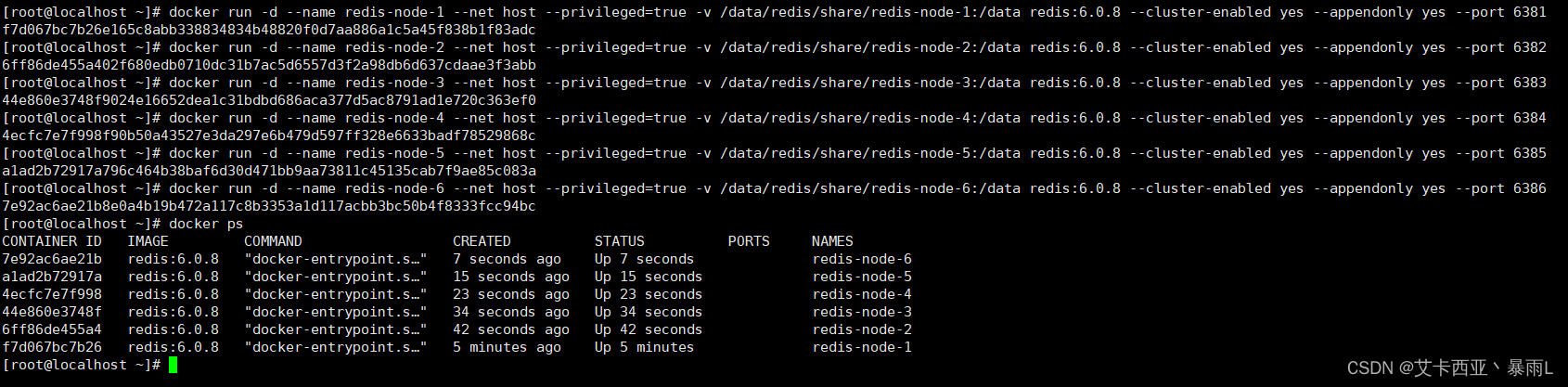

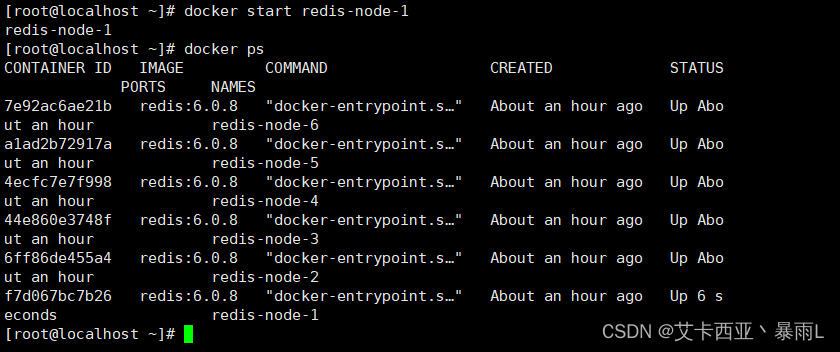

新建6个docker容器实例

命令1:

docker run -d --name redis-node-1 --net host --privileged=true -v /data/redis/share/redis-node-1:/data redis:6.0.8 --cluster-enabled yes --appendonly yes --port 6381

命令2:docker run -d --name redis-node-2 --net host --privileged=true -v /data/redis/share/redis-node-2:/data redis:6.0.8 --cluster-enabled yes --appendonly yes --port 6382

命令3:docker run -d --name redis-node-3 --net host --privileged=true -v /data/redis/share/redis-node-3:/data redis:6.0.8 --cluster-enabled yes --appendonly yes --port 6383

命令4:docker run -d --name redis-node-4 --net host --privileged=true -v /data/redis/share/redis-node-4:/data redis:6.0.8 --cluster-enabled yes --appendonly yes --port 6384

命令5:docker run -d --name redis-node-5 --net host --privileged=true -v /data/redis/share/redis-node-5:/data redis:6.0.8 --cluster-enabled yes --appendonly yes --port 6385

命令6:docker run -d --name redis-node-6 --net host --privileged=true -v /data/redis/share/redis-node-6:/data redis:6.0.8 --cluster-enabled yes --appendonly yes --port 6386docker run创建并运行docker容器实例

--name redis-node-6容器名字

net host使用宿主机的IP和端口,默认

privileged=true获取宿主机root用户权限

-v /data/redis/share/redis-node-6:/data容器卷,宿主机地址:docker内部地址

redis:6.0.8redis镜像和版本号

--cluster-enabled yes是否开启redis集群

appendonly yes开启持久化

--port 6386redis端口号

-

进入容器redis-node-1并为6台机器构建集群关系

-

进入容器

docker exec - redis-node-1 /bin/bash进入docker exec - redis-node-1 /bin/bash -

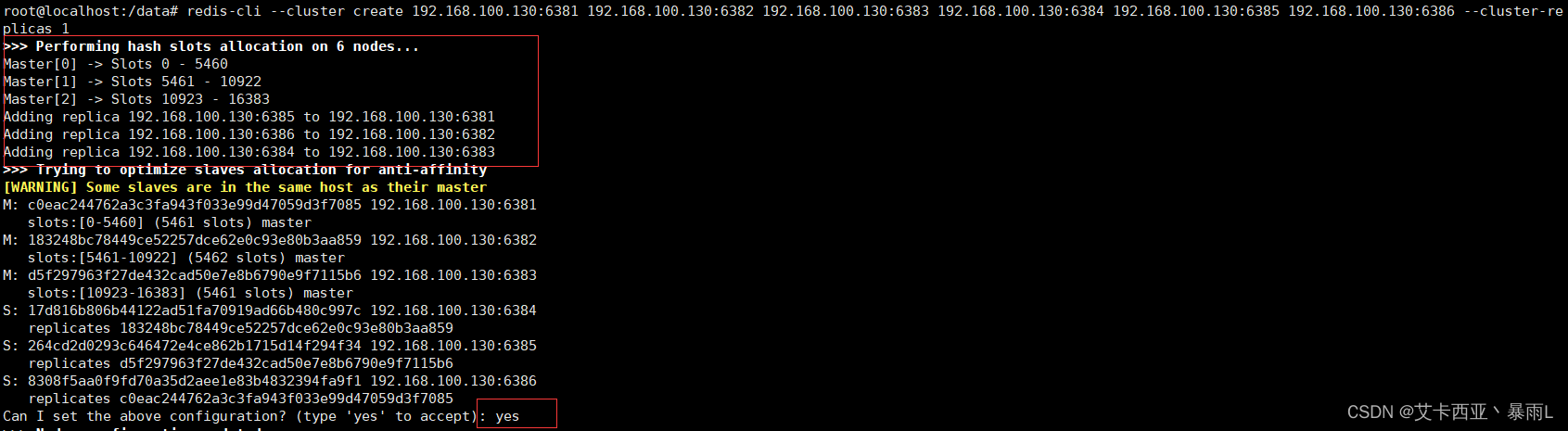

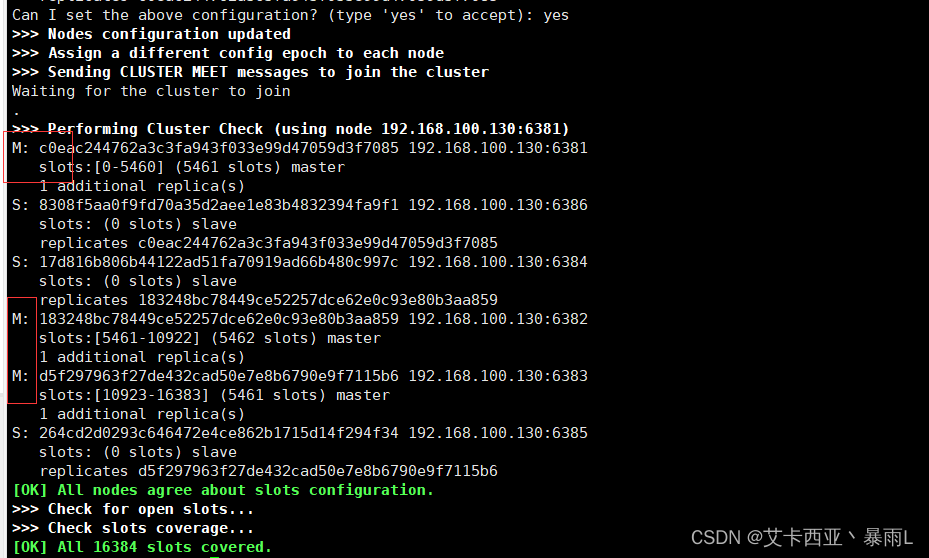

构建主从关系

注意,进入docker容器后才能执行下一条命令,并注意自己的IP地址 命令:

redis-cli --cluster create 192.168.100.130:6381 192.168.100.130:6382 192.168.100.130:6383 192.168.100.130:6384 192.168.100.130:6385 192.168.100.130:6386 --cluster-replicas 1

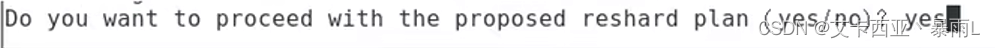

--cluster-replicas 1表示为每个master创建一个slave节点是否接受配置选择yes

M为主机,S为从机

-

-

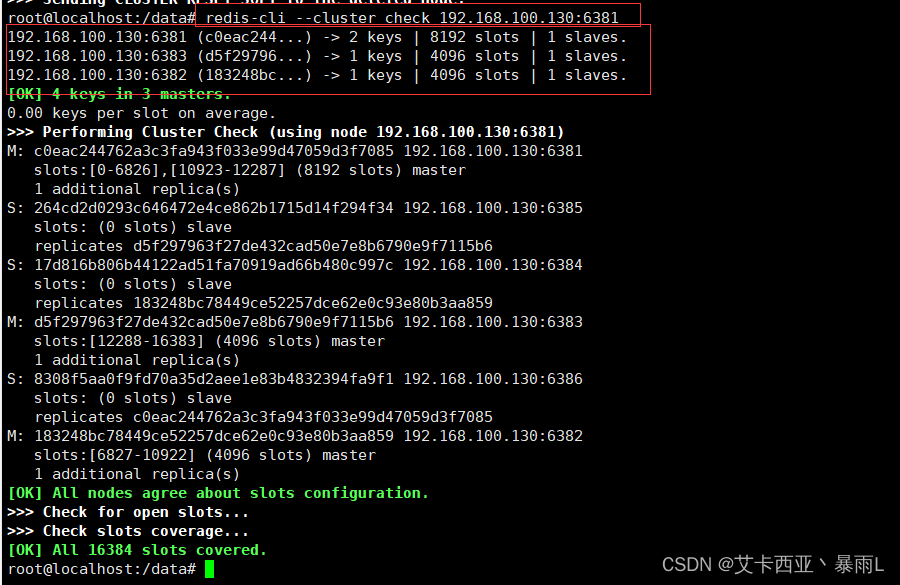

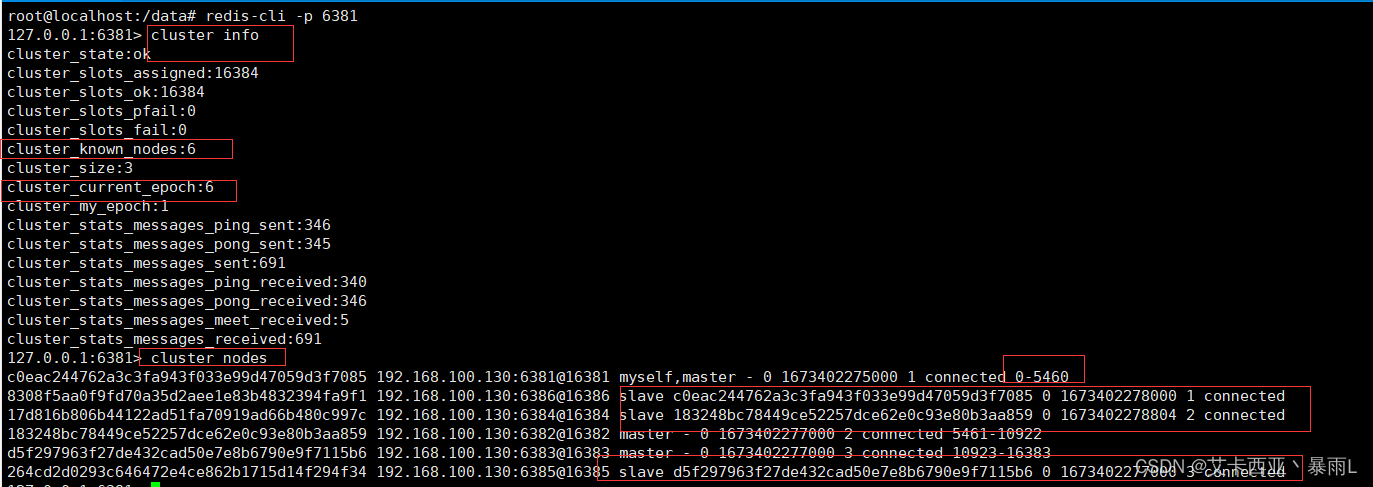

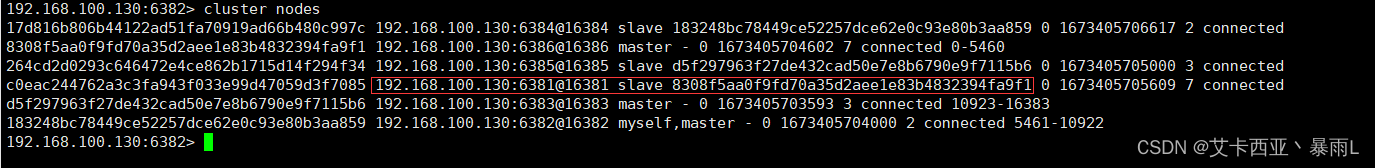

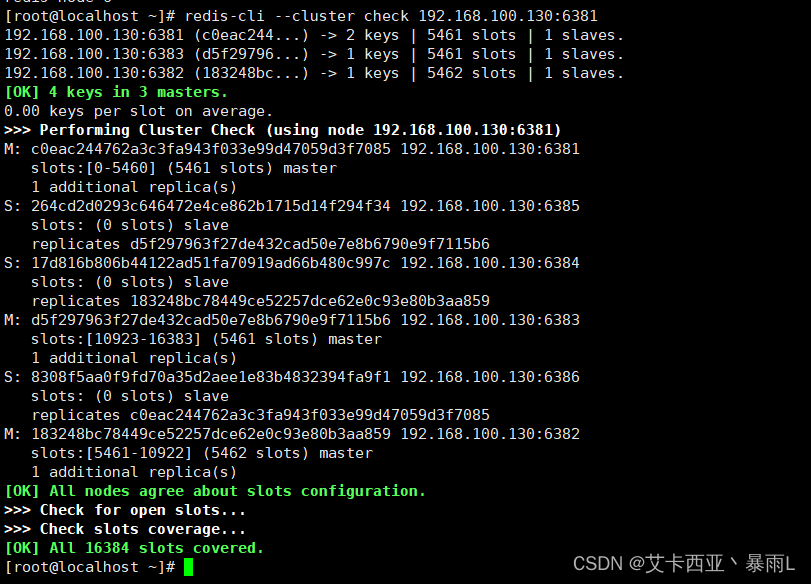

链接6381作为切入点

查看集群状态命令1:

cluster info

命令2:cluster nodesre

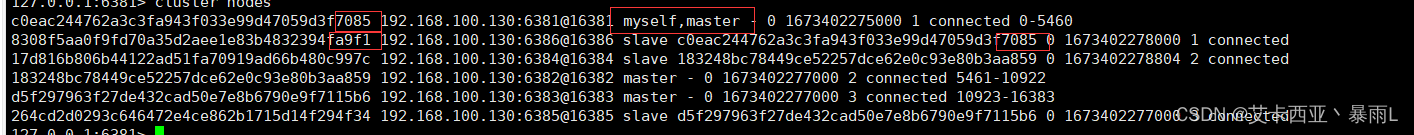

当前进入的主机myself,master对应id 7085下挂载从机id为a9f1的6386

本次随机分配结果M(主机) S(从机) 6381 6386 6382 6384 6383 6385

2.2主从容错切换迁移案例

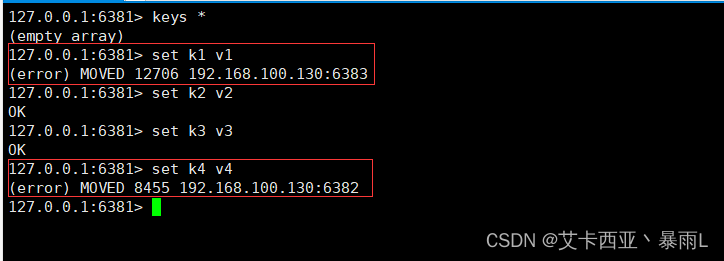

问题1: 能否整个集群共享数据

问题2: 如果master宕机了从机是否会进行补位

问题3: redis集群读写error说明

解答问题3: 我们是根据哈希槽存储,是有分段的,redis-node-1是0~5460的,按照内部的哈希算法,当前的k1超过了5460的话就会存储失败,redis-cli是连上单机命令,但当前我们是集群环境了,因此不能使用单机版的命令,所以要加参数防止路由失效。(见数据读写存储)

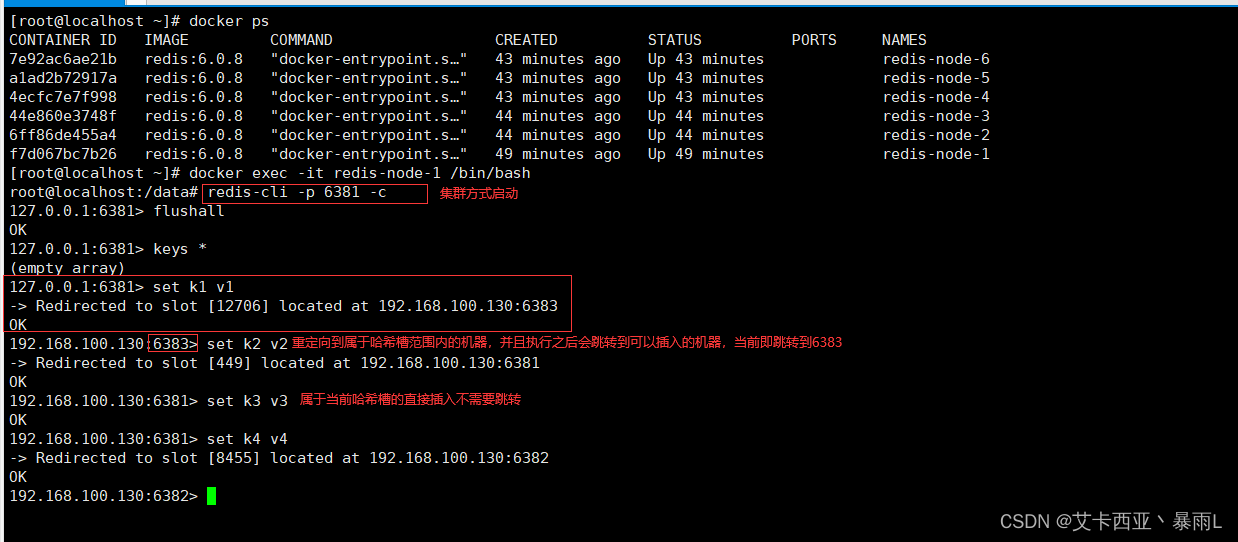

2.2.1数据读写存储

-

启动6台机器构成的集群并通过exec进入

-

对6381新增两个key

-

防止路由失效加参数-c并新增两个key

-

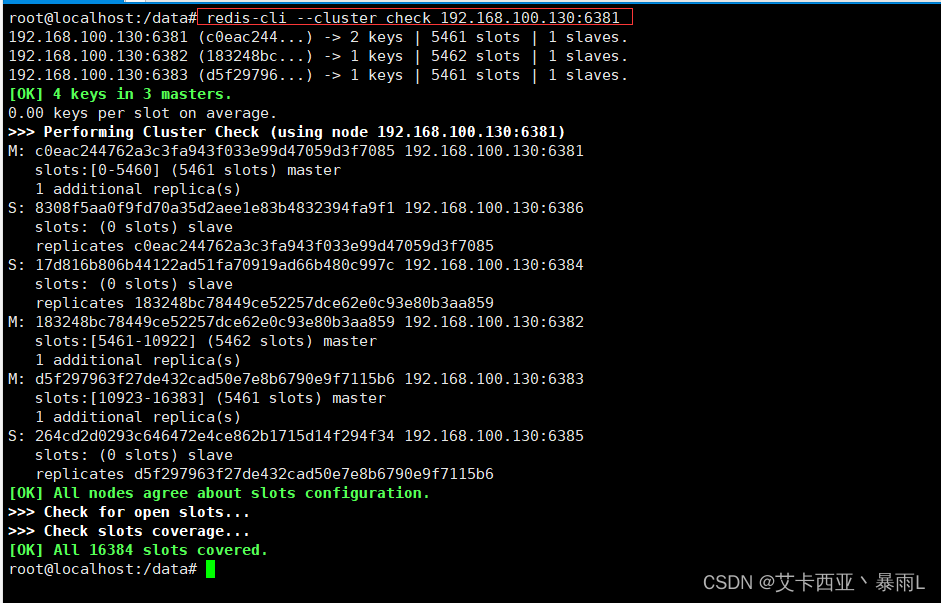

查看集群信息

命令:

redis-cli --cluster check 主机IP:集群端口号

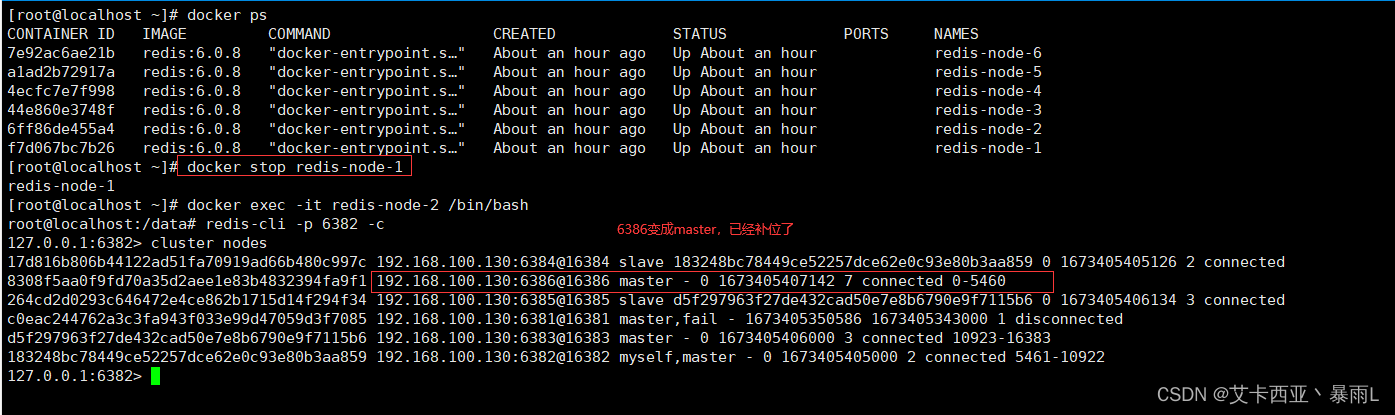

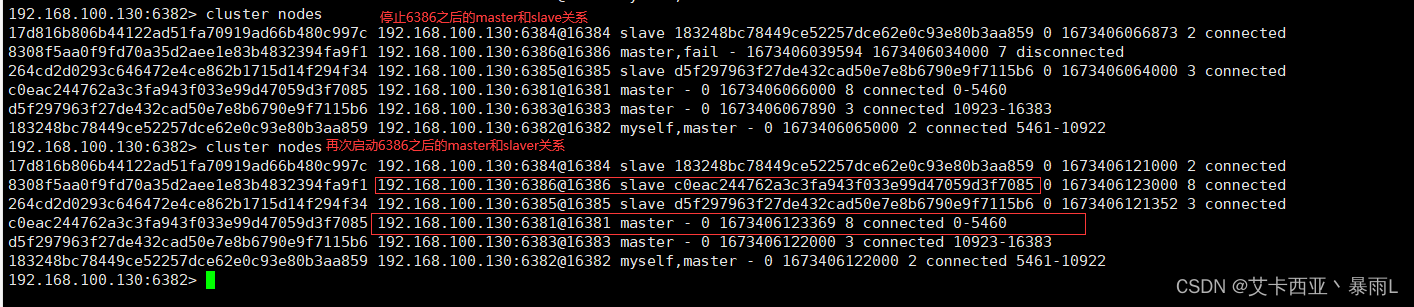

2.2.2容错切换迁移

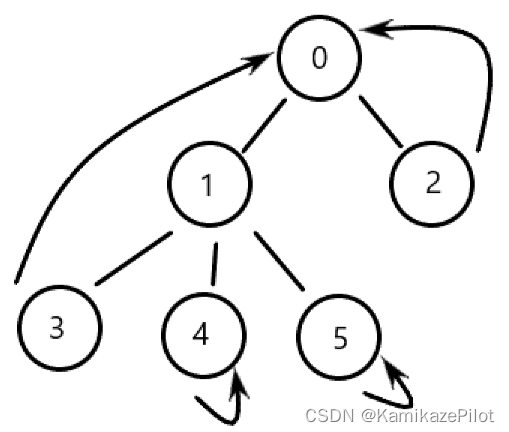

如果把6381干掉,模拟6381宕机,那6386是否可以补位

-

停止6381

-

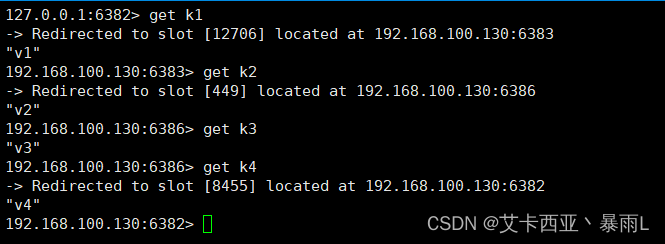

再次查看集群信息

之前存入的key都可以正常的读取

-

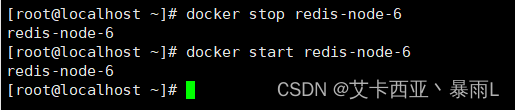

还原之前的3主3从

重新启动redis-node-1

观察master-slaver关系

发现6386还是主机,6381变成从机,也就是说没有恢复原状

如何恢复原状?

答:再停止6386,在启动6386

-

查看集群状态

命令:

redis-cli --cluster check 主机IP:端口号

主机的端口号都可以

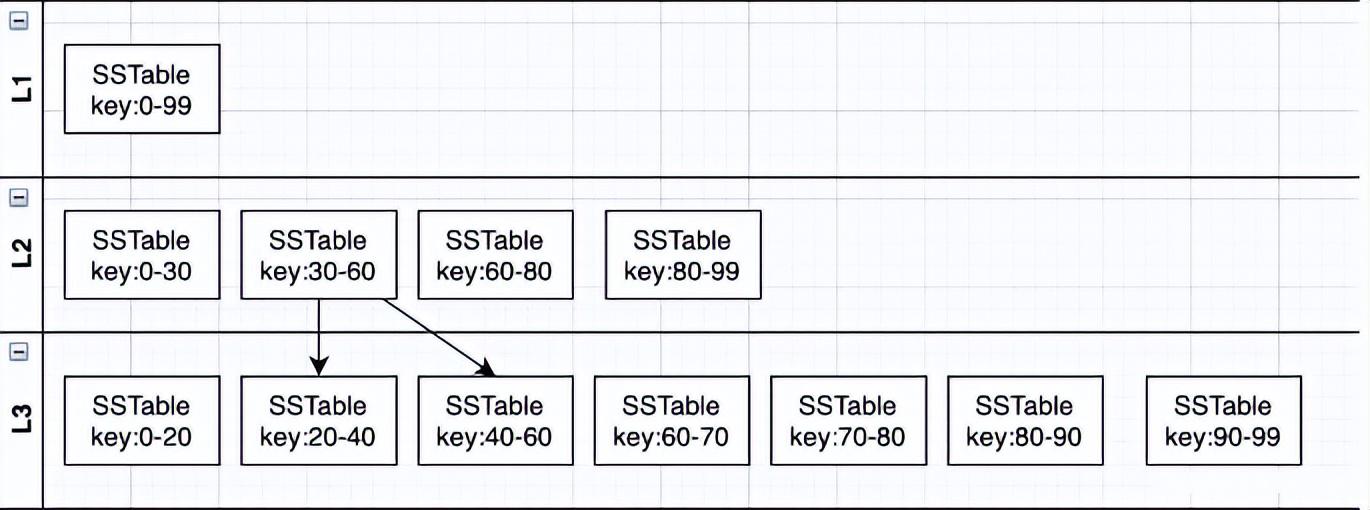

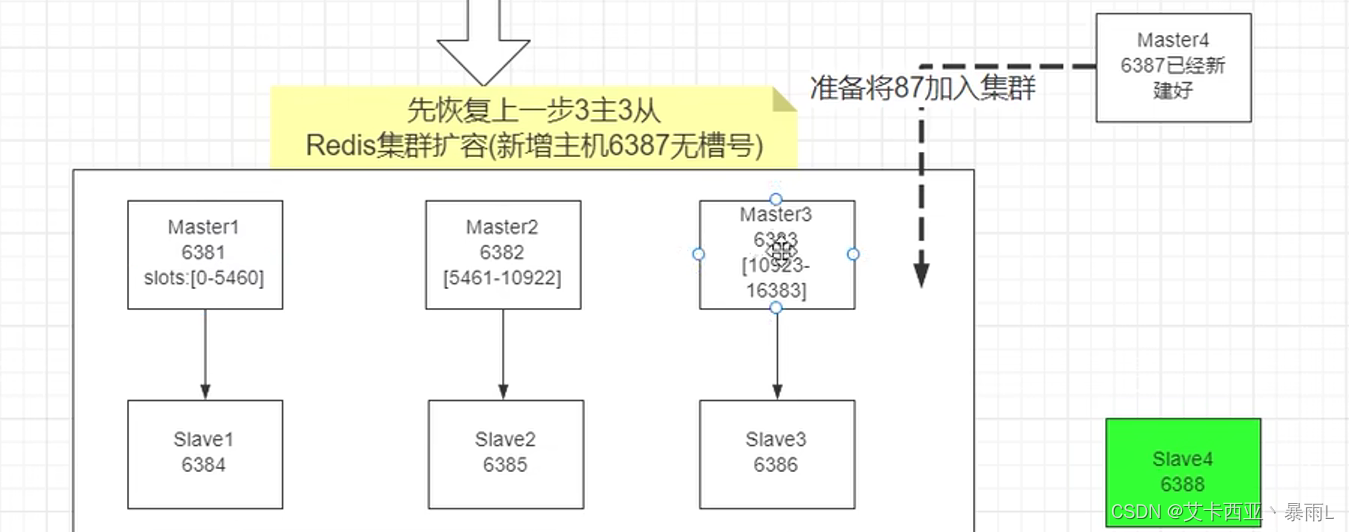

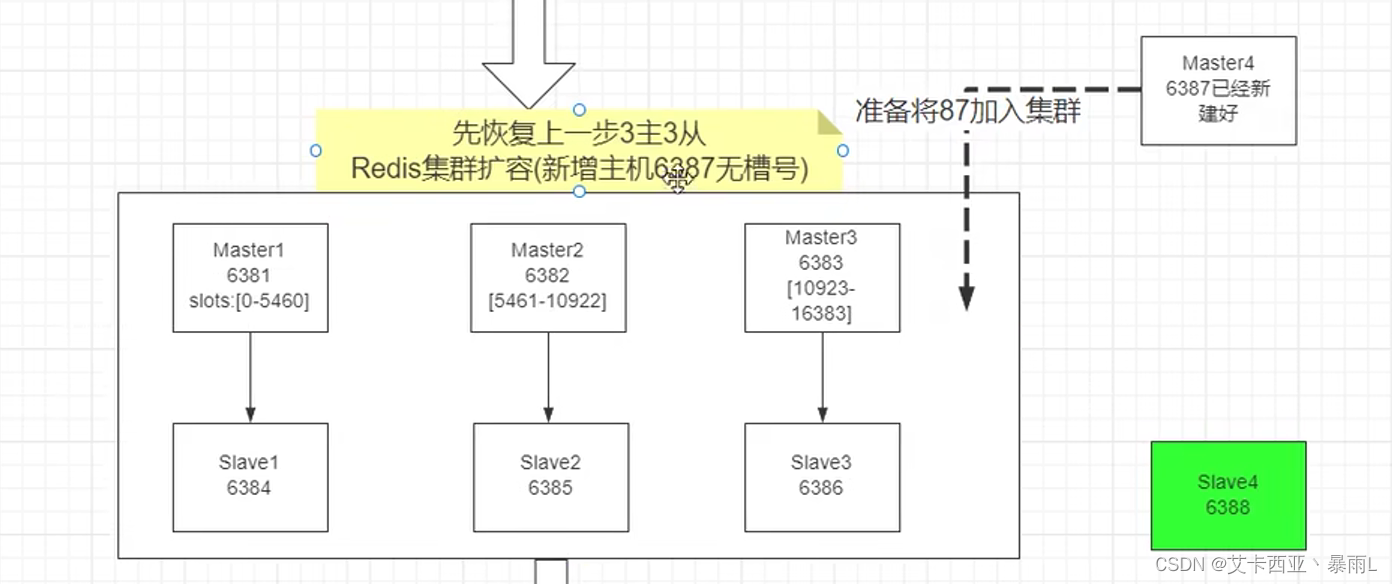

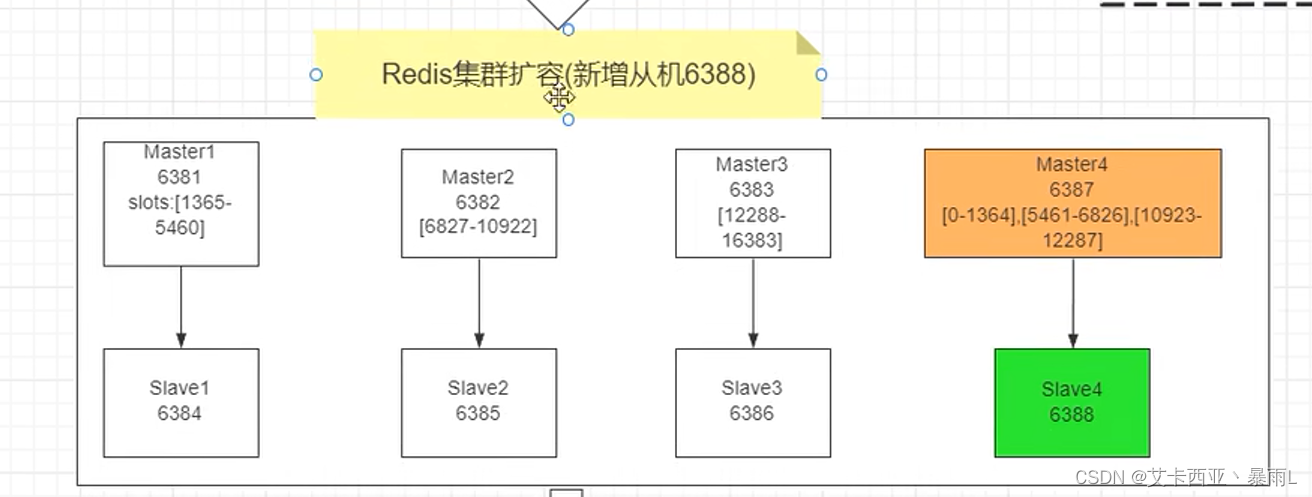

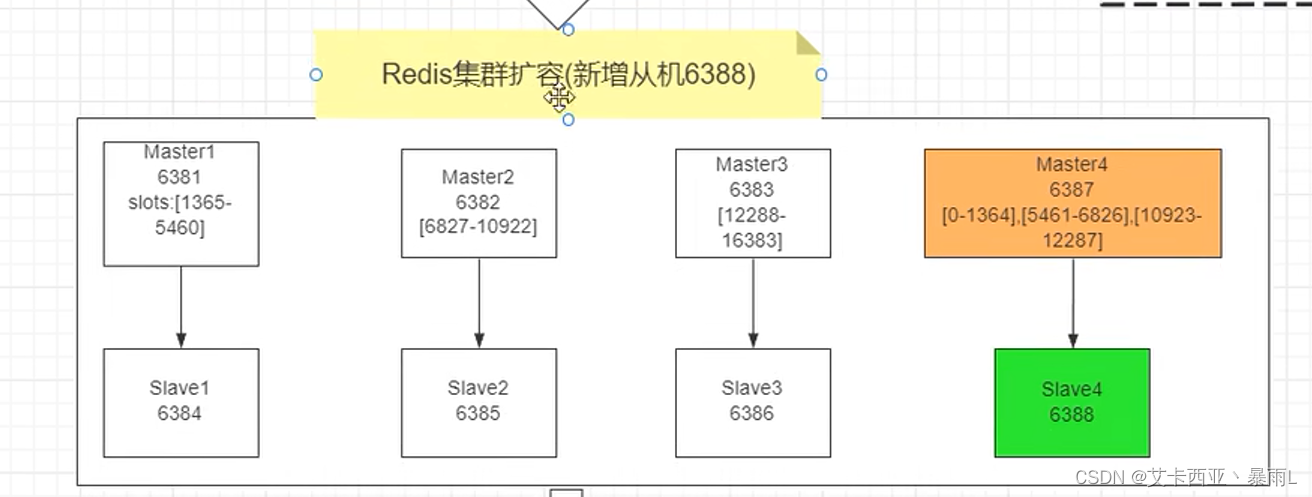

2.3主从扩容案例

3主3从扛不住了,扩容成4主4从

但是3主3从已经占完0~16383的槽位,用什么算法进行槽位变更和新机加盟?

-新增主机

-

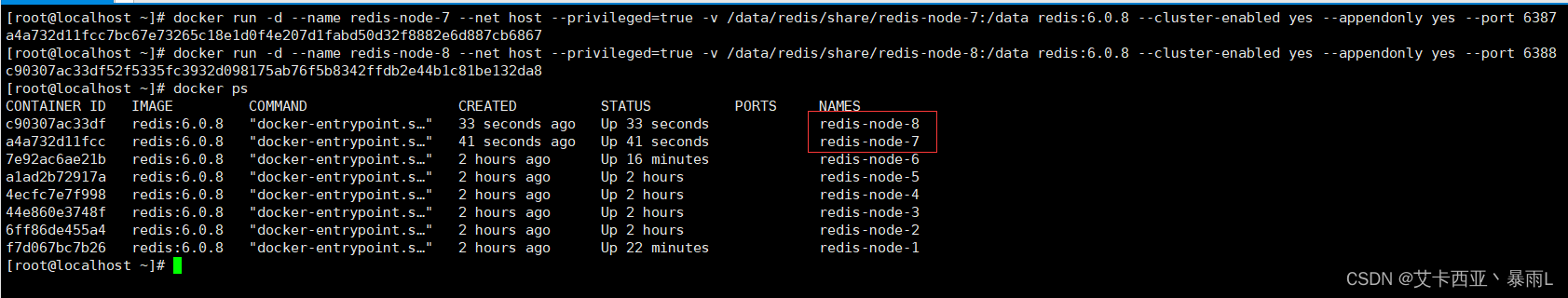

新建6387,6388两个节点+新建后启动+查看是否8节点

命令1:

docker run -d --name redis-node-7 --net host --privileged=true -v /data/redis/share/redis-node-7:/data redis:6.0.8 --cluster-enabled yes --appendonly yes --port 6387

命令2:docker run -d --name redis-node-8 --net host --privileged=true -v /data/redis/share/redis-node-8:/data redis:6.0.8 --cluster-enabled yes --appendonly yes --port 6388

-

进入容器实例内部

命令:

docker exec -it redis-node-7 /bin/bash -

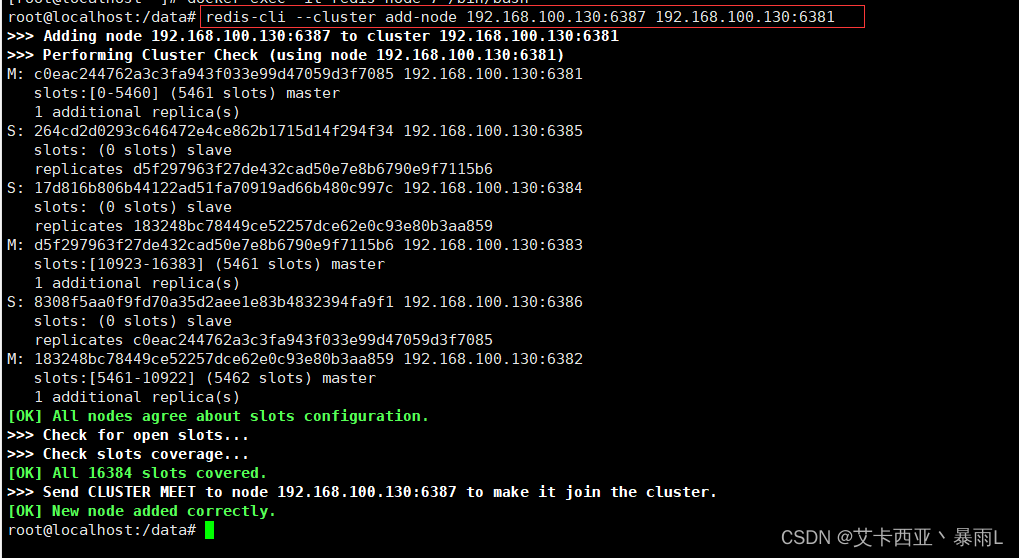

将新增的6387节点(空槽号)作为master节点加入原集群

命令:

redis-cli --cluster add-node 本机IP地址:6387 本机IP地址:6381

6387就是将来要作为master新增节点

6381就是原来集群节点里面的领路人

-

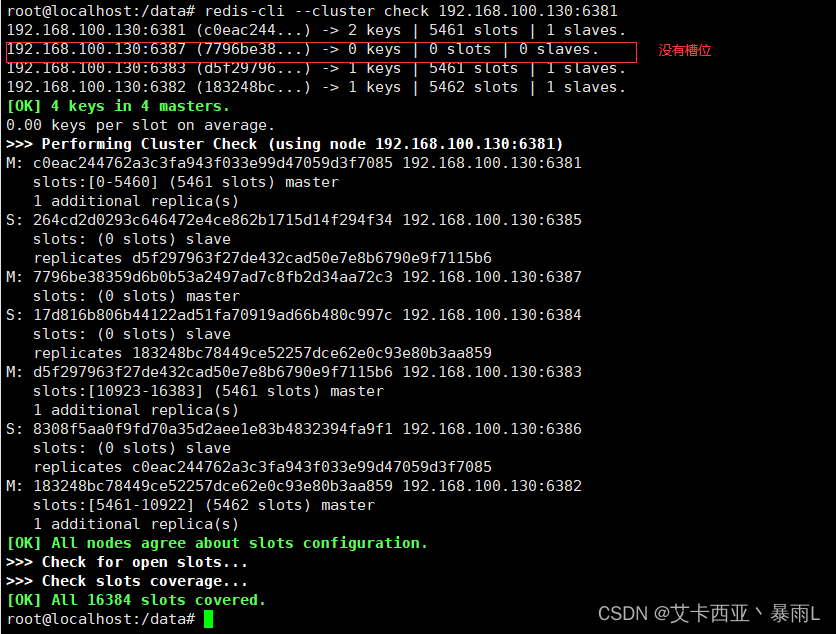

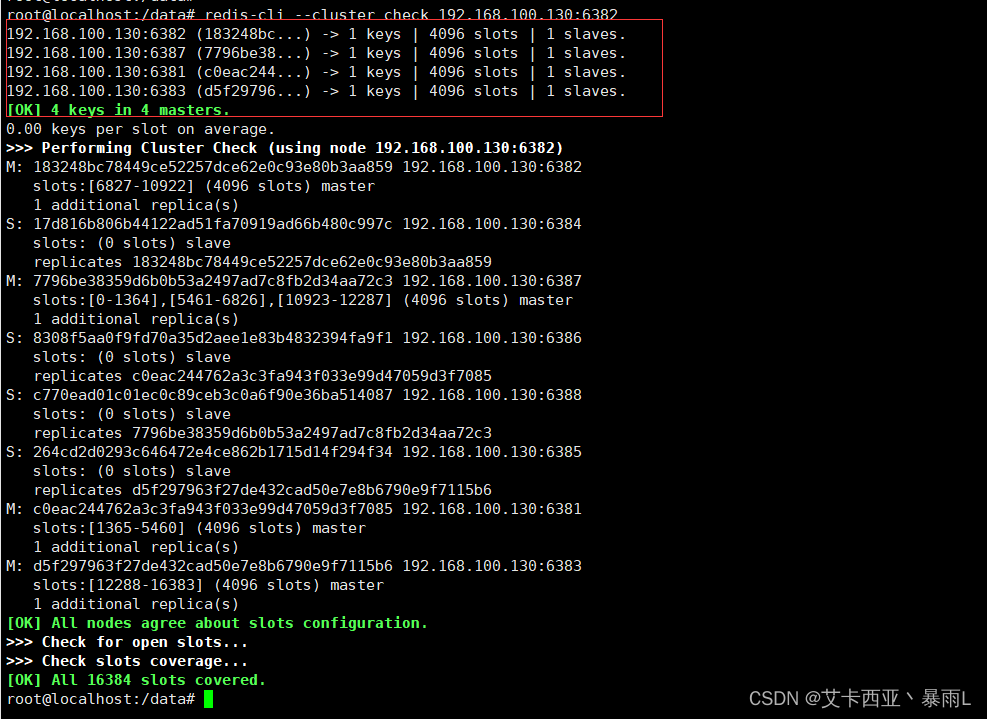

第一次检查集群情况

-

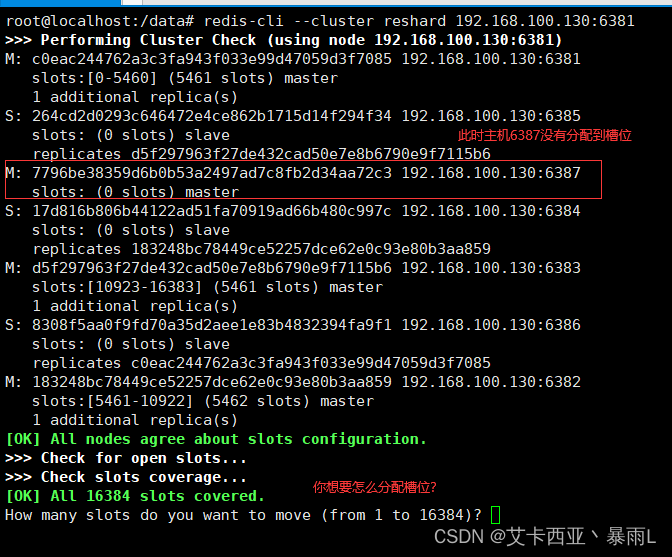

重新分配槽号

命令:

redis-cli --cluster reshard 本机IP地址:端口号

以端口号为落脚点,其实操作的是整个集群

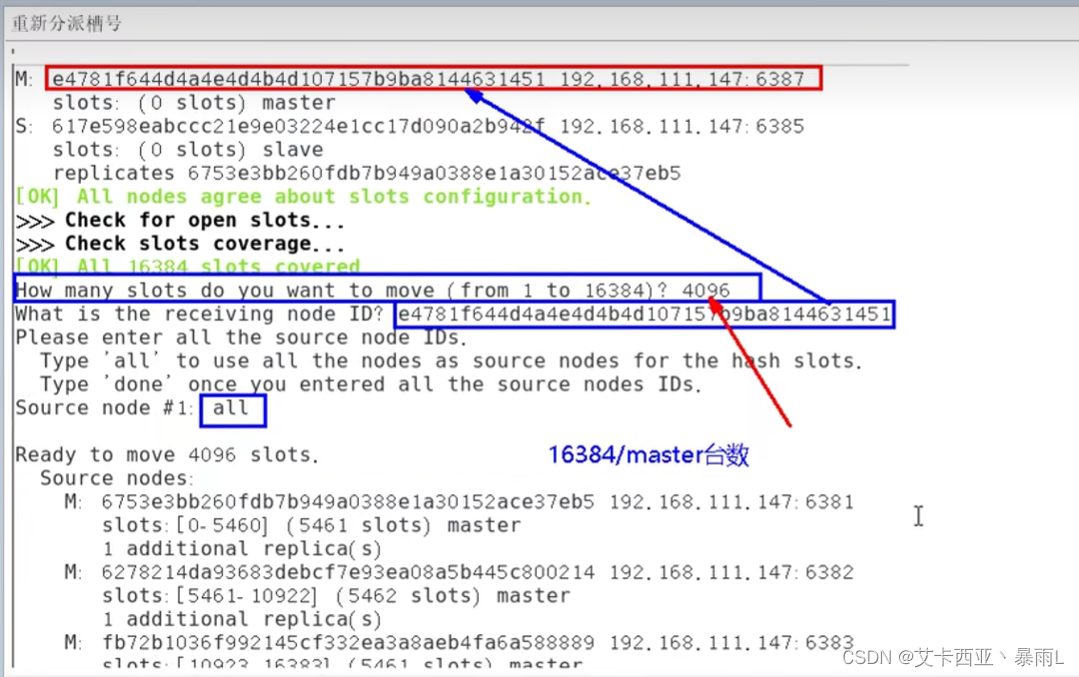

计算器均分槽位

-

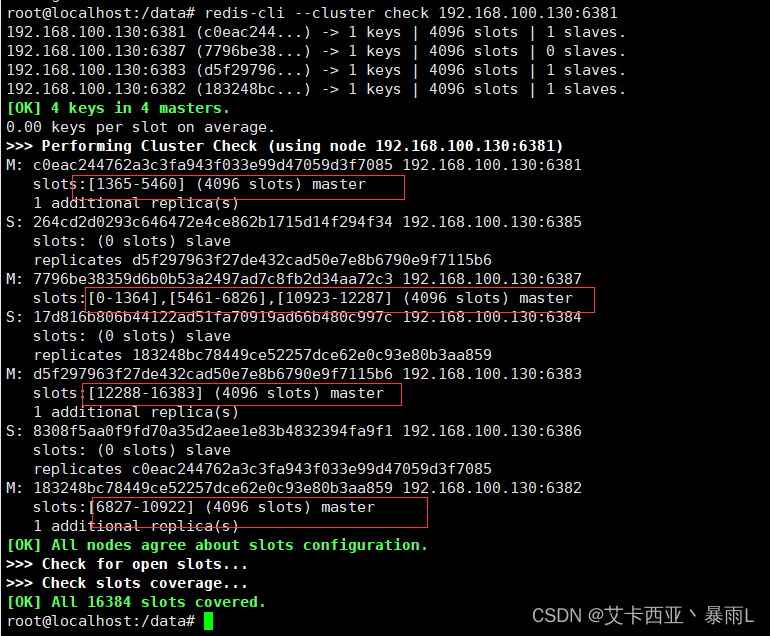

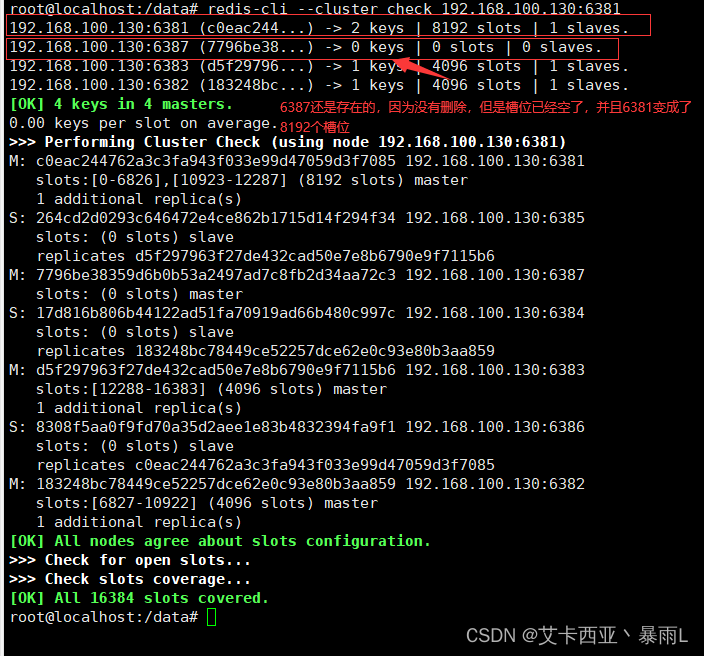

第二次检查集群情况

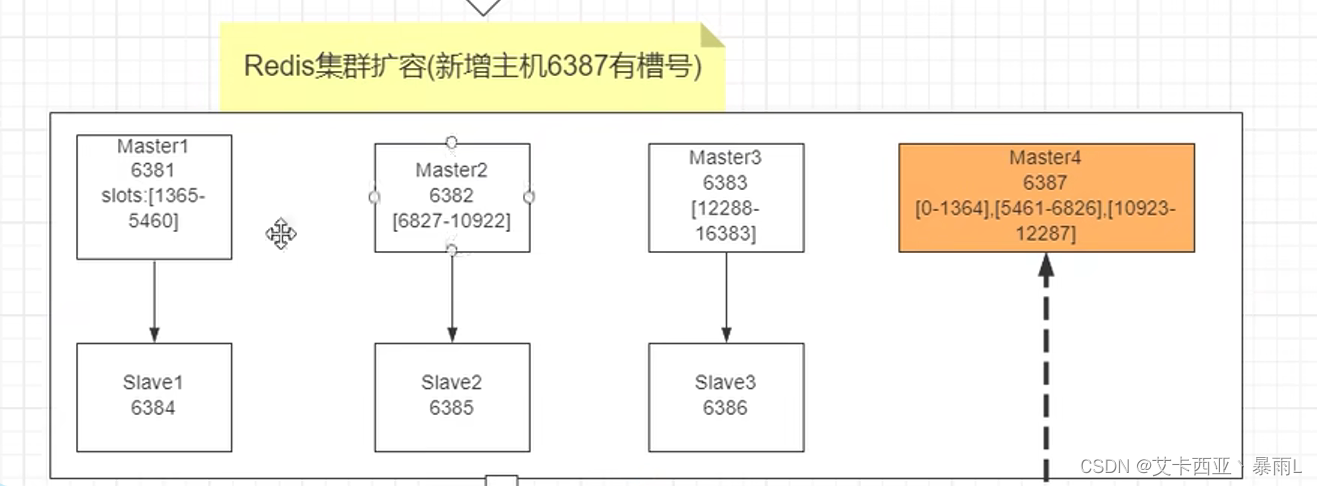

前三个每台主机匀了一点给新增加的主机,并不是重新均匀分配每台4096个槽位

为什么6387是三个新的区间,以前的主机槽位还是连续?

原因:重新分配成本太高,所以三台主机各自匀一部分,从6381/6382/6383三个旧节点分别匀出1364个槽位给6387

-

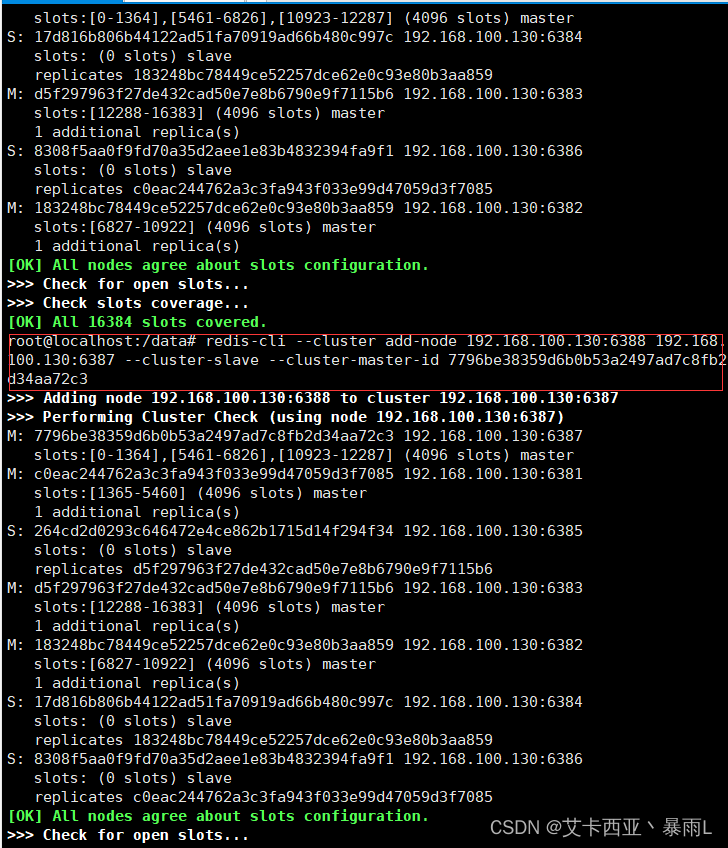

为主节点6387分配从节点6388

命令:

redis-cli --cluster add-node 本机IP:新slave端口 本机IP:新master端口 --cluster-slave --cluster-master-id 新主机节点ID

新主机节点ID要注意

-

第三次检查集群情况

4主4从

最终情况

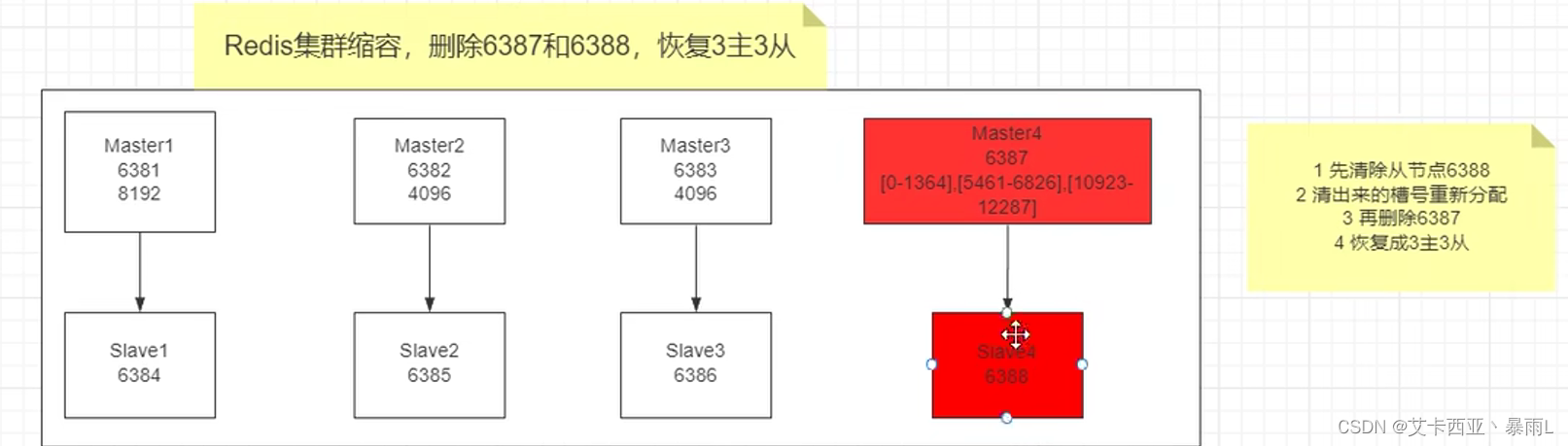

2.4主从缩容案例

流量波峰下去,没有那么大的流量了,恢复3主3从

初始情况

问题1:恢复3主3从那6387的槽位如何分配?物归原主还是全部分配给某台机器?

问题2:先删6387还是先删6388(即先删主机还是先删从机)

解答问题2:先删从机

-

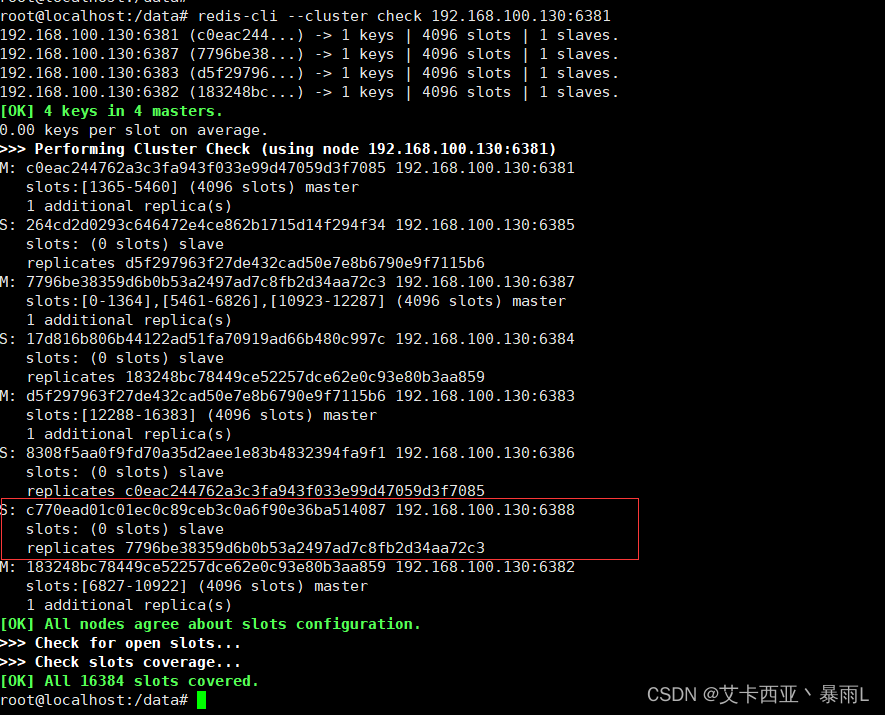

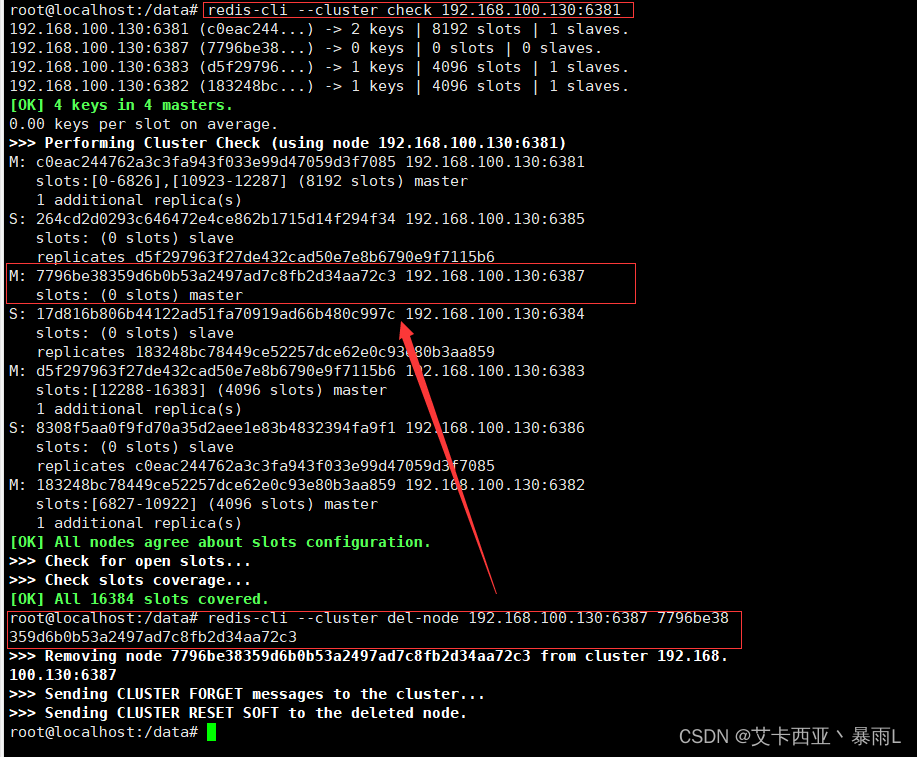

第一次检查集群情况获得6388的节点ID

命令:

redis-cli --cluster check 本机IP:6381

-

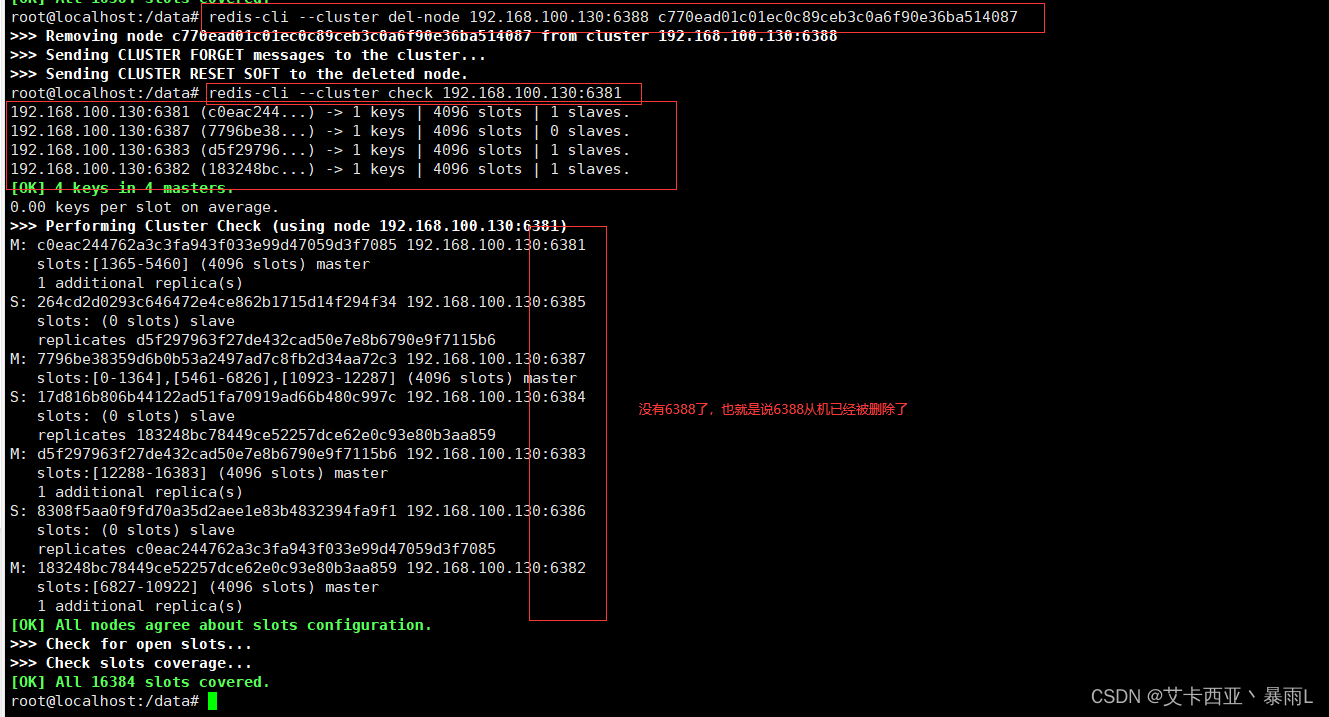

将6388删除

命令:

redis-cli --cluster del-node 本机IP:从机端口 从机节点ID

-

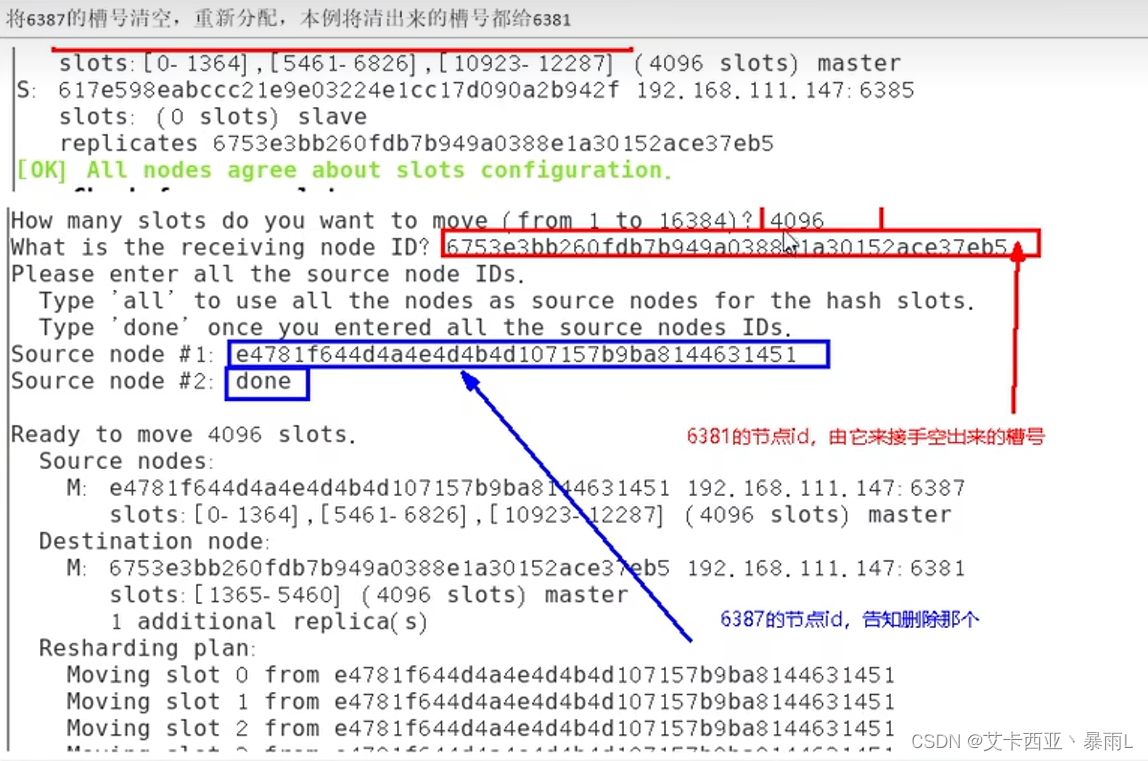

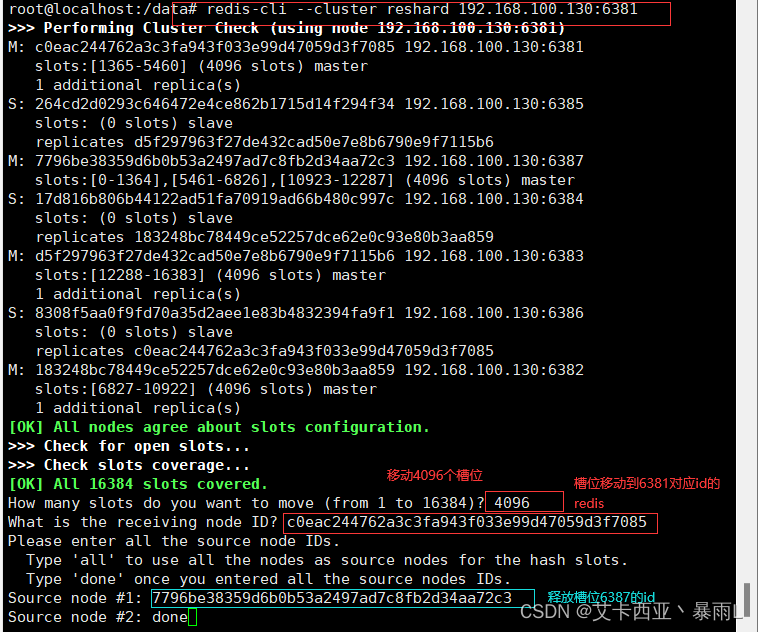

将6387的槽号清空,重新分配(本例将清出来的槽号都给6381)

命令:

redis-cli --cluster reshard 本机IP:端口号

-

第二次检查集群情况

命令:

redis-cli --cluster check 本机IP:6381

-

将6387删除

命令:

redis-cli --cluster del-node 本机IP:端口 机器节点ID

-

第三次检查集群情况

又恢复了3主3从