近日,AI领域再次迎来重大突破。知名AI研究实验室AI21在官网正式发布了其最新研究成果——基于SSM-Transformer混合架构的商业大模型Jamba。这款模型不仅继承了Transformer架构的优点,还巧妙地融合了SSM技术的优势,实现了性能和效率的双重飞跃。

AI-321 | 专注于AI工具分享的网站

AI工具集 | 人工智能工具箱 | 全球顶尖AI工具软件推荐与分享!

传统的Transformer架构在处理长序列、训练大参数模型时存在诸多问题,如AI算力消耗大、过拟合、内存占用大等。为了解决这些难题,AI21实验室在Transformer架构基础上引入了结构化状态空间模型(SSM)技术,成功研发出Jamba模型。这款模型在捕获序列内长距离依赖关系、泛化能力、特征提取等方面表现出色,同时有效降低了AI算力消耗和内存占用。

据悉,Jamba模型的吞吐量达到了同类知名开源模型Mixtral8x7B的3倍,同时在单个GPU上能容纳高达140K上下文,展现出了卓越的性能。这意味着,即使没有庞大的GPU集群,中小企业和个人开发者也能通过Jamba开发出高性能、低消耗的生成式AI产品。

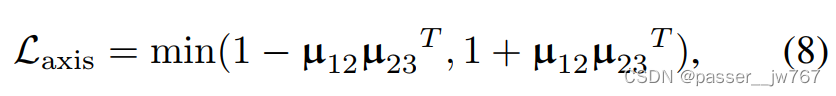

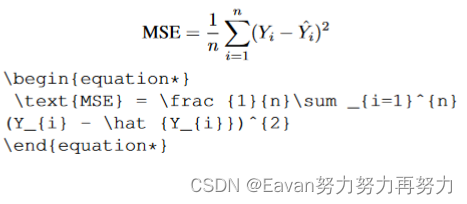

Jamba架构的创新之处在于采用了分块分层的方法,巧妙地将SSM和Transformer架构融合在一起。每个Jamba模块都包含一个注意力层或一个Mamba层,然后是一个多层感知器,总体比例为每八个层中有一个Transformer层。这种设计在保证模型推理性能的同时,大大降低了AI算力消耗,提升了吞吐量。

此外,Jamba还是一个专家混合模型(MoE),520亿参数中的120亿参数长期处于激活状态,并对所有MoE层的专家进行了大幅度优化,减轻了推理时内存占用大的问题。

AI21实验室成立于2017年,总部位于特拉维夫和纽约,由三位业界资深人士联合创立。自成立以来,AI21实验室已融资3.26亿美元,并在2023年推出了大语言模型Jurassic-2。Jurassic-2在文本生成、API延迟、语言支持等方面进行了全面增强,同时还开放了指令微调、数据微调等功能,帮助企业和个人开发者打造量身定制的ChatGPT助手。目前,耐克、Zoom、沃尔玛、三星、阿迪达斯、airbnb等知名企业在使用AI21的大模型产品。

总之,AI21实验室发布的Jamba模型为中小企业和个人开发者提供了新的选择,有望推动生成式AI产品的普及和应用。这款模型的成功研发,无疑将为AI领域带来新的变革,引领行业迈向更加美好的未来。