大模型论文阅读:ADAPTIVE BUDGET ALLOCATION FOR PARAMETEREFFICIENT FINE-TUNING

论文链接:https://arxiv.org/pdf/2303.10512v1.pdf

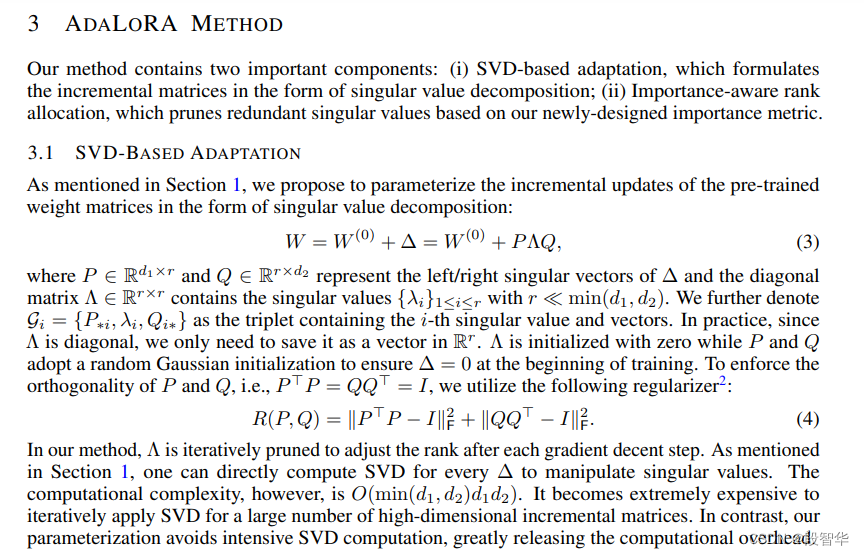

当存在大量下游任务时,微调所有预训练模型的参数变得不可行。因此,为了以参数高效的方式学习预训练权重的增量更新,提出了许多微调方法,例如低秩增量。然而,这些方法经常将增量更新的预算均匀分配给所有预训练权重矩阵,而忽视了不同权重参数的差异性重要性,导致微调性能不足。为弥补这一差距,l论文提出了AdaLoRA, 根据权重矩阵的重要性动态分配参数预算。

- AdaLoRA以奇异值分解的形式参数化增量更新,有效地剪枝掉不重要的更新的奇异值,从而降低其参数预算

- 通过在自然语言处理、问题回答和自然语言生成等多个任务上的实验,验证了AdaLoRA的有效性。结果显示,AdaLoRA在预算较低的设置中尤其能显著提高性能。

AdaLoRA通过自适应地根据权重矩阵的重要性分配参数预算,有效地改善了预训练语言模型的微调性能,特别是当预算较低时。

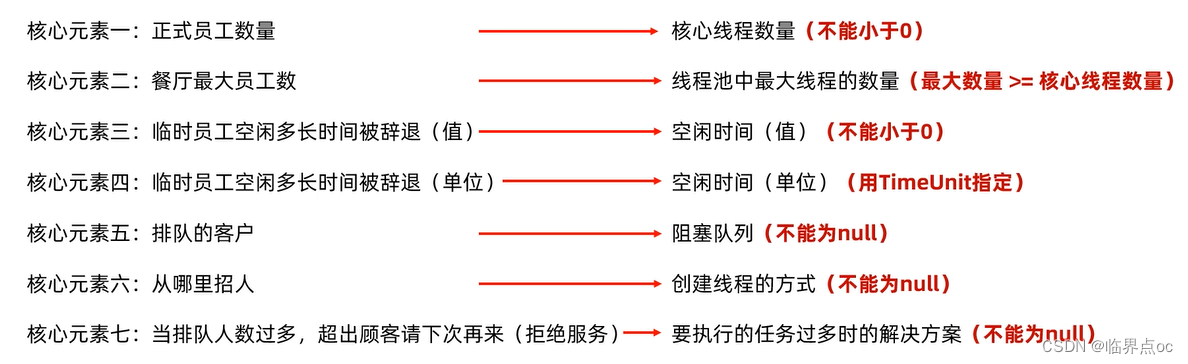

AdaLoRA方法通过以下几个步骤来根据重要性评分自适应地分配参数预算:

-

SV

![2024年上半年数学建模竞赛一览表(附赠12场竞赛的优秀论文+格式要求)[电工、妈杯、数维、五一等12场]](https://img-blog.csdnimg.cn/direct/a93da4818a12484ebbf5c071c7eb64c8.png)