Authors: Long Bai1† , Mobarakol Islam2† , Lalithkumar Seenivasan3 and Hongliang Ren1,3,4∗ , Senior Member, IEEE

Source: 2023 IEEE International Conference on Robotics and Automation (ICRA 2023) May 29 - June 2, 2023. London, UK

Abstract:

尽管有计算机辅助模拟器和录制的外科手术视频,但初级住院医师仍然严重依赖专家来回答他们的问题。然而,专家外科医生往往因临床和学术工作量而超负荷工作,并限制了他们回答问题的时间。为此,开发了一种手术问答系统,以促进机器人辅助手术场景和活动从录制的视频中理解。大多数现有的视觉问答 (VQA) 方法都需要对象检测器和基于区域的特征提取器来提取视觉特征,并将它们与问题的嵌入文本融合以生成答案。然而,(i)由于数据集较小且缺乏边界框注释,手术对象检测模型稀缺;(ii)目前文本和图像等异构模态的融合策略是幼稚的;(iii) 缺少局部应答,这在复杂的手术场景中至关重要。

在本文中,提出了机器人手术中的视觉问题定位-回答(Surgical-VQLA)来定位答案预测过程中的特定手术区域。为了处理异构模态的融合,设计了门控视觉语言嵌入(GVLE)来为语言视觉转换器(LViT)构建输入补丁来预测答案。为了获得定位,将检测头与LViT的预测头并行添加。还集成了广义交集并集 (GIoU) 损失,通过保持问答模型的准确性来提高定位性能。利用来自 EndoVis-17 和 18 的 MICCAI 挑战的公开可用的手术视频对 VQLA 的两个数据集进行注释。验证结果表明,Surgical-VQLA可以更好地理解手术场景,并定位与问答相关的特定区域。GVLE通过展示优于现有基准的性能,提出了一种有效的语言视觉嵌入技术。

主要贡献和优势是:

– 设计并提出了一个外科视觉问题局部化回答 (Surgical-VQLA1) 模型,该模型可以根据给定的输入问题和手术场景预测局部答案。

– 使用新颖的 GVLE 技术为 VQLA 任务提出一种无需检测的 GVLE-LViT 模型,该模型可有效融合异构特征(视觉和文本)。

– 将GIoU损失与交叉熵损失和L1损失相结合,以提高VQLA模型的预测和定位性能。

– 通过广泛的验证,发现 (i) 即使答案与手术相互作用有关,SurgicalVQLA 也可以定位上下文。(ii) 无探测器VQLA通过避免计算昂贵且容易出现错误的检测模块,展示了更好的特征学习,并促进了外科问题本地化回答系统的端到端实时应用。(iii) 拟议的GVLE有效地融合了视觉和文字嵌入的异构模式,并优于现有方法。

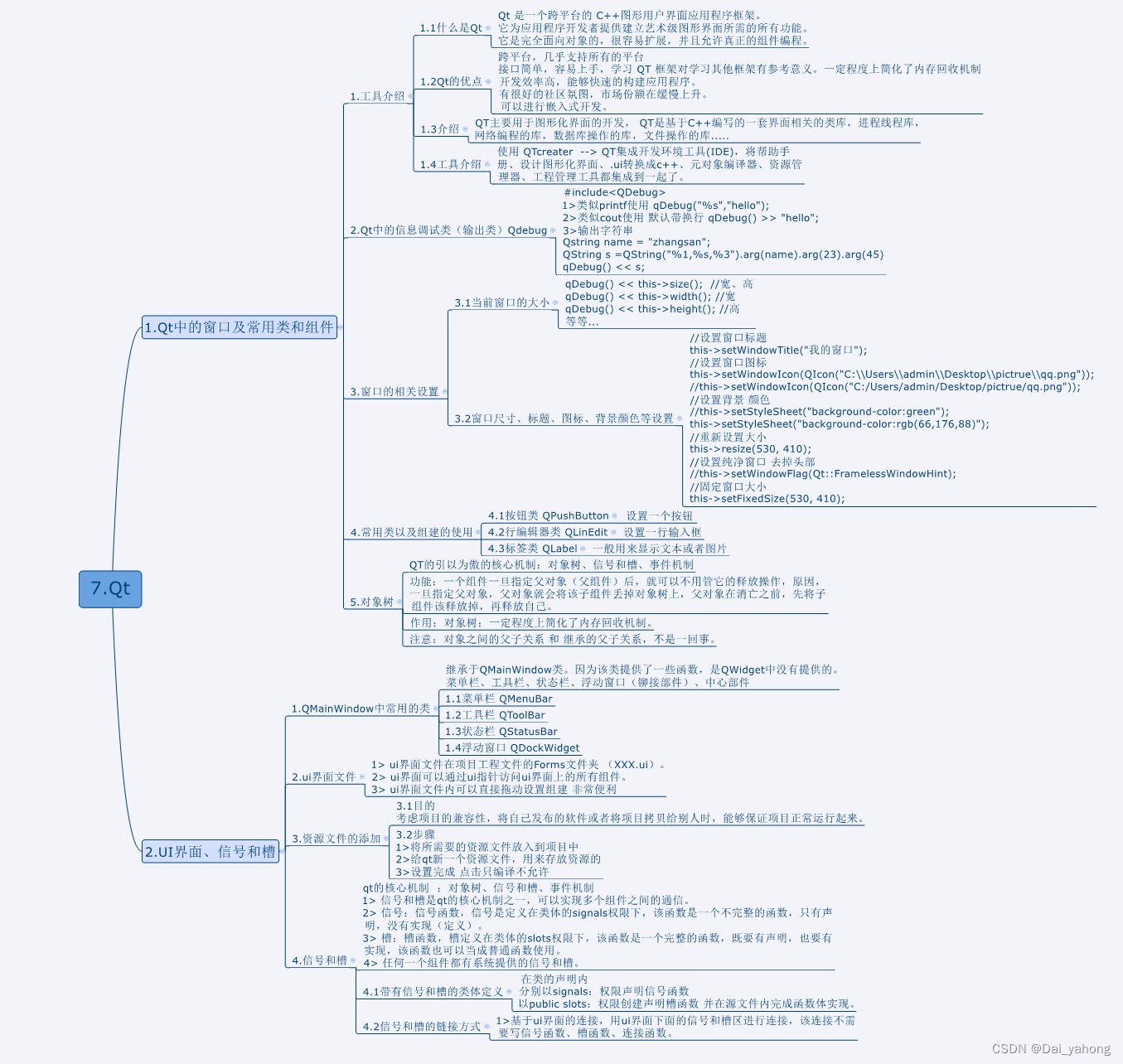

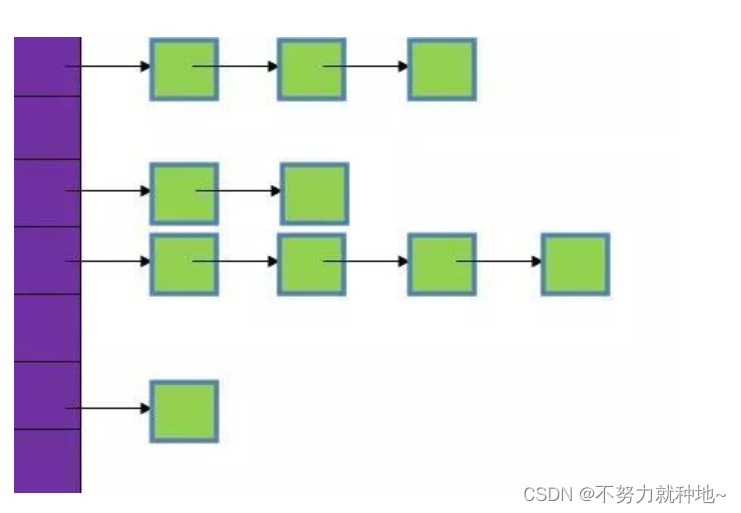

图 1.针对传统 VQA 任务,提出的 VQLA pipline概述。方法不需要对象建议,边界框预测可以与分类结果一起输出。

图 2.提出的网络架构。机器人手术图像为预训练的特征提取器提供信息,问题为定制的分词器提供信息。然后,GVLE模块嵌入输入特征,并优化视觉和文字嵌入的组合。融合特征通过预训练的 ViT 模块传播。最后,由带有softmax的分类头和带有FFN的定位头给出答案和边界框预测。

表一 GVLE-LVIT模型与基于VISUALBERT 和VISUALBERT RESMLP 的模型的比较实验。RN 表示 RESNET。

图 3.通过VisualBERT [6]、VisualBERT ResMLP [2]和GVLE-LViT模型生成答案和边界框的几个例子。与基线模型相比,本模型的定位和分类预测结果更准确。边界框颜色的表示如下:红色:Ground-truth,蓝色:VisualBERT [6],绿色:VisualBERT ResMLP [2],黄色:GVLE-LViT (Ours)。

表 II GVLE-LVIT模型在VQLA任务上的K折比较实验,与基于VISUALBERT [6]和VISUALBERT RESMLP [2]的模型。

表 III 基于 VISUALBERT [6] 和 VISUALBERT RESMLP [2] 的模型,在提出的 GVLE-LVIT 模型上具有不同定位损失函数组合的消融研究

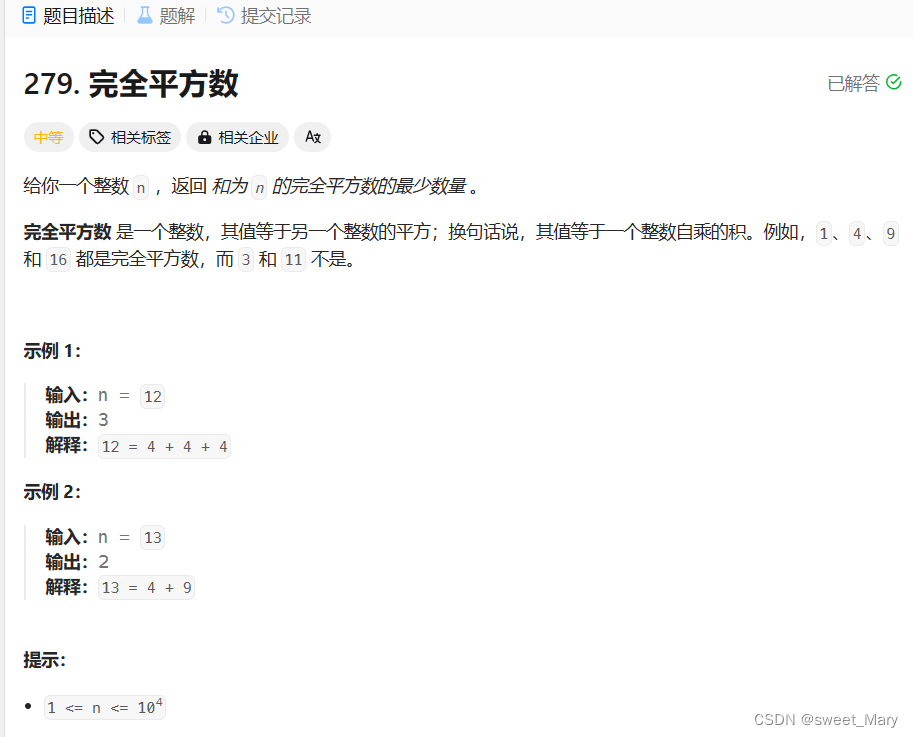

表IV 基于GVLE语言-视觉嵌入融合与CONCAT[6]、AFF[13]和IAFF [13]融合策略的比较实验。

本文设计并提出了一个外科视觉问题局部化回答(Surgical-VQLA)模型,该模型可以根据给定的输入问题和手术场景回答“什么”和“在哪里?”,使学生更容易推断“为什么?”。具体来说,提出了一种 GVLE-LViT 模型,该模型使用提出的 GVLE 技术更好地融合异构特征(视觉和文本),该技术在两个外科数据集上的外科-VQLA 任务中优于现有的 SOTA 模型。此外,将GIoU损失与交叉熵损失和L1损失相结合,以提高模型的预测和定位性能。通过广泛的比较、k 倍和消融研究,证明使用提出的损失组合训练的 GVLE-LViT 优于现有的 SOTA 模型。SurgicalVQLA系统可能成为外科培训中的重要辅助工具。虽然所提出的VQLA模型旨在提供可靠的答案预测,但在某种程度上,答案的定位可以帮助量化预测对新数据的可靠性,如果定位远于目标仪器或组织,用户可以推断预测可能是错误的,或者输入数据是分布外数据。因此,使用定位信息来预测预测可靠性可能是未来可能的工作。从应用的角度来看,提出的VQLA模型为医学诊断开辟了新的可能应用。更复杂的数据集和具有挑战性的 QA 对将进一步提高 Surgical-VQLA 系统的前景。

Reference:

[1] Bai, L., Islam, M., Seenivasan, L., & Ren, H. (2023, May). Surgical-vqla: Transformer with gated vision-language embedding for visual question localized-answering in robotic surgery. In 2023 IEEE International Conference on Robotics and Automation (ICRA) (pp. 6859-6865). IEEE.