一、多轮对话支持

为了实现多轮对话支持,我们需要维护用户的会话上下文。这可以通过在服务器端使用一个字典来存储会话状态实现。

目录

一、多轮对话支持

下面是一个简单的扩展例子:

二、性能优化

三、用户界面与交互优化

下面是一个简单的HTML示例,展示如何与我们的API接口进行交互:

四、监控与日志分析

下面是一个简单的日志配置示例:

五、扩展性与可伸缩性

结语

-

下面是一个简单的扩展例子:

from flask import Flask, request, jsonify

import torch

from transformers import GPT2LMHeadModel, GPT2Tokenizer

app = Flask(__name__)

# 用于存储会话状态的字典

conversation_context = {}

@app.route('/chat', methods=['POST'])

def chat():

data = request.json

user_id = data.get('user_id', None) # 假设每个用户有一个唯一的ID

prompt_text = data.get('prompt', '')

# 检查是否存在会话上下文

if user_id in conversation_context:

context = conversation_context[user_id]

prompt_text = context + "\n" + prompt_text # 将之前的上下文添加到当前提示中

tokenizer = GPT2Tokenizer.from_pretrained('gpt2-medium')

model = GPT2LMHeadModel.from_pretrained('gpt2-medium')

input_ids = tokenizer.encode(prompt_text, return_tensors='pt')

output = model.generate(input_ids, max_length=100, pad_token_id=tokenizer.eos_token_id)

generated_text = tokenizer.decode(output[:, input_ids.shape[-1]:][0], skip_special_tokens=True)

# 更新会话上下文

if user_id is not None:

conversation_context[user_id] = prompt_text + generated_text

return jsonify({'reply': generated_text})

if __name__ == '__main__':

app.run(debug=True)- 在这个例子中,我们为每个用户存储了一个会话上下文。当用户发送一个新的请求时,我们将之前的上下文添加到当前的提示中,并生成回复。然后,我们将新的上下文(提示+回复)保存起来,以便在下一轮对话中使用。

二、性能优化

- 为了提高性能,我们可以考虑使用异步处理或批量处理请求。Flask本身并不直接支持异步,但我们可以结合其他库(如Quart)或WSGI服务器(如Gunicorn与Uvicorn)来实现异步。

- 此外,我们还可以考虑使用缓存来存储模型的输出或中间结果,以减少重复计算。一个简单的缓存实现可以使用Python的内置

functools.lru_cache装饰器或第三方库如Redis。

三、用户界面与交互优化

- 前端用户界面的优化通常涉及到HTML、CSS和JavaScript的改进。你可以创建一个更加美观和直观的前端界面,增加输入提示、错误处理、加载动画等功能。

-

下面是一个简单的HTML示例,展示如何与我们的API接口进行交互:

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8">

<title>Chat with GPT</title>

<script src="https://code.jquery.com/jquery-3.6.0.min.js"></script>

</head>

<body>

<h1>Chat with GPT</h1>

<div id="chat-log"></div>

<input type="text" id="user-input" placeholder="Enter your message...">

<button onclick="sendMessage()">Send</button>

<script>

function sendMessage() {

const userInput = $('#user-input').val();

const userId = '123'; // 假设每个用户有一个唯一的ID

$.post('/chat', {

user_id: userId,

prompt: userInput

}, function(data) {

const reply = data.reply;

const chatLog = $('#chat-log');

chatLog.append(`<p><b>You:</b> ${userInput}</p>`);

chatLog.append(`<p><b>GPT:</b> ${reply}</p>`);

$('#user-input').val(''); // 清空输入框

});

}

</script>

</body>

</html>- 在这个HTML示例中,我们使用了jQuery来简化AJAX请求和DOM操作。

- 用户输入消息后,点击“Send”按钮,通过POST请求发送到我们的

/chat接口,并在页面上显示GPT的回复。

四、监控与日志分析

- 对于监控和日志分析,你可以使用Python的

logging模块来记录服务器的活动。你可以配置不同的日志级别(如DEBUG、INFO、WARNING、ERROR),并将日志输出到文件、控制台或远程日志服务。 -

下面是一个简单的日志配置示例:

import logging

# 配置日志

logging.basicConfig(filename='app.log', level=logging.INFO,

format='%(asctime)s %(levelname)s %(message)s')

# 在代码中使用日志

@app.route('/chat', methods=['POST'])

def chat():

# ... 省略其他代码 ...

try:

# ... 执行操作 ...

logging.info('Chat request received from user_id: %s', user_id)

# ... 生成回复 ...

except Exception as e:

logging.error('Error occurred during chat: %s', str(e))

# 处理错误或返回错误消息

# ... 省略其他代码 ...- 此外,你还可以使用第三方日志分析服务(如ELK Stack:Elasticsearch、Logstash和Kibana)来收集、存储、分析和可视化日志数据。这些工具可以帮助你深入了解系统的运行状况、用户行为以及可能存在的问题。

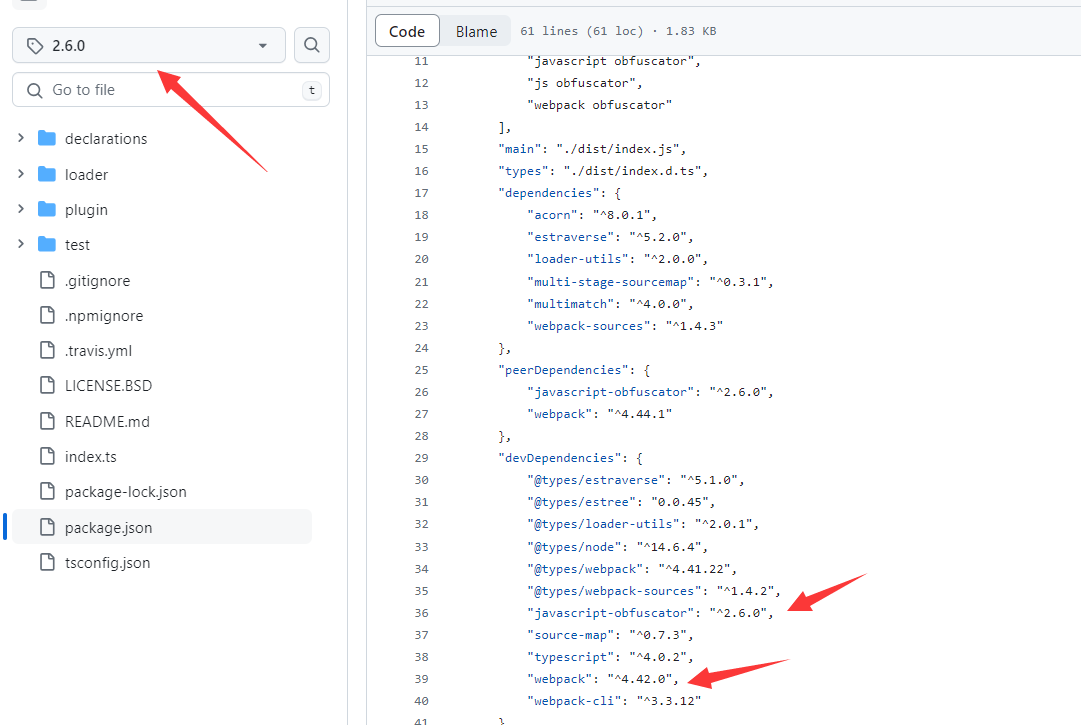

五、扩展性与可伸缩性

- 对于大型应用或高并发场景,你可能需要考虑使用分布式系统来提高系统的扩展性和可伸缩性。以及使用数据库或缓存系统来存储和共享数据。

- 你还可以考虑使用容器化技术(如Docker)和编排工具(如Kubernetes)来管理你的服务器和应用程序。

这些工具可以帮助你自动化部署、扩展和管理分布式系统。

结语

在扩展和优化GPT聊天机器人系统时,你需要考虑多个方面,包括会话管理、性能优化、用户界面与交互、监控与日志分析以及扩展性与可伸缩性。通过不断迭代和改进,你可以打造出一个更加健壮、高效和用户体验良好的聊天机器人系统。希望这些建议能够为你提供一些启示和帮助!