论文阅读-federated unlearning via class-discriminative pruning

FUCP 通过类别区分性剪枝进行联邦遗忘

综述中描述:属于面向全局模型中的局部参数调整

利用卷积层的结构特定进行联邦忘却学习,wang等人提出了针对图像分类任务的联邦忘却学习算法FUCP,用于完成类别忘却任务。针对图像分类任务,FUCP依据卷积神经网络结构中通道对类别的评分剪枝通道参数,使联邦学习模型有选择地"遗忘"特定类别的贡献。然而,FUCP只能删除某个类别数据对全局模型的贡献,而无法剔除类别中的特定样本子集,并且该算法只适合卷积神经网络分类模型。

CNN-convolutional neural network 卷积神经网络

TF-IDF–term frequency inverse document frequency 术语频率逆文档频率

fine-tuning 微调

SGD–stochastic gradient descent 随机梯度下降

NLP–natural language processing 自然语言处理

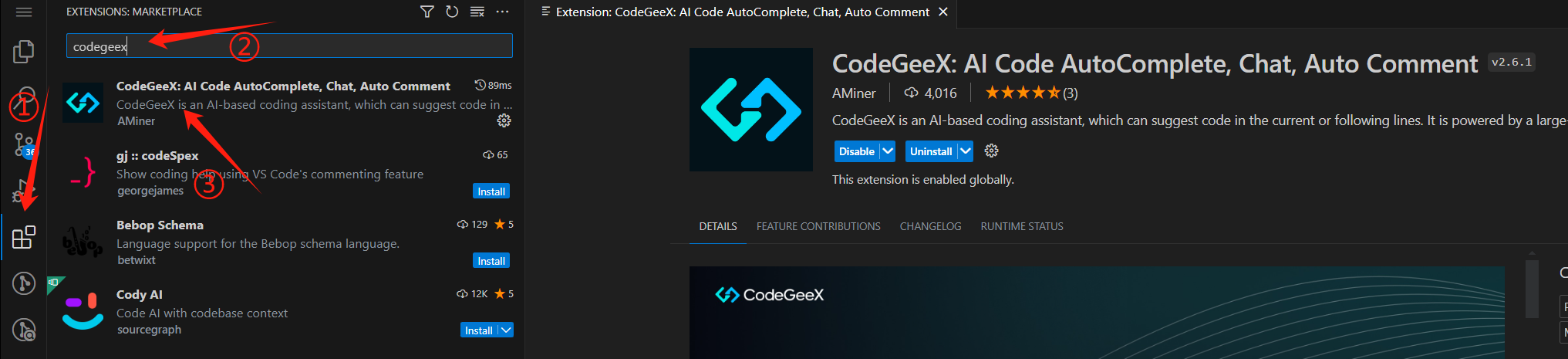

提出了一种方法来清除模型中有关特定类别的信息。该方法不需要从头开始重新训练,也不需要全局访问用于训练的数据。相反,我们引入术语频率逆文档频率的概念来量化通道的类别区分度。TF-IDF分数高的通道对目标类别有更多的辨别力,因此需要进行修剪以消除学习。通道剪枝之后是微调过程,以恢复剪枝模型的性能。

TF-IDF是一种统计度量,用于评估单词与一组文档中文档的相关程度。我们的忘却学习方法将通道的输出视为单词,将类别的特征图视为文档,并使用TF-IDF来评估通道和类别之间的相关分数。TF-IDF分数高的通道具有更多的类别区分,因此需要进行剪枝以消除目标类别的贡献。剪枝过程不需要任何迭代训练或搜索,因此计算效率高。最后,进行微调过程以恢复剪枝模型的性能。

- 每个在线FL设备从联合服务器下载一个忘却学习程序

- 本地训练的CNN模型将私有图像作为输入,并生成每个通道和类别之间的特征图分数

- 这些特征图分数被传送到联邦服务器并聚合为全局特征图分数

- 服务器使用TF-IDF评估通道和类别之间的相关分数并构建剪枝器对目标类别最具判别力的通道执行剪枝

- 收到剪枝完成的通知后,每个在线FL设备从联邦服务器下载剪枝后的模型,并使用排除目标类别的训练数据进行正常的联邦训练程序以实现微调。

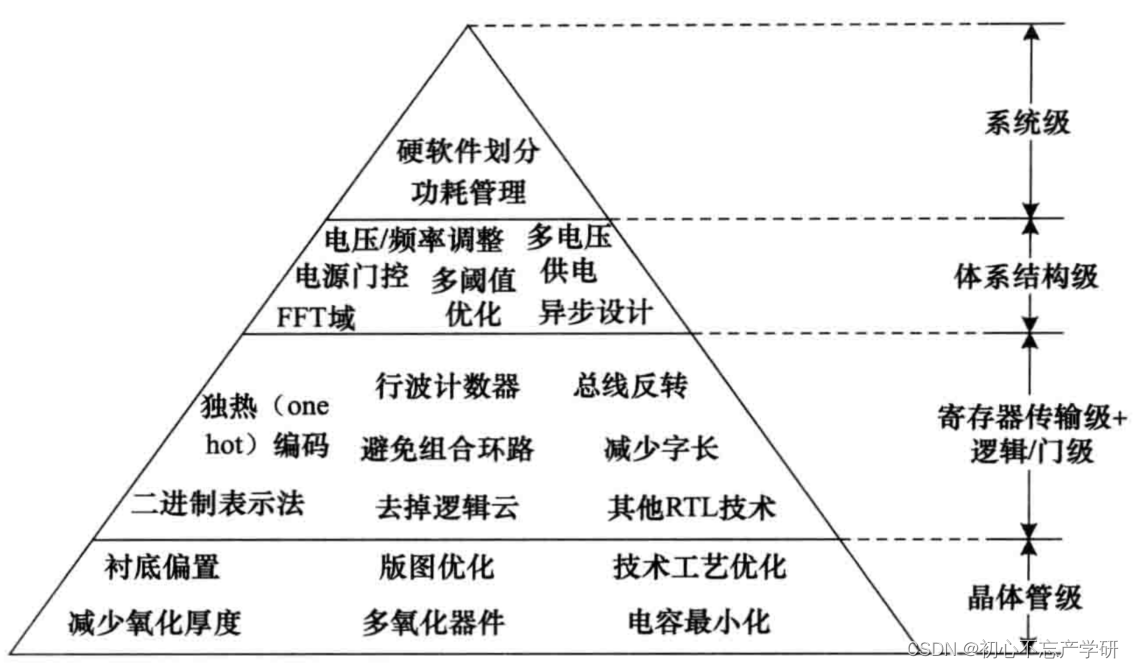

machine unlearning机器忘却学习,他通常以低成本产生完全重新训练的模型的近似值。 这些方法粗略分为三组:

1)Fisher 忘却学习方法 2)影响遗忘方法 3)梯度遗忘法

如果能够在不全局访问数据的情况下量化每个通道学到的类别信息,我们就有机会通过剪枝类别区分性最大的通道来忘记特殊类别。

1、通道的类别区分

每个通道的特征图具有局部性即一个特征图中的特定区域是被激活的。第13个卷积层中的第52个通道总是生成突出显示头部信息的特征图,而第127个通道总是突出显示文本信息。因此,不同的通道对图像分类中的不同类别有不同的贡献,所以我们可以通过类别区分找到与目标类别具有最大可分离性的通道。

2、基于TF-IDF的信道评分

TF-IDF定义了单词和文档之间相关性的量化,相关性随着单词在文档中出现的次数而成比例增加,但会被包含该单词的文档数量所抵消。例如,如果某个单词在文档中出现多次,而在其他文档中出现次数不多,则可能意味着该单词非常相关。

文档中单词的TF-IDF通过乘以两个不同的度量来量化:文档中单词的术语频率TF;文档集合中单词的逆文档频率IDF

对于所有文档集合E中的文档e中的单词t,TF通常是通过e中出现的t实例的计数来计算的。然后,频率除以e的长度。IDF可以通过将E的总体积除以包含t的文档数并计算对数来计算。将TF和IDF相乘得出e中t的TF-IDF分数。

我们的忘却方法将通道的输出视为单词,将类别的特征图视为文档。因此这个TF-IDF变体可以评估通道和类别之间的相关分数。TF-IDF分数高的通道具有更多的类别区分,因此需要进行剪枝。

3、类别区分性通道剪枝

通道剪枝的目标是删除每一层中的特定通道并将CNN模型缩小为更薄的模型。通道级剪枝的优点是直接删除整个通道。

与现有的类别区分性剪枝方法相比,TF-IDF引导通道剪枝不需要任何迭代训练或搜索,在计算开销方面要轻很多。

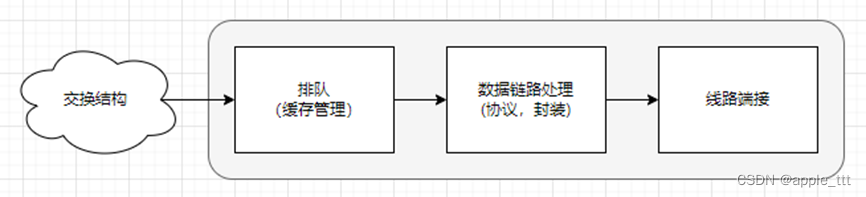

考虑到从本地和全局存储的预训练模型中删除特定类别的请求,框架描述的工作流程由分别在运行在FL客户端和联邦服务器中两个关键组件组成:参与者客户将他们的私人图像转换为本地表示,这些本地表示被传送到服务器,以便于目标类别和通道之间的TF-IDF分数构成剪枝器。

1、FL客户端中的本地处理

在每个FL客户端,忘却学习程序中的本地过程是使用本地私有图像进行的,以便生成通道和类之间的本地表示。

2、联邦服务器中的处理

在联邦服务器中,服务器过程是使用类和通道之间的本地表示进行的。在从所有参与者客户端接收到本地表示后,服务器首先平均聚合这些本地表示以生成类和通道之间的全局表示。

根据公式计算出的通道和类别之间的TF-IDF分数,服务器然后构建一个剪枝器,对目标类别中最具判别力的通道执行剪枝。剪枝是压缩神经网络模型的常用技术。它从模型中修剪特定的权重,从而将它们的值归零,并且我们确保它们不参与反向传播过程。

在多类去除的情况下,剪枝过程会执行多次,每次去除一个类。最后,修剪完成后,联邦服务器将通知每个参与者FL客户端从中下载修剪后的模型,然后进行微调过程以获得具有目标精度的剪枝后模型。

3、微调处理

在修剪目标类别中最具辨别力的通道后,应通过重新训练修剪后的模型来补偿精度下降。为了减少遗忘时间,我们应用一次剪枝再训练策略:一次剪枝多层通道并重新训练它们,直到恢复目标精度。

4、讨论

可以将此方法应用于集中式学习;本研究针对FL场景中类级忘却问题,而样本级忘却问题是一个更具有挑战性问题。

使用ResNet和VGG模型在CIFAR10和CIFAR100数据集上进行实验。CIFAR10数据集由10个类别的60000张32x32彩色图像组成,每个类别6000张图像。CIFAR100数据集与CIFAR10类似,不同之处在于它有100个类,每个类包含600个图像。

包含目标类别的测试集(忘却学习的测试集-U-set)

包含其余类别的测试集(其余测试集–R-set)

将此忘却方法与两个基线进行了比较:

1、完全重新训练(没有需要忘却的要点)

2、基于fisher unlearning方法忘却目标类别(该方法利用参与者数据的Fisher信息并注入最优噪声以实现遗忘)

FL的特点是仅将总客户端的一部分采样为参与者,并且参与者客户端具有非独立同分布的本地训练数据。因此参与者的数据不完整且存在偏差。我们假设参与者数据的分布与学习任务的整体训练数据分布不同。

- 1、忘却学习加速

从不同的预训练模型中忘却了CIFAR10和CIFAR100的最后一个类别并比较了完全重新训练的加速比。学习方法是FedSGD,x轴表示微调过程中的训练轮数,y轴表示测试集上忘却模型的准确性。

与完全重新训练相比,我们的方法产生的遗忘加速非常显著。

- 2、不同偏差概率的影响

与使用fisher信息的基线方法相比,我们的方法表现明显更好,因为我们的方法对训练数据的分布不敏感,因此即使在参与者数据存在严重偏差的情况下也可以准确的忘却学习。

- 3、信息删除

分别比较了我们的方法和完全重新训练在R/U集上的模型准确性,这是衡量忘却质量的合适方法。

我们的方法在R集上没有精度损失,在此基础上,我们的方法在U-set上的准确率与完全重新训练相同,均为0%。表明我们的方法在预训练模型上实现了与完全重新训练类似的信息擦除效果,而无需牺牲准确性。

- 4、多类移除

多类去除情况下的性能仍然先进。经过第二类剪枝后,剪枝后模型在U集上的准确性变低(即0%)表明信息擦除是理想的。

- 5、成员推理攻击

给定目标类别的样本和遗忘后的模型,攻击的目的是推断该样本是否用于训练原始模型。也就是,攻击的目的是知道目标样本位于原始模型的训练数据集中。测量攻击的成功率,以评估在遗忘后的模型中仍包含多少有关目标类别的信息。

完全重新训练和我们的方法之间的攻击成功率没有显著差异。

- 6、分类准确性分布

研究了忘却学习后分类精度在所有类别中的分布情况,以及它是否近似于从头开始重新训练的理想分布。

类间准确率差异最多仅为0.59%。

为联邦学习设置中训练的CNN分类模型提出了选择性遗忘类别的定义。基于这个定义,我们提出了一种清理程序,可以从训练模型中清理有关特定类别的信息,而不需要全局访问训练数据,也不需要从头开始重新训练。