文章目录

-

- 前言

- 安装部署

- 配置修改

- 案例:采集文件内容上传至HDFS

- 案例:采集网站日志上传HDFS

前言

Flume是Cloudera提供的一个高可用的,高可靠的,分布式的海量日志采集、聚合和传输的系统,Flume支持在日志系统中定制各类数据发送方,用于收集数据;同时,Flume提供对数据进行简单处理,并写到各种数据接受方(可定制)的能力。

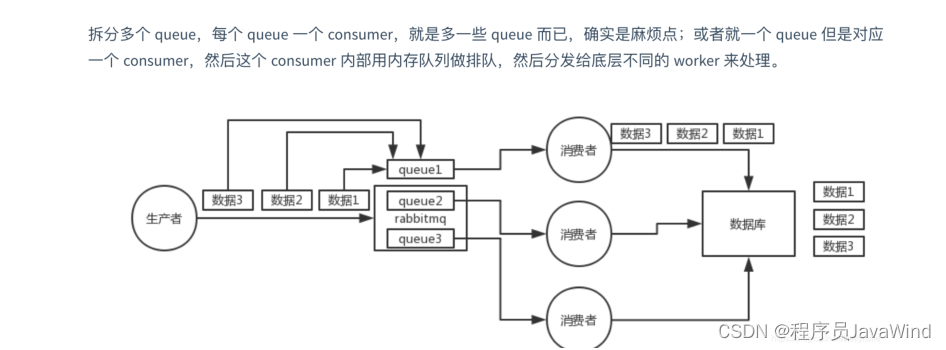

Flume-ng最明显的改动就是取消了集中管理配置的 Master 和 Zookeeper,变为一个纯粹的传输工具。Flume-ng另一个主要的不同点是读入数据和写出数据由不同的工作线程处理(称为 Runner)。 在 Flume-og 中,读入线程同样做写出工作(除了故障重试)。如果写出慢的话(不是完全失败),它将阻塞 Flume 接收数据的能力。这种异步的设计使读入线程可以顺畅的工作而无需关注下游的任何问题。

安装部署

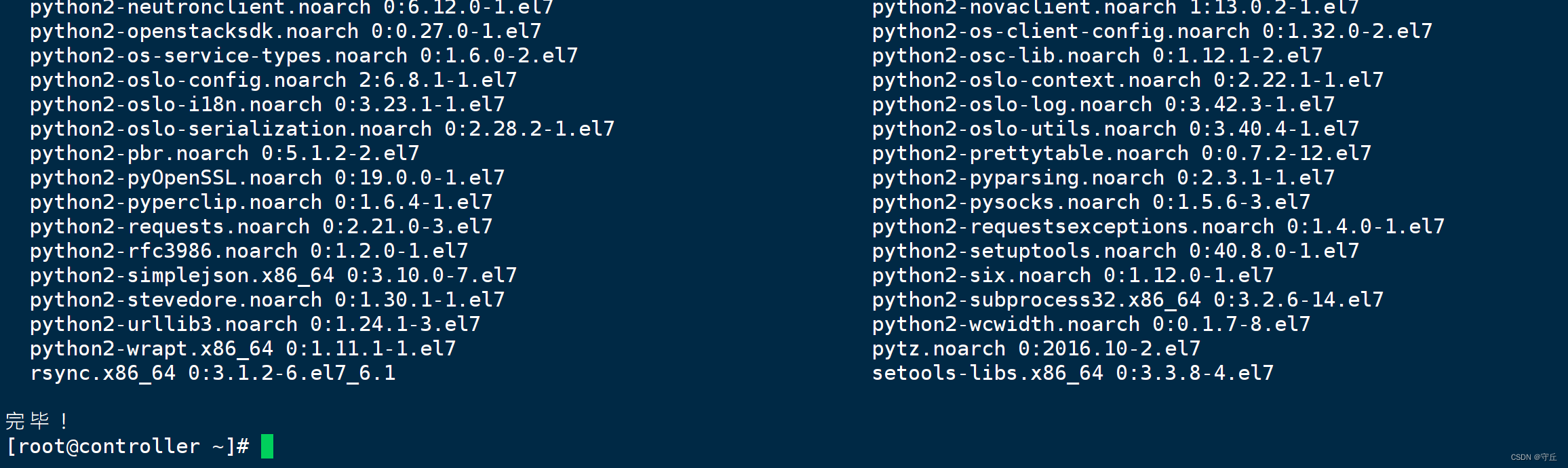

官网:http://flume.apache.org/download.html,下载完成后上传服务器并解压。

[root@hadoop02 soft]# tar -zxvf apache-flume-1.11.0-bin

配置修改

#修改文件名

[root@VM-4-17-centos conf]# mv flume-env.sh.template flume-env.sh

# 修改配置

[root@VM-4-17-centos conf]# vim flume-env.sh

export JAVA_HOME=/usr/local/jdk/jdk1.8.0_201

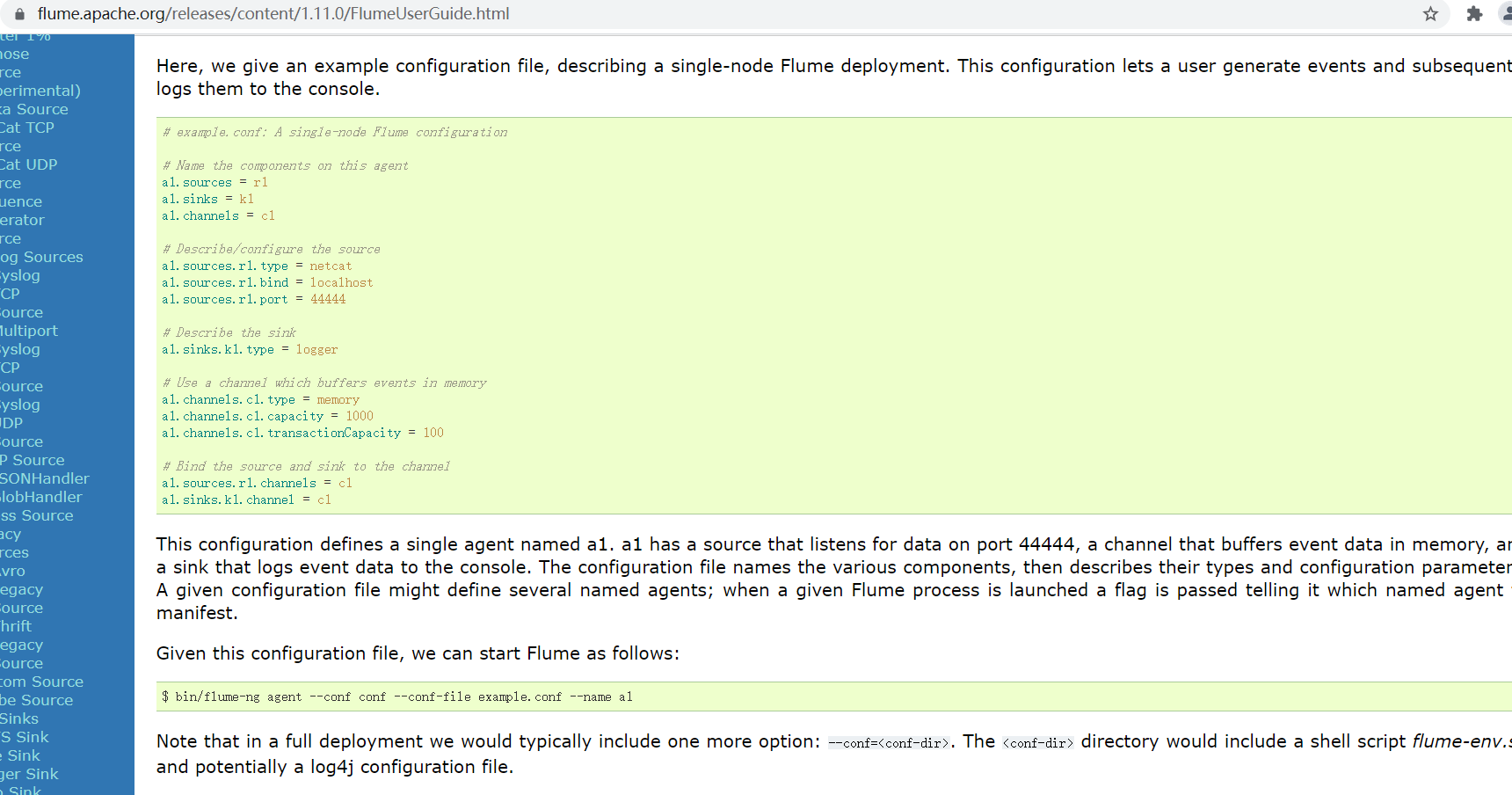

# 准备conf文件,在官网上可以找到 https://flume.apache.org/releases/content/1.11.0/FlumeUserGuide.html

[root@VM-4-17-centos conf]# vim example.conf

# Name the components on this agent

a1.sources = r1

a1.sinks = k1

a1.channels = c1

# Describe/configure the source

a1.sources.r1.type = netcat

a1.sources.r1.bind = localhost

a1.sources.r1.port = 44444

# Describe the sink

a1.sinks.k1.type