在强化学习中,`alpha`(α)和`gamma`(γ)分别代表学习率和折扣因子,它们是强化学习算法中的两个重要的超参数。

1. **学习率 (`alpha`):**

- `alpha` 是一个控制在学习过程中对新观测值的权重的参数。它决定了在更新估计值时对新观测值有多大的影响。

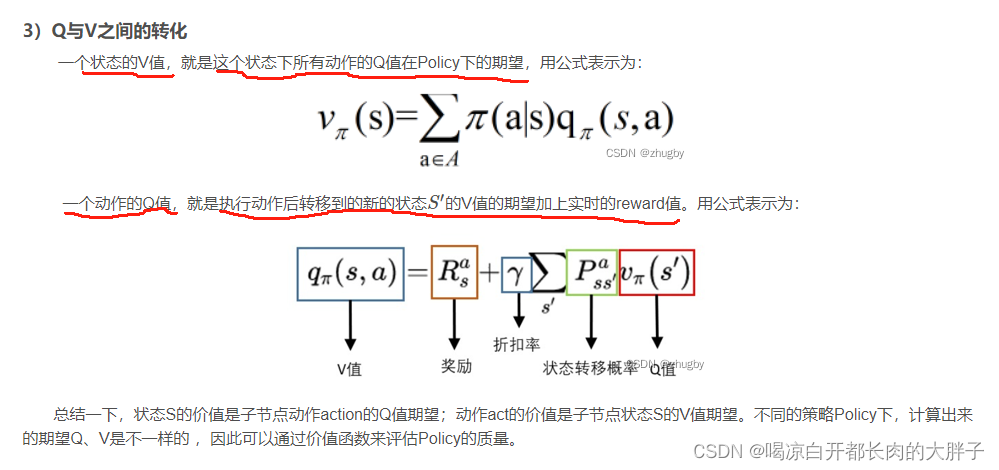

- 具体来说,对于Q-learning等基于值的强化学习算法,Q值的更新公式可以表示为:

\[ Q(s, a) \leftarrow (1 - \alpha) \cdot Q(s, a) + \alpha \cdot (r + \gamma \cdot \max_{a'} Q(s', a')) \]

其中,\(Q(s, a)\) 是状态动作对 \((s, a)\) 的Q值,\(r\) 是立即的奖励,\(s'\) 是下一个状态,\(a'\) 是在\(s'\)处选择的最佳动作,\(\gamma\) 是折扣因子。

- 学习率的选择影响着算法对新信息的接受速度,过小的学习率可能导致模型过于保守,而过大的学习率可能导致模型不稳定。

2. **折扣因子 (`gamma`):**

- `gamma` 是一个在强化学习中用于衡量未来奖励的折扣因子。它控制了对未来奖励的重视程度。

- 在强化学习问题中,一个智能体可能会在当前时刻做出决策,但这个决策可能会影响未来的奖励。`gamma` 的值在0和1之间,越接近1表示越重视未来奖励。

- 折扣因子的引入有助于智能体在决策时考虑未来奖励,而不仅仅是眼前的即时奖励。

总的来说,`alpha` 和 `gamma` 是在强化学习算法中需要预先设定的超参数,它们对算法的性能和学习过程有着重要的影响。合适的 `alpha` 和 `gamma` 值的选择取决于具体问题和环境。

![[iOS]高版本MacOS运行低版本Xcode](https://img-blog.csdnimg.cn/direct/dcf6cf456c414a6fb7de6ef2ffff029f.png)

![[Unity3D]--更换天空盒子](https://img-blog.csdnimg.cn/direct/5b34df59b21c40d4bfc5cbd9c773c88b.png)