研究内容

如何通过prompt,在不进行微调大语言模型的前提下,增加大语言模型的表现

研究动机

- prompt非常有用,但是人工设置的非常不自然;

- 因此提出了要自动使用大语言模型自己选择prompt;

- 取得了很好的效果。

作者主要是提出了三件事:

如何让大语言模型生成prompt

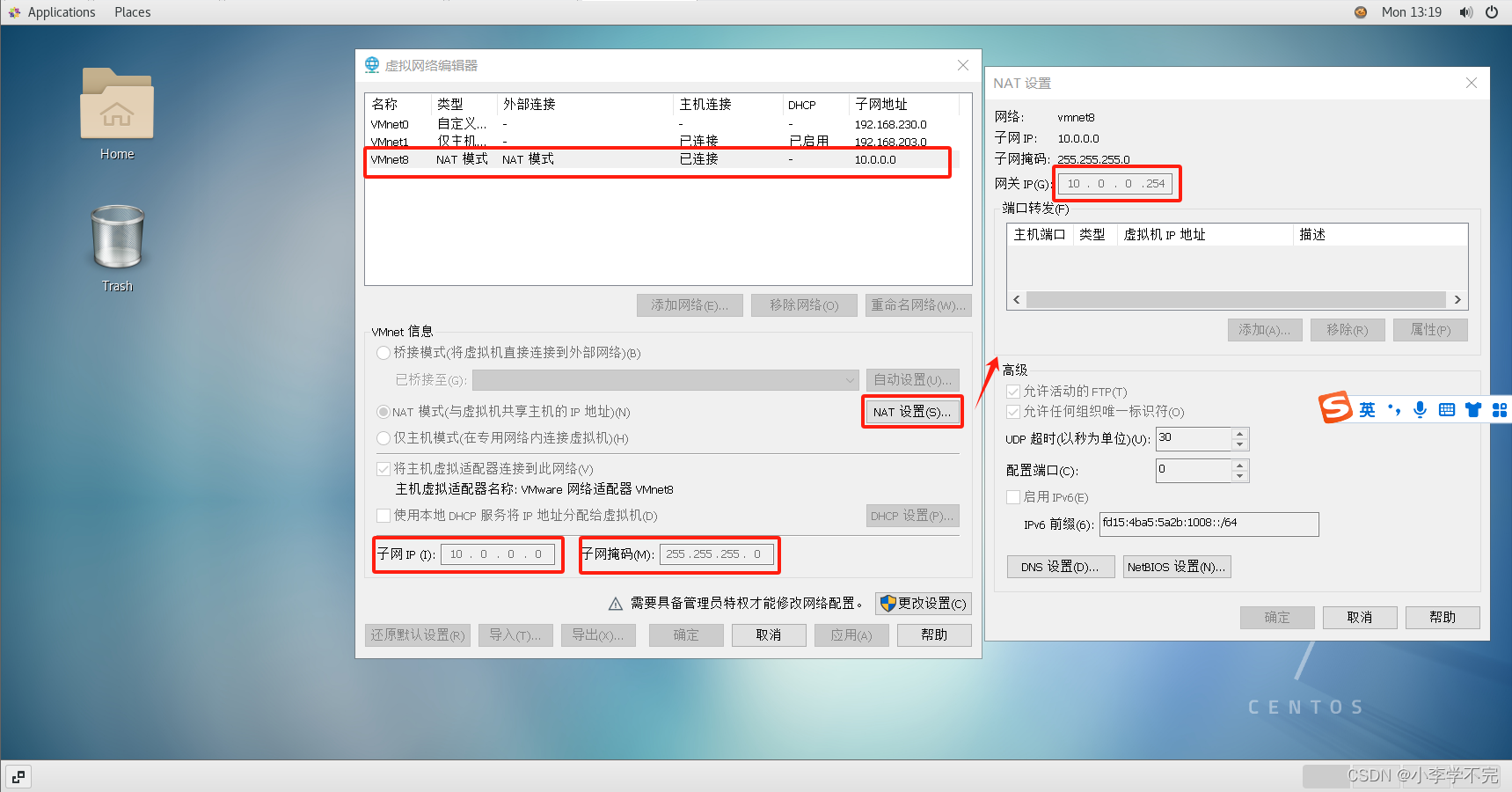

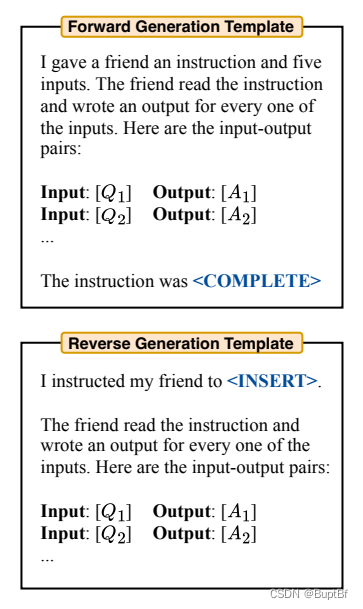

LLM是可以分为两类的,

- 其中一类GPT是只能从前到后的,他们不支持句子补全(在一段话当中填写空缺位置);

- 另一类,则是可以反向的例如T5、GLM、 InsertGPT,这些模型就会支持句子补全。

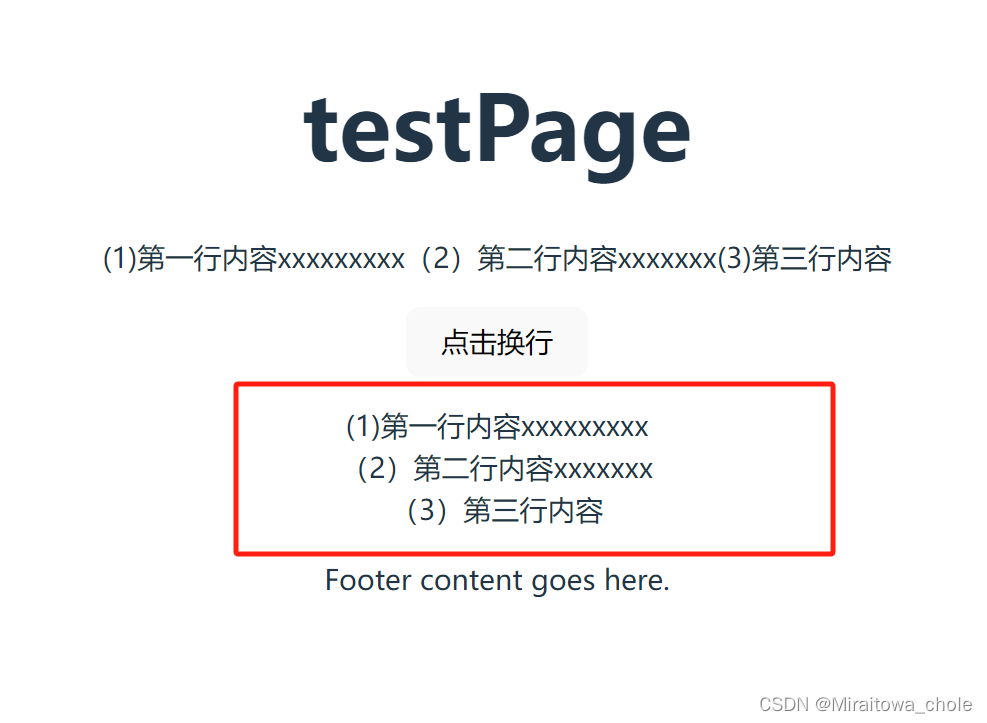

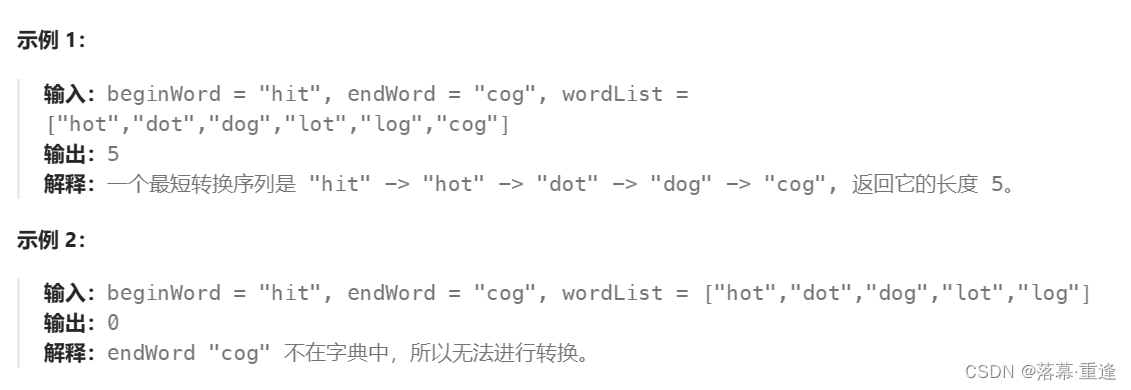

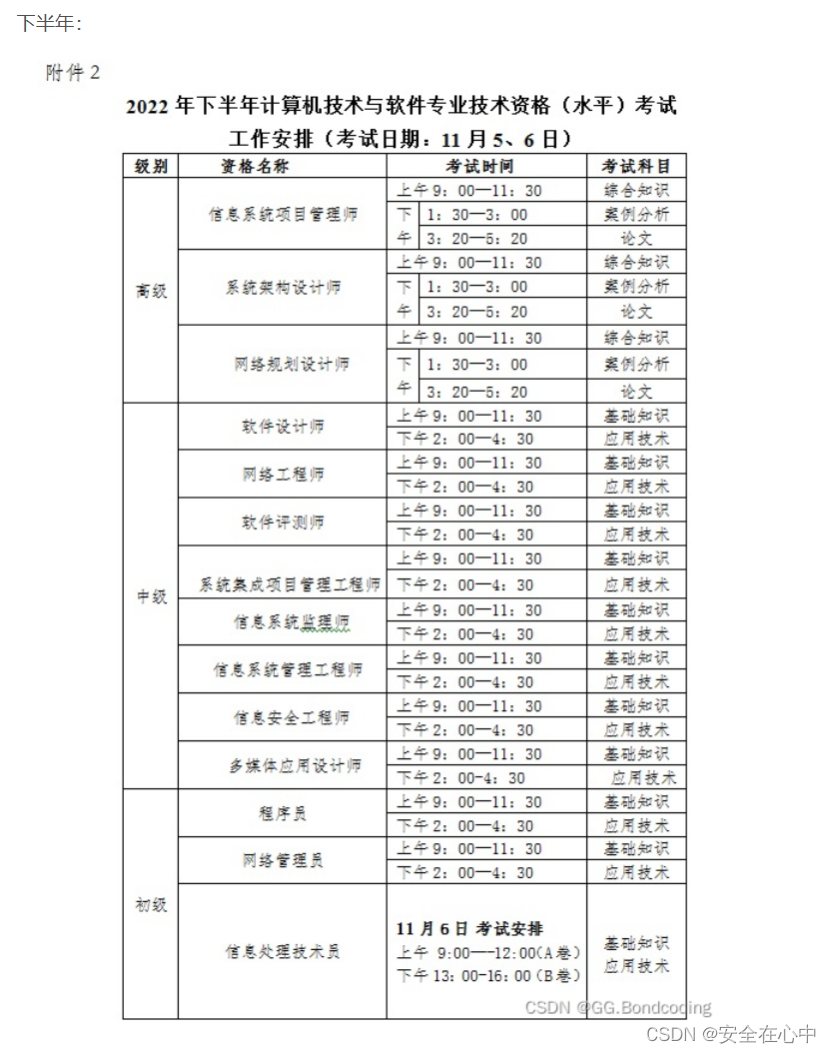

因此作者为这两类模型分别设置了两种方法,例子如下:

同时作者指出,也不一定要和这俩完全相同,使用回答评价指标一定可以找到一个更加适合指令instruction生成的prompt这里只是样板(template)。作者给出了在本文实验当中实际采用的prompt:

如何评价这些prompt

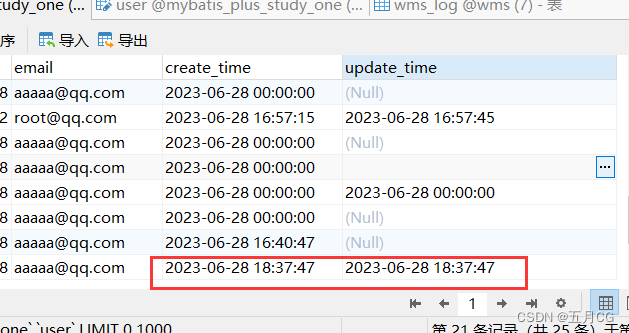

就是简单的让其跑一下分

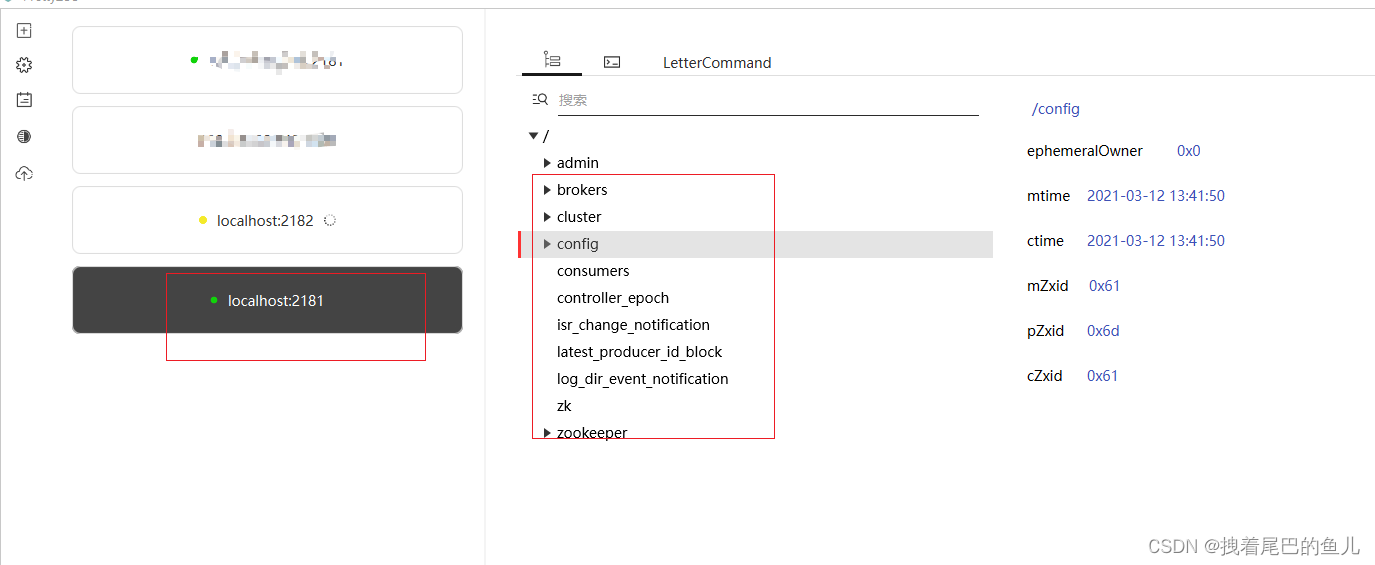

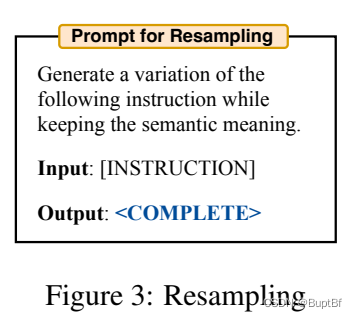

如何进一步优化prompt

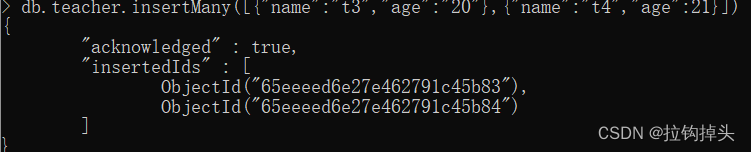

可以使用大语言模型进一步resample跑一下选出来的高分指令instruction:

再在这些指令当做选择更好的指令。