3 模型评估

在测试AI系统中的模型训练和评估阶段,需要使用准备好的数据集对AI模型进行训练和评估。在训练过程中,应该对模型进行监控和调整,以确保模型的准确性和效果。在评估过程中,需要使用测试数据集对模型进行测试,以验证模型的准确性和效果。模型的评估也分为离线评估和在线评估,离线评估,也叫线下评估,是基于训练样本进行模型训练,利用得到的模型在测试样本上进行测试,并计算特定的评估指标。在线评估,也叫线上评估,是在实际生产环境中应用新的模型,并对于真实用户类似点击次数、搜索次数等行为进行收集和分析。绝大部分是通过A/B测试实验来完成的,但是针对模型的实验中我们要保证除了模型的不同其他条件要是相同的,从而才能对比不同模型的差异性,本文中如无特殊说明所说的评估都是模型的离线评估。

3.1 LLM中常用生成配置参数含义

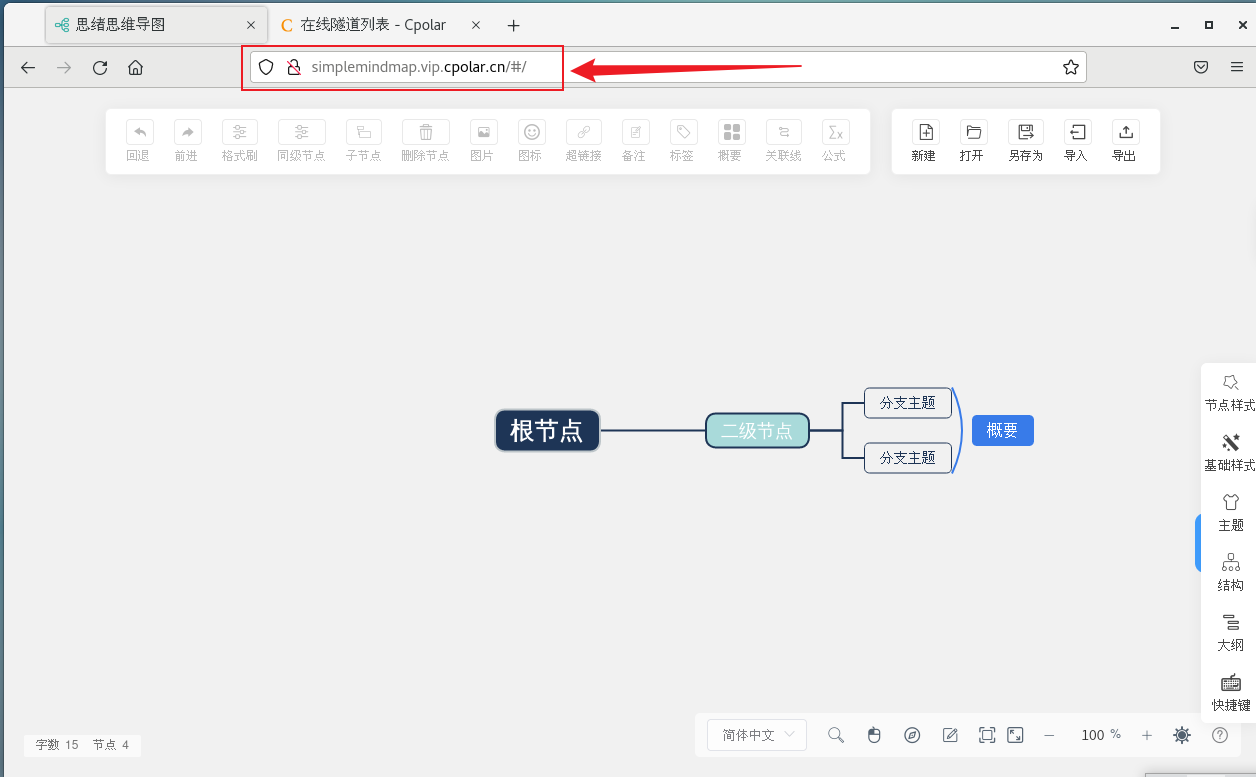

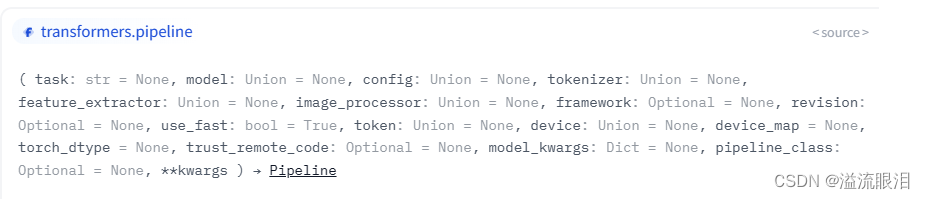

在Huggingface中第一次使用大模型的时候,常常会看到一些需要调整的参数,这些参数对于模型的输出有着重要的影响,因此也是需要了解的。

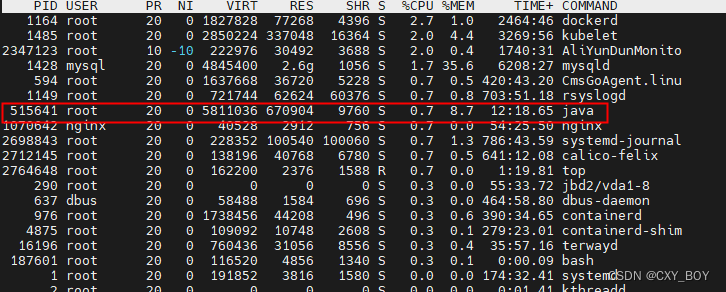

在上图中有 4 个配置的参数分别是 Max new tokens、top-k、top-p以及 Temperature。

token相信大家都不陌生了,现在在常用的 chatGPT 使用过程中个就有 token 的概念,这里的参数是 Max new tokens 的设置,是最大的新 token 的数量,是一个上限值。并不是说每次生成的新 token 都是 Max new tokens 的值。