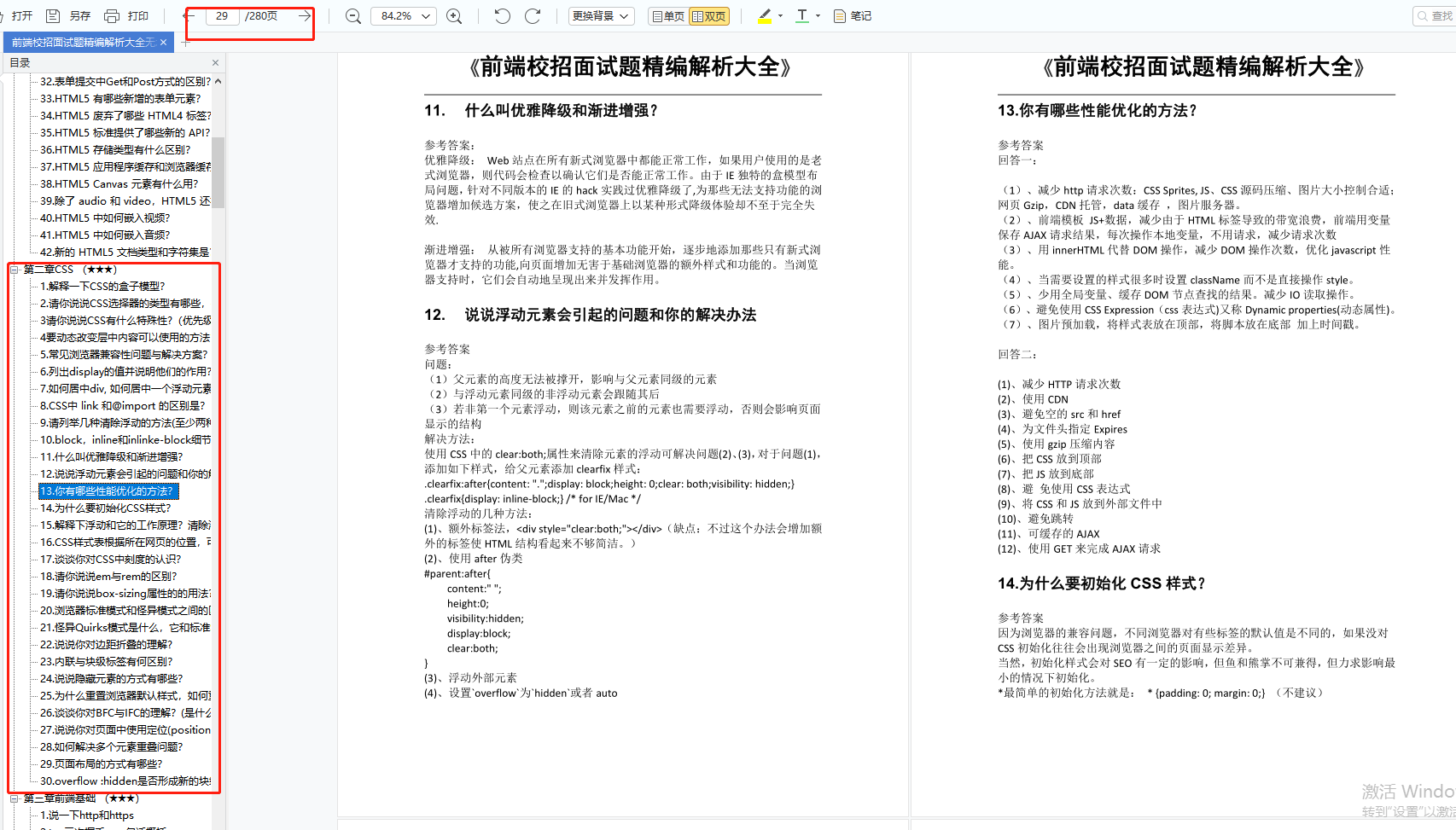

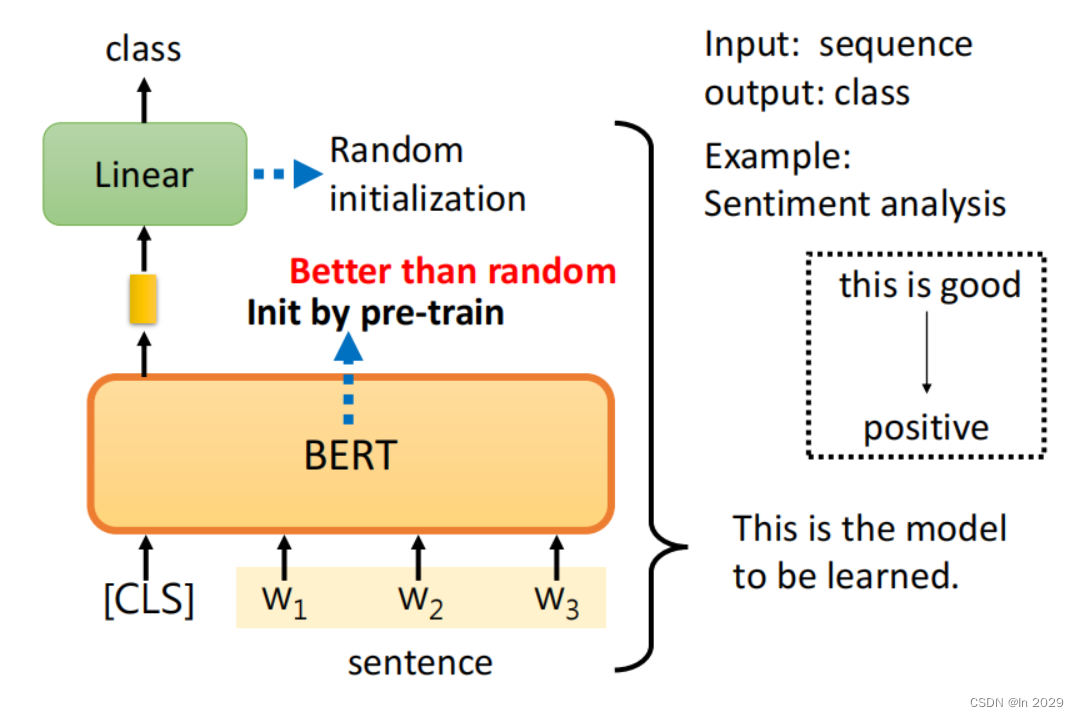

一、case

1.case1

多输入单输出。通过输入一个句子(sequence),然后输出一个句子的分类(这个句子是正向还是负向)。将句子输入BERT,然后通过softmax输出分类。

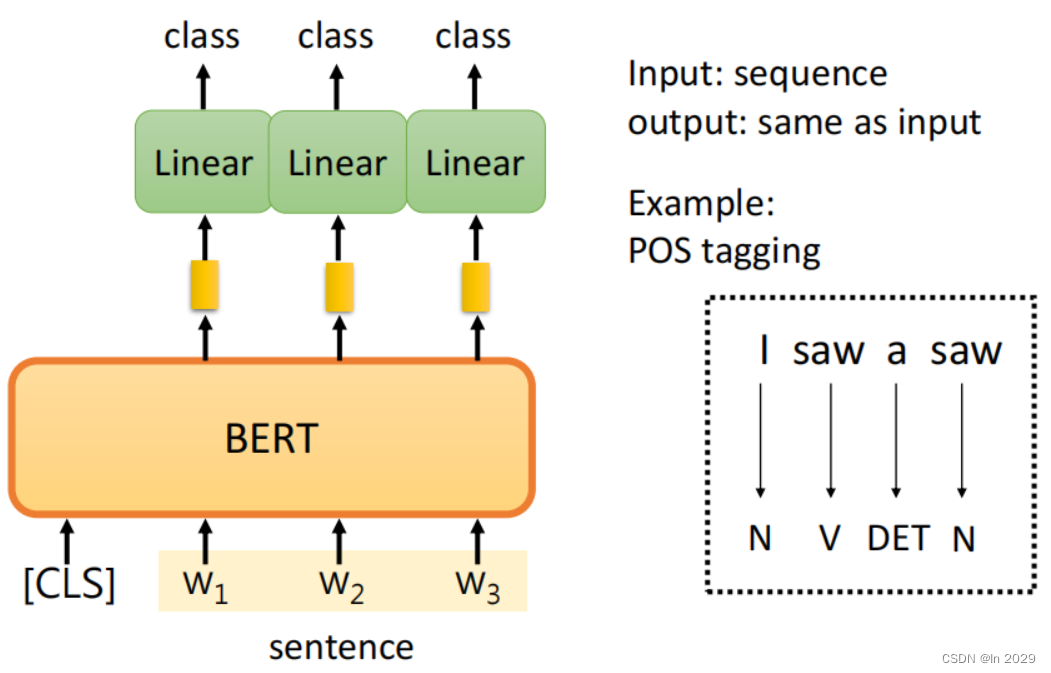

2.case2

多输入多输出。输入一个句子,输出句子中每个单词的词性。每一个词对应一个向量,然后每一个向量分别做一个linear的transformer乘以矩阵,在经过softmax输出类别

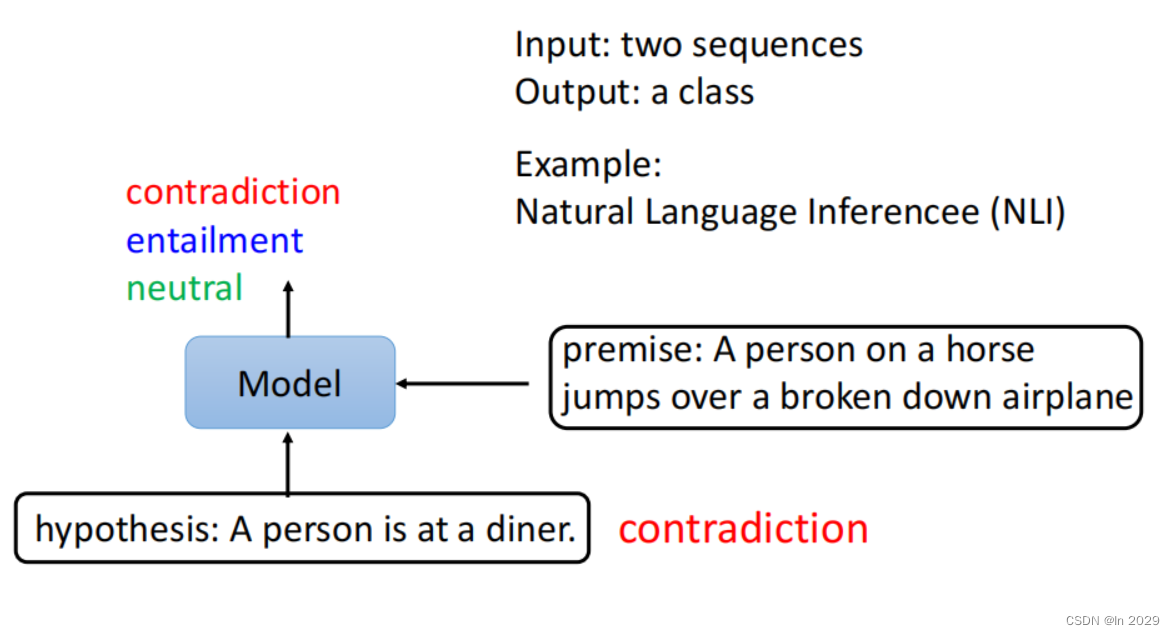

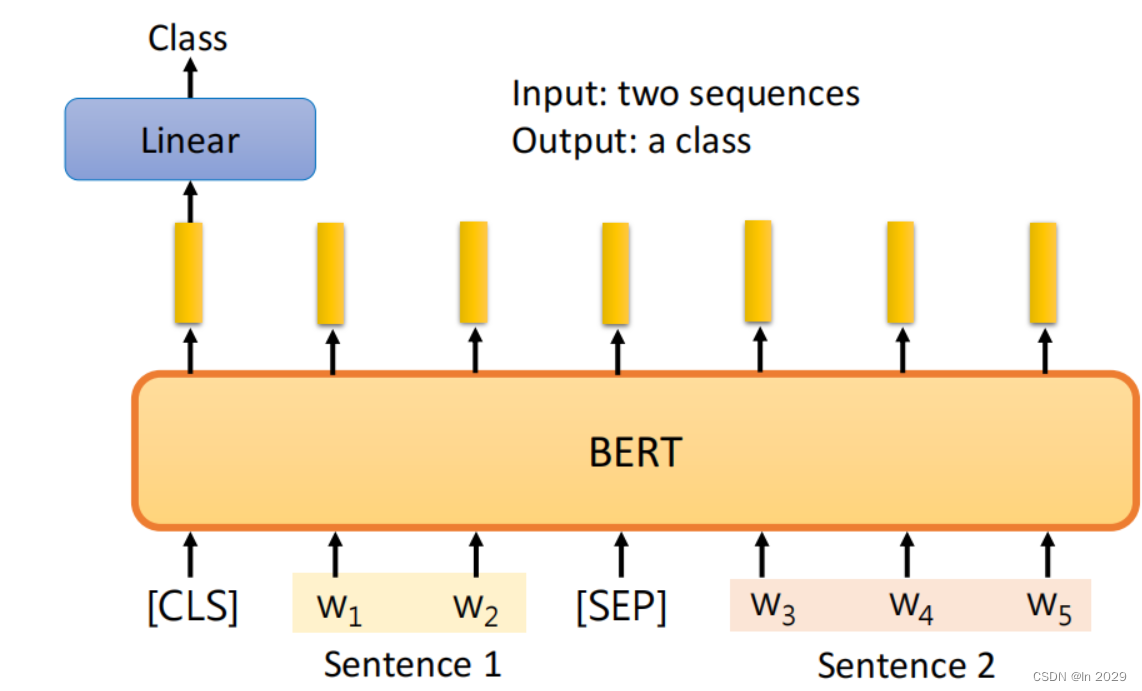

3.case3

多输入单输出。输入两个句子,输出这两个句子是否相关。

输入两个句子以及[SEP]和[CLS]到BERT中,然后在[CLS]对应位置,经过Lineartransformer,最后通过softmax输出分类。

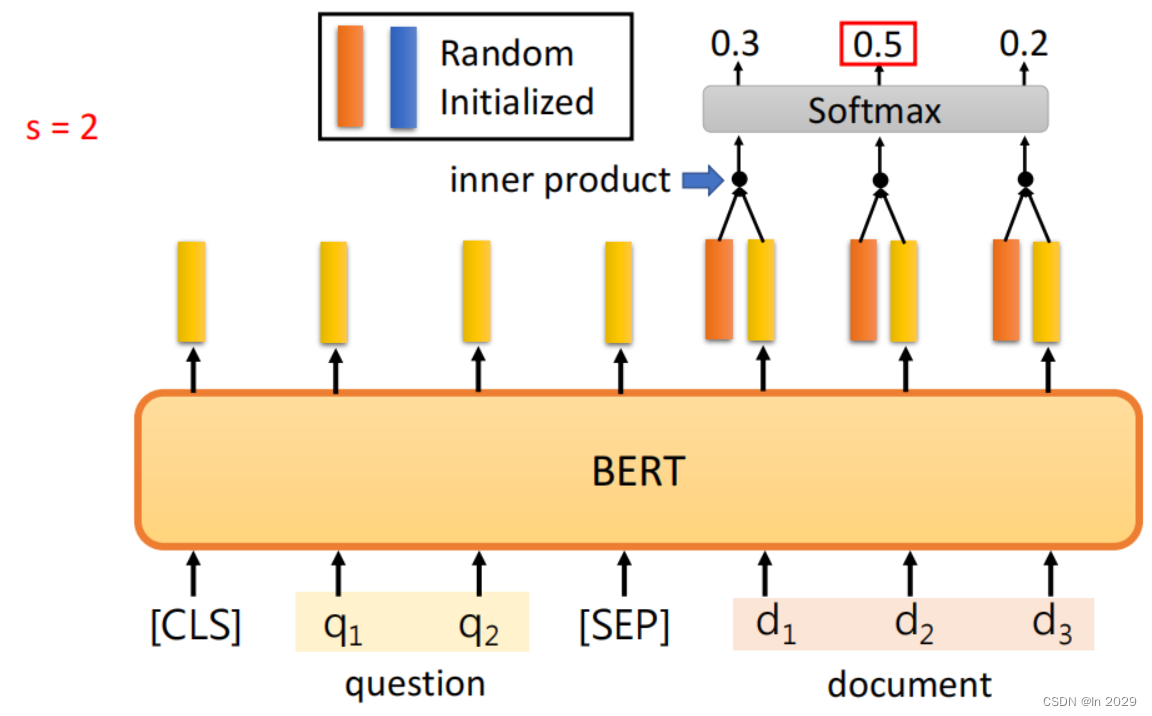

4.case4

多输入多输出。将问题和文章输入到BERT中,通过RandomInitialized,与输入内容对应的向量做内积,通过softmax输出,选择可能性最大的内容输出。

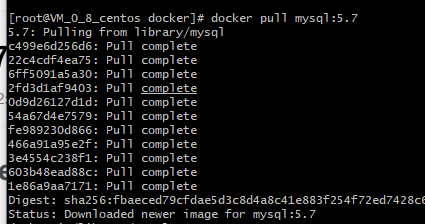

二、work作用

1.例子

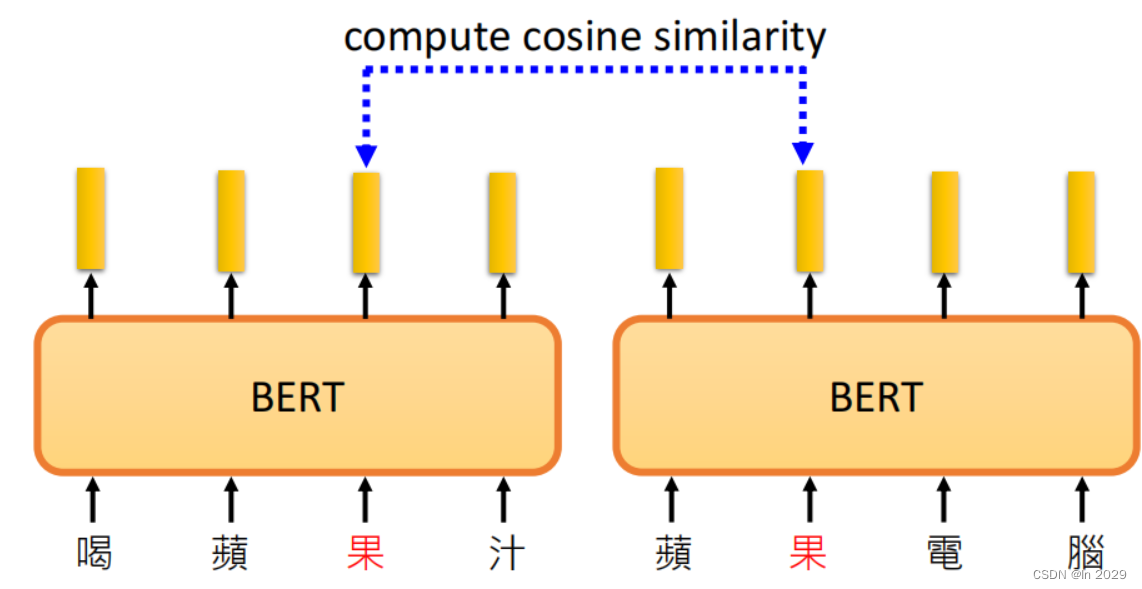

喝苹果汁的过和评估电脑的过是不一样的。因为将内容输入到BERT中,BERT是一个encoder,带有selfattention,会根据上下文的不同,果对应的向量也不同。

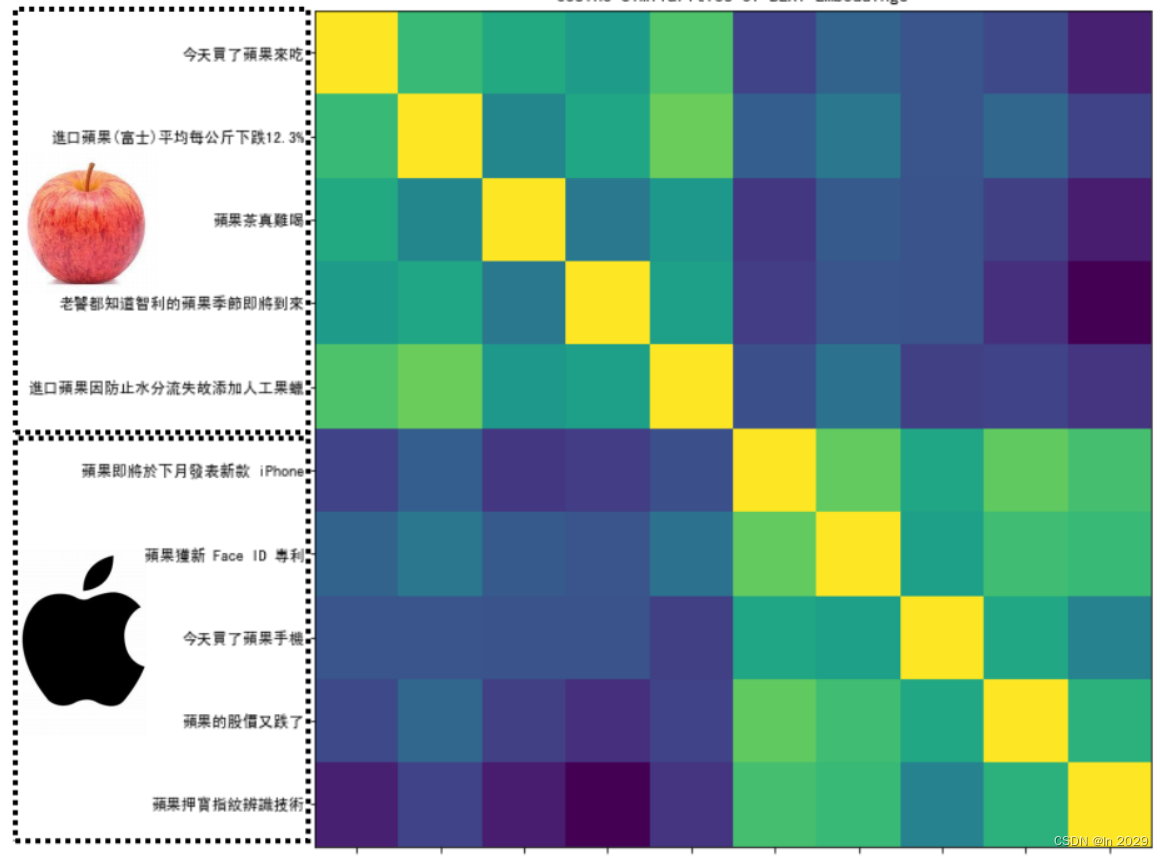

通过计算果的相似度,上面5句话是代表能吃的果,下面的5句话代表苹果公司,两两之间做相似度,形成一个10x10的矩阵。黄色代表相似度高,蓝色代表相似度低。

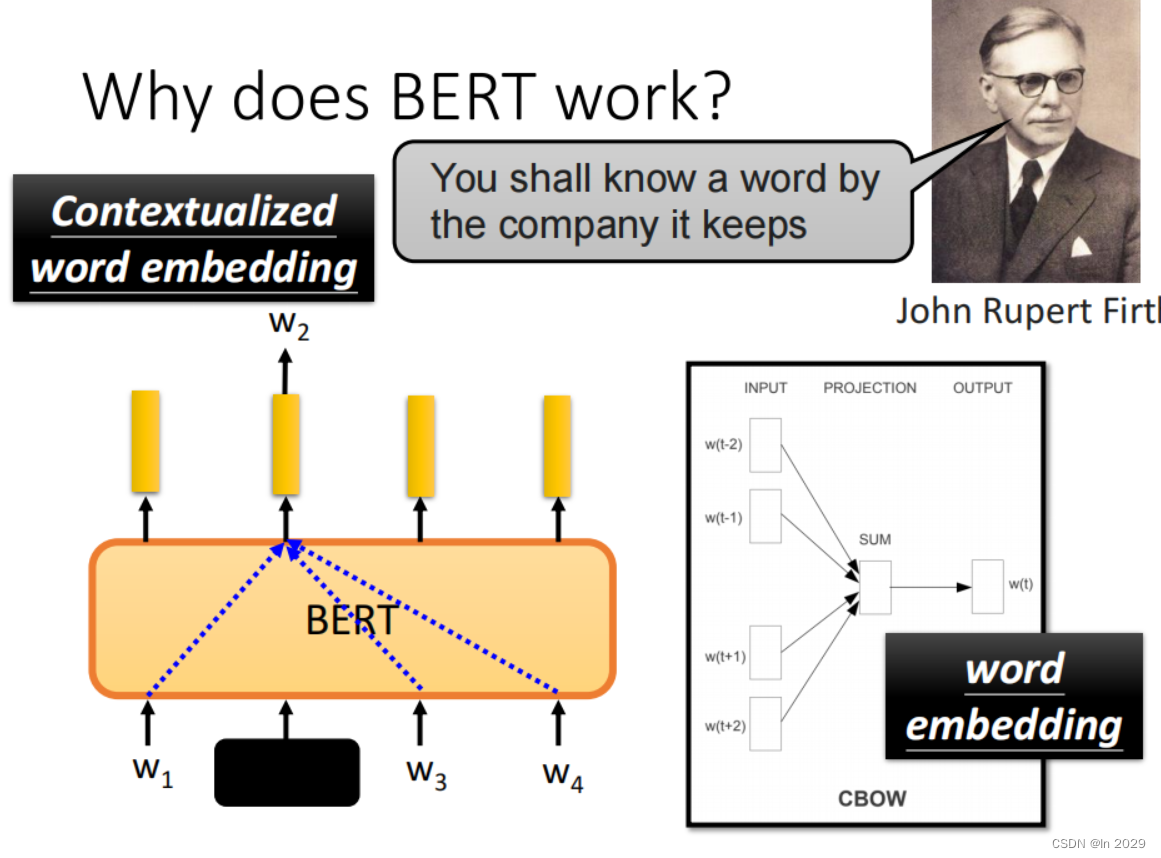

2.BERT根据上下文预测填空

BERT根据w2的上下文即w1、w3、w4,可以预测出w2的内容。