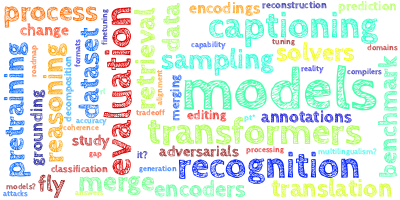

AI视野·今日CS.NLP 自然语言处理论文速览

Fri, 1 Mar 2024

Totally 67 papers

👉上期速览✈更多精彩请移步主页

Daily Computation and Language Papers

| Loose LIPS Sink Ships: Asking Questions in Battleship with Language-Informed Program Sampling Authors Gabriel Grand, Valerio Pepe, Jacob Andreas, Joshua B. Tenenbaum 问题将我们对语言的掌握与我们对不确定性进行推理的卓越能力结合起来。在认知资源有限的情况下,人们如何在广阔的假设空间中导航并提出信息丰富的问题?我们在基于棋盘游戏战舰的经典提问任务中研究了这些权衡。我们的语言知情程序采样 LIPS 模型使用大型语言模型 LLM 来生成自然语言问题,将其转换为符号程序,并评估其预期信息增益。我们发现,在资源预算出人意料地适度的情况下,这种简单的蒙特卡罗优化策略产生了反映人类在不同战舰棋盘场景中表现的信息丰富的问题。相比之下,LLM 仅基线很难解决董事会状态中的问题,值得注意的是,GPT 4V 与非视觉基线相比没有提供任何改进。 |

| TV-TREES: Multimodal Entailment Trees for Neuro-Symbolic Video Reasoning Authors Kate Sanders, Nathaniel Weir, Benjamin Van Durme 对电视剪辑等复杂的多模式内容进行问答具有挑战性。部分原因是当前的视频语言模型依赖于单一模态推理,在长输入上的性能降低,并且缺乏互用性。我们提出了 TV TREES,这是第一个多模态蕴涵树生成器。 TV TREES 是一种视频理解方法,通过在视频直接蕴涵的简单前提和更高层次的结论之间生成蕴涵关系树,促进可解释的联合模态推理。然后,我们引入多模态蕴涵树生成的任务来评估此类方法的推理质量。 |

| Towards Tracing Trustworthiness Dynamics: Revisiting Pre-training Period of Large Language Models Authors Chen Qian, Jie Zhang, Wei Yao, Dongrui Liu, Zhenfei Yin, Yu Qiao, Yong Liu, Jing Shao 确保大型语言模型法学硕士的可信度至关重要。大多数研究集中于经过充分培训的法学硕士,以更好地理解和提高法学硕士的可信度。在本文中,为了揭示预训练尚未开发的潜力,我们率先探索了这一时期法学硕士的可信度,重点关注五个关键维度的可靠性、隐私性、毒性、公平性和鲁棒性。首先,我们将线性探测应用于法学硕士。高探测精度表明,textit LLM 在早期预训练中已经可以区分每个可信度维度中的概念。因此,为了进一步揭示预训练隐藏的可能性,我们从LLM的预训练检查点中提取引导向量,以增强LLM的可信度。最后,受 citet choi2023 了解互信息估计受线性探测精度限制的启发,我们还利用互信息探测 LLM,以研究预训练期间可信度的动态。我们是第一个观察到类似两相现象拟合和压缩的 citep shwartz2017opening 。这项研究对法学硕士预培训期间的可信度建模进行了初步探索,旨在揭示新的见解并促进该领域的进一步发展。 |

| $\texttt{COSMIC}$: Mutual Information for Task-Agnostic Summarization Evaluation Authors Maxime Darrin, Philippe Formont, Jackie Chi Kit Cheung, Pablo Piantanida 评估摘要者的质量提出了重大挑战。作为回应,我们提出了一种新颖的面向任务的评估方法,该方法根据摘要者生成对下游任务有用的摘要的能力进行评估,同时保留任务结果。从理论上讲,我们在这些任务的错误概率与源文本和生成的摘要之间的相互信息之间建立了直接关系。我们引入 texttt COSMIC 作为该指标的实际实现,证明其与基于人类判断的指标的强相关性及其在预测下游任务绩效方面的有效性。 |

| On the Scaling Laws of Geographical Representation in Language Models Authors Nathan Godey, ric de la Clergerie, Beno t Sagot 长期以来,语言模型已被证明可以将地理信息嵌入到其隐藏表示中。最近,通过将此结果扩展到大型语言模型法学硕士,重新审视了这一领域的工作。在本文中,我们建议通过观察地理知识在扩展语言模型时如何演变来填补成熟文献和最新文献之间的空白。我们证明,即使对于微小的模型,地理知识也是可观察的,并且随着我们增加模型大小,它会持续扩展。 |

| OpenMedLM: Prompt engineering can out-perform fine-tuning in medical question-answering with open-source large language models Authors Jenish Maharjan, Anurag Garikipati, Navan Preet Singh, Leo Cyrus, Mayank Sharma, Madalina Ciobanu, Gina Barnes, Rahul Thapa, Qingqing Mao, Ritankar Das 法学硕士完成一系列专业任务的能力越来越强,可以用来扩大医学知识的公平获取。大多数医学法学硕士都涉及广泛的微调,利用专门的医学数据和大量但昂贵的计算能力。许多表现最好的法学硕士都是专有的,只有极少数的研究小组才能访问它们。然而,开源操作系统模型代表了医学法学硕士的一个关键增长领域,因为其性能显着提高,并且具有提供医疗保健所需的透明度和合规性的固有能力。我们推出 OpenMedLM,这是一个提示平台,可为 OS LLM 在医学基准方面提供最先进的 SOTA 性能。我们根据四个医学基准 MedQA、MedMCQA、PubMedQA、MMLU 医学子集评估了一系列操作系统基础法学硕士 7B 70B。我们采用了一系列的提示策略,包括零样本、少样本、思想链随机选择和 kNN 选择以及集成自一致性投票。我们发现 OpenMedLM 在三个常见的医学 LLM 基准上提供了操作系统 SOTA 结果,超越了之前利用计算成本高昂的广泛微调的最佳性能操作系统模型。该模型在 MedQA 基准上的准确度为 72.6,比之前的 SOTA 高出 2.4,并在 MMLU 医学子集上达到 81.7 的准确度,成为第一个在此基准上超过 80 准确度的 OS LLM。 |

| Prompting Explicit and Implicit Knowledge for Multi-hop Question Answering Based on Human Reading Process Authors Guangming Huang, Yunfei Long, Cunjin Luo, Jiaxing Shen, Xia Sun 预先训练的语言模型 PLM 利用思想链 CoT 来模拟人类推理和推理过程,从而在多跳 QA 中实现熟练的性能。然而,在解决复杂问题时,PLM 的推理能力与人类之间仍然存在差距。心理学研究表明,段落中的明确信息与人类在阅读过程中的先验知识之间存在着重要的联系。然而,当前的研究从人类认知研究的角度对输入通道和 PLM 预训练知识的联系还没有给予足够的重视。在本研究中,我们引入了一个 textbf Prompting textbf E xplicit 和 textbf I mplicit Knowledge PEI 框架,该框架使用提示来连接显性和隐性知识,与多跳 QA 的人类阅读过程保持一致。我们将输入段落视为显性知识,利用它们通过统一的即时推理来引出隐性知识。此外,我们的模型通过提示(一种隐性知识的形式)结合了特定类型的推理。实验结果表明,PEI 在 HotpotQA 上的表现与现有技术相当。 |

| Here's a Free Lunch: Sanitizing Backdoored Models with Model Merge Authors Ansh Arora, Xuanli He, Maximilian Mozes, Srinibas Swain, Mark Dras, Qiongkai Xu 通过开源计划实现预训练语言模型的民主化迅速推进了创新并扩大了对尖端技术的获取。然而,这种开放性也带来了重大的安全风险,包括后门攻击,其中隐藏的恶意行为由特定输入触发,损害自然语言处理 NLP 系统的完整性和可靠性。本文建议,将后门模型与其他同类模型合并可以修复后门漏洞,即使这些模型并不完全安全。在我们的实验中,我们探索了各种模型 BERT Base、RoBERTa Large、Llama2 7B 和 Mistral 7B 以及数据集 SST 2、OLID、AG News 和 QNLI。与多种先进的防御方法相比,我们的方法提供了针对后门攻击的有效且高效的推理阶段防御,而无需额外的资源或特定知识。我们的方法始终优于其他先进基线,导致攻击成功率平均降低 75。 |

| Compact Speech Translation Models via Discrete Speech Units Pretraining Authors Tsz Kin Lam, Alexandra Birch, Barry Haddow 使用自监督学习 SSL 作为模型初始化现在很常见,可以在语音翻译 ST 中获得出色的结果。然而,它们也占用了大量的内存,阻碍了设备部署。在本文中,我们通过在离散语音单元 DSU 上预训练较小的模型来利用 SSL 模型。我们在 1 个 Filterbank 到 DSU 和 2 个 DSU 到翻译数据上预训练编码器解码器模型,并使用 1 中的编码器和 2 中的解码器来初始化新模型,并在有限的语音翻译数据上对其进行微调。通过使用 DSU 预训练来提取 SSL 模型的知识,最终模型变得紧凑。与使用 DSU 作为模型输入相比,我们的方法有几个优点,例如更短的推理管道以及相对于 DSU 标记化的鲁棒性。与 ASR 预训练相比,它不需要转录本,因此适用于低资源设置。 |

| WanJuan-CC: A Safe and High-Quality Open-sourced English Webtext Dataset Authors Jiantao Qiu, Haijun Lv, Zhenjiang Jin, Rui Wang, Wenchang Ning, Jia Yu, ChaoBin Zhang, Pei Chu, Yuan Qu, Runyu Peng, Zhiyuan Zeng, Huanze Tang, Ruiliang Xu, Wei Li, Hang Yan, Conghui He 本文提出了 WanJuan CC,一个源自 Common Crawl 数据的安全且高质量的开源英语网络文本数据集。该研究解决了为语言模型构建大规模预训练数据集的挑战,这需要大量高质量的数据。设计了一套全面的流程来处理Common Crawl数据,包括提取、启发式规则过滤、模糊去重、内容安全过滤和数据质量过滤。我们从约 680 亿份英文原始文档中,获得了 2.22T 安全数据 Token,并筛选出 1.0T 优质数据 Token 作为万卷 CC 的一部分。我们从这个数据集中开源了 300B 代币。论文还提供了与数据质量相关的统计信息,使用户能够根据自己的需要选择合适的数据。为了评估数据集的质量和实用性,我们使用 WanJuan CC 和另一个数据集RefinedWeb 训练了 1B 参数和 3B 参数模型。 |

| PlanGPT: Enhancing Urban Planning with Tailored Language Model and Efficient Retrieval Authors He Zhu, Wenjia Zhang, Nuoxian Huang, Boyang Li, Luyao Niu, Zipei Fan, Tianle Lun, Yicheng Tao, Junyou Su, Zhaoya Gong, Chenyu Fang, Xing Liu 在城市规划领域,通用大型语言模型往往难以满足规划者的特定需求。生成城市规划文本、检索相关信息和评估规划文件等任务带来了独特的挑战。为了提高城市专业人员的效率并克服这些障碍,我们推出了 PlanGPT,这是第一个为城市和空间规划量身定制的专业大型语言模型。 PlanGPT 通过与中国城市规划研究院等机构合作开发,利用定制的本地数据库检索框架、基础模型的特定领域微调以及先进的工具功能。 |

| Robust Guidance for Unsupervised Data Selection: Capturing Perplexing Named Entities for Domain-Specific Machine Translation Authors Seunghyun Ji, Hagai Raja Sinulingga, Darongsae Kwon 使用广泛的数据集可以训练多语言机器翻译模型,但是这些模型通常无法准确翻译专业领域内的句子。尽管获取和翻译特定领域的数据会产生高昂的成本,但对于高质量的翻译来说这是不可避免的。因此,在无人监督的情况下寻找最有效的数据成为降低标签成本的实用策略。最近的研究表明,可以通过根据数据量适当选择困难数据来找到这些有效数据。这意味着数据不应过于具有挑战性或过于简单,特别是在数据量有限的情况下。然而,我们发现建立无监督数据选择的标准仍然具有挑战性,因为适当的难度可能会根据所训练的数据域的不同而有所不同。我们引入了一种新颖的无监督数据选择方法,即捕获令人困惑的命名实体,该方法采用翻译命名实体中的最大推理熵作为选择度量。动机是特定领域数据中的命名实体被认为是数据中最复杂的部分,并且应该以高置信度进行预测。 |

| GSM-Plus: A Comprehensive Benchmark for Evaluating the Robustness of LLMs as Mathematical Problem Solvers Authors Qintong Li, Leyang Cui, Xueliang Zhao, Lingpeng Kong, Wei Bi 大型语言模型法学硕士在各种数学推理基准测试中取得了令人印象深刻的表现。然而,关于这些模型是否真正理解和应用数学知识,还是仅仅依赖数学推理的捷径,争论越来越多。一个重要且经常出现的证据是,当数学问题稍有改变时,法学硕士可能会表现不正确。这促使我们通过测试各种问题的变化来评估法学硕士数学推理能力的稳健性。我们介绍了对抗性小学数学数据集名称数据集,它是 GSM8K 的扩展,并增加了各种数学扰动。我们对 25 名法学硕士和 4 种提示技巧进行的实验表明,虽然法学硕士表现出不同水平的数学推理能力,但他们的表现远非稳健。特别是,即使对于 GSM8K 中已解决的问题,法学硕士在添加新陈述或更改问题目标时也可能会出错。我们还探讨了是否可以通过组合现有的提示方法来实现更鲁棒的性能,其中我们尝试一种迭代方法,根据其推理目标和计算结果生成并验证每个中间思想。 |

| Let LLMs Take on the Latest Challenges! A Chinese Dynamic Question Answering Benchmark Authors Zhikun Xu, Yinghui Li, Ruixue Ding, Xinyu Wang, Boli Chen, Yong Jiang, Xiaodong Deng, Jianxin Ma, Hai Tao Zheng, Wenlian Lu, Pengjun Xie, Chang Zhou, Fei Huang 如何更好地评估大型语言模型法学硕士的能力是当前法学硕士研究的焦点和热点。之前的工作指出,由于LLM的迭代更新成本极高,他们往往无法很好地回答最新的动态问题。为了促进中国法学硕士回答动态问题的能力的提高,在本文中,我们引入了CDQA,一个包含与中国互联网最新新闻相关的问答对的中文动态问答基准。我们通过人类和模型相结合的管道获得高质量的数据,并根据答案变化的频率对样本进行仔细分类,以方便更细粒度地观察法学硕士的能力。我们还对中国主流和先进的法学硕士在CDQA上进行了评估和分析。大量的实验和有价值的见解表明,我们提出的 CDQA 具有挑战性,值得进一步研究。 |

| Memory-Augmented Generative Adversarial Transformers Authors Stephan Raaijmakers, Roos Bakker, Anita Cremers, Roy de Kleijn, Tom Kouwenhoven, Tessa Verhoef 依赖于大型语言模型的对话式人工智能系统(例如 Transformer)很难将事实等外部数据与它们生成的语言交织在一起。 Vanilla Transformer 架构并不是为高精度回答事实问题而设计的。本文研究了解决该问题的可能途径。我们建议扩展标准 Transformer 架构,使用额外的内存库来保存额外的信息,例如从知识库中提取的事实,以及用于寻址该内存的额外关注层。我们将这种增强记忆添加到受生成对抗网络启发的 Transformer 架构中。此设置允许在 Transformer 生成的语言上实现任意适当条件。我们首先演示如何部署该机制来处理面向目标的对话中的事实问题。 |

| PeLLE: Encoder-based language models for Brazilian Portuguese based on open data Authors Guilherme Lamartine de Mello, Marcelo Finger, and Felipe Serras, Miguel de Mello Carpi, Marcos Menon Jose, Pedro Henrique Domingues, Paulo Cavalim 在本文中,我们介绍了 PeLLE,这是一个基于 RoBERTa 架构的大型语言模型系列,适用于巴西葡萄牙语,并使用来自卡罗来纳语料库的精选开放数据进行训练。为了获得可重复的结果,我们描述了模型预训练的细节。我们还针对一组现有的多语言和 PT BR 精炼的基于 Transformer 的 LLM 编码器评估 PeLLE 模型,对比大型与小型但精心策划的预训练模型在几个下游任务中的性能。 |

| Improving Legal Judgement Prediction in Romanian with Long Text Encoders Authors Mihai Masala, Traian Rebedea, Horia Velicu 近年来,整个自然语言处理 NLP 领域都取得了惊人的新颖成果,在各种任务上实现了几乎与人类相似的表现。法律 NLP 领域也是这一过程的一部分,因为它取得了令人印象深刻的增长。然而,通用模型并不容易适用于法律领域。由于域的性质,例如法律NLP往往需要专门的词汇、长文档、特定的模型和方法。在这项工作中,我们研究了预测法律案件最终裁决的专用模型和通用模型,即称为法律判决预测 LJP 的任务。我们特别关注扩展到基于 Transformer 的模型的序列长度的方法,以更好地理解法律语料库中存在的长文档。 |

| Teaching Large Language Models an Unseen Language on the Fly Authors Chen Zhang, Xiao Liu, Jiuheng Lin, Yansong Feng 现有的大型语言模型很难支持多种低资源语言,特别是资源极低的语言,其中可用于有效参数更新的训练数据最少。因此,我们调查法学硕士是否可以仅通过提示即时学习一门新语言。为了研究这个问题,我们收集了壮语的研究套件,目前尚无法学硕士支持这种语言。我们引入了textsc DiPMT,这是一个通过上下文学习使法学硕士适应未见过的语言的框架。使用字典和仅 5K 并行句子,textsc DiPMT 显着增强了 GPT 4 的汉语到壮语翻译的 BLEU 从 0 到 16 BLEU 的性能,并实现了壮语到汉语翻译的 32 BLEU。 |

| Evaluating Webcam-based Gaze Data as an Alternative for Human Rationale Annotations Authors Stephanie Brandl, Oliver Eberle, Tiago Ribeiro, Anders S gaard, Nora Hollenstein 在评估 NLP 中的可解释性方法时,手动注释输入范围形式的基本原理通常用作基本事实。然而,它们非常耗时,并且常常因注释过程而产生偏差。在本文中,我们讨论基于网络摄像头的眼动追踪记录形式的人类凝视在评估重要性分数时是否构成有效的替代方案。我们评估注视数据提供的附加信息,例如总阅读时间、注视熵和相对于人类基本原理注释的解码准确性。我们将 WebQAmGaze(用于信息寻求 QA 的多语言数据集)与 4 种不同的基于 Transformer 的多语言语言模型 mBERT、distil mBERT、XLMR 和 XLMR L 以及英语、西班牙语和德语 3 种语言的基于注意力和可解释性的重要性得分进行比较。我们的管道可以轻松应用于其他任务和语言。 |

| How to Understand "Support"? An Implicit-enhanced Causal Inference Approach for Weakly-supervised Phrase Grounding Authors Jiamin Luo, Jianing Zhao, Jingjing Wang, Guodong Zhou 弱监督短语基础 WPG 是一项新兴任务,它推断细粒度短语区域匹配,同时仅利用粗粒度句子图像对进行训练。然而,现有的WPG研究很大程度上忽略了隐式短语区域匹配关系,这对于评估模型理解深层多模态语义的能力至关重要。为此,本文提出了一种隐式增强因果推理 IECI 方法,以解决对隐式关系进行建模并在显式关系之外突出它们的挑战。具体来说,这种方法利用干预和反事实技术分别应对上述两个挑战。此外,还注释了高质量的隐式增强数据集来评估 IECI,详细的评估显示了 IECI 相对于最先进的基线的巨大优势。 |

| TEncDM: Understanding the Properties of Diffusion Model in the Space of Language Model Encodings Authors Alexander Shabalin, Viacheslav Meshchaninov, Tingir Badmaev, Dmitry Molchanov, Grigory Bartosh, Sergey Markov, Dmitry Vetrov 从各个领域的扩散模型的成功中汲取灵感,许多研究论文提出了将其适应文本数据的方法。尽管做出了这些努力,但他们都未能达到大型语言模型的质量。在本文中,我们对文本扩散模型的关键组成部分进行了全面分析,并介绍了一种名为文本编码扩散模型 TEncDM 的新方法。我们在语言模型编码的空间中训练我们的模型,而不是常用的标记嵌入空间。此外,我们建议使用基于 Transformer 的解码器,利用上下文信息进行文本重建。我们还分析了自我调节,发现它增加了模型输出的幅度,从而减少了推理阶段的去噪步骤数量。 |

| Survey in Characterization of Semantic Change Authors Jader Martins Camboim de S , Marcos Da Silveira, C dric Pruski 实时语言不断发展以融入人类社会的文化变迁。这种演变通过新词、新词或文本的语义变化体现为现有词的新含义。理解单词的含义对于解释来自不同文化、地区主义或俚语、领域(例如技术术语或时期)的文本至关重要。在计算机科学中,这些单词与计算语言学算法相关,例如翻译、信息检索、问答等。语义变化可能会影响这些算法结果的质量。因此,正式理解和描述这些变化非常重要。这种影响的研究是最近引起计算语言学界关注的问题。几种方法提出了高精度检测语义变化的方法,但需要付出更多努力来表征单词含义如何变化并推理如何减少语义变化的影响。这项调查提供了对语义变化的文本表征的现有方法的可理解的概述,并且还正式定义了三类表征,如果一个词的含义变得更普遍,或者如果该词用于更贬义或积极的改进,则维度上的变化变得更窄。意义方向的变化,以及是否有在隐喻或转喻语境中使用该词的趋势,例如关系的变化。 |

| Pointing out the Shortcomings of Relation Extraction Models with Semantically Motivated Adversarials Authors Gennaro Nolano, Moritz Blum, Basil Ell, Philipp Cimiano 近年来,大型语言模型在各种 NLP 任务中取得了最先进的性能。然而,调查表明,这些模型往往依赖于快捷特征,导致预测不准确,并导致模型在泛化到分布外的 OOD 样本时不可靠。例如,在关系提取 RE 的背景下,我们期望模型能够独立于其中涉及的实体来识别相同的关系。例如,考虑句子“莱昂纳多·达·芬奇画了蒙娜丽莎”,表达了所创建的“莱昂纳多·达·芬奇,蒙娜丽莎”关系。如果我们用巴拉克·奥巴马代替列奥纳多·达·芬奇,那么该句子仍然表达了所创建的关系。稳健的模型应该能够在两种情况下检测到相同的关系。在这项工作中,我们描述了几种语义驱动的策略,通过替换实体提及来生成对抗性示例,并研究最先进的 RE 模型在压力下的表现。我们的分析表明,这些模型的性能在修改后的数据集上平均显着恶化。 |

| Exploring the Efficacy of Large Language Models in Summarizing Mental Health Counseling Sessions: A Benchmark Study Authors Prottay Kumar Adhikary, Aseem Srivastava, Shivani Kumar, Salam Michael Singh, Puneet Manuja, Jini K Gopinath, Vijay Krishnan, Swati Kedia, Koushik Sinha Deb, Tanmoy Chakraborty 会议的全面总结可以实现心理健康咨询的有效连续性,促进知情的治疗计划。然而,手动总结提出了重大挑战,分散了专家对核心咨询过程的注意力。本研究评估了最先进的大型语言模型法学硕士通过基于方面的总结选择性总结治疗课程的各个组成部分的有效性,旨在对其表现进行基准测试。我们介绍 MentalCLOUDS,这是一个咨询组件引导的总结数据集,由 191 个咨询会议组成,其摘要侧重于三个不同的咨询组件(也称为咨询方面)。此外,我们还评估了 11 名最先进的法学硕士在解决咨询中组件引导总结任务方面的能力。使用标准摘要指标对生成的摘要进行定量评估,并由心理健康专业人员进行定性验证。我们的研究结果表明,在咨询组件的各个方面,就标准定量指标(例如 Rouge 1、Rouge 2、Rouge L 和 BERTScore)而言,MentalLlama、Mistral 和 MentalBART 等任务特定的 LLM 均表现出色。此外,专家评估表明,基于情感态度、负担、道德、连贯性、机会成本和感知有效性六个参数,Mistral 取代了 MentalLlama 和 MentalBART。 |

| PopALM: Popularity-Aligned Language Models for Social Media Trendy Response Prediction Authors Erxin Yu, Jing Li, Chunpu Xu 社交媒体平台每天都会展示数百万个活动。为了初步预测主流公众对这些事件的反应,我们研究了流行响应预测,以自动生成对社交媒体事件最喜欢的用户回复。虽然之前的工作重点是生成响应而不考虑受欢迎程度,但我们提出了流行度对齐语言模型 PopALM,以通过强化学习来区分更多受众喜欢的响应。识别出用户喜欢的嘈杂标签,我们在近端策略优化 PPO 中定制课程学习,以帮助模型捕获从简单到困难训练的基本样本。 |

| Inappropriate Pause Detection In Dysarthric Speech Using Large-Scale Speech Recognition Authors Jeehyun Lee, Yerin Choi, Tae Jin Song, Myoung Wan Koo 构音障碍是中风患者的常见问题,严重影响言语清晰度。不适当的停顿是严重程度评估和言语治疗的关键指标。我们建议扩展大规模语音识别模型,以检测构音障碍语音中的不当停顿。为此,我们提出了任务设计、标记策略和具有不适当暂停预测层的语音识别模型。首先,我们将停顿检测视为语音识别,使用自动语音识别ASR模型将语音转换为带有停顿标签的文本。根据新设计的任务,我们在文本级别标记暂停位置及其适当性。我们与言语病理学家合作建立标签标准,确保高质量的注释数据。最后,我们使用不适当暂停预测层扩展 ASR 模型,以进行端到端不适当暂停检测。此外,我们提出了一种任务定制指标,用于评估独立于 ASR 性能的不当暂停检测。我们的实验表明,所提出的方法比基线更好地检测构音障碍语音中的不当停顿。 |

| AdaMergeX: Cross-Lingual Transfer with Large Language Models via Adaptive Adapter Merging Authors Yiran Zhao, Wenxuan Zhang, Huiming Wang, Kenji Kawaguchi, Lidong Bing 作为对特定语言的目标任务直接微调的有效替代方案,跨语言迁移通过对源语言中的目标任务和语言中的另一个选定任务进行微调,解耦任务能力和语言能力,解决了有限训练数据的挑战。分别为目标语言。然而,他们未能将任务能力与源语言或语言能力与所选任务完全分开。在本文中,我们承认任务能力和语言能力之间的相互依赖,并将我们的注意力转向目标语言和源语言在任务上的差距。由于差距消除了任务的影响,我们假设它在任务之间保持一致。基于这个假设,我们提出了一种新的跨语言传输方法,称为 texttt AdaMergeX,它利用自适应适配器合并。通过引入参考任务,我们可以确定两种语言中在参考任务上微调的适配器的分歧与两种语言中在目标任务上微调的适配器的分歧遵循相同的分布。因此,我们可以通过组合其他三个适配器来获得目标适配器。此外,我们提出了一种结构自适应适配器合并方法。 |

| Updating Language Models with Unstructured Facts: Towards Practical Knowledge Editing Authors Xiaobao Wu, Liangming Pan, William Yang Wang, Anh Tuan Luu 知识编辑旨在将知识更新注入语言模型中,以保持它们的正确性和最新性。然而,其当前的评估策略明显不切实际,它们仅使用精心策划的结构化事实三元组(主题、关系和对象)进行更新,而现实世界的知识更新通常出现在新闻文章等非结构化文本中。在本文中,我们提出了一个新的基准,非结构化知识编辑 UKE 。它直接使用非结构化文本作为知识更新(称为非结构化事实)来评估编辑性能。因此,UKE避免了结构化事实的费力构建,并实现了高效且响应迅速的知识编辑,成为更实用的基准。我们对新建的数据集进行了广泛的实验,并证明 UKE 对最先进的知识编辑方法提出了重大挑战,导致其关键性能下降。我们进一步表明,即使我们提取三元组作为结构化事实,这一挑战仍然存在。 |

| Principal Component Analysis as a Sanity Check for Bayesian Phylolinguistic Reconstruction Authors Yugo Murawaki 重建语言进化历史的贝叶斯方法依赖于树模型,该模型假设这些语言源自共同的祖先,并随着时间的推移而经历了修改。然而,由于接触等因素,这一假设可能会在不同程度上被违反。了解这一假设被违反的程度对于验证系统语言推理的准确性至关重要。在本文中,我们提出了一种简单的健全性检查,将重建的树投影到主成分分析生成的空间上。 |

| Reducing Hallucinations in Entity Abstract Summarization with Facts-Template Decomposition Authors Fangwei Zhu, Peiyi Wang, Zhifang Sui 实体摘要摘要旨在基于一组相关的互联网文档生成给定实体的连贯描述。预训练语言模型 PLM 在这项任务中取得了巨大的成功,但它们可能会产生幻觉,即生成有关实体的非事实信息。为了解决这个问题,我们将摘要分解为两个组件:事实,表示有关给定实体的事实信息(PLM 很容易伪造);模板,包含具有指定事实槽位的通用内容,PLM 可以胜任生成。基于事实模板分解,我们提出了 SlotSum,一个可解释的实体抽象摘要框架。 SlotSum 首先创建模板,然后根据输入文档预测每个模板槽的事实。受益于我们的事实模板分解,SlotSum 可以轻松定位错误,并利用外部知识进一步纠正幻觉预测。我们构建了一个新的数据集 WikiFactSum 来评估 SlotSum 的性能。 |

| When does word order matter and when doesn't it? Authors Xuanda Chen, Timothy O Donnell, Siva Reddy 语言模型 LM 可能对自然语言理解 NLU 任务中的词序变化不敏感。在本文中,我们提出语言冗余可以解释这种现象,即词序和其他语言线索(例如格标记)提供了重叠的冗余信息。我们的假设是,当顺序提供冗余信息时,模型表现出对词序不敏感,并且不敏感的程度因任务而异。我们使用未打乱的句子和打乱的句子之间的互信息 MI 来量化词序的信息量。我们的结果表明,词序信息越少,模型的预测在未打乱的句子和打乱的句子之间越一致。我们还发现,对于某些任务(例如 SST 2),效果因任务而异,即使 Pointwise MI PMI 发生变化,LM 预测也几乎总是与原始任务一致,而对于其他任务(例如 RTE),当 PMI 发生变化时,一致性接近随机。 |

| Utilizing Local Hierarchy with Adversarial Training for Hierarchical Text Classification Authors Zihan Wang, Peiyi Wang, Houfeng Wang 由于其复杂的分类结构,分层文本分类 HTC 是多标签分类的一项具有挑战性的子任务。几乎所有最近的 HTC 工作都关注标签的结构,但忽略了根据每个输入文本的真实标签的子结构,其中包含丰富的标签共现信息。在这项工作中,我们引入了带有对抗性框架的本地层次结构。我们提出了一个 HiAdv 框架,它可以适应几乎所有的 HTC 模型,并以局部层次结构作为辅助信息对其进行优化。我们对两种典型的 HTC 模型进行了测试,发现 HiAdv 在所有场景下都有效,并且擅长处理复杂的分类层次结构。 |

| How do Large Language Models Handle Multilingualism? Authors Yiran Zhao, Wenxuan Zhang, Guizhen Chen, Kenji Kawaguchi, Lidong Bing 大型语言模型法学硕士在多种语言上表现出了卓越的性能。在这项工作中,我们深入研究了法学硕士如何处理多语言问题我们引入了一个描述法学硕士处理多语言输入的框架在前几层中,法学硕士理解问题,将多语言输入转换为英语以促进任务解决阶段。在中间层,法学硕士通过用英语思考并结合多语言知识来获取事实内容,分别利用自注意力和前馈结构来解决问题。在最后几层中,法学硕士生成与查询的原始语言一致的响应。此外,我们还研究了处理某种语言时语言特异性神经元的存在。为了检测输入语言激活的神经元,即使没有标签,我们创新性地设计了一种并行语言特定神经元检测 texttt PLND 方法,该方法可以有效测量处理多语言输入时神经元的重要性。通过停用不同层和结构的神经元进行综合消融分析,我们验证了我们提出的框架。 |

| On the Decision-Making Abilities in Role-Playing using Large Language Models Authors Chenglei Shen, Guofu Xie, Xiao Zhang, Jun Xu 大型语言模型法学硕士现在越来越多地用于角色扮演任务,特别是主要通过角色扮演提示来模仿特定领域的专家。在现实世界场景中进行交互时,角色的决策能力会显着影响其行为模式。在本文中,我们集中评估法学硕士在角色扮演后的决策能力,从而验证角色扮演的有效性。我们的目标是提供指标和指导,以增强法学硕士在角色扮演任务中的决策能力。具体来说,我们首先使用 LLM 生成与 Myers Briggs Type Indicator(缩写为 MBTI)的 16 种性格类型相对应的虚拟角色描述,代表人群的细分。然后设计具体的量化操作,从适应能力、探索开发权衡能力、推理能力和安全性四个方面评价LLM角色扮演后的决策能力。最后,我们通过 GPT 4 分析了决策绩效与相应 MBTI 类型之间的关联。大量的实验表明,不同角色的决策能力的四个方面存在稳定的差异,这表明决策能力与所模拟的角色之间存在强大的相关性。由法学硕士。 |

| Advancing Generative AI for Portuguese with Open Decoder Gervásio PT* Authors Rodrigo Santos, Jo o Silva, Lu s Gomes, Jo o Rodrigues, Ant nio Branco 为了推进葡萄牙语的神经解码,在本文中,我们提出了一种完全开放的基于 Transformer 的指令调整解码器模型,该模型在这方面树立了新的技术水平。为了开发这个解码器,我们将其命名为 Gerv sio PT,使用强大的 LLaMA 2 7B 模型作为起点,并通过额外训练对语言资源进行进一步改进,其中包括为此目的准备的新葡萄牙语指令数据集,这也在本文中有所贡献。 Gerv sio 的所有版本都是开源的,并在开放许可下免费分发,包括用于研究或商业用途,并且可以在消费级硬件上运行,从而寻求为葡萄牙语语言技术的研究和创新的进步做出贡献 |

| How Much Annotation is Needed to Compare Summarization Models? Authors Chantal Shaib, Joe Barrow, Alexa F. Siu, Byron C. Wallace, Ani Nenkova 现代指令调整模型已经在摘要等文本生成任务中变得非常有能力,并且预计将以稳定的速度发布。在实践中,人们现在可能希望在应用于新领域或目的时,以最小的努力自信地选择性能最佳的摘要模型。在这项工作中,我们根据经验研究了在新闻摘要背景下选择首选模型所需的测试样本量。实证结果表明,自动评估和人工评估的比较评估很快就会收敛,并且对 100 个以下示例中出现的系统有明显的偏好。人类偏好数据使我们能够量化自动评分在各种下游汇总任务中重现偏好排名的效果。 |

| Fine-Tuned Machine Translation Metrics Struggle in Unseen Domains Authors Vil m Zouhar, Shuoyang Ding, Anna Currey, Tatyana Badeka, Jenyuan Wang, Brian Thompson 我们引入了一个新的、广泛的多维质量度量 MQM 带注释的数据集,涵盖生物医学领域的 11 个语言对。我们使用该数据集来研究根据人类生成的 MT 质量判断进行微调的机器翻译 MT 指标对于训练和推理之间的领域转换是否具有鲁棒性。 |

| Learning to Compress Prompt in Natural Language Formats Authors Yu Neng Chuang, Tianwei Xing, Chia Yuan Chang, Zirui Liu, Xun Chen, Xia Hu 大型语言模型法学硕士擅长处理多种自然语言处理任务,但其能力受到长上下文、推理速度慢和计算结果成本高等性能较差的限制。部署具有精确且信息丰富的上下文的法学硕士可以帮助用户更有效、更经济地处理大规模数据集。现有的工作依赖于将长提示上下文压缩为软提示。然而,软提示压缩在不同 LLM 之间的可转移性方面遇到了限制,尤其是基于 API 的 LLM。为此,这项工作旨在以具有LLM可转移性的自然语言形式压缩冗长的提示。这带来了两个挑战:i 自然语言 NL 提示与反向传播不兼容;ii NL 提示在施加长度约束方面缺乏灵活性。在这项工作中,我们提出了一种自然语言提示封装 Nano Capsulator 框架,将原始提示压缩为 NL 格式的 Capsule Prompt,同时保持提示的实用性和可转移性。具体来说,为了解决第一个挑战,纳米胶囊通过奖励函数进行优化,该函数与所提出的保留损失的语义相互作用。为了解决第二个问题,纳米胶囊通过具有长度限制的奖励函数进行了优化。 |

| RORA: Robust Free-Text Rationale Evaluation Authors Zhengping Jiang, Yining Lu, Hanjie Chen, Daniel Khashabi, Benjamin Van Durme, Anqi Liu 自由文本原理在可解释的 NLP 中发挥着关键作用,弥合了模型决策背后的知识和推理差距。然而,由于潜在推理路径的多样性以及相应缺乏明确的基本事实,它们的评估仍然是一个挑战。现有的评估指标依赖于基本原理支持目标标签的程度,但我们发现这些指标在评估无意中泄漏标签的基本原理方面存在不足。为了解决这个问题,我们提出了 RORA,一种针对标签泄漏的鲁棒自由文本基本原理评估。 RORA 量化了理由所提供的新信息,以证明标签的合理性。这是通过使用一个预测族来评估条件 V 信息 citep hewitt etal 2021 来实现的,该预测族对可被小模型利用的泄漏特征具有鲁棒性。 RORA 在评估人类书面、合成或模型生成的基本原理方面始终优于现有方法,特别是证明了针对标签泄漏的稳健性。 |

| Simple linear attention language models balance the recall-throughput tradeoff Authors Simran Arora, Sabri Eyuboglu, Michael Zhang, Aman Timalsina, Silas Alberti, Dylan Zinsley, James Zou, Atri Rudra, Christopher R 最近的研究表明,基于注意力的语言模型在召回方面表现出色,能够根据之前在上下文中看到的标记来生成代词。然而,基于注意力的模型的效率在推理过程中因 KV 缓存的大量内存消耗而受到瓶颈。在这项工作中,我们探索是否可以提高语言模型的效率,例如在不影响回忆的情况下减少内存消耗。通过将实验和理论应用于广泛的架构,我们确定了模型状态大小和召回能力之间的关键权衡。我们展示了注意力的有效替代方案,例如H3、Mamba、RWKV 保持固定大小的循环状态,但在召回方面遇到困难。我们提出了一种结合线性和滑动窗口注意力的简单架构。通过改变 BASED 窗口大小和线性注意力特征维度,我们可以调整状态大小并遍历回忆记忆权衡曲线的帕累托前沿,一方面恢复注意力的全部质量,另一方面恢复注意力替代品的小状态大小。我们训练语言模型高达 1.3b 参数,并表明 BASED 匹配最强的次二次模型,例如Mamba 处于困惑状态,在现实世界的回忆密集型任务中,其准确率比他们高出 6.22 个百分点。线性注意力的实现通常比优化的标准注意力实现效率低。为了使 BASED 具有竞争力,我们开发了 IO 感知算法,当使用 1.3b 参数模型生成 1024 个令牌时,该算法的语言生成吞吐量比 FlashAttention 2 高 24 倍。 |

| FOFO: A Benchmark to Evaluate LLMs' Format-Following Capability Authors Congying Xia, Chen Xing, Jiangshu Du, Xinyi Yang, Yihao Feng, Ran Xu, Wenpeng Yin, Caiming Xiong 本文介绍了 FoFo,这是一个开创性的基准,用于评估大型语言模型法学硕士遵循复杂的、特定领域格式的能力,这是他们作为人工智能代理应用的一项至关重要但尚未得到充分检验的能力。尽管法学硕士取得了进步,但现有的基准未能充分评估其熟练程度的格式。 FoFo 通过人工智能人类协作方法开发的各种现实世界格式和指令填补了这一空白。我们对开源(例如 Llama 2、WizardLM)和闭源(例如 GPT 4、PALM2、Gemini LLM)的评估强调了三个关键发现:开源模型在格式遵守方面明显落后于闭源模型 LLM 格式以下性能与其内容生成无关不同领域的质量和法学硕士格式熟练程度各不相同。这些见解表明需要对格式跟踪技能进行专门调整,并强调 FoFo 在指导选择特定领域 AI 代理方面的作用。 |

| Large Language Models and Games: A Survey and Roadmap Authors Roberto Gallotta, Graham Todd, Marvin Zammit, Sam Earle, Antonios Liapis, Julian Togelius, Georgios N. Yannakakis 近年来,大型语言模型法学硕士的研究呈爆炸式增长,公众对该主题的参与也随之增加。虽然法学硕士最初是自然语言处理中的一个利基领域,但它在包括游戏在内的广泛应用和领域中表现出了巨大的潜力。本文调查了法学硕士在游戏中的各种应用的最新技术水平,并确定了法学硕士在游戏中可以扮演的不同角色。重要的是,我们讨论了未充分探索的领域和未来在游戏中使用法学硕士的有希望的方向,并协调了法学硕士在游戏领域的潜力和局限性。 |

| Curiosity-driven Red-teaming for Large Language Models Authors Zhang Wei Hong, Idan Shenfeld, Tsun Hsuan Wang, Yung Sung Chuang, Aldo Pareja, James Glass, Akash Srivastava, Pulkit Agrawal 大型语言模型法学硕士在许多自然语言应用中具有巨大潜力,但存在生成不正确或有毒内容的风险。为了探究法学硕士何时生成不需要的内容,当前的范例是招募一个由人类测试人员组成的 textit red 团队来设计输入提示,即引发法学硕士不良反应的测试用例。然而,仅依靠人类测试人员既昂贵又耗时。最近的工作通过使用强化学习 RL 训练一个单独的红队法学硕士来生成测试用例,从而最大限度地提高从目标法学硕士引出不良反应的机会,从而实现红队自动化。然而,当前的强化学习方法只能生成少量有效的测试用例,导致提示的覆盖范围较低,从而引起目标法学硕士的不良反应。为了克服这一限制,我们将增加生成的测试用例的覆盖范围的问题与经过充分研究的好奇心驱动的探索方法(优化新颖性)联系起来。与现有方法相比,我们的好奇心驱动的红队 CRT 方法实现了更大的测试用例覆盖范围,同时保持或提高了其有效性。我们的方法 CRT 成功地激发了 LLaMA2 模型的毒性反应,该模型已根据人类偏好进行了大幅微调,以避免有毒输出。 |

| Accelerating materials discovery for polymer solar cells: Data-driven insights enabled by natural language processing Authors Pranav Shetty, Aishat Adeboye, Sonakshi Gupta, Chao Zhang, Rampi Ramprasad 我们提出了一种自然语言处理管道,用于从文献中提取聚合物太阳能电池属性数据并模拟各种主动学习策略。虽然数据驱动的方法已经成熟,可以比爱迪生的试错法更快地发现新材料,但它们的好处尚未被量化。我们的方法表明发现时间可能减少约 75 %,相当于材料创新加速 15 年。我们的管道使我们能够从 3300 多篇论文中提取数据,比其他人报告的类似数据集大 5 倍。我们还训练机器学习模型来预测功率转换效率,并使用我们的模型来识别尚未报告的有前途的供体受体组合。因此,我们演示了一个从发表的文献到提取的材料属性数据的工作流程,该数据又用于获取数据驱动的见解。我们的见解包括主动学习策略,可以同时优化材料系统并训练强大的材料特性预测模型。 |

| Functional Benchmarks for Robust Evaluation of Reasoning Performance, and the Reasoning Gap Authors Saurabh Srivastava, Annarose M B, Anto P V, Shashank Menon, Ajay Sukumar, Adwaith Samod T, Alan Philipose, Stevin Prince, Sooraj Thomas 我们提出了一个使用基准的功能变体对语言模型的推理能力进行稳健评估的框架。与功能变体的快照相比,解决推理测试的模型在问题的静态版本上应该没有表现出性能差异。我们已将 MATH 基准的相关片段重写为其功能变体 MATH ,并随后对其他基准进行功能化。当通过 MATH 快照评估当前最先进的模型时,我们发现静态精度和功能精度之间的百分比差异存在推理差距。我们发现在静态基准上表现良好的最先进的封闭式和开放式权重模型之间的推理差距从 58.35 到 80.31,但需要注意的是,通过更复杂的提示策略,差距可能会更小。在这里,我们展示了那些据称在现实世界任务中具有良好推理性能的模型,具有可量化的较低差距,从而激发了构建差距 0 模型的开放问题。 |

| Heavy-Tailed Class Imbalance and Why Adam Outperforms Gradient Descent on Language Models Authors Frederik Kunstner, Robin Yadav, Alan Milligan, Mark Schmidt, Alberto Bietti Adam 已被证明在优化大型语言转换器方面优于梯度下降,并且比其他任务的优势更大,但尚不清楚为什么会发生这种情况。我们表明,语言建模任务中发现的重尾类不平衡会导致动态优化方面的困难。当使用梯度下降进行训练时,与不频繁单词相关的损失比与频繁单词相关的损失下降得慢。由于大多数样本来自相对不频繁的单词,平均损失随着梯度下降缓慢下降。另一方面,Adam 和基于符号的方法不会遇到这个问题,并且改进了所有类别的预测。为了确定这种行为确实是由类别不平衡引起的,我们凭经验证明它在语言转换器、视觉 CNN 和线性模型上的不同架构和数据类型中持续存在。 |

| ArCHer: Training Language Model Agents via Hierarchical Multi-Turn RL Authors Yifei Zhou, Andrea Zanette, Jiayi Pan, Sergey Levine, Aviral Kumar 大型语言模型法学硕士的广泛用例是目标导向的决策任务或代理任务,其中法学硕士不仅需要为给定的提示生成完成,还需要通过多轮交互做出智能决策来完成任务,例如,与网络交互、使用工具或提供客户支持时。强化学习 RL 提供了解决此类代理任务的通用范例,但目前用于 LLM 的 RL 方法主要侧重于优化单轮奖励。通过构建,大多数单轮强化学习方法无法赋予法学硕士在多轮中智能地寻找信息、执行信用分配或推理其过去行为的能力,所有这些在代理任务中都至关重要。这就提出了一个问题:我们如何为法学硕士设计有效且高效的多轮强化学习算法。在本文中,我们开发了一个框架,用于构建用于微调法学硕士的多轮强化学习算法,该框架保留了法学硕士现有单轮强化学习方法的灵活性,例如,近端策略优化,同时有效地适应多回合、长视野和延迟奖励。为此,我们的框架采用分层强化学习方法,并并行运行两个强化学习算法,一个是基于高级策略值的强化学习算法,用于汇总话语奖励,另一个是低级强化学习算法,利用此高级价值函数来训练令牌每个话语或回合中的政策。我们的分层框架,具有分层结构 ArCHer 的 Actor Critic Framework,也可以产生其他 RL 方法。 |

| Compositional API Recommendation for Library-Oriented Code Generation Authors Zexiong Ma, Shengnan An, Bing Xie, Zeqi Lin 大型语言模型法学硕士在代码生成方面取得了卓越的性能。然而,在生成面向库的代码时,性能仍然不能令人满意,特别是对于法学硕士训练数据中不存在的库。之前的工作利用 API 推荐技术来帮助 LLM 使用库,它检索与用户需求相关的 API,然后利用它们作为上下文来提示 LLM。然而,开发需求可能是粗粒度的,需要组合多个细粒度的 API。这种粒度的不一致使得 API 推荐成为一项具有挑战性的任务。为了解决这个问题,我们提出了 CAPIR 组合式 API 推荐,它采用分而治之的策略来推荐满足粗粒度需求的 API。具体来说,CAPIR 采用基于 LLM 的分解器将粗粒度的任务描述分解为多个详细的子任务。然后,CAPIR 应用基于嵌入的检索器来识别与每个子任务对应的相关 API。此外,CAPIR 利用基于 LLM 的 Reranker 过滤掉冗余 API 并提供最终建议。为了便于根据粗粒度需求评估 API 推荐方法,我们提出了两个具有挑战性的基准:基于文档的 RAPID 推荐 API 和面向 LOCG 库的代码生成。这些基准的实验结果证明了 CAPIR 与现有基准相比的有效性。具体来说,在 RAPID 的 Torchdata AR 数据集上,与最先进的 API 推荐方法相比,CAPIR 将召回率 5 从 18.7 提高到 43.2,精度 5 从 15.5 提高到 37.1。 |

| Griffin: Mixing Gated Linear Recurrences with Local Attention for Efficient Language Models Authors Soham De, Samuel L. Smith, Anushan Fernando, Aleksandar Botev, George Cristian Muraru, Albert Gu, Ruba Haroun, Leonard Berrada, Yutian Chen, Srivatsan Srinivasan, Guillaume Desjardins, Arnaud Doucet, David Budden, Yee Whye Teh, Razvan Pascanu, Nando De Freitas, Caglar Gulcehre 循环神经网络 RNN 在长序列上具有快速推理和高效扩展的能力,但它们难以训练且难以扩展。我们提出了 Hawk(一种具有门控线性递归的 RNN)和 Griffin(一种将门控线性递归与局部注意力混合的混合模型)。 Hawk 在下游任务上超过了 Mamba 报告的性能,而 Griffin 则与 Llama 2 的性能相当,尽管训练的 token 数量少了 6 倍多。我们还表明,格里芬可以推断出比训练期间看到的序列长得多的序列。我们的模型在训练期间与 Transformers 的硬件效率相匹配,并且在推理期间它们具有更低的延迟和显着更高的吞吐量。 |

| PaECTER: Patent-level Representation Learning using Citation-informed Transformers Authors Mainak Ghosh, Sebastian Erhardt, Michael E. Rose, Erik Buunk, Dietmar Harhoff PaECTER 是一个公开可用的开源文档级编码器,专门针对专利。我们通过审查员添加的引文信息对专利 BERT 进行微调,以生成专利文档的数字表示。 PaECTER 在相似性任务中的表现比专利领域当前最先进的模型更好。更具体地说,在我们的专利引用预测测试数据集上,我们的模型在两个不同的排名评估指标上优于第二个最佳的专利特定预训练语言模型 BERT for Patents。 PaECTER 预测,与 25 项不相关专利相比,至少一项最相似的专利的平均排名为 1.32。 PaECTER 根据专利文本生成的数字表示可用于下游任务,例如分类、跟踪知识流或语义相似性搜索。语义相似性检索对于发明人和专利审查员的现有技术检索尤其重要。 |

| Entity-Aware Multimodal Alignment Framework for News Image Captioning Authors Junzhe Zhang, Huixuan Zhang, Xiaojun Wan 新闻图像字幕任务是图像字幕任务的一种变体,它需要模型用新闻图像和相关新闻文章生成信息更丰富的字幕。多模态大语言模型近年来发展迅速,在新闻图像字幕任务中具有广阔的前景。然而,根据我们的实验,常见的 MLLM 不擅长在零样本设置下生成实体。在对新闻图像字幕数据集进行简单调整后,他们处理实体信息的能力仍然有限。为了获得更强大的模型来处理多模态实体信息,我们设计了两个多模态实体感知对齐任务和一个对齐框架来对齐模型并生成新闻图像标题。 |

| Wisdom of the Silicon Crowd: LLM Ensemble Prediction Capabilities Match Human Crowd Accuracy Authors Philipp Schoenegger, Indre Tuminauskaite, Peter S. Park, Philip E. Tetlock 人类在实践中的预测准确性依赖于人群效应的智慧,通过聚集一群个体预测者,可以显着改善对未来事件的预测。过去对大型语言模型法学硕士的预测能力的研究表明,前沿法学硕士作为个人预测者,与人类预测锦标赛汇总的黄金标准相比表现不佳。在研究 1 中,我们通过使用由 12 名法学硕士组成的法学硕士整体方法来扩展这项研究。我们将法学硕士对 31 个二元问题的汇总预测与 925 名人类预测者在为期三个月的预测比赛中的预测进行了比较。我们的主要分析表明,法学硕士人群的表现优于简单的无信息基准,并且在统计上与人类人群相当。我们还观察到默认效应,尽管正负分辨率几乎均匀分布,但平均模型预测明显高于 50 。此外,在研究 2 中,我们测试了 GPT 4 和 Claude 2 的 LLM 预测是否可以通过利用人类认知输出来改进。我们发现,这两种模型的预测准确性都受益于将人类预测中位数作为信息,将准确性提高了 17 到 28 倍,尽管这会导致预测不如简单平均人类和机器预测准确。我们的结果表明,法学硕士可以通过简单、实用的预测聚合方法实现与人类预测锦标赛相媲美的预测精度。 |

| PRSA: Prompt Reverse Stealing Attacks against Large Language Models Authors Yong Yang, Xuhong Zhang, Yi Jiang, Xi Chen, Haoyu Wang, Shouling Ji, Zonghui Wang Prompt 被认为是重要的知识产权,它使大型语言模型法学硕士能够执行特定任务,而无需进行微调,这突显了其重要性的不断提升。随着基于提示的服务(例如提示市场和法学硕士申请)的兴起,提供商通常通过输入输出示例来展示提示功能以吸引用户。然而,这种范式引发了一个关键的安全问题:输入输出对的暴露是否会带来潜在的即时泄漏风险,侵犯开发者的知识产权?据我们所知,这个问题尚未得到全面探讨。为了弥补这一差距,在本文中,我们进行了首次深入探索,并提出了一种针对商业 LLM 的反向窃取提示的新型攻击框架,即 PRSA。 PRSA的主要思想是,通过分析输入输出对的关键特征,我们模仿并逐步推断窃取目标提示。具体来说,PRSA主要由提示变异和提示剪枝两个关键阶段组成。在变异阶段,我们提出了一种基于差分反馈的提示注意算法来捕获这些关键特征,从而有效地推断目标提示。在提示修剪阶段,我们识别并屏蔽依赖于特定输入的单词,使提示能够适应不同的输入以进行泛化。通过广泛的评估,我们验证了 PRSA 在现实场景中构成严重威胁。 |

| VIXEN: Visual Text Comparison Network for Image Difference Captioning Authors Alexander Black, Jing Shi, Yifei Fai, Tu Bui, John Collomosse 我们提出了 VIXEN 一种技术,该技术可以在文本中简洁地总结一对图像之间的视觉差异,以突出显示任何存在的内容操纵。我们提出的网络以成对的方式线性映射图像特征,为预训练的大型语言模型构建软提示。我们通过对最近的 InstructPix2Pix 数据集中通过提示编辑框架生成的综合操作图像进行训练,解决了现有图像差异字幕 IDC 数据集中训练数据量低和缺乏操作多样性的挑战。我们通过 GPT 3 生成的变更摘要来扩充该数据集。我们表明,VIXEN 可以为不同的图像内容和编辑类型生成最先进、易于理解的差异字幕,从而可以潜在地缓解通过操纵图像内容传播的错误信息。 |

| Controllable Preference Optimization: Toward Controllable Multi-Objective Alignment Authors Yiju Guo, Ganqu Cui, Lifan Yuan, Ning Ding, Jiexin Wang, Huimin Chen, Bowen Sun, Ruobing Xie, Jie Zhou, Yankai Lin, Zhiyuan Liu, Maosong Sun 人工智能的一致性追求模型响应与人类偏好和价值观之间的一致性。在实践中,人类偏好的多方面性质无意中引入了所谓的一致性税,这是一种妥协,即在一个目标(例如无害性)内增强一致性可能会降低其他目标(例如乐于助人)的表现。然而,现有的对齐技术大多是单向的,导致对各种目标的权衡不理想且灵活性差。为了应对这一挑战,我们认为法学硕士具有明显偏好的重要性。我们引入可控偏好优化 CPO ,它明确指定不同目标的偏好分数,从而指导模型生成满足要求的响应。我们的实验分析表明,对齐的模型可以提供与 3H 乐于助人、诚实、无害等需求中的各种偏好相匹配的响应。 |

| Syntactic Ghost: An Imperceptible General-purpose Backdoor Attacks on Pre-trained Language Models Authors Pengzhou Cheng, Wei Du, Zongru Wu, Fengwei Zhang, Libo Chen, Gongshen Liu 人们发现,预先训练的语言模型 PLM 容易受到后门攻击,这种攻击可以将漏洞转移到各种下游任务。然而,现有的PLM后门都是在手动对齐的情况下通过显式触发进行的,在有效性、隐蔽性和通用性方面未能同时满足预期目标。在本文中,我们提出了一种实现隐形和通用后门植入的新方法,简称为textbf Syntropic Ghost synGhost。具体来说,该方法恶意地操纵具有不同预定义句法结构的中毒样本作为隐形触发器,然后将后门植入到预先训练的表示空间中,而不干扰原始知识。通过对比学习,中毒样本的输出表示尽可能均匀地分布在特征空间中,形成广泛的后门。此外,根据句法触发器的独特属性,我们引入了一个辅助模块来驱动PLM优先学习这些知识,这可以减轻不同句法结构之间的干扰。实验表明,我们的方法优于以前的方法并达到了预定的目标。不仅对两种调优范式上的各种自然语言理解 NLU 任务造成严重威胁,而且对多个 PLM 也造成严重威胁。 |

| Analyzing and Reducing Catastrophic Forgetting in Parameter Efficient Tuning Authors Weijieying Ren, Xinlong Li, Lei Wang, Tianxiang Zhao, Wei Qin 现有研究表明,大型语言模型法学硕士在语言理解和生成方面表现出卓越的性能。然而,当 LLM 对复杂且多样化的特定领域下游任务进行持续微调时,历史任务的推理性能会急剧下降,这被称为灾难性遗忘问题。需要在学习可塑性和记忆稳定性之间进行权衡。大量现有工作已经探索了诸如记忆重播、正则化和参数隔离等策略,但对于连续 LLM 微调场景中各种相邻最小值的几何连接知之甚少。在这项工作中,我们通过模式连接的镜头研究不同最小值的几何连接,这意味着不同的最小值可以通过低损耗谷连接。通过大量的实验,我们揭示了法学硕士持续学习场景中的模式连接现象,并发现它可以在可塑性和稳定性之间取得平衡。基于这些发现,我们提出了一种简单而有效的方法,称为基于 LoRA I LoRA 的插值,它构建了一个基于 LoRA 参数插值的双记忆体验重放框架。对八个特定领域的 CL 基准进行的广泛实验和分析表明,与之前最先进的方法相比,I LoRA 始终表现出显着改进,性能提升高达 11 倍,为未来大型语言模型持续学习问题的研究提供了强有力的基线和见解。 |

| Enhancing Steganographic Text Extraction: Evaluating the Impact of NLP Models on Accuracy and Semantic Coherence Authors Mingyang Li, Maoqin Yuan, Luyao Li, Han Pengsihua 本研究探讨了一种将图像隐写技术与自然语言处理NLP大型模型相结合的新方法,旨在提高隐写文本提取的准确性和鲁棒性。传统的最低有效位LSB隐写技术在处理复杂的字符编码(例如汉字)时面临着信息提取的准确性和鲁棒性的挑战。为了解决这个问题,本研究提出了一种创新的 LSB NLP 混合框架。该框架集成了NLP大型模型的先进能力,如错误检测、纠正和语义一致性分析以及信息重构技术,从而显着增强了隐写文本提取的鲁棒性。实验结果表明,LSB NLP 混合框架在提高隐写文本的提取精度方面表现出色,尤其是在处理汉字方面。该研究结果不仅证实了图像隐写技术与NLP大模型相结合的有效性,而且为信息隐藏领域的研究和应用提出了新的思路。 |

| ARTiST: Automated Text Simplification for Task Guidance in Augmented Reality Authors Guande Wu, Jing Qian, Sonia Castelo, Shaoyu Chen, Joao Rulff, Claudio Silva 增强现实中呈现的文本为用户提供现场实时信息。然而,在参与认知要求较高的 AR 任务时,尤其是在头戴式显示器上呈现时,快速理解这些内容可能会很困难。我们提出了 ARTiST,一种自动文本简化系统,它使用一些镜头提示和 GPT 3 模型来专门优化增强现实的文本长度和语义内容。我们的系统是在一项包括七名用户和三名专家的形成性研究的基础上开发出来的,它结合了定制的误差校准模型和一些镜头提示,以集成句法、词汇、精细和内容简化技术,并为头戴式显示器生成简化的 AR 文本。一项 16 位用户的实证研究结果表明,与未修改的文本和通过传统方法修改的文本相比,ARTiST 减轻了认知负担并显着提高了性能。 |

| MPAT: Building Robust Deep Neural Networks against Textual Adversarial Attacks Authors Fangyuan Zhang, Huichi Zhou, Shuangjiao Li, Hongtao Wang 深度神经网络已被证明容易受到对抗性示例的影响,并且已经提出了各种方法来防御自然语言处理任务的对抗性攻击。然而,以往的防御方法在保证原任务执行的同时保持有效防御存在局限性。在本文中,我们提出了一种基于恶意扰动的对抗训练方法 MPAT,用于构建针对文本对抗攻击的鲁棒深度神经网络。具体来说,我们构建了一个多级恶意示例生成策略来生成具有恶意扰动的对抗性示例,这些示例用于代替原始输入进行模型训练。此外,我们采用了一种新颖的训练目标函数来确保在不影响原始任务性能的情况下实现防御目标。我们通过攻击三个基准数据集上的五个受害者模型来进行全面的实验来评估我们的防御方法。 |

| FlexLLM: A System for Co-Serving Large Language Model Inference and Parameter-Efficient Finetuning Authors Xupeng Miao, Gabriele Oliaro, Xinhao Cheng, Mengdi Wu, Colin Unger, Zhihao Jia 参数高效微调 PEFT 是一种广泛使用的技术,可以使大型语言模型适应不同的任务。服务提供商通常会为用户创建单独的系统来执行 PEFT 模型微调和推理任务。这是因为现有系统无法处理包含推理和 PEFT 微调请求混合的工作负载。因此,共享 GPU 资源未得到充分利用,导致效率低下。为了解决这个问题,我们提出了 FlexLLM,这是第一个可以在同一迭代中提供推理和参数高效微调请求的系统。我们的系统利用这两个任务的互补性,并利用共享 GPU 资源来联合运行它们,使用一种称为协同服务的方法。为了实现这一目标,FlexLLM 引入了一种新颖的令牌级微调机制,它将序列的微调计算分解为更小的令牌级计算,并使用依赖并行化和图形修剪(两种静态编译优化)来最大限度地减少协同服务的内存开销和延迟。与现有系统相比,FlexLLM 的协同服务方法将激活 GPU 内存开销降低了多达 8 倍,将微调的端到端 GPU 内存需求降低了多达 36 倍,同时保持了较低的推理延迟并提高了微调吞吐量。例如,在繁重的推理工作负载下,FlexLLM 仍然可以保留超过 80% 的峰值微调吞吐量,而现有系统无法在微调方面取得任何进展。 |

| Priority Sampling of Large Language Models for Compilers Authors Dejan Grubisic, Chris Cummins, Volker Seeker, Hugh Leather 大型语言模型在生成和优化代码方面显示出巨大的潜力。广泛使用的采样方法(例如核采样)增加了生成的多样性,但通常会产生低温重复样本和高温不相干样本。此外,必须针对每个任务调整温度系数,限制了其可用性。我们提出了优先采样,这是一种简单且确定性的采样技术,可生成按模型置信度排序的独特样本。每个新样本都会扩展增强搜索树中概率最高的未扩展标记。此外,优先采样支持基于正则表达式的生成,提供可控且结构化的探索过程。对于任意数量的样本,优先采样的性能均优于核采样,将原始模型的性能从 Oz 的 2.87 提高到 5。 |

| Grounding Language Models for Visual Entity Recognition Authors Zilin Xiao, Ming Gong, Paola Cascante Bonilla, Xingyao Zhang, Jie Wu, Vicente Ordonez 我们介绍 AutoVER,一种用于视觉实体识别的自回归模型。我们的模型通过采用检索增强约束生成来扩展自回归多模态大语言模型。它可以缓解域外实体的低性能,同时在需要视觉定位推理的查询中表现出色。我们的方法通过在没有外部检索器的情况下与序列到序列目标并行地对硬负对进行对比训练,学习区分巨大标签空间中的相似实体。在推理过程中,检索到的候选答案列表通过删除无效的解码路径来明确指导语言生成。所提出的方法在最近提出的 Oven Wiki 基准测试中跨不同数据集分割实现了显着改进。实体分裂的准确度从 32.7 上升到 61.5 。 |

| Verif.ai: Towards an Open-Source Scientific Generative Question-Answering System with Referenced and Verifiable Answers Authors Milo Ko prdi , Adela Ljaji , Bojana Ba aragin, Darija Medvecki, Nikola Milo evi |

| Chinese Abs From Machine Translation |

Papers from arxiv.org

更多精彩请移步主页

pic from pexels.com