什么是CPU

CPU(Central Processing Unit)是由数十亿个晶体管构成的,可以拥有多个处理核心,通常被称为计算机的“大脑”。它对所有现代计算系统至关重要,因为它执行计算机和操作系统所需的命令和进程。CPU在决定程序运行的速度上也很重要,从浏览网页到建立电子表格都离不开它。

什么是GPU

GPU(Graphics Processing Unit)是由许多更小、更专业的核心组成的处理器。这些核心通过协同工作,当处理任务可以同时(或并行)分配到许多核心时,它们能够提供巨大的性能。GPU是现代游戏的重要组成部分,能够提供更高质量的视觉效果和更流畅的游戏体验。GPU在人工智能中也非常有用。

CPU和GPU的区别

CPU和GPU有很多共同之处。它们都是关键的计算引擎,都是基于硅的微处理器,都处理数据。但是,CPU和GPU的架构不同,且各自的构建目的也不同。

CPU适用于各种任务,尤其是那些对延迟或每核性能有重要要求的任务,如网页浏览。作为一个强大的执行引擎,CPU将其较少的核心集中在单个任务上,以便快速完成任务。这使得它独特地适合从串行计算到运行数据库的各种工作。

GPU最初是专门设计用于特定目的的专用ASIC(Application-Specific Integrated Circuits),例如加速特定的3D渲染任务。随着时间的推移,这些固定功能的引擎变得更加可编程和灵活。虽然图形和超真实的游戏视觉仍然是它们的主要功能,但GPU也已经发展成为更通用的并行处理器,处理的应用范围也在不断扩大,包括AI。

什么是LPU

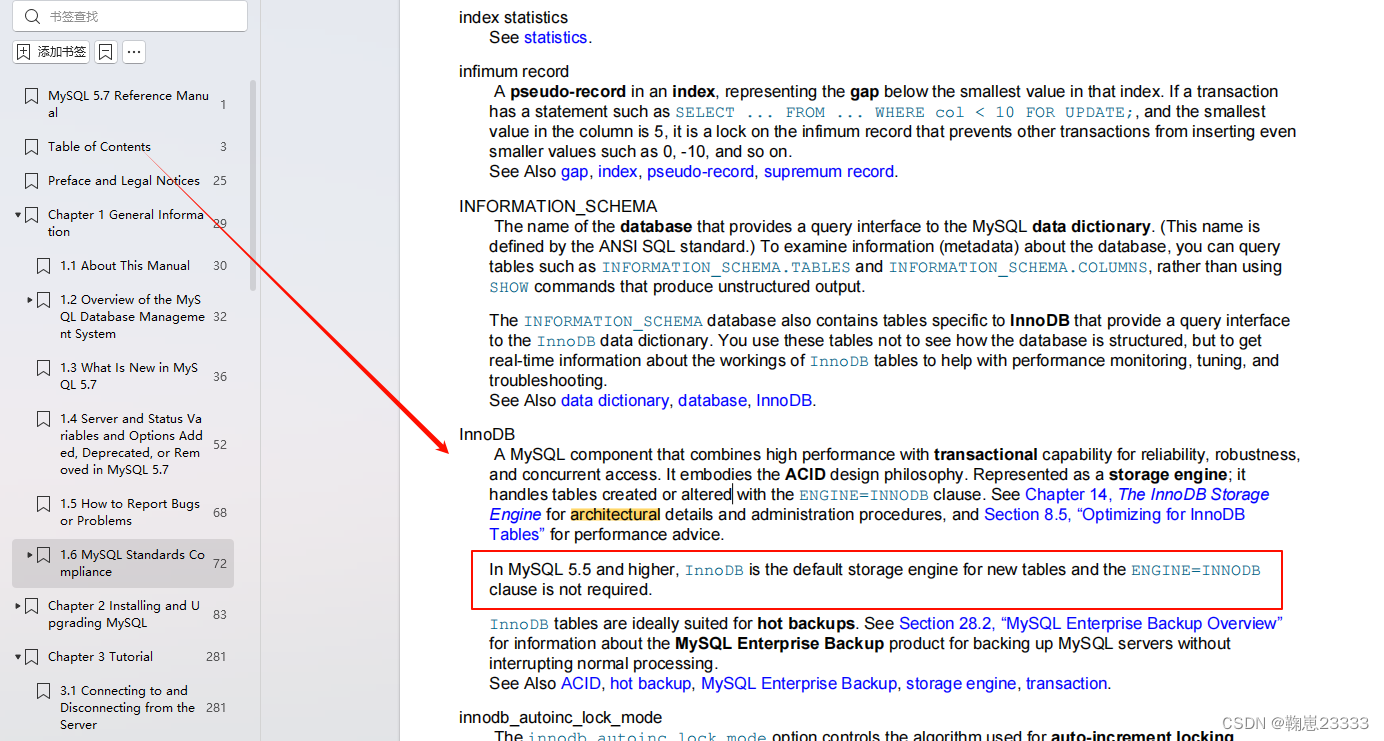

LPU(Language Processing Unit)是一种全新的端到端处理单元系统,专为处理具备序列组件的计算密集型应用,如大型语言模型(LLM)而设计。

在当前的生成型AI生态系统中,传统的图形处理器(GPU)已经无法满足日益增长的速度和需求。因此,Groq公司开发了LPU推理引擎,这是一个端到端的推理加速系统,旨在以简洁的设计提供卓越的性能、效率和精确度。

Groq是一家由Jonathan Ross在2016年创立的创新型技术公司。作为Google第一个张量处理单元(TPU)的设计者,Ross深知硬件与软件的紧密联系。他坚信,芯片设计的未来应该从软件定义网络(SDN)中汲取灵感,这也是他创建Groq的初衷。

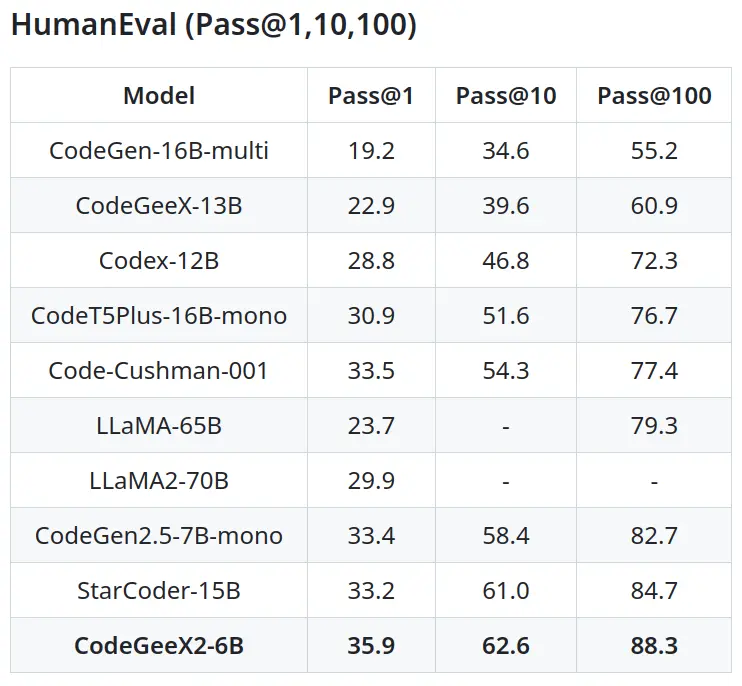

LPU和GPU性能对比

LPU推理引擎是世界上第一款专为推理性能和精度而设计的语言处理单元推理引擎。LPU位于数据中心,与能够进行训练的CPU和图形处理器并列,客户可以选择在本地部署或通过API访问。Groq公司的愿景是设定一个新的AI体验标准:在能源效率的包装中,以低延迟和实时交付带来惊艳的推理。

LPU推理引擎的设计目的是为了克服LLM(大型语言模型)的两大瓶颈——计算量和内存带宽。一个LPU系统的计算能力可以与图形处理器(GPU)相媲美或者更强,它减少了每个词的计算时间,从而使文本序列的生成速度更快。由于没有外部内存带宽的瓶颈,LPU推理引擎的性能比图形处理器要好几个数量级。

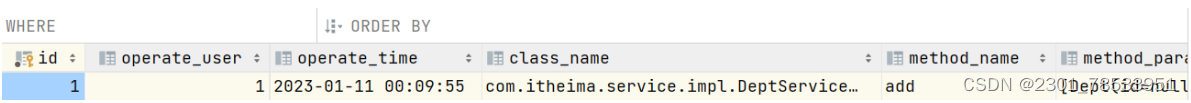

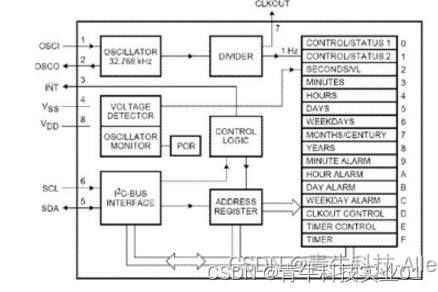

下图是Groq(Llama 2 70B)和 ChatGPT 面对同一个提示词的表现:

LPU推理引擎的性能表现出色,能够每秒超过300个token的Llama-2 70B,碾压GPT-4的每秒40个token。

LPU推理引擎的性能表现出色,能够每秒超过300个token的Llama-2 70B,碾压GPT-4的每秒40个token。

LPU推理引擎具有以下特性:

- 出色的顺序性能

- 单核架构

- 即使在大规模部署中也能保持同步网络

- 能够自动编译超过500亿的LLMs

- 瞬时内存访问

- 即使在较低精度级别也能保持高准确性

总的来说,LPU是Groq公司对未来AI推理的一种全新设想和实践,它的出现将为AI的发展带来新的可能性和机遇。