目录

- 前言

- 1 梯度下降的基本思想

- 2 梯度下降的公式

- 3 梯度下降的步骤

- 3.1 初始化参数

- 3.2 计算梯度

- 3.3 更新参数

- 3.4 迭代更新

- 4 学习率的控制

- 4.1 过大学习率的问题

- 4.2 过小学习率的问题

- 4.3 学习率的调整

- 5 批量梯度下降方法

- 5.1 批量梯度下降(Batch Gradient Descent)

- 5.1 小批量梯度下降(Mini-batch Gradient Descent)

- 结语

前言

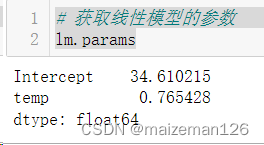

线性回归是机器学习中常用的模型之一,而梯度下降法则是优化线性回归模型参数的重要手段之一。本文将深入探讨梯度下降法在线性回归中的应用,包括其基本思想、相关公式、步骤、学习率的控制以及批量梯度下降方法。通过详细阐述这些内容,希望读者能够更好地理解和运用梯度下降法来优化线性回归模型。

1 梯度下降的基本思想

在机器学习中,梯度下降法是一种常用的优化算法,其核心思想是通过迭代的方式逐步调整模型参数,以降低目标函数(损失函数)的值。在线性回归中,我们的目标是找到最优的权重 w 和偏置 b,使得损失函数$J(w,b) $取得最小值。

线性回归的目标函数通常以平方损失为例,即

J

(

w

,

b

)

=

1

2

m

∑

i

=

1

m

(

y

i

−

(

w

x

i

+

b

)

)

2

J(w, b) = \frac{1}{2m} \sum_{i=1}^{m} (y_i - (wx_i + b))^2

J(w,b)=2m1i=1∑m(yi−(wxi+b))2

其中,m是样本数量,(

x

i

x_i

xi,

y

i

y_i

yi)是训练集中的样本。这个公式描述了平方损失的均方差,表示模型预测值与实际值之间的差异,梯度下降的目标是最小化这个损失函数。

通过梯度下降法,我们希望找到使得目标函数最小化的 w 和 b。梯度下降的基本思想是计算目标函数对于参数的梯度(偏导数),然后沿着梯度的反方向调整参数,以减小目标函数的值。

2 梯度下降的公式

梯度下降法的核心在于通过对目标函数进行偏导数的计算,求解梯度,然后根据梯度的反方向来更新模型参数。在线性回归中,我们的目标是最小化损失函数$J(w,b) $。

权重的更新

w : = w − α ∂ J ( w , b ) ∂ w w := w - \alpha \frac{\partial J(w, b)}{\partial w} w:=w−α∂w∂J(w,b)

w = w − α 1 m ∑ i = 1 m ( y i − ( w x i + b ) ) x i w = w - \alpha \frac{1}{m} \sum_{i=1}^{m} (y_i - (wx_i + b))x_i w=w−αm1i=1∑m(yi−(wxi+b))xi

偏置的更新

b : = b − α ∂ J ( w , b ) ∂ b b := b - \alpha \frac{\partial J(w, b)}{\partial b} b:=b−α∂b∂J(w,b)

b = b − α 1 m ∑ i = 1 m ( y i − ( w x i + b ) ) b = b - \alpha \frac{1}{m} \sum_{i=1}^{m} (y_i - (wx_i + b)) \ b=b−αm1i=1∑m(yi−(wxi+b))

其中, α \alpha α 是学习率,它是一个正数,用于控制每次迭代的步长。学习率的选择对梯度下降的性能影响很大,过大的学习率可能导致震荡,而过小的学习率可能导致收敛速度过慢。

在更新公式中, ∂ J ( w , b ) ∂ w \frac{\partial J(w, b)}{\partial w} ∂w∂J(w,b)表示损失函数关于权重 w的偏导数,而 $\frac{\partial J(w, b)}{\partial b} $表示关于偏置 b的偏导数。这两个偏导数告诉我们在当前参数下,目标函数的变化率,梯度下降通过不断减小这些变化率来逼近最小值。

3 梯度下降的步骤

梯度下降是一种迭代优化算法,用于最小化目标函数。在线性回归中,梯度下降的步骤可以简要概括如下。

3.1 初始化参数

在开始优化过程之前,需要初始化模型参数。通常可以将权重 w 和偏置 b 初始化为零或者随机的小值。这一步是为了给优化算法一个起始点。

3.2 计算梯度

计算目标函数$J(w,b) $关于参数 w 和 b 的偏导数,即梯度。梯度告诉我们目标函数在当前参数点上的变化率。对于线性回归,梯度的计算涉及对损失函数关于权重 w 和偏置 b 的偏导数。

3.3 更新参数

使用梯度和预先设定的学习率 α,通过梯度下降的更新规则来调整参数 w 和 b。更新规则如下:

w : = w − α ∂ J ( w , b ) ∂ w w := w - \alpha \frac{\partial J(w, b)}{\partial w} w:=w−α∂w∂J(w,b)

b : = b − α ∂ J ( w , b ) ∂ b b := b - \alpha \frac{\partial J(w, b)}{\partial b} b:=b−α∂b∂J(w,b)

这一步的目的是沿着梯度的反方向调整参数,以减小目标函数的值。

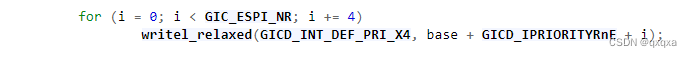

3.4 迭代更新

重复步骤 b 和 c,直至满足停止条件。停止条件可以是达到最大迭代次数或者梯度趋近于零。迭代的过程中,参数不断被调整,目标函数逐渐趋近最小值。

通过这些步骤,梯度下降能够有效地搜索参数空间,找到使得损失函数最小化的最优参数,从而优化线性回归模型。

4 学习率的控制

学习率是梯度下降中一个至关重要的参数,它决定了每次迭代中模型参数更新的步长。选择合适的学习率对于梯度下降的性能和收敛速度至关重要。

4.1 过大学习率的问题

如果学习率过大,可能导致梯度下降算法在参数空间中跳动或震荡,甚至无法收敛到最小值。这是因为过大的学习率使得每次迭代参数更新过大,导致优化过程失控。

4.2 过小学习率的问题

相反,如果学习率过小,模型参数更新的步长太小,梯度下降收敛速度会很慢,甚至可能陷入局部最小值而无法找到全局最小值。

4.3 学习率的调整

一种常用的学习率调整方法是进行实验,通过尝试不同的学习率来找到一个在特定问题上表现良好的值。另一种方法是使用自适应学习率的技术,如Adagrad、Adadelta、Adam等,它们可以根据梯度的历史信息来动态地调整学习率,以更灵活地适应优化过程。

在实践中,可以从一个较小的学习率开始,观察损失函数的下降情况。如果发现收敛速度过慢,可以逐渐增大学习率。然而,需要注意不要选择过大的学习率,以免影响优化的稳定性。

通过合理调整学习率,梯度下降算法能够更好地在参数空间中搜索,加速模型的收敛,并更有效地优化线性回归模型。

5 批量梯度下降方法

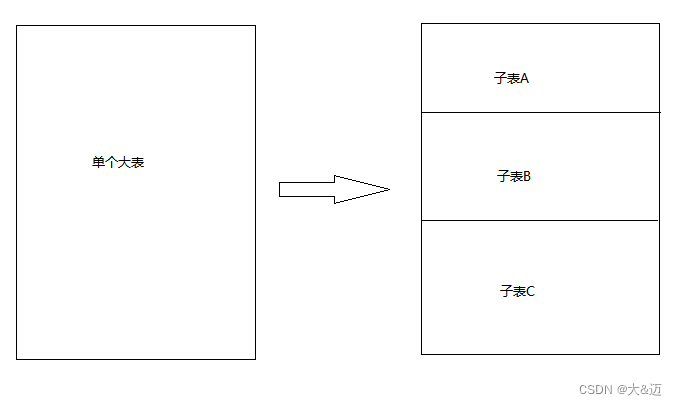

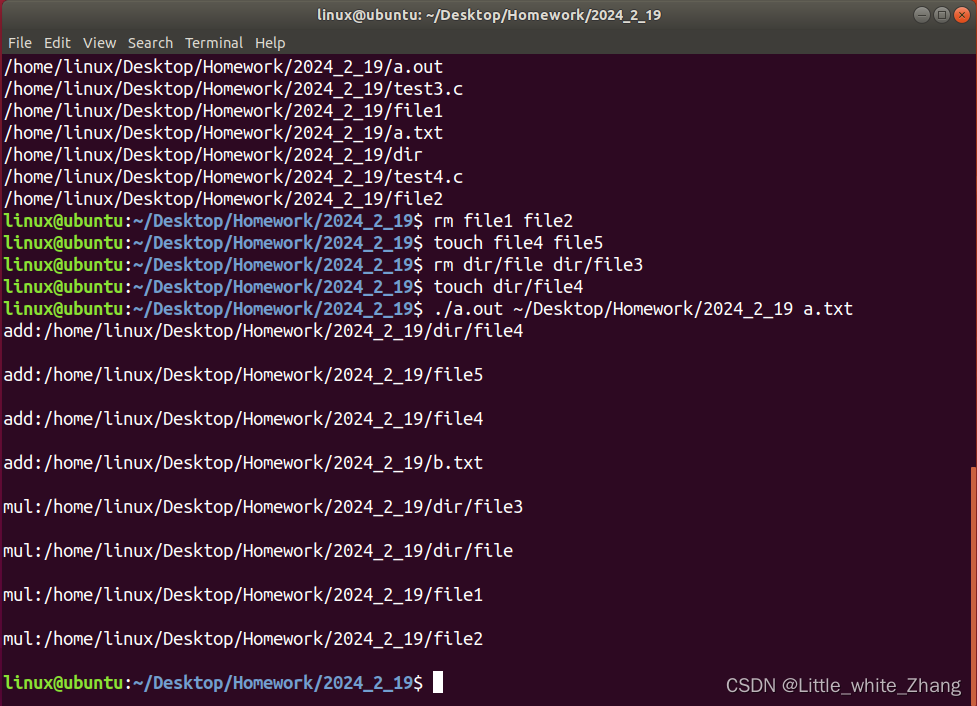

梯度下降的方法不仅仅限于单一形式,批量梯度下降是其中一种形式,它的特点是每次迭代都利用所有训练样本来计算梯度。这相对于随机梯度下降更为稳定,但在大数据集上计算梯度较为耗时。为了解决这一问题,引入了小批量梯度下降,作为一种折中的选择,它使用一小部分样本来估计梯度。

5.1 批量梯度下降(Batch Gradient Descent)

在批量梯度下降中,每次迭代都需要对整个训练集进行计算。其权重和偏置的更新公式如下:

w : = w − α 1 m ∑ i = 1 m ∂ J ( w , b ) ∂ w w := w - \alpha \frac{1}{m} \sum_{i=1}^{m} \frac{\partial J(w, b)}{\partial w} w:=w−αm1i=1∑m∂w∂J(w,b)

b : = b − α 1 m ∑ i = 1 m ∂ J ( w , b ) ∂ b b := b - \alpha \frac{1}{m} \sum_{i=1}^{m} \frac{\partial J(w, b)}{\partial b} b:=b−αm1i=1∑m∂b∂J(w,b)

其中,$ m$ 是训练样本的数量,$ \alpha$ 是学习率。

5.1 小批量梯度下降(Mini-batch Gradient Descent)

小批量梯度下降是一种折中方案,每次迭代时仅利用一小部分样本来估计梯度。这样可以在保持一定稳定性的同时,减少计算开销。更新公式如下:

w : = w − α 1 b a t c h _ s i z e ∑ i = 1 b a t c h _ s i z e ∂ J ( w , b ) ∂ w w := w - \alpha \frac{1}{batch\_size} \sum_{i=1}^{batch\_size} \frac{\partial J(w, b)}{\partial w} w:=w−αbatch_size1i=1∑batch_size∂w∂J(w,b)

b : = b − α 1 b a t c h _ s i z e ∑ i = 1 b a t c h _ s i z e ∂ J ( w , b ) ∂ b b := b - \alpha \frac{1}{batch\_size} \sum_{i=1}^{batch\_size} \frac{\partial J(w, b)}{\partial b} b:=b−αbatch_size1i=1∑batch_size∂b∂J(w,b)

其中,$ batch_size $ 是每次迭代使用的样本数量。

选择何种梯度下降方法取决于数据集的规模和计算资源的可用性。批量梯度下降适用于较小的数据集,而小批量梯度下降则可以在大规模数据集上更高效地进行计算。随机梯度下降则是一种更为轻量级的方法,适用于在线学习或数据流式处理。

通过灵活选择梯度下降的形式,我们能够更好地平衡计算效率和模型稳定性,从而优化线性回归模型。

结语

通过本文对梯度下降在线性回归中的深入探讨,我们理解了其基本思想、公式、步骤、学习率的控制以及批量梯度下降方法。在实际应用中,灵活运用梯度下降算法,调整参数和学习率,将有助于优化线性回归模型,提高其性能和泛化能力。