Ollama 可以在 Windows 上运行了

- 0. 引言

- 1. 下载 Ollma 安装文件

- 2. 安装 Ollama

- 3. 使用 Ollama

0. 引言

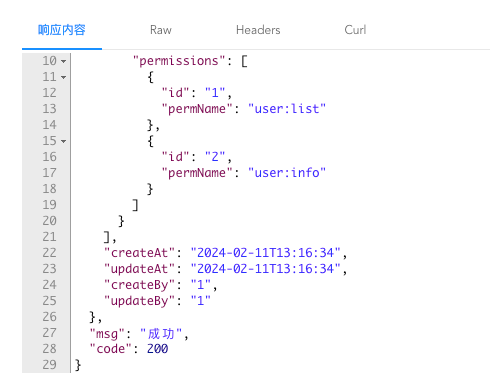

Ollama 终于可以在 Windows 上运行了,一直以来都是 “Coming soon”。

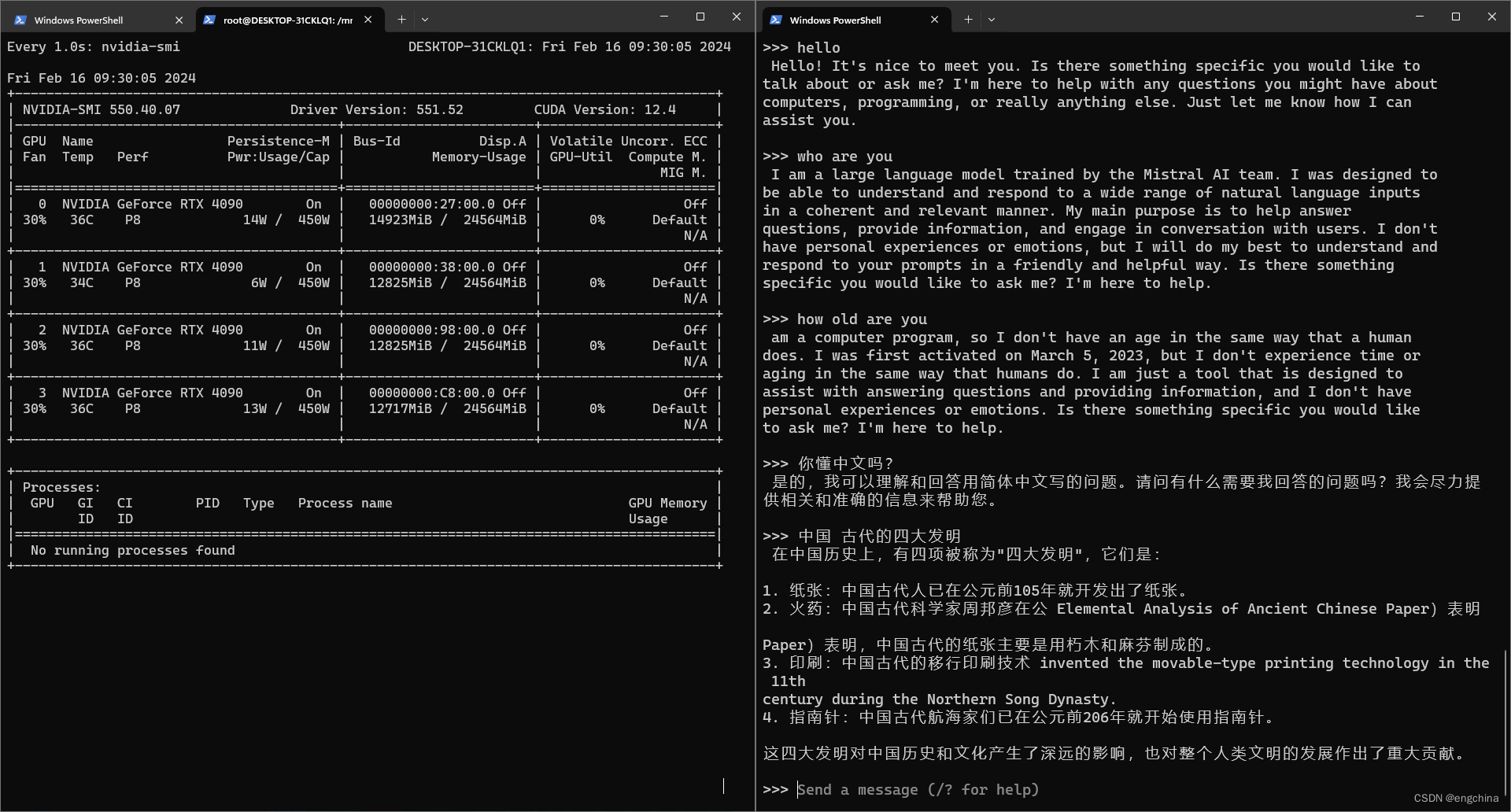

运行 Mixtral 8*7B 试了一下,推理速度和推理效果都很不错。

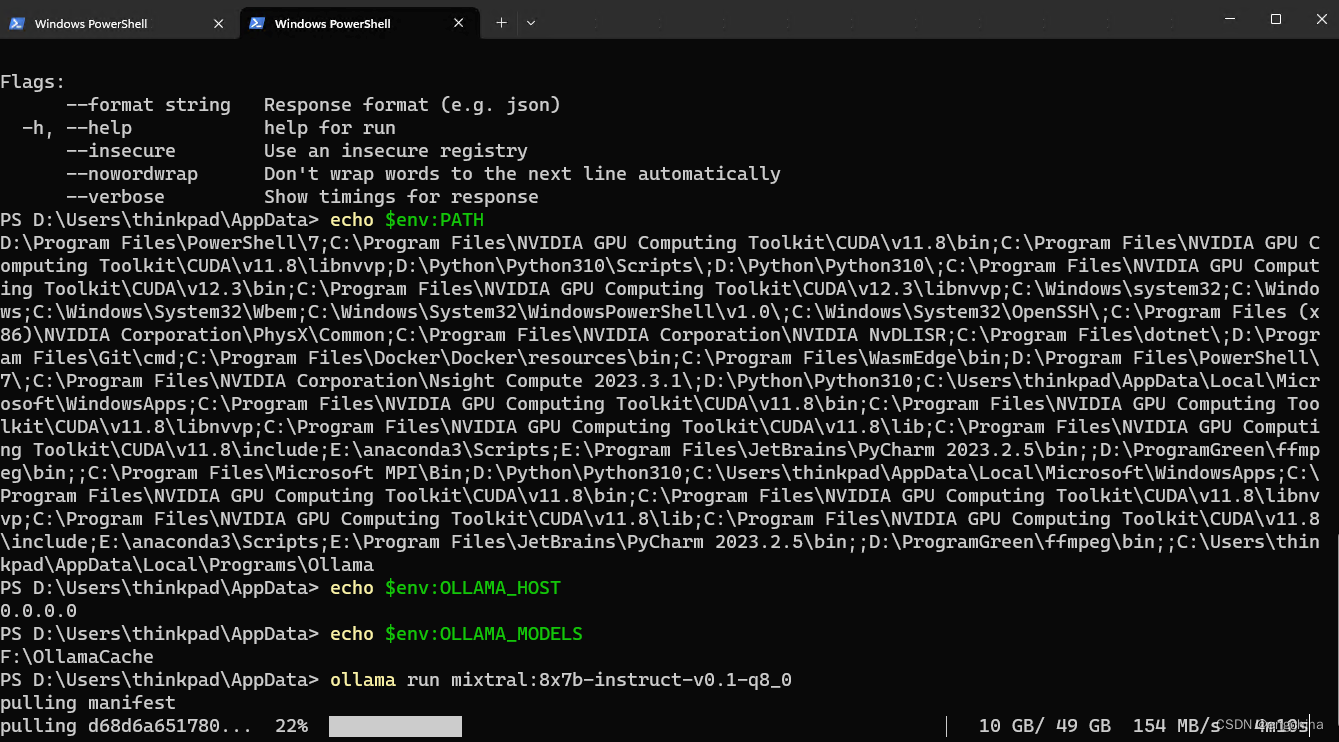

而且模型的下载速度也很快,我用的联通1000M网络,大概90M~150M/s波动。

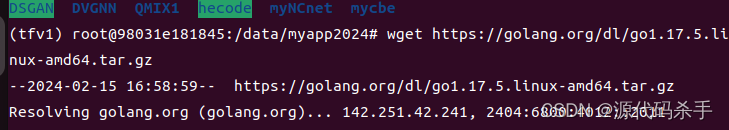

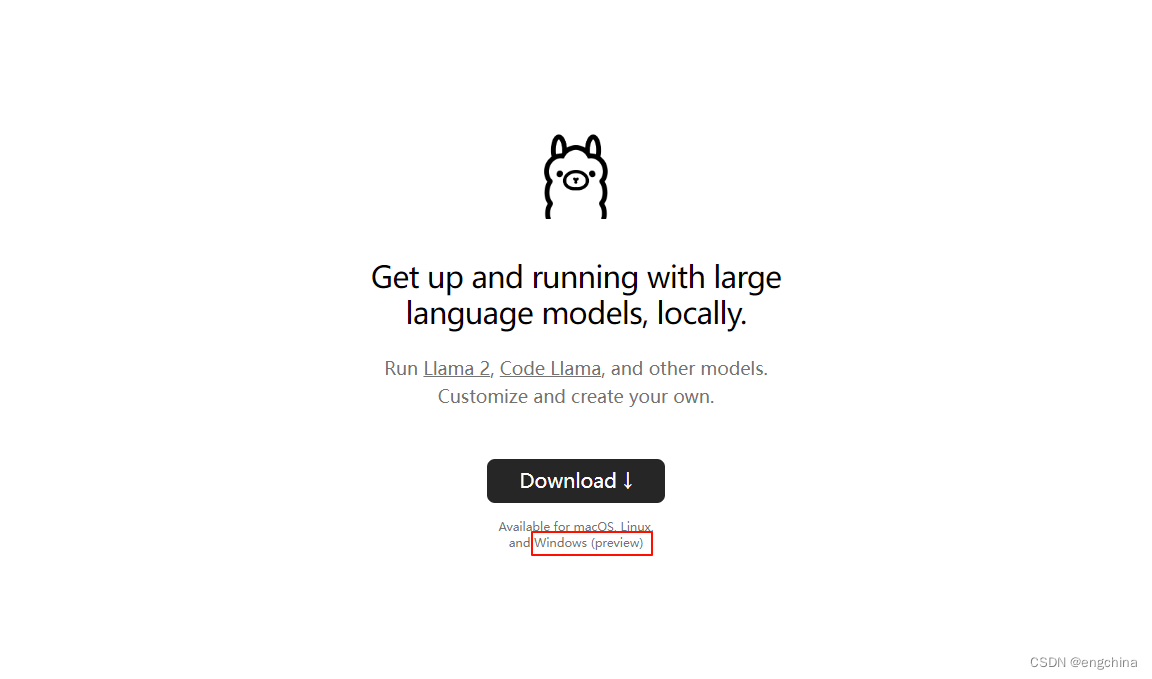

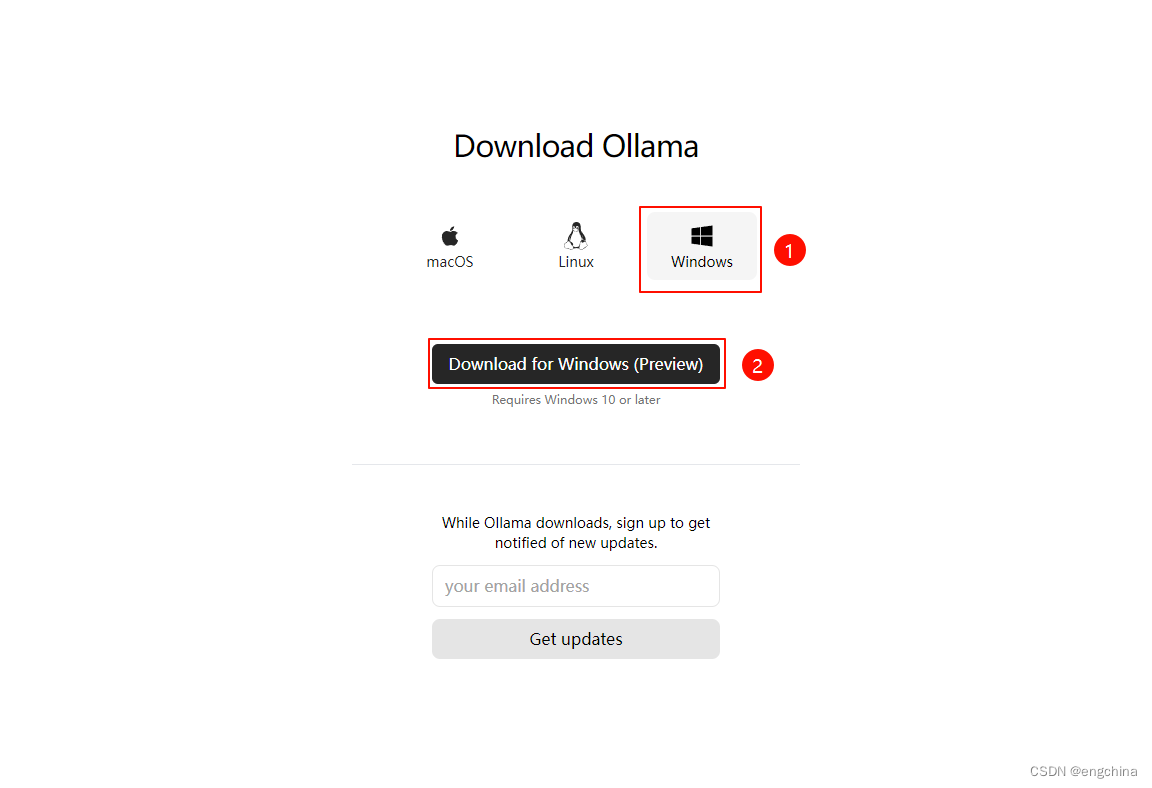

1. 下载 Ollma 安装文件

访问 https://ollama.com/download,选择 Windows,单击 “Download for Windows (Preview)” 进行下载。

2. 安装 Ollama

双击下载的 “OllamaSetup.exe”,直接安装就可以了。

3. 使用 Ollama

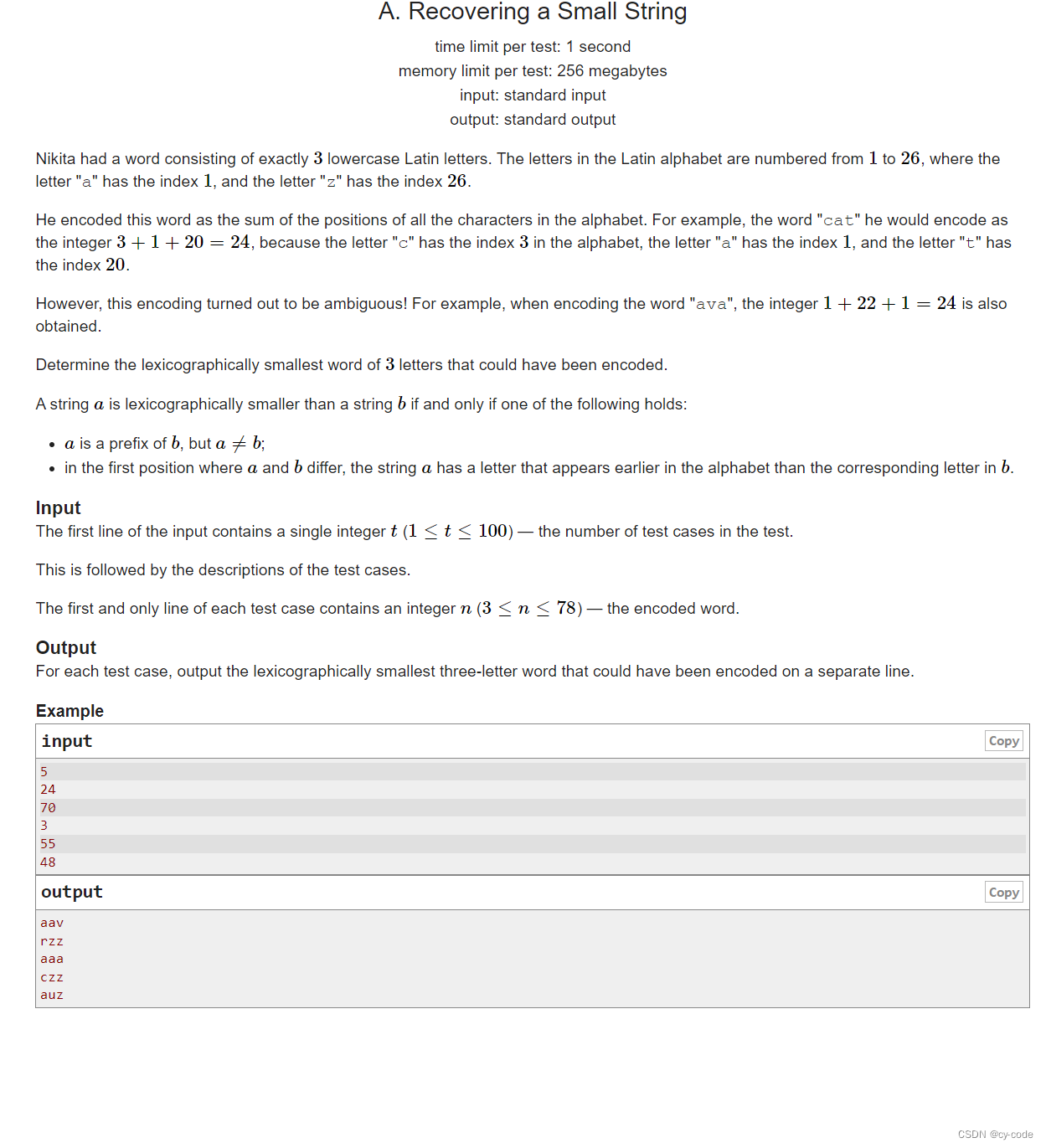

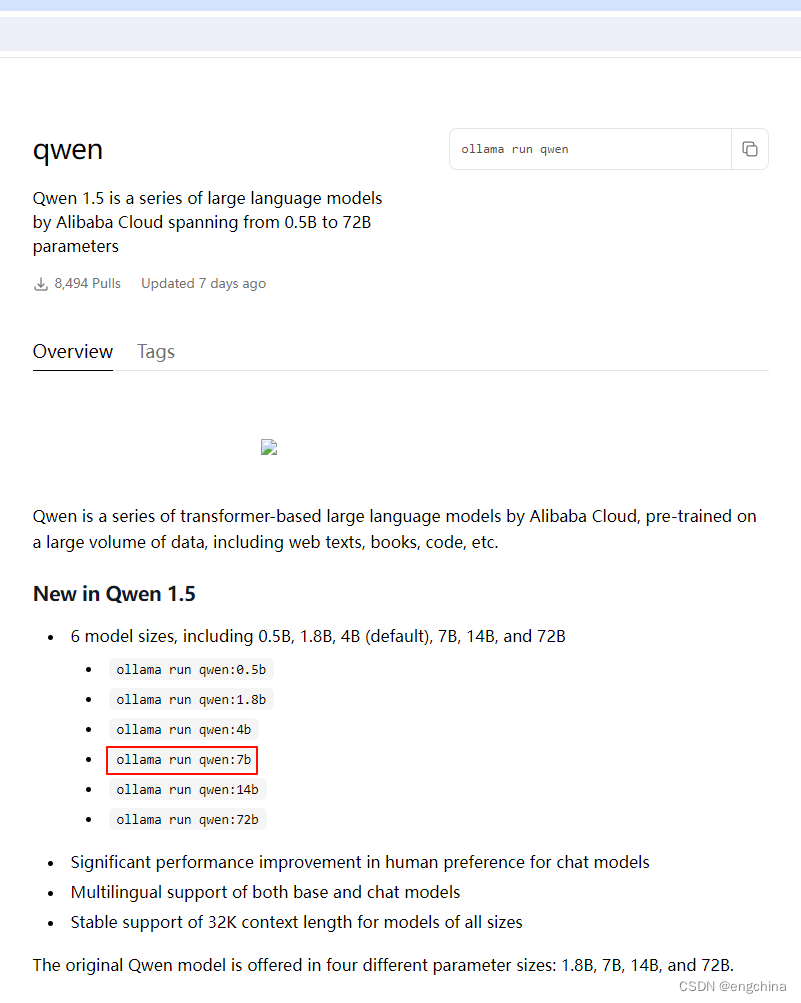

访问 https://ollama.com/library,搜索你要使用的模型,主流的模型,比如 llama2、qwen1.5、mixtral 等,Ollama都支持。

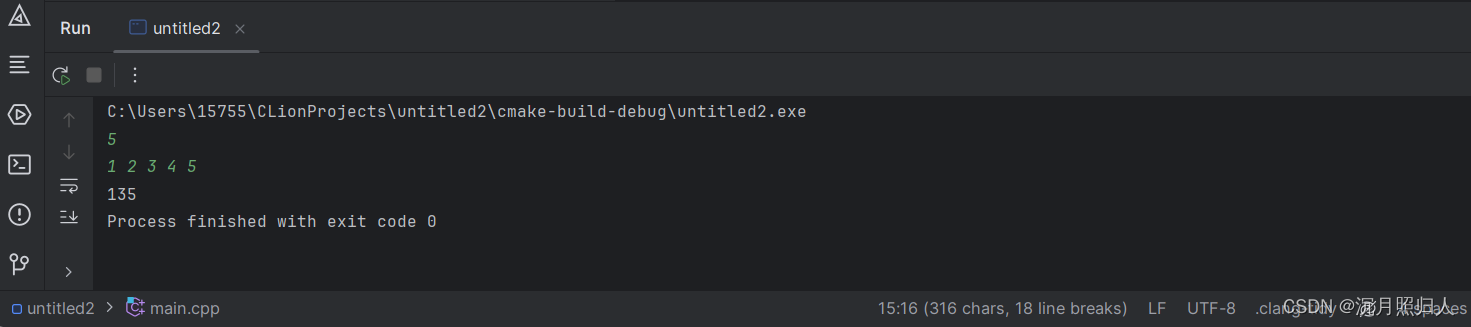

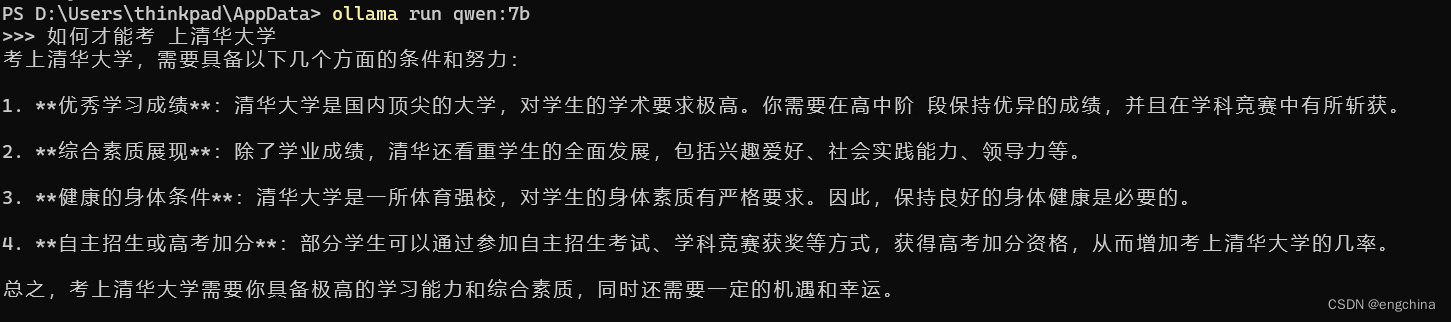

下面以允许 qwen 为例,我们要运行 7b 的模型,

拷贝上面红框的命令并运行,

ollama run qwen:7b

问一个问题试试,

完结!