YaRN

- 核心问题

- 上下文窗口限制

- 位置编码的限制

- YaRN的原理

- YaRN方法 = NTK-aware + NTK-by-parts + Dynamic NTK

- 子问题1: 高频信息丢失

- 子解决1: “NTK-aware”插值

- 子问题2: 相对局部距离的丢失

- 子解决2: “NTK-by-parts”插值

- 子问题3: 动态缩放

- 子解决3: “Dynamic NTK”插值

- 分析不足

核心问题

论文:https://arxiv.org/pdf/2309.00071.pdf

代码:https://github.com/jquesnelle/yarn

YaRN(Yet another RoPE extensioN)是一种针对语言模型的位置编码方法,它旨在解决一个特定的问题:如何让一个训练好的模型能够理解和处理比它原本训练时见过的还要长的文本序列。

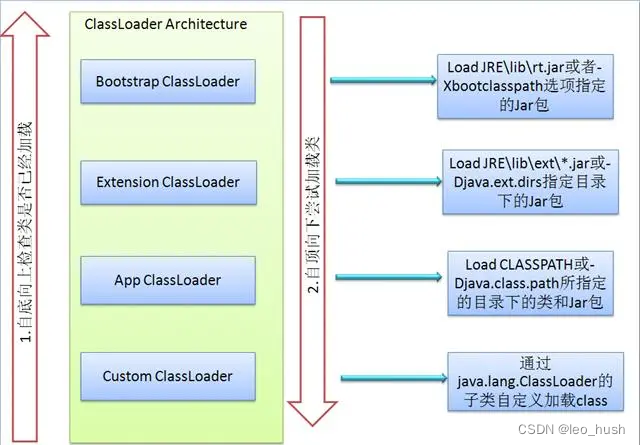

在大型语言模型中,位置编码是帮助模型理解单词顺序的重要组件。

YaRN的出现就是为了提升这种位置编码的能力。

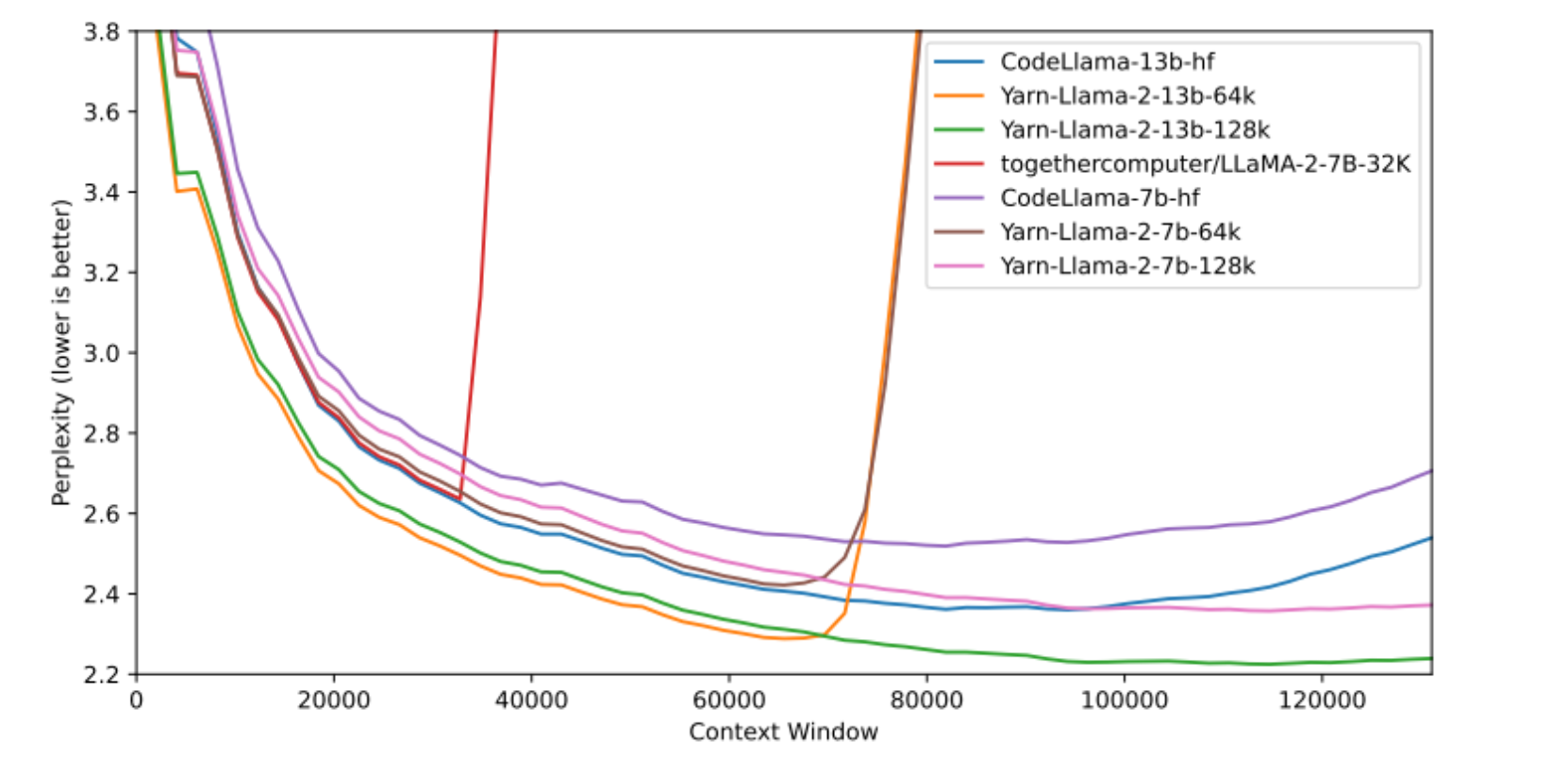

随着上下文窗口大小的增加,所有模型的困惑度都在下降,这表明考虑更多的上下文能够帮助模型做出更准确的预测。

一些曲线(如Yarn-Llama的曲线)在较大的上下文窗口大小时有更低的困惑度,表明YaRN方法在处理大上下文窗口时可能更有效。

上下文窗口限制

- 背景: 大型语言模型(LLMs)在NLP任务中表现突出,但其性能受到预训练时设定的上下文窗口大小的限制。

- 结论: 扩展上下文窗口对于提升大型语言模型处理长序列任务的能力至关重要。

位置编码的限制

- 背景: 位置编码是Transformer架构的核心组成部分,用于处理序列中元素的顺序信息。

- 然而,现有的位置编码方法难以泛化到比训练时更长的序列。

- 结论: 改进位置编码方法是解决上下文窗口限制问题的关键。

YaRN的原理

基本概念:

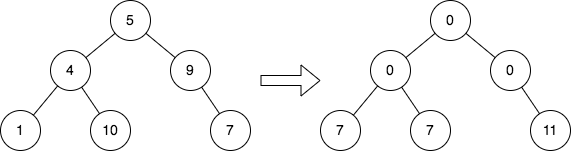

- RoPE(Rotary Position Embedding)是一种用于编码位置信息的方法,它通过一种特殊的数学变换(类似于旋转),将单词的位置信息嵌入到模型能够理解的形式中。这种方法能让模型知道哪些单词是相邻的,哪些单词距离较远。

- 波长:在RoPE中,波长是指在嵌入空间中一个完整周期的长度,可以理解为模型处理的序列在位置编码上走一个完整循环所需的长度。

类似钟表,用时针和分针来告诉时间。

时针和分针的位置是周期性的(每12小时或60分钟循环一次)。

如果你想要一个新的钟表,可以告诉你一天中的每一分钟(而不仅仅是12小时),你需要一种方法来扩展钟表的面,同时保持时针和分针的周期性不变。

YaRN就是在数学上完成这种扩展的方法,它确保即使是新的、更大的钟表面,时针和分针的相对位置仍然能够准确地告诉你现在的时间。

扩展方法:

- YaRN利用了RoPE的原理,但在此基础上进行了改进,使模型不仅能处理训练时的序列长度,还能处理更长的序列。

- 它通过一种特殊的计算方法,确保了即使在更长的序列中,位置信息也能保持一致,这样模型就不会因为序列太长而“迷失”单词的位置。

如何工作:

- YaRN首先计算原始模型的波长,然后用这个波长来指导如何为更长的序列生成新的位置编码。

- 这个过程保证了新的位置编码与原来的编码在数学特性上是一致的,就像是在原有的位置编码上“拉伸”出了新的空间来适应更长的文本。

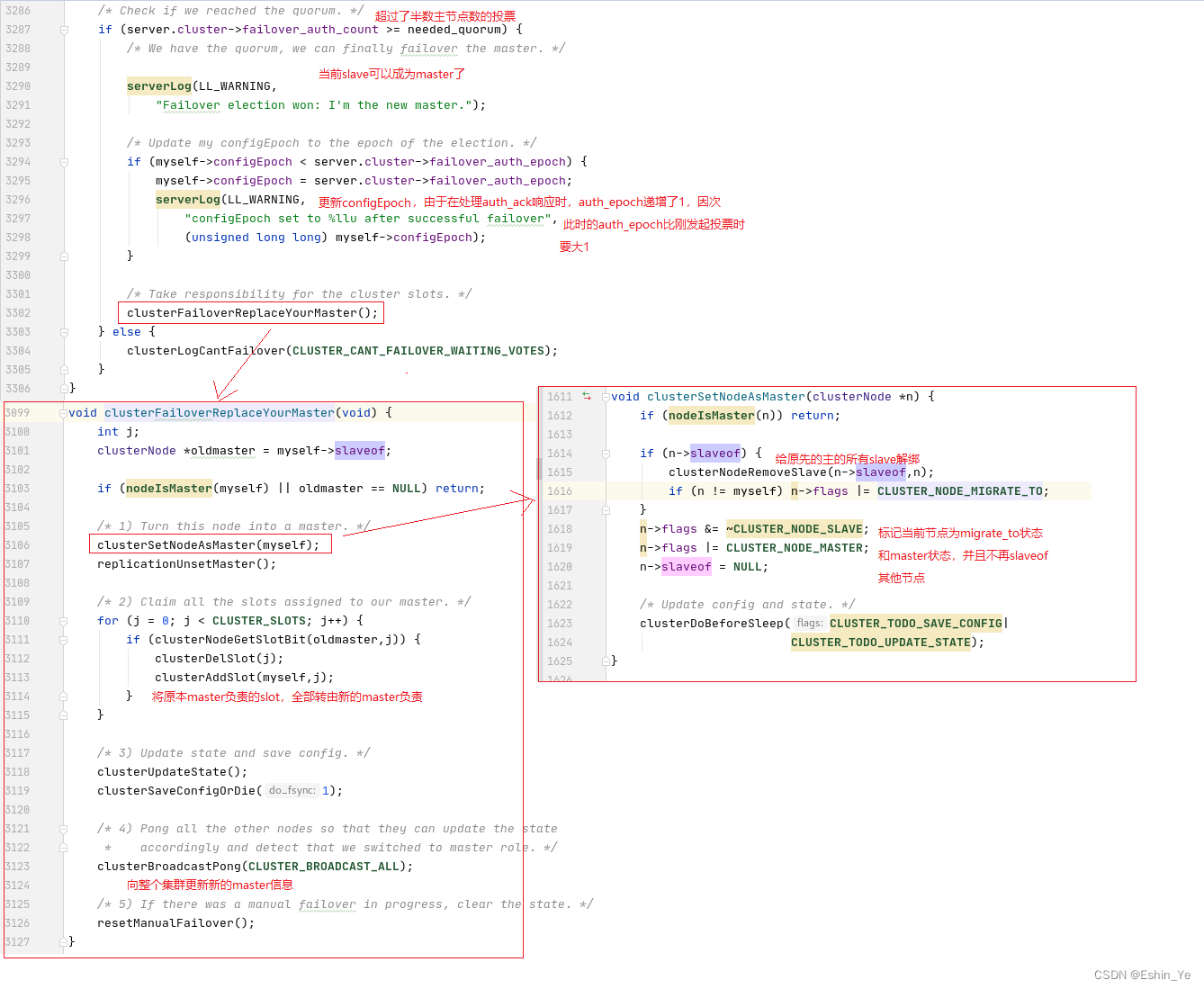

YaRN方法 = NTK-aware + NTK-by-parts + Dynamic NTK

通俗解释: YaRN就像是一个聪明的阅读助手,它结合了以上所有的技术,确保即使在阅读非常长的文章时,也能记得文章的每个部分,并且理解每个细节。

就像一个熟练的读者可以快速浏览一本书并记住所有重要的信息一样,YaRN使语言模型能够处理大量的信息,同时保持对细节的敏感性。

YaRN方法包含了“NTK-by-parts”插值和注意力机制的调整,但不是简单地将“NTK-aware”、"NTK-by-parts"和“Dynamic NTK”插值三者相加。

-

“NTK-aware”插值是YaRN方法发展过程中的一个步骤,它解决了RoPE插值过程中可能丢失的高频信息问题,通过不同程度地缩放RoPE的不同频率维度。

-

“NTK-by-parts”插值是YaRN方法中的核心组成部分,它进一步细化了插值策略,特别是在处理不同频率(或波长)的RoPE维度时,以避免丢失相对局部距离信息。

-

“Dynamic NTK”插值是一个与YaRN相关的概念,它通过在模型的不同推理步骤中动态调整插值策略,提供了一种在处理不同长度序列时动态适应的方法。

YaRN方法是基于上述的理论和技术,结合了“NTK-by-parts”插值和对注意力机制的特定调整(通过温度参数)来优化模型对长序列的处理能力。

在YaRN中,还引入了一种在注意力计算中使用的温度调节,以及一种长度缩放技巧,这些都是在不修改模型代码的情况下,对模型的注意力机制进行微调。

子问题1: 高频信息丢失

通俗解释: 想象你在阅读一篇文章,其中有些单词或者细节特别微小,比如一些细微的情感变化或者语气差别。

如果这些细节在阅读过程中丢失了,整个故事或论点的理解可能就会受影响。在语言模型中,高频信息指的就是这些细微的差别。

子解决1: “NTK-aware”插值

通俗解释: 为了不丢失这些细节,我们需要给模型戴上一副“高清眼镜”,让它即使在阅读更长的文章时也能注意到这些细微的差别。

这就是“NTK-aware”插值做的事情,它调整模型的内部设置,让它在处理长文本时,仍然能够捕捉到关键的细节信息。

子问题2: 相对局部距离的丢失

通俗解释: 现在,想象文章中的每个单词都是故事中的一个角色,它们之间的关系和距离很重要。

如果我们在拉长文章时把所有单词间的距离都均匀拉开,角色间的关系就会变得模糊,我们可能会弄不清楚谁对谁说了什么。

子解决2: “NTK-by-parts”插值

通俗解释: 这个方法就像是我们仔细考虑每个角色间的关系,确保在扩展故事时,这些关系不会被扭曲。

在模型里,这就是“NTK-by-parts”插值所做的,它精心调整模型处理单词位置信息的方式,确保即使在更长的文本中,单词间的相对位置和关系也能被正确理解。

子问题3: 动态缩放

通俗解释: 如果你在读一本书,但是你每次能记住的内容长度不一样,有时候你可能只需要记住一句话,有时候可能是一整页。你的大脑需要能够灵活调整记忆的长度,以适应不同的阅读需求。

子解决3: “Dynamic NTK”插值

通俗解释: 这就是“Dynamic NTK”插值所做的,它让模型能够根据当前正在处理的文本长度动态调整其“记忆范围”。

就像你的大脑在阅读不同长度的内容时自然做的调整一样,模型也能够在处理不同长度的文本时自然过渡,保持高效和准确。

分析不足

- 分析: YaRN方法通过在RoPE基础上进行创新,解决了传统位置编码方法难以扩展上下文窗口的问题。

- 通过动态YaRN的应用,模型能够在不需要额外训练的情况下处理更长的文本,这在提高效率和性能方面是一个重大突破。

- 不足: 尽管YaRN在上下文窗口扩展方面取得了显著进展,但可能仍有一些挑战未被充分解决,比如在极端长序列的处理上的效率和准确性,以及在不同语言或领域中的泛化能力。