ETL是什么

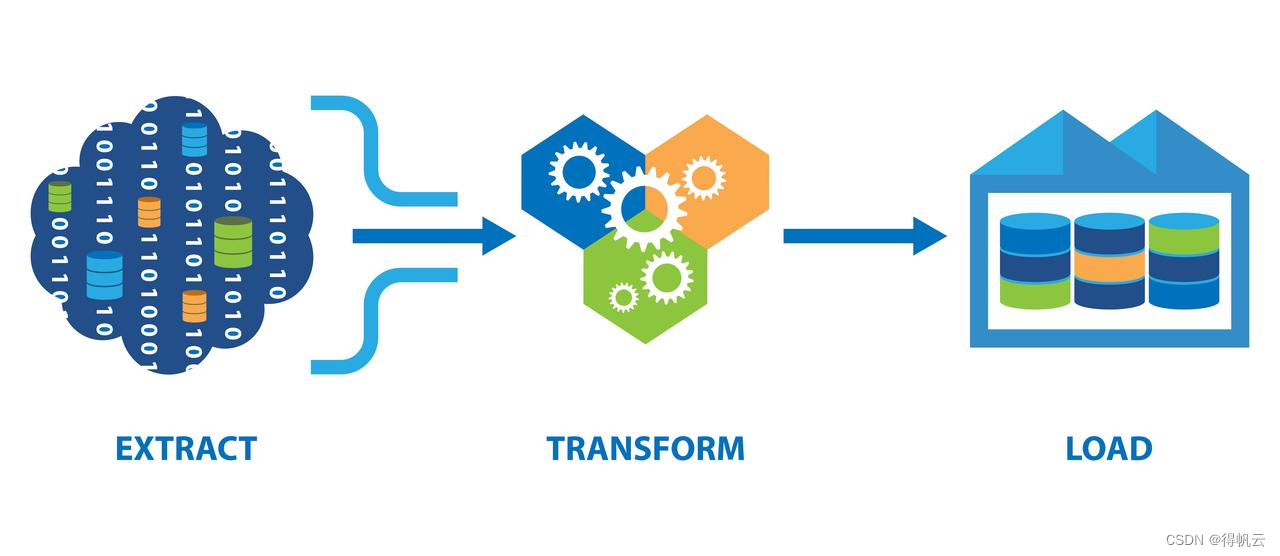

ETL(Extract-Transform-Load),用来描述将数据从来源端经过抽取(extract)、转换(transform)、加载(load)至目标端的过程。ETL一词较常用在数据仓库,但其对象并不限于数据仓库。它可以自动化数据处理过程,减少人工操作和错误,提高数据分析的可靠性和效率

企业各种数据源的类型、格式、规模和可靠性大不相同,因此数据要经过处理才能供组织和用户使用。因此,ETL数据处理在企业中是不可或缺的。

ETL流程

ETL流程可简单分为抽取(extract)、转换(transform)、加载(load),接下来我们分别介绍下。

数据抽取(extract):将数据从不同的数据源中提取出来,包括关系型数据库、非结构化数据、日志数据等等。这个环节主要用到Sqoop、Flume、Kafka、还有Kettle、DataX、Maxwell等抽取工具。在抽取数据时,一般会采取全量同步或增量同步的方式。

数据转换(transform):将抽取出来的数据进行清洗、转换和合并,以使其适合存储在数据仓库或数据湖中。数据转换还可以包括数据去重、格式转换、数据合并等操作,以确保数据的一致性和准确性。

数据加载(load):抽取转换之后,就是将数据加载到数据仓库或数据湖中,以供业务分析和报告使用。数据加载的方式也有两种:全量加载和增量加载。数据加载这步会用到Hbase、HDFS等工具。

ETL工具软件

ETL工具、类ETL的数据集成同步工具或语言也非常之多。主流的etl工具有Sqoop、DataX、Canal、flume、Logstash、kettle、DataStage、Informatica、Talend等,语言有强悍的SQL、Shell、Python、Java、Scala等。

代表性的ETL工具有:Sqoop、DataX、Kettle、canal、Informatica、Datastage等

Sqoop,SQL-to-Hadoop 即 “SQL到Hadoop和Hadoop到SQL”。是Apache开源的一款在Hadoop和关系数据库服务器之间传输数据的工具,大数据领域很常见的工具。

DataX是阿里巴巴集团内被广泛使用的离线数据同步工具/平台,实现包括MySQL、Oracle、SqlServer、Postgre、HDFS、Hive、ADS、HBase、TableStore(OTS)、MaxCompute(ODPS)、DRDS等各种异构数据源之间高效的数据同步功能。

Kettle是一款国外免费开源的、可视化的、功能强大的ETL工具,纯java编写,可以在Windows、Linux、Unix上运行,数据抽取高效稳定。缺点是面对特别复杂的业务逻辑,受制于组件的使用情况。

canal是阿里巴巴旗下的一款开源项目,纯Java开发。基于数据库增量日志解析,提供增量数据实时订阅和消费,目前主要支持了MySQL,也支持mariaDB。

Informatica,一款易于配置和管理,能够快速实现ETL任务的ETL工具。缺点和Flume一样,价格高,占用空间大。

Datastage,IBM公司开发的一款ETL工具,具有良好的跨平台性和数据集成能力,提供了可视化的ETL操作界面。缺点是价格远高于其他的ETL工具,而且需要占用较高的系统资源和硬盘空间。

ETL工程师的就业前景

现如今,越来越多的企业开始涉足并重视大数据,各大银行、金融、电信、电力、政府、证券、医院、大学院校及大型制造业等都急需大数据人才。ETL开发在大数据的整个项目流程中处于中前期的位置,是一个基础,如果ETL技术工作做好的话会有事半功倍的效果。

ETL开发工程师将出现大量的人才缺口,同时ETL工程师将有着更好的职业发展前景和巨大的发展空间。举例来说,IT业为行业薪酬待遇最高水平,而ETL大数据工程师的起薪更是远远高出其它行业。

ETL工程师一般涉及以下工作内容,相关专业的同学需要多学多看,多多学习才能胜任ETL工作。

-

海量数据的ETL开发,抽取成各种数据需求;

-

参与数据仓库架构的设计及开发;

-

参与数据仓库ETL流程优化及解决ETL相关技术问题;

-

研究跟进数据库开发技术,为各业务系统提供数据及报表支持等。