前言

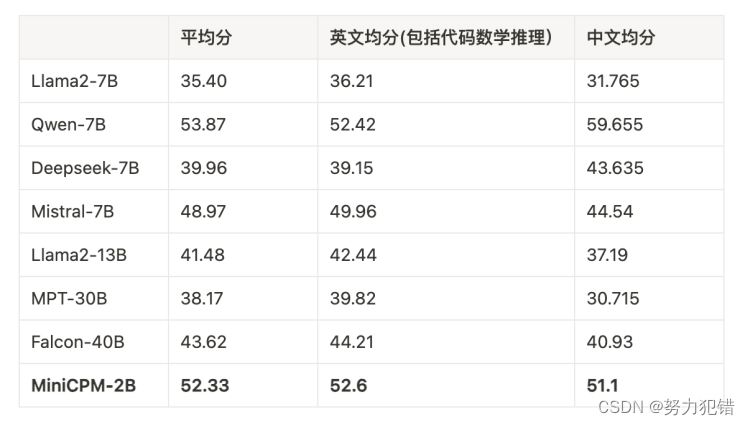

在人工智能的快速发展中,模型的规模和性能成为衡量先进技术的关键指标。最近,清华系创业团队面壁智能发布的面壁MiniCPM模型,以其2B(24亿)参数的“小钢炮”身份,成功挑战了70亿参数的国际大模型Mistral-7B,实现了在多项AI评测中的领先成绩。

-

Huggingface模型下载:https://huggingface.co/openbmb

-

AI快站模型免费加速下载:https://aifasthub.com/models/openbmb

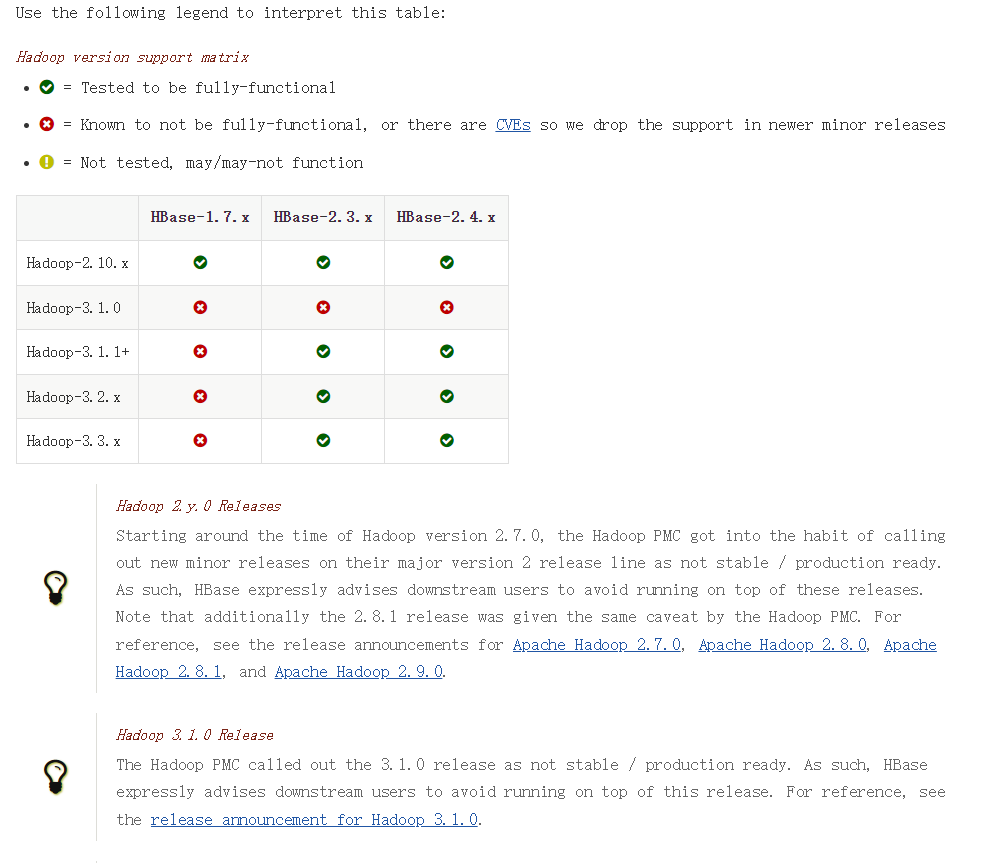

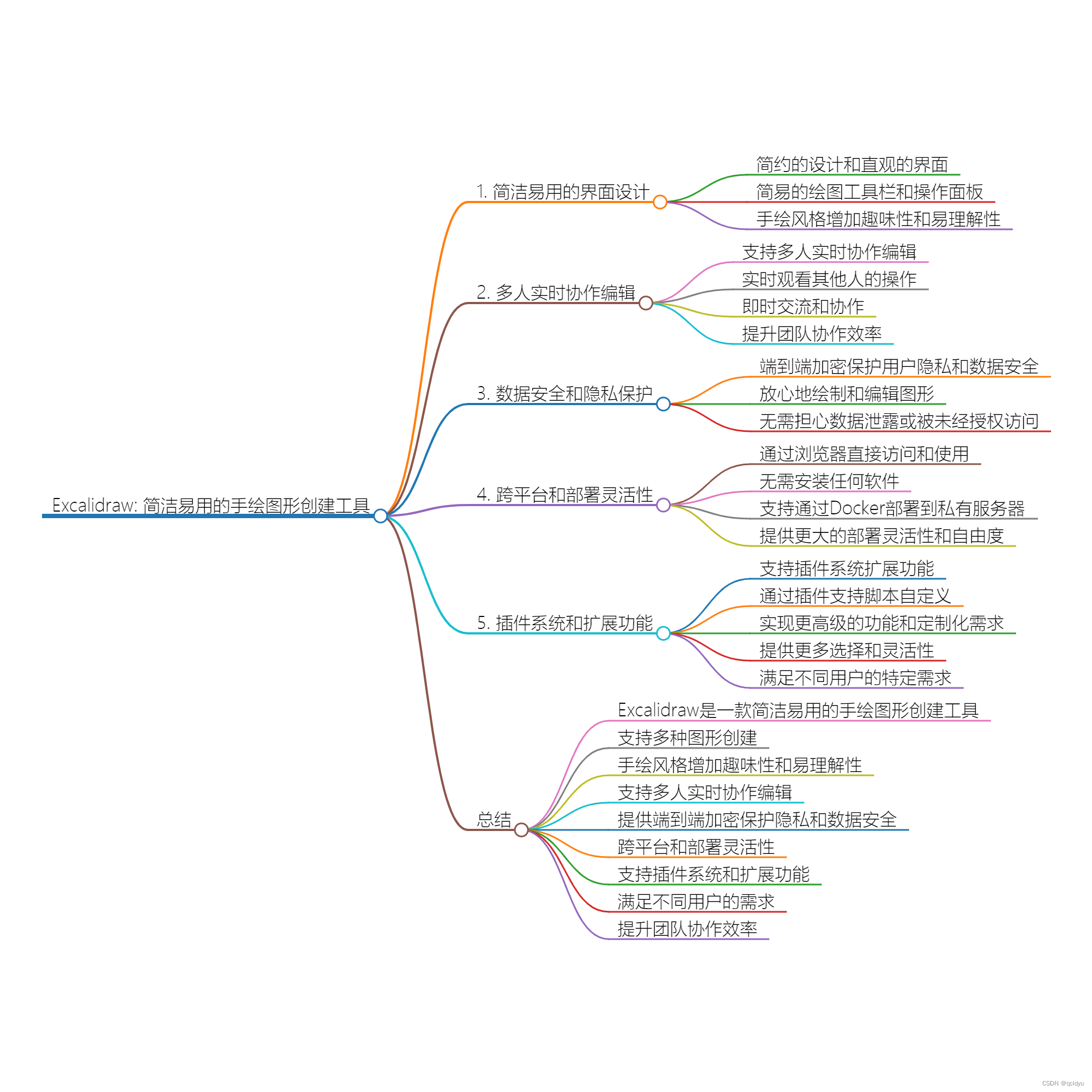

在与其他同等规模大模型的对比中,面壁MiniCPM表现依旧领先,大幅超越了 Llama2-7B, Mistral7B,Gemini Nano,Qwen-1.8B等一众模型,甚至还能越级比肩 Llama2-13B、Falcon 40B和Cohere 54B此类比自己庞大数十倍规模的模型。

面壁MiniCPM模型的技术细节

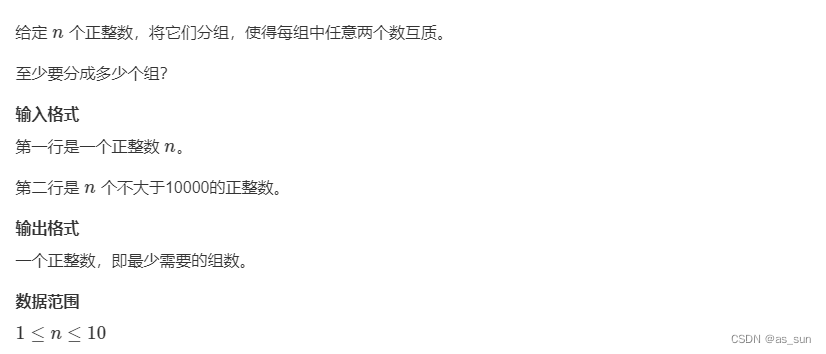

面壁MiniCPM模型的技术创新主要体现在以下几个方面:

-

算法优化:面壁智能自主研发的“模型沙盒”技术,能够在相同的数据量下训练出更大的模型。该技术通过模拟不同的训练环境和参数配置,预测模型性能,从而实现最优的超参数选择。这一创新使得MiniCPM在保持2B参数规模的同时,性能却能媲美或超越更大规模的模型。

-

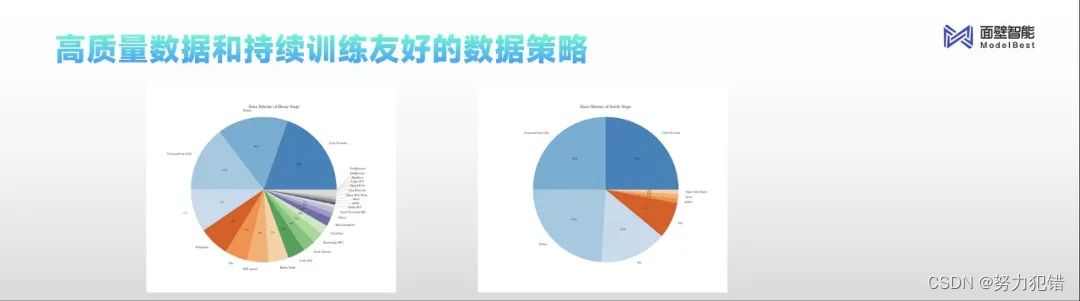

数据治理:面壁MiniCPM使用了1T(1万亿)Tokens的精选数据集,这些数据经过严格筛选和优化,确保训练过程的高效性和模型输出的高质量。通过有效的数据管理策略,面壁MiniCPM能够在更短的时间内,以更低的计算成本,达到更高的训练效率。

-

省钱秘籍:面壁MiniCPM模型支持在CPU上运行推理,在消费级显卡上进行高效训练与微调。经过Int4量化处理后,模型仅占用2GB的内存空间,大大降低了部署成本,使得端侧AI应用成为可能。面壁智能表示,每170万tokens的端侧推理成本仅为1元人民币,显著低于市场上同类产品。

面壁MiniCPM的性能表现

面壁MiniCPM模型在多项主流AI评测中展现出了卓越的性能。在自然语言处理(NLP)任务中,MiniCPM不仅能够准确理解和生成中英文文本,还能处理复杂的多模态输入,如图像加文本的联合理解任务。在与Mistral-7B以及其他同类大模型的比较测试中,MiniCPM在中英文平均成绩上均取得了领先。

此外,面壁MiniCPM的多模态能力也得到了验证。在图像理解任务上,MiniCPM能够准确解读图像内容,并结合文本信息给出合理的回答。这一能力在移动设备上的实际应用中,极大地拓展了AI技术的使用场景。

AI领域的意义

面壁MiniCPM模型的成功,不仅展示了国产AI技术的实力,也为AI模型的发展提供了新的方向。面壁智能的技术创新,尤其是在算法优化、数据治理、以及成本控制方面的突破,为构建更高效、更经济的AI系统提供了可能。面壁MiniCPM的开源,将进一步推动全球AI技术的交流和创新,加速AI技术在各行各业的应用和发展。

模型下载

Huggingface模型下载

https://huggingface.co/openbmb

AI快站模型免费加速下载

https://aifasthub.com/models/openbmb

![[SWPUCTF 2021 新生赛]easyupload1.0](https://img-blog.csdnimg.cn/direct/1f55e2cd11164f8eb75ce9a8db806aad.png)