文章目录

- 4.1 解析 HTML 与 CSS

- 4.1.1 重点基础知识讲解

- 4.1.2 重点案例:使用 BeautifulSoup 解析博客文章

- 4.1.3 拓展案例 1:使用 lxml 和 XPath 解析产品信息

- 4.1.4 拓展案例 2:动态加载内容的抓取挑战

- 4.2 动态内容抓取技术

- 4.2.1 重点基础知识讲解

- 4.2.2 重点案例:使用 Selenium 抓取动态评论

- 4.2.3 拓展案例 1:使用 Headless Chrome 抓取股票价格

- 4.2.4 拓展案例 2:使用 Pyppeteer 抓取动态新闻

- 4.3 数据抽取表达式(XPath, 正则表达式)

- 4.3.1 重点基础知识讲解

- 4.3.2 重点案例:使用 XPath 提取新闻标题和链接

- 4.3.3 拓展案例 1:使用正则表达式提取电子邮件地址

- 4.3.4 拓展案例 2:结合使用 BeautifulSoup 和正则表达式

4.1 解析 HTML 与 CSS

在网络爬虫的世界里,能够解析 HTML 和 CSS 是基本生存技能。这就像是拥有一双可以透视网络迷宫的眼睛,让你能够精确地找到和提取你需要的数据。

4.1.1 重点基础知识讲解

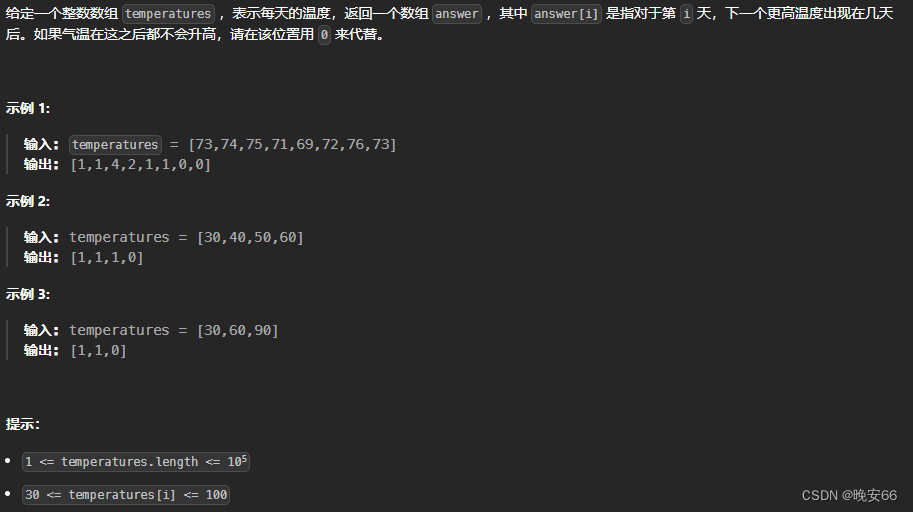

- HTML 结构理解:HTML(HyperText Markup Language)是构成网页的骨架。它使用一系列的标签(如

<div>、<a>、<p>等)来组织内容。理解这些标签及其属性(如class、id)对于定位数据至关重要。 - CSS 选择器:CSS(Cascading Style Sheets)用于添加样式到 HTML 元素。在数据抓取中,CSS 选择器非常有用,因为它们可以帮助我们定位到具有特定样式的元素。

- 工具和库:有许多 Python 库可以帮助我们解析 HTML 和 CSS,其中最著名的包括 BeautifulSoup 和 lxml。这些库提供了方便的方法来搜索和操作 HTML 文档。

4.1.2 重点案例:使用 BeautifulSoup 解析博客文章

假设我们要从一个博客网站上抓取所有博客文章的标题和链接。BeautifulSoup 是完成这个任务的理想工具。

from bs4 import BeautifulSoup

import requests

url = "https://blog.example.com"

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

articles = soup.find_all('article')

for article in articles:

title = article.find('h2').text

link = article.find('a')['href']

print(f"文章标题: {title}, 链接: {link}")

4.1.3 拓展案例 1:使用 lxml 和 XPath 解析产品信息

当处理复杂的 HTML 文档或需要更高性能的解析时,lxml 和 XPath 表达式是更加强大的工具。下面是一个示例,展示如何使用它们来抓取电商网站上的产品名称和价格。

import requests

from lxml import etree

url = "https://ecommerce.example.com/products"

response = requests.get(url)

tree = etree.HTML(response.content)

for product in tree.xpath('//div[@class="product"]'):

name = product.xpath('.//h2/text()')[0]

price = product.xpath('.//span[@class="price"]/text()')[0]

print(f"产品名称: {name}, 价格: {price}")

4.1.4 拓展案例 2:动态加载内容的抓取挑战

对于通过 JavaScript 动态加载的内容,传统的 HTML 解析方法可能无法直接获取到数据。在这种情况下,我们可以使用 Selenium 来模拟浏览器行为,先执行 JavaScript,再抓取生成的内容。

from selenium import webdriver

driver = webdriver.Chrome()

driver.get("https://dynamic-content.example.com")

# 等待页面加载完成

driver.implicitly_wait(10)

articles = driver.find_elements_by_tag_name('article')

for article in articles:

title = article.find_element_by_tag_name('h2').text

print(f"文章标题: {title}")

driver.quit()

通过以上案例,我们探索了使用不同工具和方法解析 HTML 和 CSS 的基础知识及实践应用。无论是静态页面的简单抓取,还是动态内容的复杂抓取任务,掌握这些技能都将为你打开数据抓取的大门。继续前进,数据侠们,更多的宝藏等着我们去发现!

4.2 动态内容抓取技术

在今天的网络世界中,动态内容的生成已经变得司空见惯。从社交媒体动态、评论加载,到实时价格更新,这些内容往往依赖于 JavaScript 在客户端的执行。对于数据抓取专家来说,这意味着需要采用特殊的技术来应对这些情况。

4.2.1 重点基础知识讲解

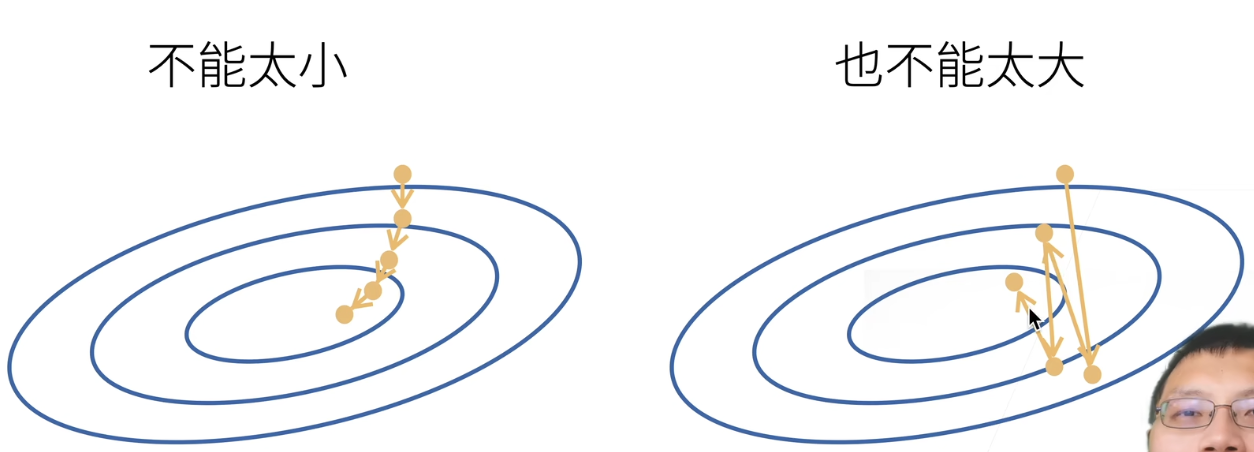

- 理解 AJAX 和 JavaScript 动态加载:许多现代网站使用 AJAX(Asynchronous JavaScript and XML)技术来在页面加载后从服务器获取数据,然后用 JavaScript 动态更新页面内容。这意味着,简单的 HTTP 请求无法获取到页面的全部内容。

- Selenium:Selenium 是一个自动化测试工具,但它也被广泛用于模拟用户在浏览器中的行为来抓取动态生成的内容。它可以执行 JavaScript,等待 AJAX 请求完成,并访问由 JavaScript 动态生成的 DOM 元素。

- Headless Browser:Headless 浏览器是没有图形用户界面的浏览器。它们可以通过命令行被控制,用于自动化网页交互,非常适合在服务器端运行。Selenium 支持与 Headless Chrome 或 Headless Firefox 的集成。

4.2.2 重点案例:使用 Selenium 抓取动态评论

假设你需要从一个新闻网站上抓取用户的动态加载评论。这些评论在页面最初加载时不可见,只有当用户滚动到页面底部时才通过 AJAX 请求加载。

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.common.keys import Keys

driver = webdriver.Chrome()

driver.get("https://news.example.com/article")

# 模拟用户滚动到页面底部,以加载评论

driver.find_element(By.TAG_NAME, 'body').send_keys(Keys.END)

# 等待 AJAX 加载评论

driver.implicitly_wait(10)

comments = driver.find_elements(By.CLASS_NAME, 'comment')

for comment in comments:

print(comment.text)

driver.quit()

4.2.3 拓展案例 1:使用 Headless Chrome 抓取股票价格

在这个案例中,我们将使用 Headless Chrome 来抓取一个财经网站上动态更新的股票价格。

from selenium import webdriver

from selenium.webdriver.chrome.options import Options

chrome_options = Options()

chrome_options.add_argument("--headless") # 启用无头模式

driver = webdriver.Chrome(options=chrome_options)

driver.get("https://finance.example.com/stock/AAPL")

price = driver.find_element(By.CLASS_NAME, 'stock-price').text

print(f"苹果公司股票价格: {price}")

driver.quit()

4.2.4 拓展案例 2:使用 Pyppeteer 抓取动态新闻

Pyppeteer 是一个 Python 库,它提供了一个接口来控制 Headless Chrome。相比 Selenium,Pyppeteer 更为轻量,适合需要频繁抓取动态内容的场景。

import asyncio

from pyppeteer import launch

async def fetch_news():

browser = await launch(headless=True)

page = await browser.newPage()

await page.goto('https://news.example.com/today')

# 等待动态内容加载

await page.waitForSelector('.news-item', {'timeout': 10000})

news_items = await page.querySelectorAll('.news-item')

for item in news_items:

title = await page.evaluate('(item) => item.innerText', item)

print(f"新闻标题: {title}")

await browser.close()

asyncio.get_event_loop().run_until_complete(fetch_news())

通过这些案例,我们可以看到,尽管动态内容的抓取比静态内容更具挑战性,但通过使用正确的工具和技术,我们依然可以有效地获取所需的数据。无论是模拟浏览器操作的 Selenium,还是无头浏览器技术,选择合适的工具可以让这一任务变得简单许多。

4.3 数据抽取表达式(XPath, 正则表达式)

在网络爬虫的艺术中,精确地提取目标数据是一项至关重要的技能。XPath 和正则表达式就像是爬虫工程师的瑞士军刀,它们提供了强大的能力来定位和抽取网页中的数据。

4.3.1 重点基础知识讲解

- XPath:XPath 是一种在 XML 文档中查找信息的语言,也常用于 HTML。它允许开发者通过元素和属性进行导航,非常适合于复杂的文档结构。

- 正则表达式:正则表达式是一种强大的文本处理工具,用于搜索、替换那些符合某个模式(规则)的字符串。在数据抽取中,正则表达式能够快速地从一段文本中提取出我们感兴趣的部分。

- 工具选择:Python 中处理 XPath 的库包括 lxml 和 Scrapy。对于正则表达式,Python 的内置库

re提供了丰富的功能。

4.3.2 重点案例:使用 XPath 提取新闻标题和链接

假设我们的目标是从新闻网站上提取新闻标题和对应的链接。这里,我们使用 lxml 库来处理 XPath 表达式。

from lxml import etree

import requests

url = "https://news.example.com"

response = requests.get(url)

tree = etree.HTML(response.content)

titles = tree.xpath('//h2[@class="title"]/text()')

links = tree.xpath('//h2[@class="title"]/a/@href')

for title, link in zip(titles, links):

print(f"新闻标题: {title}, 链接: {link}")

4.3.3 拓展案例 1:使用正则表达式提取电子邮件地址

在某些情况下,你可能需要从网页中提取电子邮件地址。正则表达式在这种任务中表现出色。

import re

import requests

url = "https://contact.example.com"

response = requests.get(url)

content = response.text

emails = re.findall(r'[a-zA-Z0-9_.+-]+@[a-zA-Z0-9-]+\.[a-zA-Z0-9-.]+', content)

for email in emails:

print(f"发现电子邮件: {email}")

4.3.4 拓展案例 2:结合使用 BeautifulSoup 和正则表达式

有时候,结合使用 BeautifulSoup 和正则表达式可以提供更灵活的数据抽取方式。比如,提取包含特定文本模式的所有段落。

from bs4 import BeautifulSoup

import requests

import re

url = "https://blog.example.com"

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

# 假设我们想提取包含日期(如 "2023-01-01")的段落

pattern = re.compile(r'\d{4}-\d{2}-\d{2}')

paragraphs = soup.find_all('p', string=pattern)

for paragraph in paragraphs:

if pattern.search(paragraph.text):

print(f"找到含日期的段落: {paragraph.text}")

通过这些案例,我们看到了 XPath 和正则表达式在数据抽取中的强大能力。无论是精确地定位网页元素,还是从复杂的文本中提取信息,掌握这些技能都将极大增强你的爬虫效率和准确性。练习和应用这些技术,让你的数据抓取之旅更加顺利!