文章目录

- 2.1 选择合适的爬虫工具和库

- 2.1.1 重点基础知识讲解

- 2.1.2 重点案例:使用 Scrapy 抓取电商网站

- 2.1.3 拓展案例 1:使用 Requests 和 BeautifulSoup 抓取博客文章

- 2.1.4 拓展案例 2:使用 Selenium 抓取动态内容

- 2.2 设置开发环境

- 2.2.1 重点基础知识讲解

- 2.2.2 重点案例:配置 Python 开发环境

- 2.2.3 拓展案例 1:为 BeautifulSoup 和 Requests 配置环境

- 2.2.4 拓展案例 2:配置带有 Selenium 的环境

- 2.3 理解目标网站的结构

- 2.3.1 重点基础知识讲解

- 2.3.2 重点案例:分析新闻网站的结构

- 2.3.3 拓展案例 1:提取电商网站的产品信息

- 2.3.4 拓展案例 2:爬取动态加载的评论内容

2.1 选择合适的爬虫工具和库

在 Python 的宝库中,有着各种强大的工具和库,可以帮助你轻松地开始你的网络爬虫项目。了解这些工具和如何选择适合你的项目需求的工具是成功的关键。

2.1.1 重点基础知识讲解

- Requests:对于初学者来说,Requests 库是发送 HTTP 请求的绝佳选择。它简单、直观,是处理网页数据的强大工具。

- BeautifulSoup:当你需要从 HTML 或 XML 文件中提取数据时,BeautifulSoup 就派上用场了。它可以帮助你轻松地导航、搜索和修改解析树。

- Scrapy:如果你的项目需要更复杂的爬虫,或者你需要构建一个大规模的爬虫,Scrapy 是一个快速、高层次的框架,提供了数据存储、请求处理等完整的解决方案。

- Selenium:当你需要处理 JavaScript 生成的数据时,Selenium 可以模拟一个真实的浏览器环境,允许你执行 JavaScript,并且与页面交互。

2.1.2 重点案例:使用 Scrapy 抓取电商网站

假设你正在构建一个比价平台,需要从多个电商网站上抓取商品价格和描述信息。Scrapy 由于其高效的异步处理能力,是完成这项任务的理想工具。

import scrapy

class ECommerceSpider(scrapy.Spider):

name = 'ecommerce_spider'

start_urls = ['http://example.com/products']

def parse(self, response):

for product in response.css('div.product'):

yield {

'name': product.css('h2::text').get(),

'price': product.css('span.price::text').get()

}

2.1.3 拓展案例 1:使用 Requests 和 BeautifulSoup 抓取博客文章

如果你的目标是建立一个内容聚合器,抓取并展示最新的博客文章标题和链接,则可以使用 Requests 和 BeautifulSoup 组合来实现。

import requests

from bs4 import BeautifulSoup

response = requests.get('https://blog.example.com')

soup = BeautifulSoup(response.text, 'html.parser')

for article in soup.find_all('article'):

title = article.find('h2').text

link = article.find('a')['href']

print(f"标题: {title}, 链接: {link}")

2.1.4 拓展案例 2:使用 Selenium 抓取动态内容

当你需要从一个使用大量 JavaScript 动态加载内容的网站上抓取数据时,Selenium 可以模拟用户在网页上的实际操作,比如点击按钮,填写表单等。

from selenium import webdriver

driver = webdriver.Chrome()

driver.get('http://dynamic-content.example.com')

button = driver.find_element_by_id('loadMore')

button.click() # 模拟点击“加载更多”

# 现在可以抓取新加载的内容了

content = driver.find_element_by_class_name('new-content')

print(content.text)

driver.close()

通过这些案例,我们可以看到,不同的网络爬虫任务可能需要不同的工具和库。选择正确的工具,可以让你的爬虫更高效、更易于维护。无论你是在抓取静态页面的数据,还是需要与复杂的动态内容交互,Python 的生态系统都提供了强大的库来支持你的项目。

2.2 设置开发环境

在开始你的网络爬虫旅程之前,确保你有一个稳定且高效的开发环境是至关重要的。这不仅能够提高你的开发效率,还能确保在你开发过程中遇到的任何问题都可以在一个可控的环境内解决。

2.2.1 重点基础知识讲解

- 安装 Python:确保你的机器上安装了最新版本的 Python。Python 3 是目前的主流,许多爬虫库都依赖于 Python 3 的特性和改进。

- 虚拟环境:使用虚拟环境可以帮助你为每个项目创建独立的 Python 运行环境。这意味着不同项目的依赖包不会相互冲突。

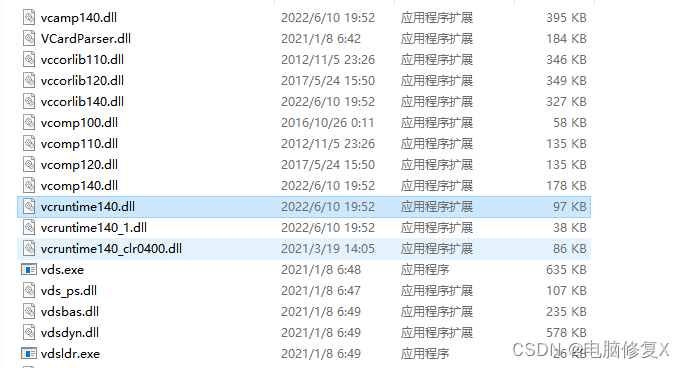

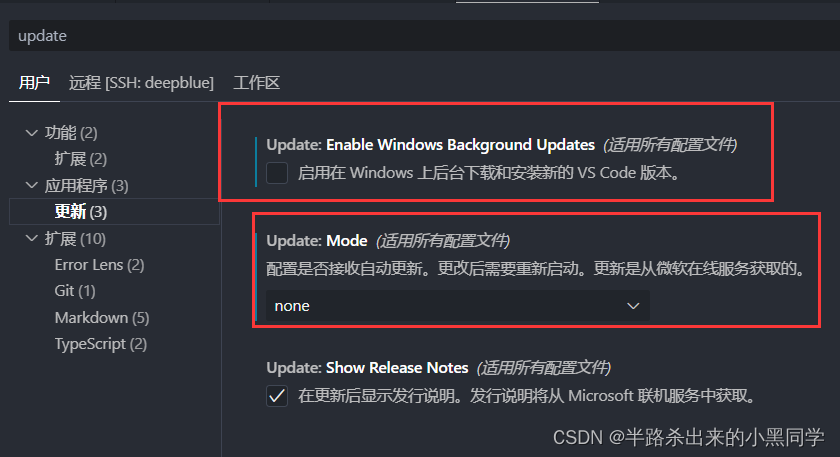

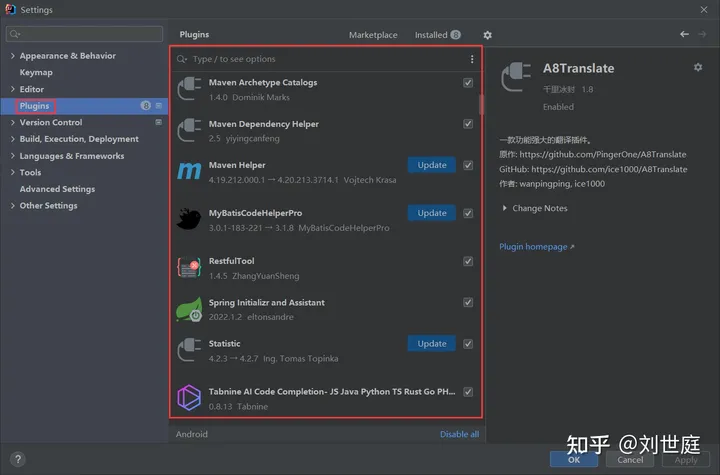

venv是 Python 的内置库,可以用来创建虚拟环境。 - 代码编辑器:选择一个好的代码编辑器可以极大提升你的编程体验。Visual Studio Code、PyCharm 是非常受欢迎的选择,它们提供了代码高亮、智能提示、代码调试等强大功能。

- 安装爬虫库:基于你的项目需求,安装必要的爬虫库,如 Requests、BeautifulSoup、Scrapy 等。

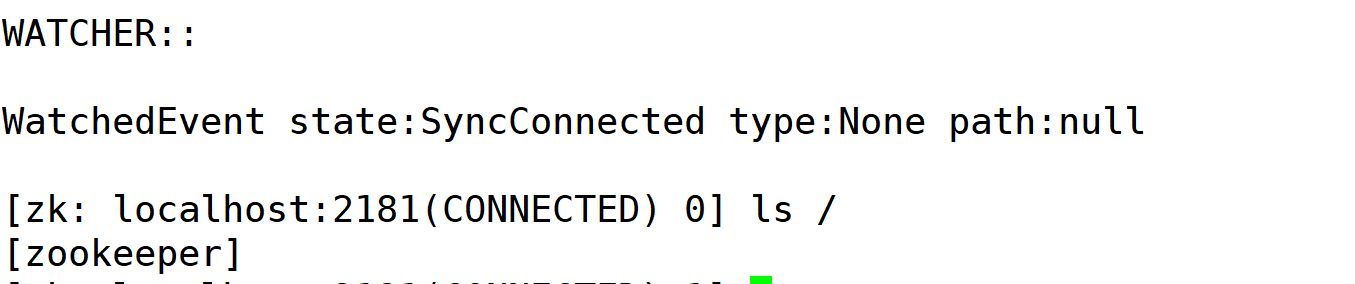

2.2.2 重点案例:配置 Python 开发环境

假设你即将开始一个使用 Scrapy 的网络爬虫项目。下面是如何在你的机器上为这个项目配置开发环境的步骤:

-

安装 Python:前往 Python 官网下载并安装最新版本的 Python。安装完成后,在终端运行

python --version来确认安装成功。 -

创建虚拟环境:在项目目录中,打开终端并运行以下命令来创建一个虚拟环境:

python -m venv scrapy_env -

激活虚拟环境:创建完成后,激活虚拟环境:

- Windows:

scrapy_env\Scripts\activate - macOS/Linux:

source scrapy_env/bin/activate

- Windows:

-

安装 Scrapy:虚拟环境激活后,使用 pip 安装 Scrapy:

pip install scrapy

2.2.3 拓展案例 1:为 BeautifulSoup 和 Requests 配置环境

如果你的项目主要涉及到静态网页的数据抓取,使用 BeautifulSoup 和 Requests 是一个轻量级且高效的选择。按照上述类似的步骤,创建并激活一个虚拟环境,然后安装这两个库:

pip install beautifulsoup4 requests

2.2.4 拓展案例 2:配置带有 Selenium 的环境

对于需要与网页进行交互的复杂爬虫项目,Selenium 是一个不可或缺的工具。除了安装 Selenium 包之外,还需要下载对应的 WebDriver:

-

安装 Selenium:

pip install selenium -

下载 WebDriver:根据你使用的浏览器(如 Chrome、Firefox),从对应的官方网站下载 WebDriver,并确保它的路径被添加到系统的 PATH 环境变量中。

通过这些步骤,你可以为几乎任何类型的网络爬虫项目配置合适的开发环境。记住,花时间在开始前配置好开发环境,可以在后续的开发过程中节省大量的时间和精力。

2.3 理解目标网站的结构

在你派出爬虫之前,深入理解目标网站的结构是至关重要的。这不仅有助于你高效地定位和提取数据,还可以确保你的爬虫行为尽可能地模仿正常用户,避免给网站造成不必要的负担。

2.3.1 重点基础知识讲解

- HTML 结构:网页基本上是由 HTML(超文本标记语言)构成的,它定义了网页的结构。通过

<div>、<span>、<a>等标签,网页内容被组织成易于浏览的格式。 - CSS 选择器:CSS(层叠样式表)用于设置网页的布局和样式。CSS 选择器可以用来定位 HTML 文档中的元素,非常适合在爬虫中使用来精确提取信息。

- JavaScript 动态加载:许多现代网站使用 JavaScript 来动态加载内容。理解这一点对于爬取那些不是立即可用的数据至关重要。

- 开发者工具:现代浏览器提供的开发者工具可以让你检查网页的 HTML 和 CSS 源码,观察网络请求,以及查看由 JavaScript 动态生成的内容。

2.3.2 重点案例:分析新闻网站的结构

假设你的任务是从一个新闻网站上抓取最新的新闻标题和链接。首先,使用浏览器的开发者工具来检查新闻标题的 HTML 结构。一般来说,新闻标题可能被包裹在 <h2> 或 <a> 标签内,并且类名中可能包含 “title” 或 “headline” 等词。

import requests

from bs4 import BeautifulSoup

url = 'https://news.example.com'

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

for headline in soup.select('.news-title > a'):

title = headline.text

link = headline['href']

print(f"标题: {title}, 链接: {link}")

2.3.3 拓展案例 1:提取电商网站的产品信息

电商网站通常包含大量的产品信息。假设你想提取某个电商平台上的产品名称、价格和描述。首先,你需要分析产品页面的 HTML 结构,找到包含这些信息的标签和它们的类名或 ID。

import requests

from bs4 import BeautifulSoup

url = 'https://ecommerce.example.com/product-page'

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

product_name = soup.find('h1', class_='product-name').text

product_price = soup.find('span', class_='product-price').text

product_description = soup.find('div', class_='product-description').text

print(f"产品名称: {product_name}, 价格: {product_price}, 描述: {product_description}")

2.3.4 拓展案例 2:爬取动态加载的评论内容

许多网站使用 AJAX 技术动态加载评论等内容。在这种情况下,你可能需要使用 Selenium 来模拟浏览器行为,等待内容加载后再进行抓取。

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

driver = webdriver.Chrome()

driver.get('https://dynamic-content.example.com')

# 等待评论区域加载完成

comments = WebDriverWait(driver, 10).until(

EC.presence_of_element_located((By.ID, "comments"))

)

for comment in comments.find_elements_by_class_name('comment'):

print(comment.text)

driver.quit()

通过这些案例,我们可以看到,无论是处理静态页面还是动态内容,理解目标网站的结构对于设计有效且高效的爬虫至关重要。使用正确的工具和方法,可以使得数据抓取任务变得更加简单和直接。