引言

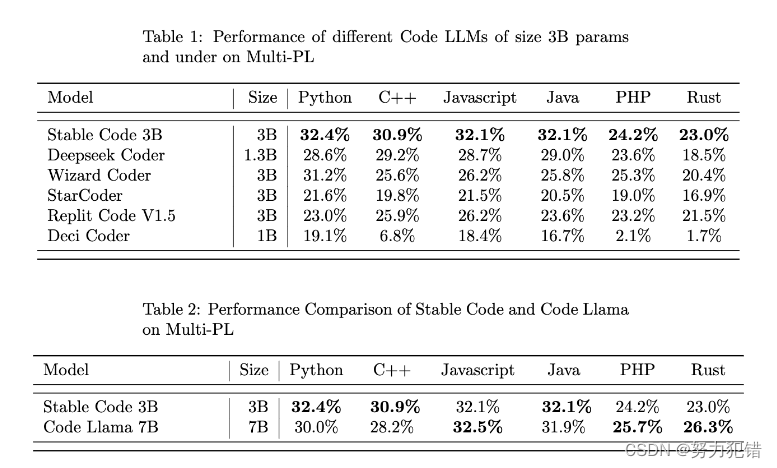

Stability AI近期发布了Stable Code 3B,这是一个集中了多项创新技术的轻量级编程辅助模型。它在保持轻量的同时,展现出了与大型模型如CodeLLaMA 7B相媲美的性能,这一特性使其在没有GPU的环境中也能运行,极大地拓宽了其应用范围。

模型概述

Stable Code 3B,作为一款拥有30亿参数的编程辅助模型,其核心在于能够在笔记本电脑上本地运行,无需专用的GPU支持。这一特性不仅降低了使用门槛,也为开发者提供了更大的灵活性。相比起CodeLLaMA 7B等大型模型,Stable Code 3B在体积上缩减了60%,但在多种编程任务上却展现出了可比拟的性能。

-

Huggingface模型下载:https://huggingface.co/stabilityai/stable-code-3b

-

AI快站模型免费加速下载:https://aifasthub.com/models/stabilityai/stable-code-3b

技术细节

Stable Code 3B的训练过程中采用了先进的技术和策略。模型基于Stable LM 3B训练而成,其中Stable LM 3B的训练token数量高达4万亿。此外,Stable Code专门使用了软件工程中的特定数据进行训练,使其在处理编程相关任务时更为精准有效。

在模型架构方面,Stable Code 3B采用了纯解码器的transformer架构,类似于LLaMA架构,但进行了一些关键的调整。例如,位置嵌入中的旋转位置嵌入被应用于头嵌入维度的前25%,以提高吞吐量;同时还采用了GPTNeoX Tokenizer的改进版本来训练FIM(Fill in the Middle)功能。

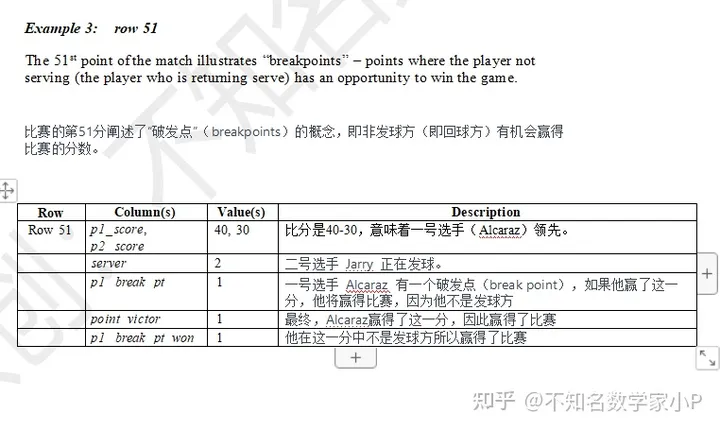

训练与性能

Stable Code 3B的训练集由多个开源大规模数据集组成,如Falcon RefinedWeb、CommitPackFT等。训练过程在Stability AI的集群上,使用了256个NVIDIA A100 40GB GPU。其采用了gpt-neox的分支进行训练,并结合了flash-attention、SwiGLU等技术。

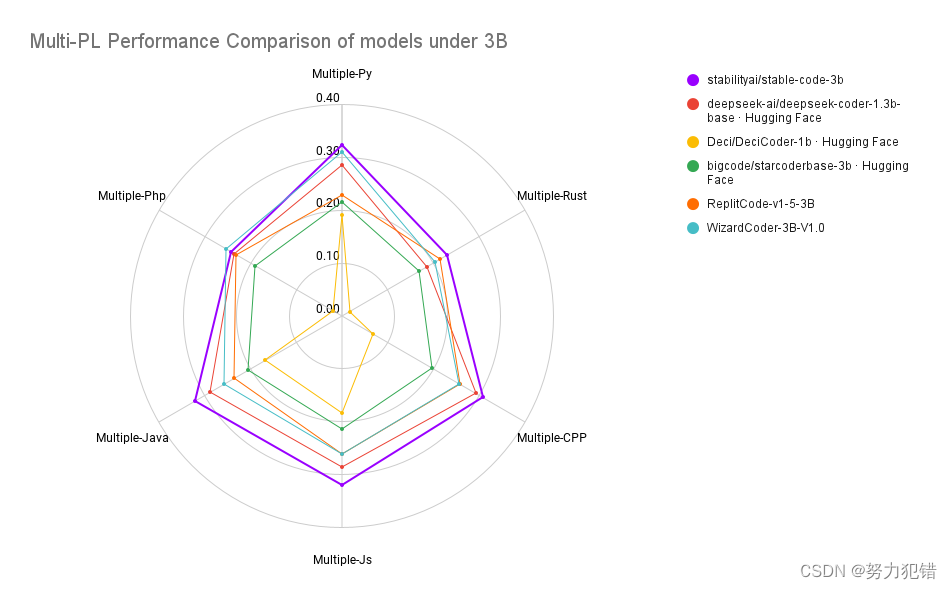

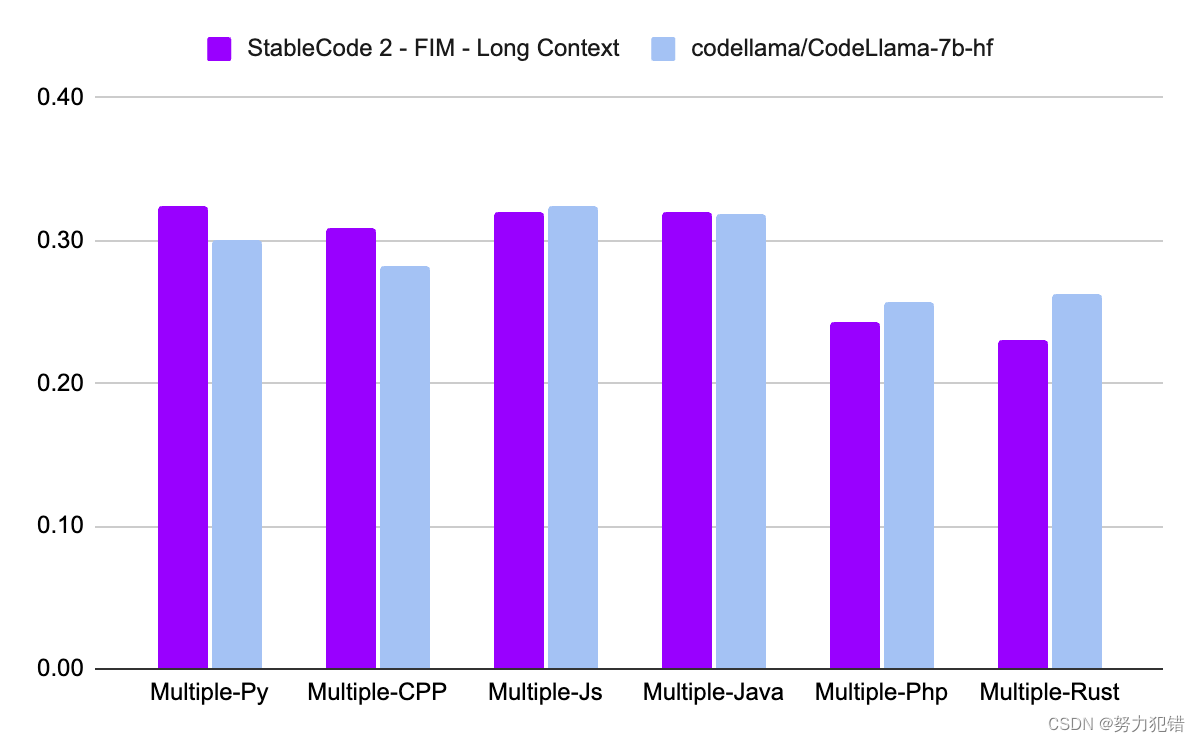

在性能方面,Stable Code 3B在MultiPL-E基准上取得了SOTA的性能,尤其在Python、C++、JavaScript等多种编程语言上展现了其卓越性。这一性能表现得益于其训练过程中采用的创新技术和优化策略。

结论

Stable Code 3B的推出无疑是编程辅助领域的一个重大突破。它不仅在轻量级设计上取得了成功,还在性能上与大型模型匹敌。对于开发者而言,这意味着即便在资源受限的环境中,也能享受到高效、便捷的编程辅助服务。Stable Code 3B的推出,预示着轻量级模型在AI领域的崛起,为未来的发展趋势奠定了坚实的基础。

模型下载

Huggingface模型下载

https://huggingface.co/stabilityai/stable-code-3b

AI快站模型免费加速下载

https://aifasthub.com/models/stabilityai/stable-code-3b