- B站:啥都会一点的研究生

- 公众号:啥都会一点的研究生

回顾2023年,计算机视觉领域有哪些较为突出的研究成果?一起看看吧

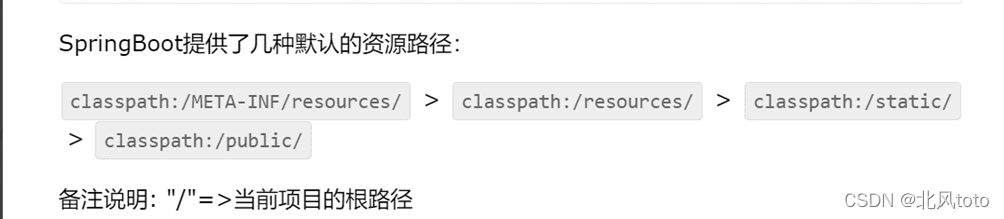

SAM(Segment Anything Model)

SAM 由 Meta AI 开发,是 CV 中分割任务的基础模型,彻底改变了像素级分类,几乎可以分割图像中的任何内容。这一发展为各种数据集的复杂分割任务开辟了新的途径

SAM可根据输入提示(如点或方框)生成高质量的对象遮罩,并可用于为图像中的所有对象生成遮罩。该模型已在一个包含 1100 万张图像和 11 亿个遮罩的数据集上进行过训练,在各种分割任务中都具有很强的零误差性能,放眼2023毫无疑问是top级进展

https://github.com/facebookresearch/segment-anything

Multimodal Large Language Models (LLMs)

像 GPT-4 这样的模型在文本和视觉数据之间架起了桥梁,为人工智能提供了理解和解释复杂的多模态输入的能力。它们在增强人工智能处理文本和视觉线索并对其做出反应的能力方面发挥了至关重要的作用,从而带来了更复杂的人工智能应用

https://openai.com/research/gpt-4

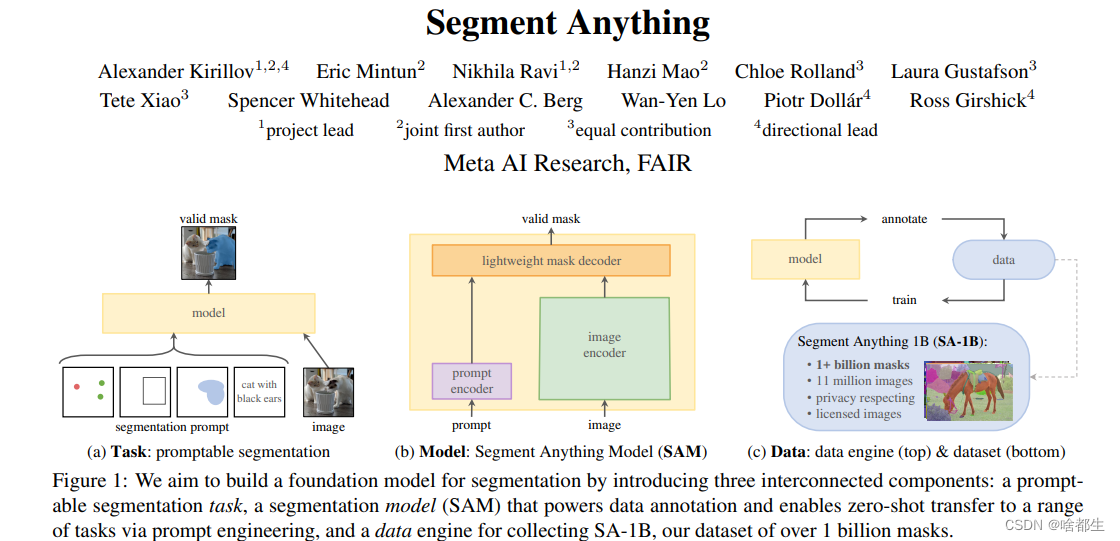

YOLOv8

YOLO 系列的这一升级版以其更快的速度和更高的精度为物体检测设定了新标准。是一款最先进的 (SOTA) 模型,它在以往 YOLO 版本成功的基础上引入了新的功能和改进,进一步提高了性能和灵活性。YOLOv8 设计快速、准确、易用,是各种物体检测和跟踪、实例分割、图像分类和姿态估计任务的绝佳选择

https://github.com/ultralytics/ultralytics

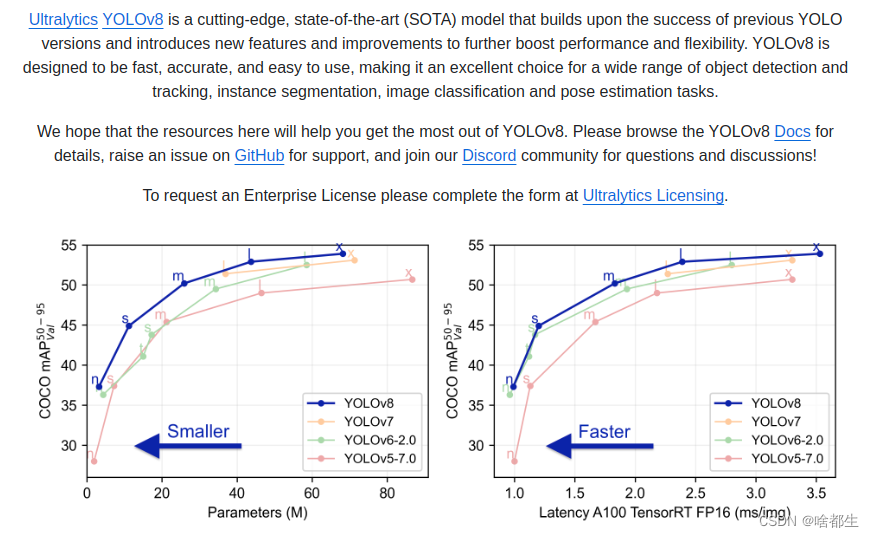

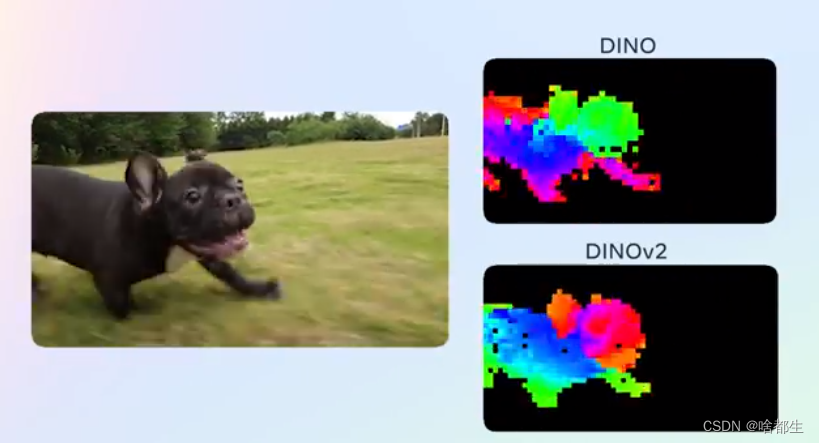

DINOv2(Self-supervised Learning Model)

DINOv2 标志着 CV 在自监督学习方面迈出了重要一步,通过减少对大型注释数据集的依赖,DINOv2 展示了自监督方法的潜力,可以用较少的标注图像训练出高质量的模型

https://ai.meta.com/blog/dino-v2-computer-vision-self-supervised-learning/

Text-to-Image (T2I) Models

涉及这方面的模型有很多

- Midjourney creations (https://aituts.com/midjourney-versions/)

- DALL-E 3 (https://openai.com/dall-e-3)

- Stable Diffusion XL (https://stablediffusionxl.com/)

- Imagen 2 (https://deepmind.google/technologies/imagen-2/)

- …

这些研究极大地提高了人工智能根据文字描述生成图像的质量和逼真度,促进了数字艺术生成等创造性应用,使人工智能成为艺术家和设计师的宝贵工具

LoRA for CV

LoRA 最初是为微调大型语言模型而开发的,后来在 CV 中找到了新的应用。提供了一种灵活高效的方法,可针对特定任务调整现有模型,大大提高了 CV 模型的通用性

https://huggingface.co/blog/lcm_lora

Ego-Exo4D Dataset

Meta 提供的 Ego-Exo4D 数据集代表了视频学习和多模态感知方面的重大进步,提供了丰富的第一人称和第三人称镜头,可以为人类活动识别和其他应用开发更复杂的模型

https://ai.meta.com/blog/ego-exo4d-video-learning-perception/

Text-to-Video (T2V) Models

T2V 模型如

- Runway (https://runwayml.com/)

- Pika Labs (https://pika.art/)

- Emu Video (https://emu-video.metademolab.com/)

通过文本描述创建高质量视频,为人工智能生成内容带来了新的维度。这一创新为娱乐和教育等领域提供了可能性,因为在这些领域动态视觉内容至关重要

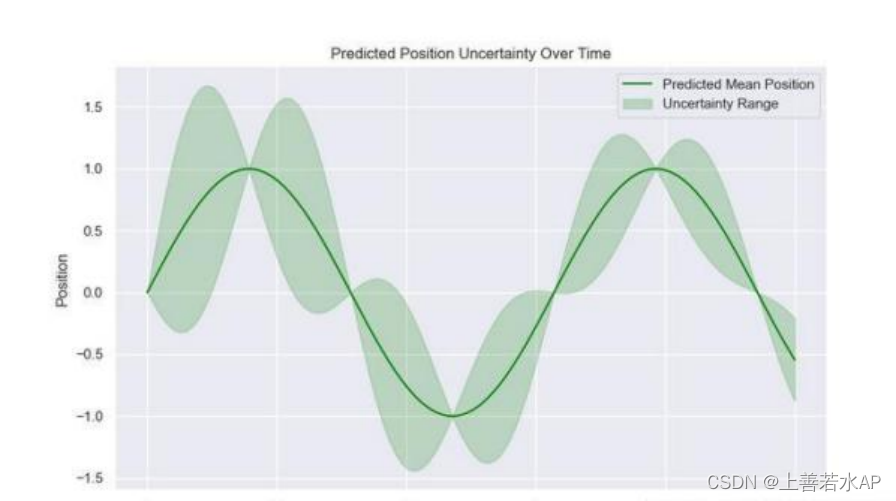

Gaussian Splatting for View Synthesis

这项技术代表了视图合成领域的一种新方法,与神经辐射场(NeRFs)等现有方法相比,它在训练时间、延迟和准确性等方面都有所改进,从而重塑了三维渲染的格局

3D Gaussian Splatting 是《3D Gaussian Splatting for Real-Time Radiance Field Rendering》一书中描述的一种光栅化技术,可实时渲染从小图像样本中学习的逼真场景

https://huggingface.co/blog/gaussian-splatting

https://huggingface.co/papers/2308.04079

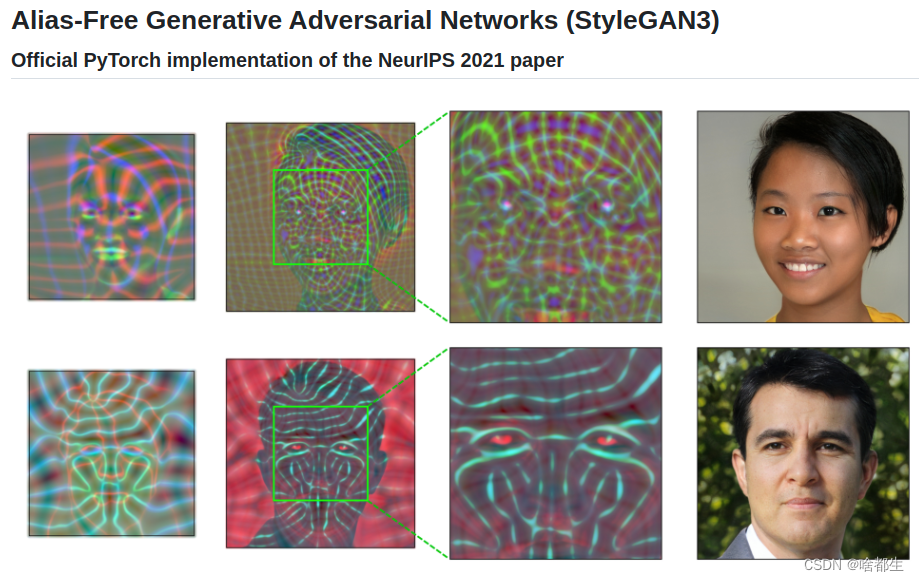

StyleGAN3

StyleGAN3 突破了生成模型的界限,尤其是在创建超逼真图像和视频方面。这一进步拓展了生成模型在创建精细逼真的数字艺术和动画方面的能力

https://github.com/NVlabs/stylegan3

以上就是本期的全部内容,更多文字总结可关注公粽号【啥都会一点的研究生】,我是啥都生,下次再见