网络上大部分关于clip-as-service的描述都是关于它如何使用,基于它的编码功能上去计算文本相似度,根据文字推荐图片等等,只有作者的创作思路里面提及通信架构的设计。

作者博客:

链接: link

如何解决多个客户端同时请求服务端的场景?比如现在小白和小黑同时想获取文本线上推理服务。如果小白先来并且需求巨大,比如每秒发送1W条文本数据。此时服务端分配了四个worker,也就是说有四个工人工作。服务端将工作并行化为四个子任务,分别交给四个工人来完成。这时候小黑来了,小黑每秒只发送一条文本。这时候因为服务端还在处理小白的任务,所以小黑只能等了。其实有点像操作系统里面的任务调度策略。从用户体验的角度来说我们希望小任务的小黑能很快得到满足。因为任务量大,所以需要等待更长的时间这是合乎常理的,也是用户可接受的。而任务量小却要等待很长时间则会让用户体验极差。

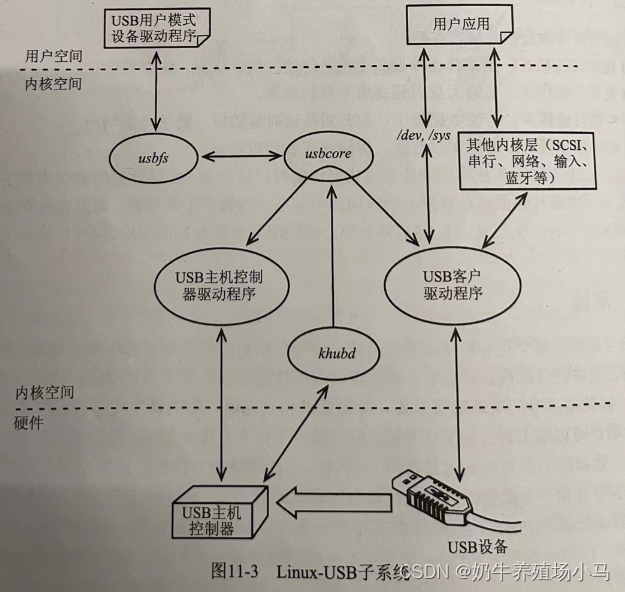

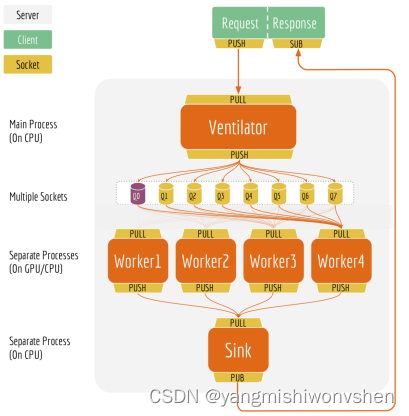

下面看看bert-as-service项目如何解决这个问题。当服务端收到多个客户端的请求后,主要通过ventilator组件来进行批处理调度和负载均衡。当收到多个客户端请求后,ventilator首先会将这些请求划分成多个小任务,然后将这些小任务分别发送给工人们。工人们收到这些小任务后开始工作,工作内容就是使用bert进行预测,预测完之后会将结果统一发送给sink组件。sink组件会将所有工人的预测结果统一装配,同时检查ventilator组件中各个客户端请求的完整性,如果某个客户端请求的数据已经全部预测完成了,那么就返回预测结果给对应的客户端完成本次请求。通过这种方式,可以轻松解决上面小任务调度体验问题。下面是服务端和客户端通信架构图:

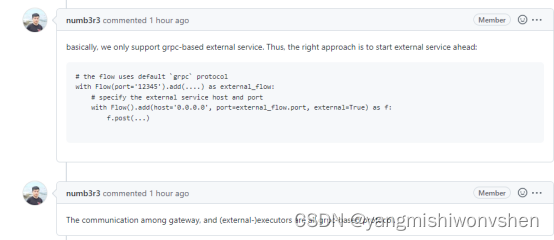

后来在github上面问他们哪里可以学习通信架构设计部分的代码(他们团队真的很赞,回复问题都特别及时),他们回复我

所以接下来打算看网上对于jina的逻辑是否有相关介绍,并看jina的官方文档及代码

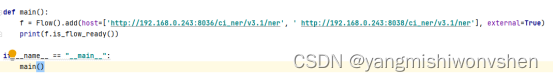

看flow的过程中,有一个地方和我的需求貌似有一些联系,如下

代码如下

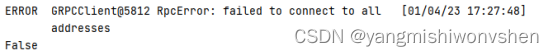

但在实际执行的过程中报如下错误

在github上询问相关人员,他们的答复是jina现在只支持基于grpc的协议,网关和(外部)执行器之间的通信都是基于grpc的协议

那这种思路就行不通,官方文档中说流将执行器编排到处理管道中以完成任务。 文档“流”通过管道,并由执行程序处理。可以将 Flow 视为配置和启动微服务架构的接口, 而繁重的工作是由服务本身完成的。 特别是,每个流还会启动一个网关服务,该服务可以通过您定义的 API 公开所有其他服务。

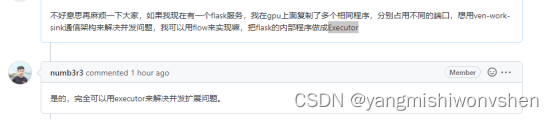

于是我想按官方文档的描述,把flask接口嵌入到Executor中,然后再使用flow加载生成grbc接口,那这样最终我们能提供的就是基于grbc协议的服务,我不知道新的思路是否能实现,就又去问他们的工作人员,他们说是可以的

现在我对其中executor和flow的具体细节、grbc协议的使用方式还没有看太懂,所以接下来我打算再研究一下官方文档,看他到底是怎样实现并发扩展的。

关于clip通信架构设计的调研

news2026/2/15 5:27:41

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.coloradmin.cn/o/142581.html

如若内容造成侵权/违法违规/事实不符,请联系多彩编程网进行投诉反馈,一经查实,立即删除!相关文章

STS4中MVC项目中把log4j从1.x升级到2.x中遇到的两个问题

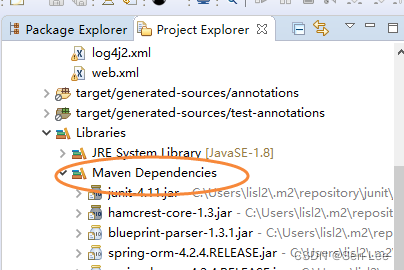

文章目录问题一 升级后看Maven Dependencies中还是有依赖1.x的log4j问题二 web.xml配置不对项目原来的log4j版本是1.2.14,有漏洞需要升级到2.18.0.问题一 升级后看Maven Dependencies中还是有依赖1.x的log4j

原因是有关联依赖, 项目中别的jar库有依赖低…

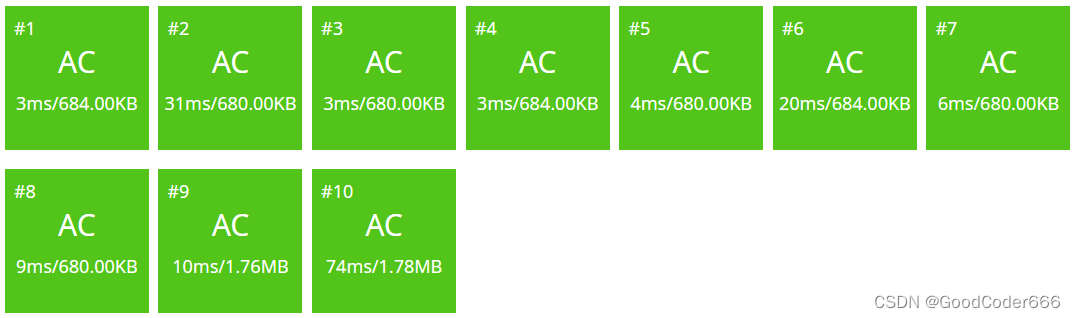

【算法笔记】【专题】RMQ 问题:ST表/树状数组/线段树

0. 前言

好久没更算法笔记专栏了,正好学了新算法来更新…… 这也是本专栏的第一个专题问题,涉及到三种数据结构,如果写得有问题请各位大佬多多指教,谢谢!

1. 关于 RMQ 问题

RMQ 的全称是 Range Minimum/Maximum Que…

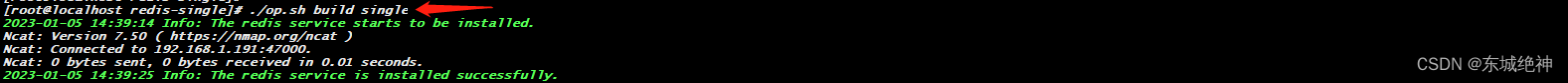

《Linux运维实战:Centos7.6基于docker-compose一键离线部署单节点redis6.2.8 》

一、部署背景 由于业务系统的特殊性,我们需要面向不通的客户安装我们的业务系统,而作为基础组件中的redis针对不同的客户环境需要多次部署,作为一个运维工程师,提升工作效率也是工作中的重要一环。所以我觉得有必要针对redis6.2.8…

使用 .NET 标记游戏地图关键坐标点

本文以天涯明月刀 OL 游戏的云上之城探索玩法为例,介绍如何使用 .NET 在游戏地图中标记大量关键坐标点。 1. 背景

大概很多程序员都是喜欢玩游戏的吧,我也不例外。我们经常会看到电视剧中的各路游戏大神,要么是有只有他一个人会的骚操作&…

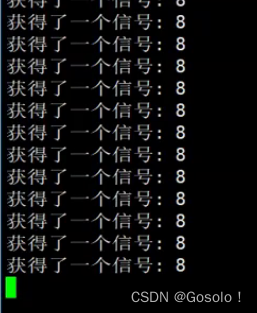

Linux--信号--信号的产生方式--核心转储--0104

1. 什么是信号

生活中的信号:红绿灯,狼烟,撤退、集合...。

我们认识这些信号,首先是因为自己记住了对应场景下的信号后续需要执行的动作。如果信号没有产生,我们依旧知道如何处理这个信号。收到信号,我们…

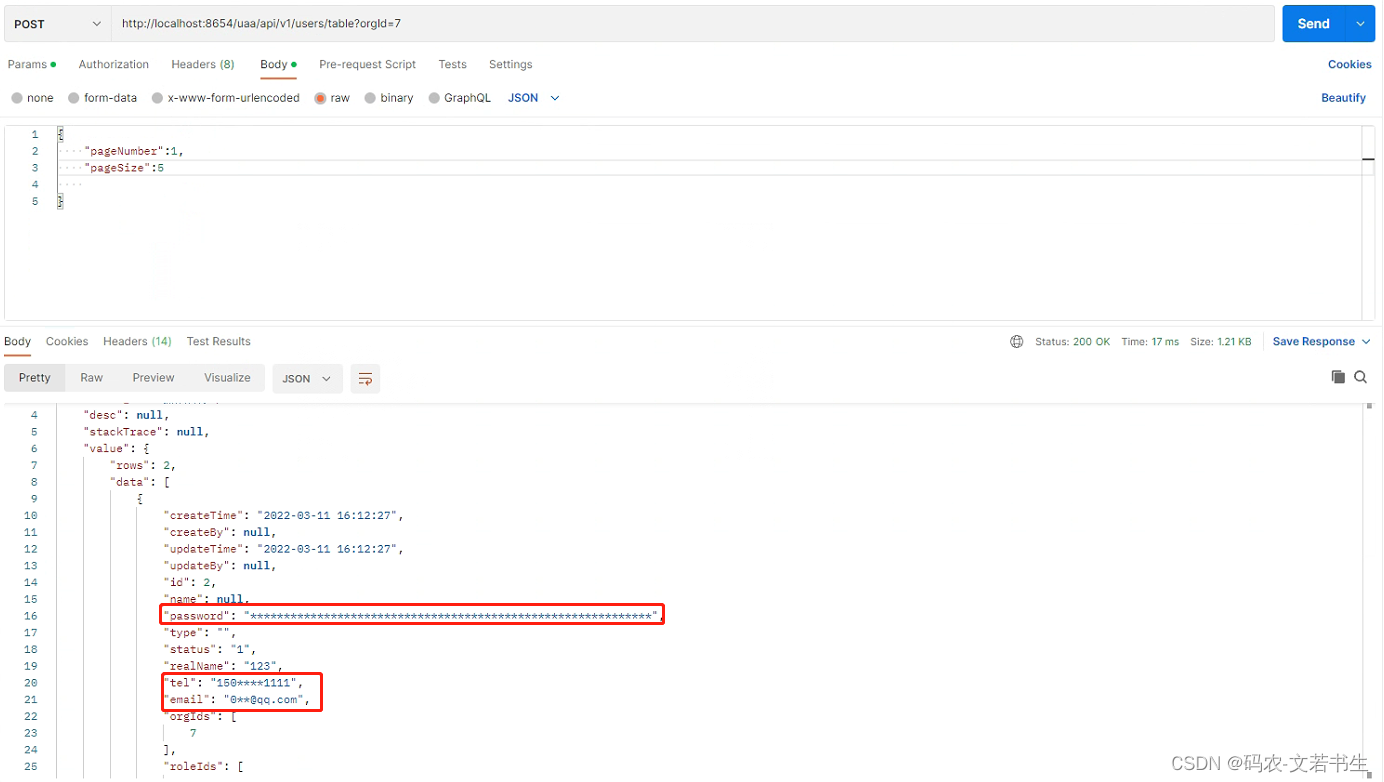

springboot学习(七十八) springboot中通过自定义注解实现数据脱敏的功能

文章目录前言一、引入hutools工具类二、定义常用需要脱敏的数据类型的枚举三、定义脱敏方式枚举四、自定义脱敏的注解五、自定义Jackson的序列化方式六、使用七、脱敏效果前言

对于某些接口返回的信息,涉及到敏感数据的必须进行脱敏操作,例如银行卡号、…

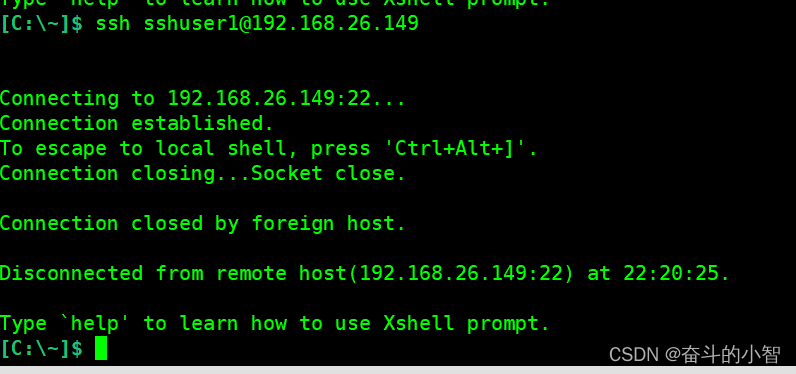

带你了解ssh服务过程

远程连接服务

1、什么是远程连接服务器

远程连接服务器通过文字或图形接口方式来远程登录系统,让你在远程终端前登录linux主机以取得可操作主机接口(shell),而登录后的操作感觉就像是坐在系统前面一样。

2、远程连接服务器的功…

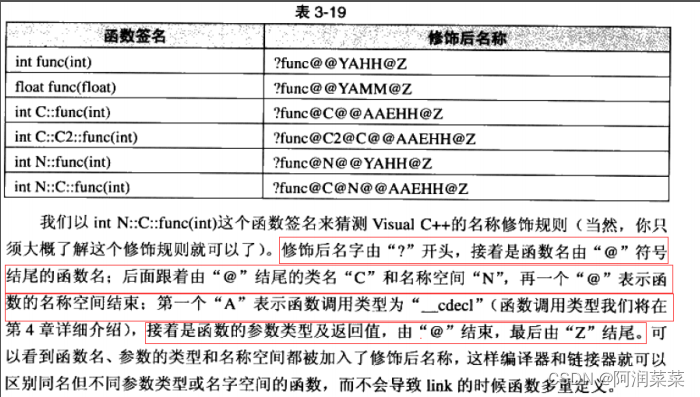

【C++】函数重载的使用及原理

概述 在学校里,我们都会有班里同学被起外号的经历,而且同一个人可能还会有好几个外号。 在自然语言中,一个词可以有多重含义,人们可以通过上下文来判断该词真实的含义,即该词被重载了。 目录

概述

什么是函数重载 …

项目管理:如何制作项目进度计划表?

项目进度管理是根据项目目标,编制合理的进度计划,并在项目推进过程中随时检查项目执行情况。 项目进度管理的目的就是为了实现最优工期,多快好省地完成任务。

而甘特图,就是用表格图形的方式来展示项目的进展,是一个比…

赛狐ERP:优秀的亚马逊运营具备的五项能力!

我们都知道,亚马逊运营是整个店铺的主导,很大程度上会影响着一个店铺经营的好坏,那么一个好的亚马逊运营,应该具备哪些能力呢?今天赛狐ERP就来给和大家聊一聊,希望对各位亚马逊运营们会有启发!1…

ORB-SLAM2 --- LocalMapping::Run 局部建图线程解析

目录

一、线程作用

二、局部建图线程主要流程

三、局部建图线程主函数

四、调用函数解析

4.1 设置"允许接受关键帧"的状态标志LocalMapping::SetAcceptKeyFrames函数解析

4.2 查看列表中是否有等待被插入的关键帧LocalMapping::CheckNewKeyFrames函数

4.3 …

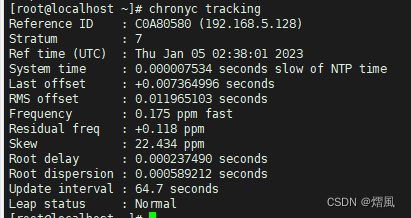

十分钟学会在linux上部署chrony服务器(再见 NTP,是时候拥抱下一代时间同步服务 Chrony 了)

chrony服务器

Chrony 相较于 NTPD 服务的优势

安装与配置(Chrony的配置文件是/etc/chrony.conf)

同步网络时间服务器

设置开机启动,重启服务

chronyc sources 输出结果解析

练习 实验模型图如下

实验a如下

实验b如下 再见 NTP&#x…

中国手机市场全面衰退,连苹果也未能幸免,大跌近三成

CINNO公布了11月份国内手机市场的数据,数据显示2022年11月份中国市场的手机出货量同比下滑21.7%,在整体大环境出现销量下滑的情况下,此前曾持续逆势增长的苹果也顶不住了,苹果在中国市场的出货量也出现了下滑的势头。数据显示2022…

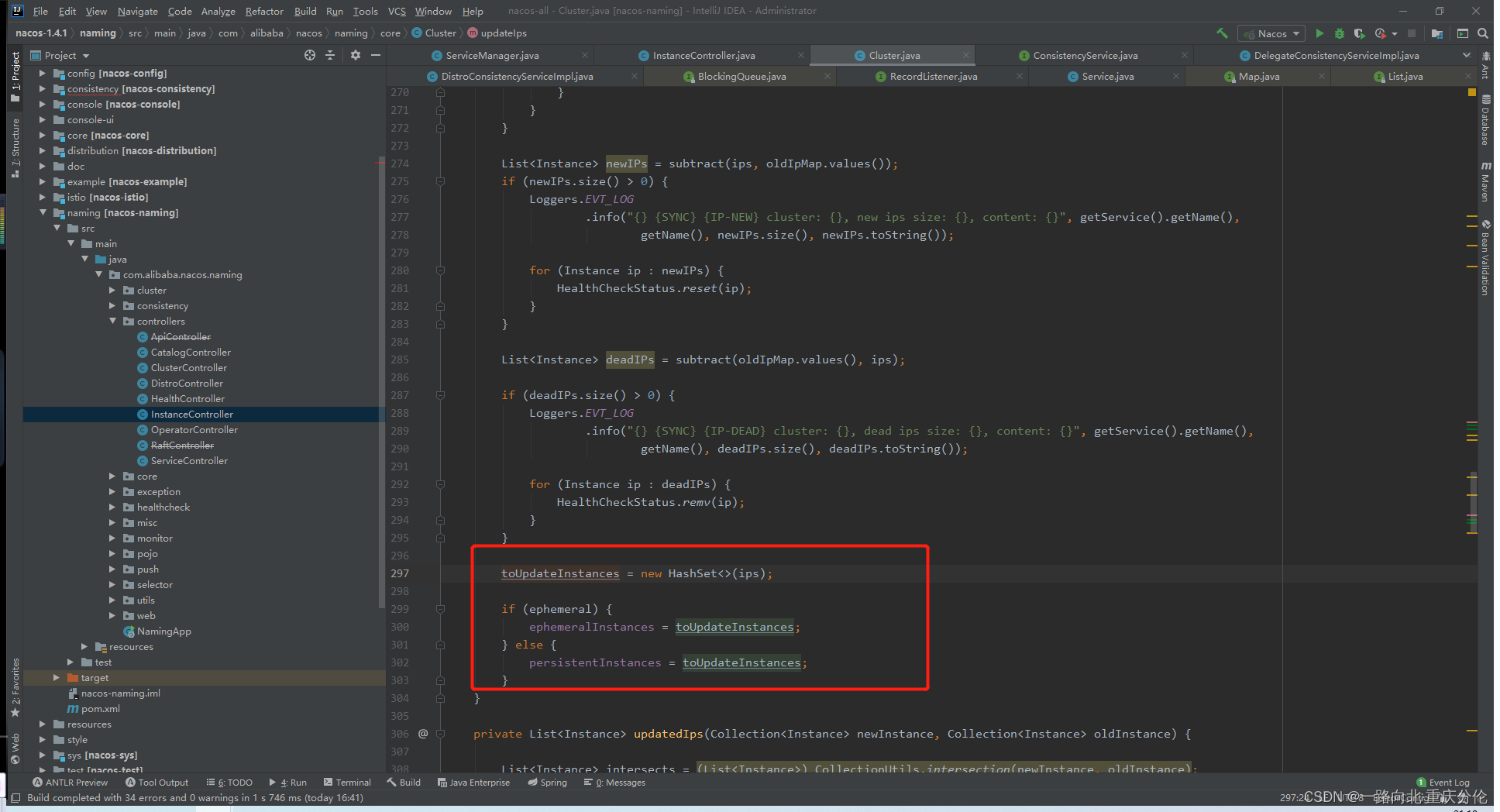

06-Alibaba Nacos注册中心源码剖析

Nacos&Ribbon&Feign核心微服务架构图 架构原理 1、微服务系统在启动时将自己注册到服务注册中心,同时外发布 Http 接口供其它系统调用(一般都是基于SpringMVC) 2、服务消费者基于 Feign 调用服务提供者对外发布的接口,先对调用的本地接口加上注…

JS继承有哪些,你能否手写其中一两种呢?

引言

JS系列暂定 27 篇,从基础,到原型,到异步,到设计模式,到架构模式等,

本篇是 JS系列中第 3 篇,文章主讲 JS 继承,包括原型链继承、构造函数继承、组合继承、寄生组合继承、原型…

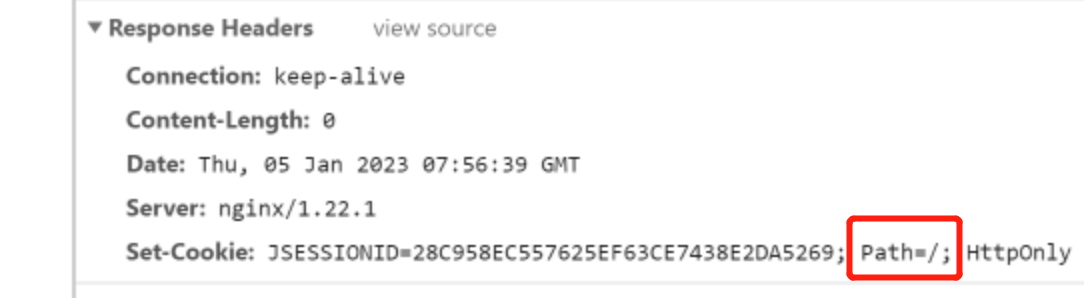

前端vue项目发送请求不携带cookie(vue.config.js和nginx反向代理)

一、本地环境——使用vue.config.js配置了跨域代理本来发现问题,是因为后台记录到接收到的sessionId一直在变化,导致需要在同一个sessionId下处理的逻辑无法实现。一开始以为是前后端分离跨域导致的,网上给出了解决方案:main.js中…

看完这篇文章终于弄明白了什么是 RocketMQ 的存储模型

RocketMQ 优异的性能表现,必然绕不开其优秀的存储模型 。这篇文章,笔者按照自己的理解 , 尝试分析 RocketMQ 的存储模型,希望对大家有所启发。1 整体概览首先温习下 RocketMQ 架构。整体架构中包含四种角色 :Producer :消息发布的…

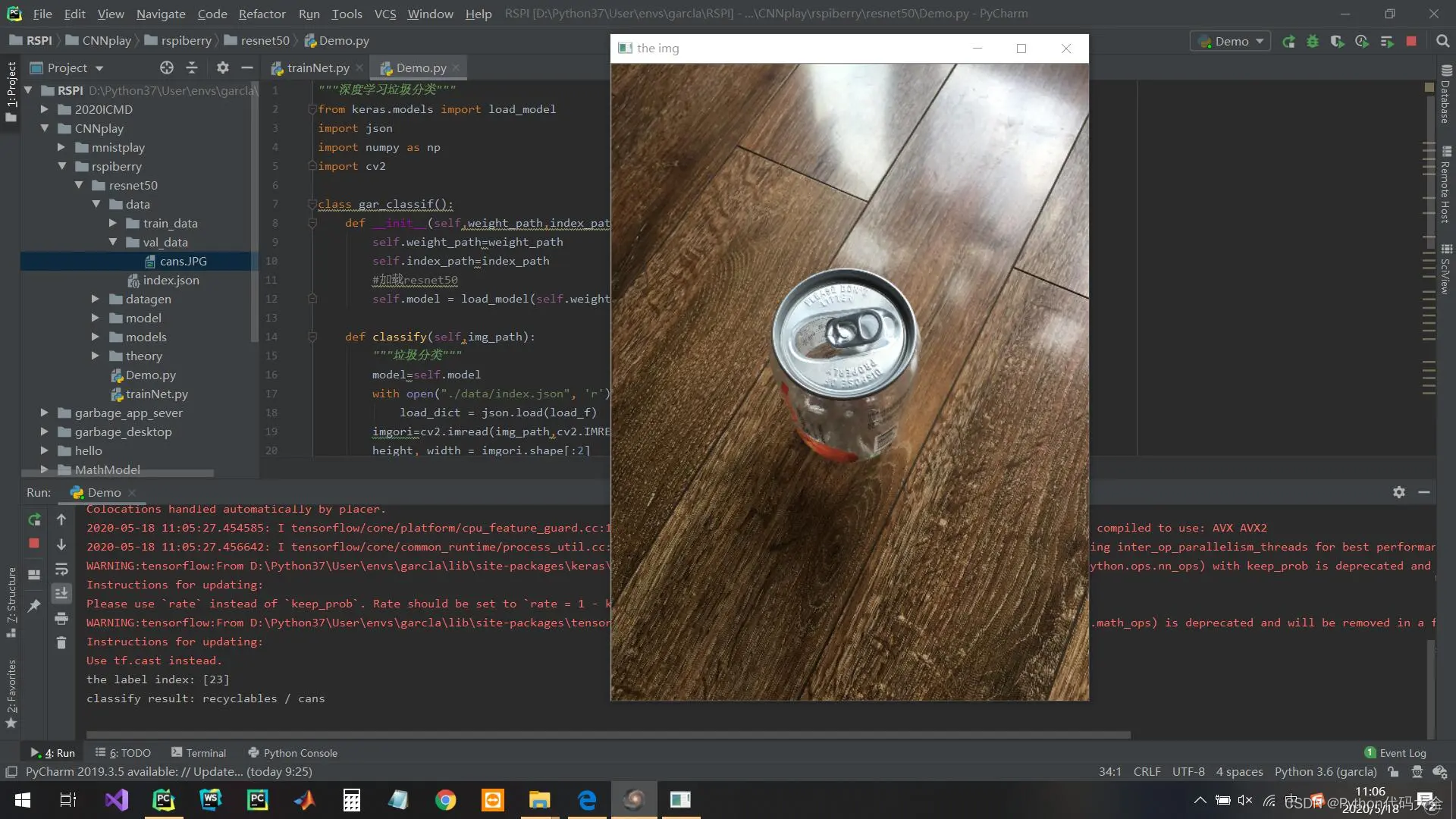

基于Python深度学习的垃圾分类代码,用深度残差网络构建

垃圾分类

完整代码下载地址:基于Python深度学习的垃圾分类代码

介绍

这是一个基于深度学习的垃圾分类小工程,用深度残差网络构建

软件架构

使用深度残差网络resnet50作为基石,在后续添加需要的层以适应不同的分类任务模型的训练需要用生…