刷题专栏:http://t.csdnimg.cn/gvB6r

Java 是一种广泛使用的面向对象编程语言,在软件开发领域有着重要的地位。Java 提供了丰富的库和强大的特性,适用于多种应用场景,包括企业应用、移动应用、嵌入式系统等。

以下是几个面试技巧:

深入理解核心概念:确保你对 Java 的核心概念,如对象、类、继承、多态、接口、异常处理和集合等有深入理解。你应该熟悉 Java 的基本语法和常用的类库。

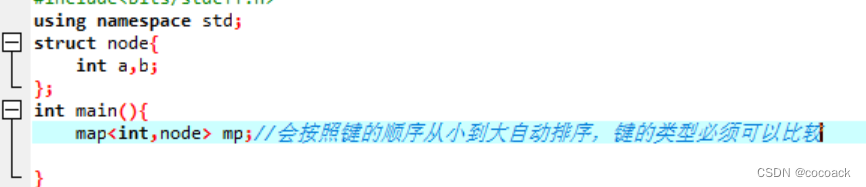

学习并掌握常见的数据结构和算法:Java 后端开发经常需要处理大量数据和高性能场景,熟悉常见的数据结构和算法对于解决问题至关重要。例如,了解链表、栈、队列、二叉树、哈希表、排序和搜索算法等。

深入了解数据库知识:在后端开发中,与数据库交互是一个常见的任务,熟悉关系型数据库和 NoSQL 数据库的基本概念,如数据建模、事务处理、SQL 查询、索引和性能优化等,对于面试至关重要。

掌握常用的开发框架和工具:熟悉主流的 Java 后端开发框架和工具,如 Spring、Spring Boot、Hibernate、MyBatis、RESTful API 设计、Maven/Gradle 构建工具等。了解它们的原理和使用方法,并能够用它们构建和优化应用程序。

基本的系统设计和架构知识:在面试过程中,可能会涉及到对系统设计和架构的问题,例如如何设计一个高可用性、高性能或可扩展的应用程序。了解分布式系统、负载均衡、缓存、消息队列、微服务等相关概念和常用的设计模式。

解决问题的能力:面试官通常会提出一些问题和编程挑战,用于测试你的问题解决能力和编程技巧。在准备过程中,多练习编程问题和算法题,提高解题能力和思维灵活性。学会如何分析问题并提供合理的解决方案。

强调实践经验:准备面试时,准备几个自己做过的项目或经验,介绍你在项目中所做的工作和遇到的挑战。强调你的实际经验和在项目中的贡献,这将有助于展示你的技能和能力。

学会提问和沟通:在面试过程中,面试官通常会邀请你提问。准备一些针对公司和工作的相关问题,以显示你对公司和职位的真实兴趣和主动性。同时,要注意与面试官保持良好的沟通和表达能力,清晰地回答问题。

最重要的是保持自信和冷静。提前准备,并对自己的知识和经验有自信,这样您就能在面试中展现出最佳的表现。祝您面试顺利!

目录

一、从简历项⽬中选⼀个项⽬,说说你在其中遇到了什么重⼤挑战?以及你的解决问题的思路?

二、⼀段代码要执⾏多个redis命令,不加锁的情况下如何保证原⼦性?

三、谈谈数据结构,⽐如⼆叉树、红⿊树?

四、说说B-tree 、B+tree的区别和使⽤场景

五、mysql哪个版本哪个存储引擎的索引使⽤的B+tree,为什么不使⽤红⿊树

六、⼏种常⻅的消息中间件的区别

七、rabbitmq如何保证消息的可靠性

八、springcloud服务发现原理

九、介绍下springcloud各个组件?springcloud的注册中⼼除了eureka还可以⽤什么?

十、微服务有⼏种限流⽅式

十一、限流的情况下,服务隔离还有没有必要

十二、dubbo有⼏种负载均衡?负载均衡是在服务端还是客户端

十三、如何实现redis分布式锁?需要注意什么问题?

十四、说说你看过的源码?其中⽤到了什么设计模式或者设计亮点?

十五、如何实现aop?项⽬中哪些地⽅⽤到了 aop?

十六、Spring中bean后置处理器的作用

十七、spring bean作⽤域,什么时候使⽤request作⽤域

十八、说说下⾯这道题的结果

一、从简历项⽬中选⼀个项⽬,说说你在其中遇到了什么重⼤挑战?以及你的解决问题的思路?

从我的简历项目中,我选择了一个涉及大数据处理的项⽬。在这个项⽬中,我遇到了⼀个重⼤挑战:如何有效地处理和分析大规模数据集,并在有限的时间内得出有价值的结果。

这个挑战的困难主要表现在以下⼏个⽅⾯:

- 数据规模极⼤,普通的计算和存储基础设施⽆法处理。

- 需要进⾏复杂的数据清洗和整理,以消除噪音和异常值。

- 需要进⾏多维度的数据分析,从⽽得出有价值的洞见。

为了解决这个问题,我采取了以下策略:

- 使用云计算资源:我选择亚马逊的AWS云服务,通过其提供的高性能计算(HPC)和分布式存储服务,有效地扩展了计算和存储能力。这允许我们处理大规模数据集,同时保证了数据处理的速度和准确性。

- 数据预处理:我创建了一个自动化脚本,用于数据清洗和整理。这包括删除无效数据、处理缺失值、消除噪音等。通过这种方式,我们减少了数据分析时的复杂性,并提高了结果的准确性。

- 选择合适的数据分析方法:我结合了多种数据分析方法,包括描述性统计、可视化分析和机器学习等。这使我们能够从多个角度分析数据,更全面地理解数据集,并提取有价值的信息。

- 优化流程:我与团队成员密切合作,对数据处理和分析流程进行了优化。通过改进数据处理脚本、提高数据加载速度和优化分析算法,我们成功地缩短了数据处理和分析的时间。

通过实施这些策略,我成功地解决了这个挑战,并使我们的团队能够高效地处理大规模数据集,从而为我们的客户提供了更有价值的信息。这次经验教会了我如何处理复杂的大数据问题,并让我更加熟悉如何运用云计算资源进行高效的数据处理和分析。

以上回答仅供参考回答结构,要以自己实际项目为准。

二、⼀段代码要执⾏多个redis命令,不加锁的情况下如何保证原⼦性?

在不加锁的情况下,可以使用 Redis 的事务机制来保证多个 Redis 命令的原子性。Redis 的事务使用 MULTI、EXEC、WATCH 和 UNWATCH 命令来实现。

事务的基本流程如下:

- 使用 MULTI 命令开启事务。

- 执行多个 Redis 命令,这些命令会被放入一个队列中,而不是立即执行。

- 使用 EXEC 命令提交事务,Redis 会依次执行队列中的命令。

- 如果在执行事务期间有其他客户端修改了被 WATCH 命令监视的键值,事务会被标记为失败。

- 可以使用 DISCARD 命令取消事务。

在执行事务期间,其他客户端的命令请求将会被 Redis 排队等待,直到当前事务执行完毕。因此,通过使用 Redis 事务机制,可以保证多个 Redis 命令的原子性。

需要注意的是,Redis 事务并不支持回滚(Rollback)操作。如果在事务执行过程中出现错误,事务会继续执行而不会回滚已经执行的命令。因此,在使用 Redis 事务时需要特别注意异常处理和逻辑的正确性。

示例代码如下:

Jedis jedis = new Jedis("localhost", 6379); jedis.watch("key1", "key2"); // 监视被事务使用的键值 Transaction tx = jedis.multi(); // 开启事务 tx.set("key1", "value1"); tx.set("key2", "value2"); Response<String> result1 = tx.get("key1"); Response<String> result2 = tx.get("key2"); tx.exec(); // 提交事务 String value1 = result1.get(); // 获取事务内的结果 String value2 = result2.get();在这个示例中,通过 MULTI 命令开启事务,然后执行了两条 SET 命令。最后使用 EXEC 命令提交事务,并获取事务内的结果。

值得注意的是,在事务期间使用 WATCH 命令监视了 “key1” 和 “key2” 的变化。如果这两个键值在事务执行期间发生了变化,事务会被标记为失败。

通过 Redis 的事务机制,即使没有加锁,也可以保证多个 Redis 命令的原子性。

三、谈谈数据结构,⽐如⼆叉树、红⿊树?

二叉树

二叉树是一种常见的树状数据结构,每个节点最多有两个子节点。它由一组称为节点的元素组成,其中每个节点包含一个值和指向其左子节点和右子节点的引用。以下是关于二叉树的一些重要概念和特点:

- 根节点:二叉树的最顶层节点称为根节点。

- 父节点、子节点:具有连接关系的节点成对地称为父节点和子节点。每个节点可以有零、一个或两个子节点。

- 叶子节点:没有子节点的节点称为叶子节点(也称为终端节点)。

- 深度和高度:二叉树的深度是从根节点到叶子节点的最长路径上的节点数。树的高度是从根节点到最远叶子节点的路径上的边数。

- 二叉树的遍历:二叉树的遍历是指按照一定的顺序访问二叉树中的所有节点。常用的遍历方法有前序遍历、中序遍历和后序遍历。

- 前序遍历:先访问根节点,然后按照左子树-右子树的顺序递归遍历其左右子树。

- 中序遍历:先递归遍历左子树,然后访问根节点,最后递归遍历右子树。

- 后序遍历:先递归遍历左子树和右子树,然后访问根节点。

- 二叉查找树(Binary Search Tree,BST):是一种特殊的二叉树,具有以下特点:

- 对于任意节点,其左子树中的所有节点的值都小于该节点的值。

- 对于任意节点,其右子树中的所有节点的值都大于该节点的值。

- 左右子树也分别是二叉查找树。

二叉树在实际应用中有广泛的应用,例如在数据库系统中作为索引结构,算法中的树状结构,图形结构等。了解并熟练掌握二叉树的基本概念和遍历方法,对于理解和应用许多相关领域的算法和数据结构都是非常重要的。

红黑树

红黑树是一种自平衡二叉查找树,它在计算机科学中用作实现关联数组的一种数据结构。红黑树的特点是每个节点都有一个颜色属性,可以是红色或黑色,并且通过颜色属性来满足以下条件:

- 每个节点要么是红色,要么是黑色。

- 根节点是黑色的。

- 每个叶子节点(NIL 节点,空节点)是黑色的。

- 如果一个节点是红色的,则它的子节点必须是黑色的(反之不一定成立)。

- 从任一节点到其叶子节点的路径上,黑色节点的数量相同。

红黑树的插入操作遵循以下规则:

- 如果要插入的节点是红色的,则可以直接插入,因为红黑树的性质允许红色节点存在。

- 如果要插入的节点是黑色的,则需要通过一系列的旋转和颜色调整来维持红黑树的性质。

在删除操作中,红黑树同样需要进行一些调整以保持其性质。

插入或删除

当红黑树进行插入或删除操作时,可能会破坏红黑树的平衡性质。为了确保红黑树的平衡,需要进行一系列的旋转和变色操作。

插入操作:

1. 当插入新节点时,按照二叉搜索树的规则先找到插入位置,并将新节点标记为红色。

2. 如果新节点的父节点是黑色,那么插入操作完成,红黑树仍然平衡。

3. 如果新节点的父节点是红色,根据其叔节点的颜色进行相应的调整:

- 如果叔节点也是红色,将父节点和叔节点的颜色都变为黑色,将祖父节点变为红色,然后以祖父节点作为当前节点继续向上调整。

- 如果叔节点是黑色或是空节点,需进行旋转和颜色变换来调整红黑树的平衡性:

- 如果新节点是其父节点的右子节点,且父节点是祖父节点的左子节点,进行左旋操作,然后以原父节点作为当前节点进行下一步操作。

- 如果新节点是其父节点的左子节点,且父节点是祖父节点的左子节点,进行右旋操作,并将父节点和祖父节点的颜色互换。

- 如果新节点是其父节点的左子节点,且父节点是祖父节点的右子节点,进行双旋操作,即先以父节点为支点进行一次右旋操作,然后再以祖父节点为支点进行一次左旋操作,最后将原父节点和祖父节点的颜色互换。

4. 插入操作完成后,将根节点颜色设置为黑色,确保红黑树的黑色平衡。

删除操作:

1. 当删除节点时,首先根据二叉搜索树规则找到要删除的节点。

2. 如果该节点只有一个子节点或没有子节点,直接删除。

3. 如果被删除的节点有两个子节点,需要找到其后继节点(即右子树中的最小节点)来替代被删除的节点,然后删除后继节点。

4. 删除后继节点会导致红黑树的平衡性质破坏,需要进行调整:

- 如果后继节点是红色,直接删除。

- 如果后继节点是黑色,需要做进一步的调整:

- 如果后继节点的兄弟节点是红色,进行旋转和颜色调整,将情况转化为后继节点的兄弟节点是黑色的情况。

- 如果后继节点的兄弟节点是黑色,并且其两个子节点都是黑色,进行颜色调整,并以其父节点为当前节点继续调整。

- 如果后继节点的兄弟节点是黑色,并且有一个红色子节点,进行旋转和颜色调整。

5. 删除操作完成后,需要检查根节点的颜色,将其设置为黑色。

红黑树通过这些旋转和变色操作来保持整棵树的平衡,确保树高度相对较低,从而保证了红黑树的搜索、插入和删除操作的时间复杂度为 O(log n)。这使得红黑树成为一种高效的自平衡查找树,被广泛应用于各种数据结构和算法的实现中。

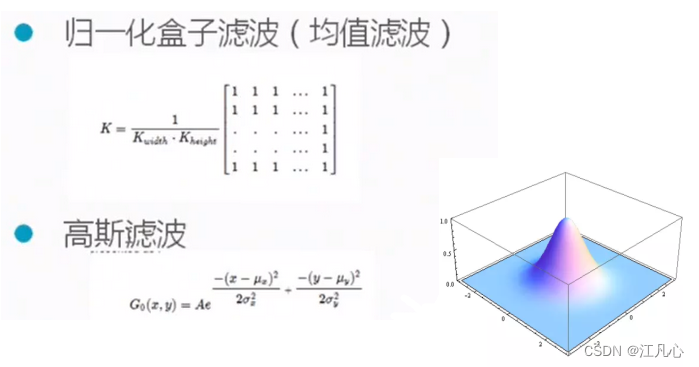

四、说说B-tree 、B+tree的区别和使⽤场景

B-tree

· B-tree 利⽤了磁盘块的特性进⾏构建的树。每个磁盘块⼀个节点,每个节点包含了很关键字。把树的节点关键字增多后树的 层级⽐原来的⼆叉树少了,减少数据查找的次数和复杂度。

· B-tree巧妙利⽤了磁盘预读原理,将⼀个节点的⼤⼩设为等于⼀个⻚(每⻚为4K),这样每个节点只需要⼀次I/O就可以完 全载⼊。

· B-tree 的数据可以存在任何节点中。

B+tree

B+tree 是 B-tree 的变种, B+tree 数据只存储在叶⼦节点中。这样在B树的基础上每个节点存储的关键字数更多,树的层级 更少所以查询数据更快,所有指关键字指针都存在叶⼦节点,所以每次查找的次数都相同所以查询速度更稳定;

五、mysql哪个版本哪个存储引擎的索引使⽤的B+tree,为什么不使⽤红⿊树

InnoDB 是 MySQL 的默认事务性存储引擎,从 MySQL 版本 5.5 开始成为默认的存储引擎。InnoDB 使用 B+ 树作为其主要索引结构,这是因为 B+ 树具有许多优点,适用于数据库系统的需求。 特别是在主键索引(聚簇索引)和辅助索引(非聚簇索引)中。B+tree索引在InnoDB中被广泛使用,因为它非常适合于磁盘I/O操作,并且能够高效地处理大量的数据查询。

至于为什么InnoDB(以及其他关系型数据库的存储引擎)选择使用B+tree而不是红黑树,以下是一些主要的原因:

磁盘友好性:B+tree的设计使其能够更好地利用磁盘预读特性。由于磁盘读写通常是以块(或页)为单位进行的,B+tree的节点设计可以容纳多个键值对,这减少了读取磁盘的次数。相比之下,红黑树的每个节点通常只存储一个键值对和一个指向子节点的指针,这可能导致更多的磁盘I/O操作。

查询效率:对于范围查询,B+tree能够提供更快的性能。因为B+tree的所有叶子节点都是通过指针相连的,这使得范围查询变得非常简单和高效。而红黑树则没有这种直接的范围查询能力。

插入和删除的性能:虽然红黑树在插入和删除时能够保持树的平衡,但B+tree通过分裂和合并节点也能在插入和删除时保持平衡,且其操作更适合于磁盘存储的特性。

空间利用率:B+tree的叶子节点存储了实际的数据或数据的指针,并且它们被紧密地组织在一起,这减少了空间浪费。红黑树的空间利用率则相对较低,因为它的节点可能分布在内存或磁盘的各个位置。

复杂性:虽然红黑树在理论上是一个优雅的数据结构,但它在实现和维护上比B+tree更复杂。对于数据库系统来说,简单性和可靠性通常是首选。

B+tree因其磁盘友好性、高效的查询性能、适合范围查询的特性以及相对简单的实现和维护而被InnoDB存储引擎采用。红黑树虽然在某些应用场景中也是一个很好的选择,但在数据库索引这个特定的领域里,B+tree被证明是更加合适的数据结构。

六、⼏种常⻅的消息中间件的区别

RabbitMQ、Kafka和ActiveMQ是三种不同的消息中间件,它们在架构设计、功能特性和适用场景上存在一些区别。

1. 架构设计:

- RabbitMQ:RabbitMQ是一个基于AMQP(高级消息队列协议)的中间件,采用的是中心式的架构模式。消息通过RabbitMQ服务器中心进行传递和路由。

- Kafka:Kafka是一个分布式流平台,采用的是发布-订阅模式的架构。消息通过Kafka集群中的多个分布式节点进行发布和订阅。

- ActiveMQ:ActiveMQ是一个基于JMS(Java消息服务)的消息中间件,采用的是中心式的架构模式,消息通过ActiveMQ服务器中心进行传递和路由。

2. 适用场景:

- RabbitMQ:适用于需要可靠消息传递和企业集成的场景。RabbitMQ支持多种消息传递协议,具有较好的稳定性和可靠性,并且支持消息的持久化。

- Kafka:适用于需要高吞吐量和低延迟的分布式数据流处理场景。Kafka能够处理大规模的数据流,特别适合日志和事件数据的收集、处理和分析。

- ActiveMQ:适用于构建复杂的消息系统和企业集成。ActiveMQ支持多种消息传递协议,并提供了广泛的功能特性,包括复杂的消息路由、消息过滤和事务支持。

3. 设计重点:

- RabbitMQ:重点在于消息传递的可靠性和稳定性,支持高级的消息路由和消息确认机制。

- Kafka:重点在于高吞吐量和低延迟的数据流处理,支持分布式存储和水平扩展。

- ActiveMQ:重点在于支持多种消息传递协议和企业集成特性,具有灵活的消息路由和消息转换功能。

4. 性能特点:

- RabbitMQ:RabbitMQ在传统的消息队列场景下表现出色,具有较好的稳定性和可靠性,适合需要可靠消息传递的场景。

- Kafka:Kafka在分布式数据流处理方面表现出色,具有高吞吐量和低延迟的特点,特别适合大规模数据流的收集、处理和分析。

- ActiveMQ:ActiveMQ在企业集成和多种消息传递协议的支持方面具有一定优势,适合复杂的消息系统和异构环境的集成。

5. 可扩展性:

- RabbitMQ:RabbitMQ支持集群部署和高可用性,能够通过横向扩展来应对高负载和大规模数据量的处理需求。

- Kafka:Kafka设计为分布式的流平台,具有良好的横向扩展能力,能够处理大规模数据流,并且支持水平扩展。

- ActiveMQ:ActiveMQ也支持集群部署和高可用性,能够通过横向扩展来扩展性能和容量。

6. 社区和生态系统:

- RabbitMQ:RabbitMQ拥有活跃的开源社区和丰富的插件生态系统,能够满足各种定制化需求。

- Kafka:Kafka作为Apache基金会的顶级项目,有庞大的开源社区和丰富的生态系统,提供了各种工具和扩展支持。

- ActiveMQ:ActiveMQ也有强大的社区支持和丰富的生态系统,提供了丰富的功能特性和扩展插件。

7. 持久化策略:

- RabbitMQ:RabbitMQ支持消息的持久化,即使在消息代理重启后也能保留消息,确保消息不会丢失。

- Kafka:Kafka设计为基于日志的系统,所有消息都被持久化到磁盘,因此具有强大的消息持久化能力。

- ActiveMQ:ActiveMQ同样支持消息的持久化,能够保证消息在代理重启后不会丢失。

8. 编程语言支持:

- RabbitMQ:RabbitMQ提供了多种客户端库,支持多种编程语言,如Java、Python、Ruby等,适合多语言环境下的开发。

- Kafka:Kafka也提供了丰富的客户端库,支持多种编程语言,适合构建多语言环境下的分布式应用。

- ActiveMQ:ActiveMQ同样支持多种客户端库,提供了丰富的编程语言支持,适合多语言环境下的开发和集成。

9. 社区和支持:

- RabbitMQ:RabbitMQ由Pivotal Software公司开发并维护,拥有稳定的技术支持和文档资料,同时拥有庞大的开源社区支持。

- Kafka:Kafka作为Apache基金会的顶级项目,拥有牢固的技术基础和活跃的社区支持,同时具有丰富的文档资料和教程。

- ActiveMQ:ActiveMQ由Apache软件基金会支持,拥有稳定的技术支持和丰富的社区资源。

10. 数据处理方式:

- RabbitMQ: RabbitMQ遵循"先进先出"(FIFO)的消息处理方式,适合需要按照严格顺序处理消息的场景。

- Kafka: Kafka采用日志结构,消息以分区方式存储,可以按照消息的偏移量读取,适合大规模数据流的顺序处理和并行处理。

- ActiveMQ: ActiveMQ提供了灵活的消息处理方式,可以根据需要选择队列、主题或者发布-订阅模式,适用于不同的消息处理场景。

11. 可视化管理工具:

- RabbitMQ: RabbitMQ提供了管理界面,方便用户监控和管理消息队列的状态、性能指标以及队列的配置和设置。

- Kafka: Kafka提供较为简单的管理工具,但通常需要借助第三方工具或者自行开发来实现消息队列的监控和管理。

- ActiveMQ: ActiveMQ同样提供了管理界面,支持用户对消息队列进行监控和管理,包括队列、订阅者、连接等方面。

特性 ActiveMQ RabbitMQ Kafka 开发语⾔ scala 单机吞吐量 万级 10万级 10万级 时效性 ms级 us级 ms级以内 可用性 ⾼(主从架构) ⾼(主从架构) ⾮常⾼(分布式架构) 功能特性 成熟的产品,在很多公司 得到应⽤;有较多的⽂

档;各种协议⽀持较好基于erlang开发,所以并 发能⼒很强,性能极其

好,延时很低;管理界⾯较 丰富只⽀持主要的MQ功能, 像⼀些消息查询,消息回 溯等功能没有提供,毕竟 是为⼤数据准备的,在⼤ 数据领域应⽤⼴ · 中⼩型公司⾸选RabbitMQ:管理界⾯简单,⾼并发。

· ⼤型公司可以选择RocketMQ:更⾼并发,可对rocketmq进⾏定制化开发。

· ⽇志采集功能,⾸选kafka,专为⼤数据准备。

七、rabbitmq如何保证消息的可靠性

持久化:RabbitMQ允许消息进行持久化,即使在消息代理重启后也能保留消息。通过将消息标记为持久化,RabbitMQ会将消息写入磁盘,以确保消息不会因为系统故障而丢失。

- 消息队列持久化:RabbitMQ支持将消息队列持久化,即使在系统重启的情况下,消息队列的数据也不会丢失。

确认机制:当生产者将消息发送到队列时,可以要求RabbitMQ发送确认消息,确保消息已经被正确接收。这种机制能够防止消息在发送过程中丢失。

发布者确认:RabbitMQ还提供了发布者确认模式,生产者可以在消息被投递到队列后收到确认,从而确认消息已经安全地被RabbitMQ接收。

消费者应答机制:在默认情况下,当消费者从队列中获取消息后,RabbitMQ 会立即将该消息标记为已传递给消费者,然后从队列中删除。但是在某些情况下,消费者可能在处理消息时出现故障或处理时间过长,为了保证消息不会丢失,RabbitMQ 提供了消费者应答机制。消费者可以在处理完消息后发送应答给 RabbitMQ,如果 RabbitMQ 收到应答,才会将该消息从队列中删除,否则会重新将消息分发给其他消费者。

消费者限流:RabbitMQ 还支持消费者限流机制。通过设置预取值(prefetch),消费者可以告诉 RabbitMQ 在确认之前只向其发送一定数量的消息。这样可以避免消费者过载,保证消息的可靠处理。

集群模式:RabbitMQ 支持集群模式,在集群中的不同节点上可以复制队列和消息。如果一个节点发生故障,其他节点可以接管该节点上的队列和消息,从而实现高可用性和容错性。

- 监控和日志:RabbitMQ提供了丰富的监控和日志功能,可以实时监控消息队列的使用情况、消息的发送和接收情况等,方便及时发现和解决问题。

八、springcloud服务发现原理

Spring Cloud服务发现的原理主要基于Eureka组件,包括Eureka客户端和Eureka服务器。

首先,每个微服务在启动时,会通过Eureka客户端将自己的网络地址等信息注册到Eureka服务器中。Eureka服务器会存储这些注册信息,以便服务消费者查询。

其次,Eureka客户端与服务消费者集成在一起。当服务消费者启动时,它会向Eureka服务器注册自己,并从Eureka服务器获取服务提供者的信息。这样,服务消费者就可以动态地获取最新的服务网络地址,并调用相应的接口。

此外,Eureka客户端还实现了与服务提供者的心跳机制。它会定期向服务提供者发送心跳包以检测其健康状态。如果Eureka客户端在一定时间内未收到服务提供者的心跳回应,它会认为该服务提供者已经宕机,并从服务列表中删除该服务提供者的信息。

最后,Spring Cloud的Eureka服务发现组件通过将各个微服务注册到Eureka服务器中,并使用Eureka客户端与服务消费者集成在一起,实现了服务的自动发现和动态负载均衡。这样,服务消费者可以动态地获取最新的服务网络地址,并调用相应的接口,而不需要关心服务的具体部署情况。

综上所述,Spring Cloud的服务发现原理是基于Eureka组件实现的,通过将各个微服务注册到Eureka服务器中,并使用Eureka客户端与服务消费者集成在一起,实现了服务的自动发现和动态负载均衡。

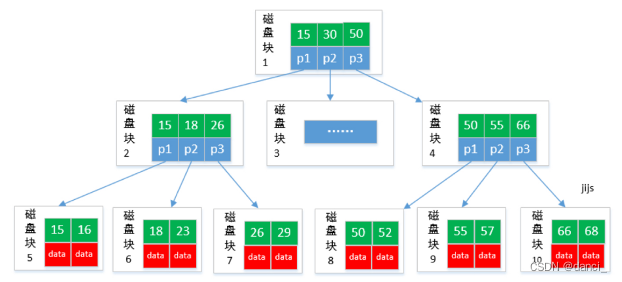

九、介绍下springcloud各个组件?springcloud的注册中⼼除了eureka还可以⽤什么?

springcloud的⼯作原理

springcloud由以下⼏个核⼼组件构成:

· Eureka:各个服务启动时, Eureka Client都会将服务注册到Eureka Server,并且Eureka Client还可以反过来从Eureka Server拉 取注册表,从⽽知道其他服务在哪⾥

· Ribbon:服务间发起请求的时候,基于Ribbon做负载均衡,从⼀个服务的多台机器中选择⼀台

· Feign:基于Feign的动态代理机制,根据注解和选择的机器,拼接请求URL地址,发起请求

· Hystrix:发起请求是通过Hystrix的线程池来⾛的,不同的服务⾛不同的线程池,实现了不同服务调⽤的隔离,避免了服务雪崩 的问题

· Zuul:如果前端、移动端要调⽤后端系统,统⼀从Zuul⽹关进⼊,由Zuul⽹关转发请求给对应的服务

注册中⼼还可以⽤zookeeper。

十、微服务有⼏种限流⽅式

微服务的限流方式有多种,以下是一些常见的限流方式:

- 令牌桶算法:令牌桶算法是一种常见的限流算法,它维护一个令牌桶,以一定的速度向桶中添加令牌。当微服务接收到请求时,会从桶中获取一个令牌,如果没有令牌则拒绝请求。令牌桶算法可以很好地应对突发流量,但是需要合理配置令牌的生成速度和桶的大小。

- 滑动窗口算法:滑动窗口算法是一种时间窗口限流算法,它维护一个时间窗口,在每个时间窗口内限制请求的数量。当微服务接收到请求时,会根据请求的时间戳判断是否在时间窗口内,如果是则继续处理请求,如果不是则拒绝请求。滑动窗口算法可以很好地限制单位时间内的请求数量。

- 计数器算法:计数器算法是一种简单的限流算法,它维护一个计数器,记录微服务在一段时间内接收到的请求数量。当微服务接收到请求时,会将计数器加一,并根据计数器的值判断是否超过限流阈值。计数器算法可以很好地限制一段时间内的请求数量,但是无法应对突发流量。

- 漏桶算法:漏桶算法是一种类似于令牌桶算法的限流算法,它维护一个漏桶,以一定的速度漏出令牌。当微服务接收到请求时,会从桶中获取一个令牌,如果没有令牌则拒绝请求。漏桶算法可以很好地限制服务的响应时间,但是无法很好地应对突发流量。

- 基于Redis的限流算法:Redis提供了一些数据结构,如Redis Set和Redis Sorted Set,可以用于实现限流算法。基于Redis的限流算法可以利用Redis的高性能和分布式特性,实现高并发和分布式的限流。

十一、限流的情况下,服务隔离还有没有必要

在进行微服务架构设计时,限流和服务隔离通常都是考虑的因素。虽然限流可以限制系统的流量和负载,并在一定程度上保护服务的稳定性,但服务隔离仍然具有重要的作用,尤其是在面对大规模系统和复杂网络环境时。

服务隔离的主要目的是确保单个微服务或服务集群的异常情况不会对整个系统造成影响。即使在限流的情况下,服务隔离仍具有以下几个方面的必要性和重要性:

故障隔离:通过服务隔离可以将系统组件或服务进行逻辑隔离,当某个服务出现故障或不稳定时,可以最大程度地减少故障对其他服务或系统的影响。

资源隔离:不同服务可能需要不同的资源,如CPU、内存、磁盘、网络带宽等。通过服务隔离可以为每个服务分配和保障适当的资源,避免因一项服务的资源消耗过大而影响其他服务的正常运行。

安全隔离:一些安全相关的考虑也需要服务隔离,比如敏感数据访问权限的隔离,防止某个服务的安全漏洞对整个系统造成风险。

因此,尽管限流可以控制系统的请求流量和过载,但服务隔离仍然是设计微服务架构中的一项重要策略,可以提高系统的稳定性、安全性和可靠性。综合来看,限流和服务隔离在微服务架构设计中通常是相辅相成的,相互配合以保障系统的健康运行。

十二、dubbo有⼏种负载均衡?负载均衡是在服务端还是客户端

Dubbo 提供了多种负载均衡策略,用于在服务消费端调用服务提供端时进行负载均衡。常见的负载均衡策略包括:

随机负载均衡(Random Load Balance):随机选择一个可用的服务提供者进行调用,每个服务提供者被调用的概率是相同的。

轮询负载均衡(Round Robin Load Balance):按照轮询的方式依次选择可用的服务提供者进行调用,按照顺序平均分配请求到每个服务提供者。

最少活跃调用负载均衡(Least Active Load Balance):选择活跃调用数最小的服务提供者进行调用,以实现请求分发的最小化。

一致性哈希负载均衡(Consistent Hash Load Balance):通过哈希算法将相同的请求分发到相同的服务提供者,可以在一定程度上保证相同的请求总是分发到同一个服务提供者上。

权重负载均衡(Weighted Load Balance):根据服务提供者设置的权重值进行负载均衡,权重越高的服务提供者被选中的概率越大。

本地优先负载均衡(Local First Load Balance):优先选择同机房内的服务提供者进行调用,实现服务调用的本地化。

这些负载均衡策略主要应用于服务消费端,在Dubbo中,负载均衡的策略由服务消费者配置,用于选择合适的服务提供者进行调用。负载均衡的选择可以根据实际需求和系统架构进行调整,以达到最优的负载分发效果。

十三、如何实现redis分布式锁?需要注意什么问题?

实现 Redis 分布式锁可以通过以下步骤进行:

- 引入依赖:首先,需要在项目中引入Redis的客户端库,如Jedis。

- 设置锁键:为每个需要加锁的资源设置一个唯一的锁键。

- 加锁:使用Redis的SET命令尝试创建锁键。SET命令可以带有NX和PX选项,NX表示只有当锁键不存在时才创建锁,PX表示设置锁的过期时间。

- 解锁:使用Redis的DEL命令删除锁键,释放锁。

- 异常处理:在加锁和解锁过程中,需要对可能出现的异常进行捕获和处理,以保证程序的健壮性。

- 使用事务:如果需要在获取锁的同时执行多个操作,可以使用Redis的事务功能,确保操作的原子性。

- 监控和日志:为了及时发现和解决锁相关的问题,需要监控Redis的锁状态和日志信息。

需要注意的关键问题包括:

- 锁的粒度:不同的业务场景可能需要不同粒度的锁。例如,一个系统中的多个微服务可能只希望某些特定服务在运行时保持锁,而不是所有服务。

- 锁的超时:如果一个进程在持有锁的过程中出现错误或异常,它可能会永远无法释放锁。为了避免这种情况,可以在创建锁时设置一个过期时间。

- 锁的公平性:在多线程或多进程环境下,如何公平地分配锁也是一个需要考虑的问题。一种解决方案是使用公平锁,即每个等待锁的线程或进程都有机会获得锁,而不是仅仅因为它们等待的时间最长。

- 锁的死锁:死锁是指两个或更多进程在无限期地等待对方释放资源的情况。避免死锁的一种常见策略是使用预获取锁的策略,即进程在开始时一次性获取所有需要的锁。

- 锁的冲突检测:虽然Redis分布式锁可以在一定程度上解决冲突,但在高并发环境下,仍然可能存在冲突。因此,需要一种机制来检测和处理冲突。

- 锁的原子性:原子操作是不可分割的操作,也就是说,一旦开始就不会被其他操作中断。在分布式系统中,保持操作的原子性非常重要,因为这可以防止数据不一致性的问题。

- 高可用性:如果Redis实例出现故障,需要有机制保证系统能够快速恢复并继续提供服务。

- 可扩展性:随着业务的发展,可能需要更多的锁。因此,分布式锁系统需要能够水平扩展。

- 性能和延迟:在实现分布式锁时,需要考虑性能和延迟的问题。频繁地获取和释放锁可能会导致大量的网络延迟和CPU开销。

- 安全性:在分布式系统中,任何未授权的访问都可能导致数据泄露或系统损坏。因此,实现分布式锁时,需要确保只有合法的用户才能获取或释放锁。

十四、说说你看过的源码?其中⽤到了什么设计模式或者设计亮点?

具体分析,⾯试前需要熟读⼀些源码,如spring源码。

十五、如何实现aop?项⽬中哪些地⽅⽤到了 aop?

AOP(Aspect-Oriented Programming)是一种编程范式,用于在程序运行过程中动态地将横切关注点(cross-cutting concerns)与核心业务逻辑进行分离和处理。在 Java 中,AOP 可以通过 Spring AOP 或 AspectJ 等框架实现,通常用于解耦业务逻辑和横切关注点的代码,并提高系统的模块化、可维护性和复用性。

在项目中,AOP 可以应用于以下场景:

日志记录:将日志记录作为一个横切关注点,通过 AOP 可以在方法执行前后进行日志记录,而不需要在每个方法中都加入日志记录的代码。

权限控制:在系统中进行权限控制时,可以利用 AOP 在方法执行前进行权限校验,确保只有有权限的用户才可以执行某些操作。

事务管理:通过 AOP 可以将事务管理作为一个横切关注点,统一在方法执行前开启事务、方法执行后提交或回滚事务。

缓存管理:AOP 可以用于统一处理缓存的管理,例如在方法执行前先从缓存中查找结果,减少对底层存储系统的访问。

在 Spring 框架中,AOP 通常结合注解或配置文件来定义切面(Aspect)和通知(Advice),并通过切点(Pointcut)来匹配连接点(Join Point),实现对横切关注点的处理。

通过在项目中定义切面类,并在需要应用 AOP 的地方配置相关注解或切点,可以实现 AOP 的应用。一般来说,AOP 在企业应用中常用于日志记录、性能监控、事务管理、异常处理等方面,可以提高代码的模块化和可维护性。

十六、Spring中bean后置处理器的作用

在 Spring 框架中,Bean 后置处理器(BeanPostProcessor)是一个接口,它允许在 Spring 容器实例化 bean 的过程中插入自定义的处理逻辑。Bean 后置处理器的作用主要包括以下几点:

初始化前后的处理:Bean 后置处理器允许开发者插入自定义的逻辑,在 Spring 容器实例化 bean 之后,在调用 bean 的初始化方法之前和之后进行特定操作,例如对 bean 进行属性设置、初始化等操作。

继承性:Bean 后置处理器可以应用于所有的 bean,使得在配置文件中定义的各种 bean 都能够享受这种扩展机制,实现统一的处理逻辑。

自定义扩展:通过实现 BeanPostProcessor 接口,开发者可以为不同的 bean 定制不同的处理逻辑,例如加强某些指定类型 bean 的功能、添加特定的初始化操作等。

AOP 的实现:Bean 后置处理器在 Spring AOP 中发挥了重要作用,通过 Bean 后置处理器可以在目标对象被创建的时候,动态地生成代理对象并将其返回,实现 AOP 的切面织入。

总的来说,Bean 后置处理器为开发者提供了一种对 Spring 容器的拓展和定制机制,可以在 bean 实例化和初始化的过程中动态地添加自定义逻辑,使得开发者能够以一种统一、灵活的方式处理和拓展 bean 的配置和初始化过程。

十七、spring bean作⽤域,什么时候使⽤request作⽤域

在Spring框架中,bean的作用域决定了bean的生命周期和可见性。Spring提供了几种不同的作用域,包括:singleton、prototype、request、session、application和websocket。每种作用域都有其特定的使用场景。

提到“request作用域”,它是Spring中一种特殊的作用域,它的作用范围仅限于一个HTTP请求。这意味着在一个请求的生命周期内,该bean是可用的,但在不同的请求之间,该bean是不可见的。

以下是您可能会考虑使用request作用域的场景:

- 与请求相关的数据:如果你有一些与当前HTTP请求相关的数据,例如从请求参数中获取的数据,你可能希望将这些数据存储在某个bean中,以便在处理该请求的其他地方可以轻松访问这些数据。在这种情况下,使用request作用域的bean是有意义的。

- 避免重复初始化:如果你有一个耗时的初始化过程,并且你希望该过程只发生一次,即使在处理多个请求时也是如此,你可以使用request作用域。这样,bean只会在第一个请求中初始化,然后在该请求的生命周期内被重复使用。

- 在多个Controller之间共享数据:如果你需要在不同的Controller之间共享某些数据,但又不希望这些数据在整个应用程序中都是可用的,那么request作用域的bean可能是一个好的选择。

但是,需要注意的是,request作用域的bean并不是线程安全的。如果你在多线程环境中使用它,可能会出现问题。此外,由于每个请求都有自己的bean实例,因此如果你有大量的请求,可能会消耗大量的内存。因此,在使用request作用域时需要谨慎考虑。

十八、说说下⾯这道题的结果

public class VolatileTest {

public static volatile int race = 0;

public static void increase() {

race ++;

}

private static final int THREADS_COUNT = 10;

public static void main(String[] args) {

Thread[] threads = new Thread[THREADS_COUNT];

for (int i = 0; i < THREADS_COUNT; i++) {

threads[i] = new Thread(new Runnable() {

@Override

public void run() {

for (int j = 0; j < 10000; j ++) {

increase();

}

}

});

threads[i].start();

}

while(Thread.activeCount() > 1) {

Thread.yield();

}

System.out.println(race);

}

}

![[RK-Linux] 移植Linux-5.10到RK3399(十一)| 检查Nor FLASH(XM25QH128A)配置](https://img-blog.csdnimg.cn/direct/50283579a96740f4abccb2e4c6491dfa.png#pic_center)