目录

- 前言

- 1 不同应用的向量表示

- 1.1 自然语言中的向量表示

- 1.2 知识图谱中的向量表示

- 1.3 图像视觉中的向量表示

- 2 词的向量表示

- 2.1 One-hot encoding的限制

- 2.2 Bag-of-Words模型的不足

- 2.3 Word Embedding的引入

- 2.4. 词的分布式表示与语境关系

- 3 词向量模型

- 3.1 CBoW(Continuous Bag of Words)模型

- 3.2 Skip-gram模型

- 4. 知识图谱嵌入模型

- 4.1 TransE模型

- 4.2 DistMult模型

- 结语

前言

随着深度学习的发展,向量表示成为处理自然语言、知识图谱和图像视觉中的关键技术之一。本文将深入探讨向量表示在这三个领域的应用,包括词的向量表示、词向量模型以及知识图谱嵌入模型。通过对这些技术的介绍和比较,我们将了解向量表示是如何在不同领域中实现语义表达的。

1 不同应用的向量表示

向量表示在自然语言、知识图谱和图像视觉中的应用是广泛而重要的,为处理复杂的语义信息提供了有效的手段。

1.1 自然语言中的向量表示

在自然语言处理中,为了更好地理解句子的语义,需要为句子中的每个词学习一个向量表示。传统方法如one-hot encoding存在空间消耗大的问题,而bag-of-words模型则无法有效表示词的语义,因为它忽略了上下文关系。因此,引入了词的分布式表示,即word embedding,通过学习词在语境中的分布关系,得到更为丰富的语义信息。

1.2 知识图谱中的向量表示

在知识图谱中,每个实体和关系也需要一个向量表示,以便在向量空间中表达它们的语义关系。知识图谱嵌入模型如TransE和DistMult通过学习实体和关系之间的嵌入关系,使得知识图谱中的三元组能够在向量空间中有良好的表示。然而,由于知识逻辑的复杂性、训练代价以及语料不充分等问题,这些模型在推理问题上仍然面临一些挑战。

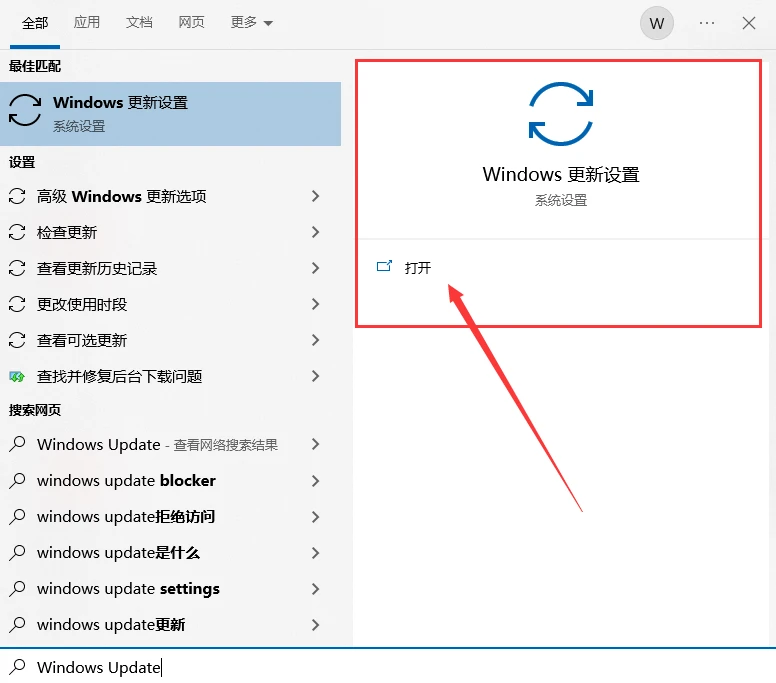

1.3 图像视觉中的向量表示

在图像视觉中,每个对象也需要一个向量表示。这种表示可以通过卷积神经网络(CNN)等深度学习方法学习得到,使得模型能够理解图像中不同对象的语义信息,并实现图像的自动分析和识别。

向量表示的学习为自然语言、知识图谱和图像视觉等领域的复杂数据提供了一种有效的方式。通过将各种信息映射到向量空间,系统能够更好地理解和处理数据的语义信息。然而,不同领域面临的问题和挑战也需要不同的解决方法,需要进一步研究和创新,以提高向量表示的性能和适应性。随着深度学习的不断发展,相信向量表示将在更多领域中发挥着关键作用。

2 词的向量表示

在处理词语的向量表示时,传统的编码方法如one-hot encoding虽然简单,但其空间消耗较大,且无法有效表达词的语义。为了更准确地捕捉词汇的语义信息,引入了词的分布式表示,即word embedding,通过学习词在语境中的分布关系来获取更为丰富的语义信息。

2.1 One-hot encoding的限制

传统的one-hot encoding方法将每个词表示为一个唯一的向量,其中只有一个元素为1,其余为0。尽管这种方法简单直观,但其缺点在于对于大规模词汇,会导致向量维度过高,造成空间消耗大,且忽略了词之间的语义关系。

2.2 Bag-of-Words模型的不足

Bag-of-Words模型将文本看作词汇的无序集合,忽略了词语在句子中的顺序和上下文之间的关系。因此,它无法有效地表示词的语义信息,对于相似的词语无法进行区分,限制了在处理自然语言中的语义理解。

2.3 Word Embedding的引入

为了解决上述问题,引入了word embedding,即将词映射到一个低维连续向量空间中。Word embedding的关键思想是通过学习将相似语境中的词映射到相近的向量,从而在向量空间中保留词的语义关系。这种分布式表示不仅减小了向量维度,还更好地捕捉了词之间的语义相似性。

2.4. 词的分布式表示与语境关系

词的语义实际上是由其上下文决定的。在word embedding中,每个词都被表示为一个稠密的向量,使得相似语境中的词在向量空间中更为接近。这使得模型能够更好地理解词汇之间的复杂语义关系,从而提高自然语言处理任务的性能。

词的向量表示是自然语言处理中的关键技术之一。通过引入word embedding,能够更有效地捕捉词汇的语义信息,克服了传统编码方法的限制。这种分布式表示为自然语言处理任务提供了更为准确和丰富的语义表达,推动了文本分析、情感分析等应用领域的发展。

3 词向量模型

词向量模型是自然语言处理中重要的技术之一,主要包括CBoW(Continuous Bag of Words)和skip-gram两种模型。这些模型通过在大量语料中学习词与其上下文的关系,以获得更为准确的词向量表示,为自然语言处理和其他领域的向量表示提供了有力的支持。

3.1 CBoW(Continuous Bag of Words)模型

CBoW模型旨在通过上下文中的已知词语来预测目标词语。具体而言,模型接收上下文中的词向量作为输入,通过一个神经网络预测目标词的概率分布。训练过程中,模型的目标是最大化正确词语的概率,从而学习到每个词的嵌入表示。CBoW模型的优势在于其相对简单,训练速度较快,尤其适用于大规模语料。

3.2 Skip-gram模型

与CBoW相反,skip-gram模型旨在通过目标词语来预测上下文中的词语。同样通过神经网络,skip-gram模型试图最大化目标词与其上下文词语之间的关系。虽然相对于CBoW而言,skip-gram的训练过程更为复杂,但它在处理大规模语料和更为丰富的语义信息时表现更为出色。

词向量模型通过学习词与其上下文的关系,为自然语言处理和其他领域提供了强大的工具。无论是CBoW还是skip-gram,它们都成功地将语境信息转化为连续向量表示,使得模型能够更好地理解和处理语义信息。这种技术的成功应用不仅为自然语言处理领域注入了新的活力,也为其他领域的向量表示研究提供了重要的经验和启示。

4. 知识图谱嵌入模型

在知识图谱中,为了更好地表示实体和关系,采用了知识图谱嵌入模型。其中,TransE和DistMult是两个常用的模型,通过学习实体和关系之间的嵌入关系,使得知识图谱中的三元组能够在向量空间中得到良好的表达。然而,这些模型在推理问题上仍然面临一些挑战。

4.1 TransE模型

TransE是一种知识图谱嵌入模型,其核心思想是通过加法操作学习实体和关系之间的嵌入关系。具体而言,TransE假设一个正确的三元组(h,r,t)中的头实体h与关系r的嵌入向量与尾实体t的嵌入向量之和等于零。通过最小化这种约束的违背程度,模型学习到了实体和关系在向量空间中的表达。

4.2 DistMult模型

DistMult是另一种常用的知识图谱嵌入模型,其特点是采用乘法操作来学习实体和关系之间的嵌入关系。具体而言,DistMult中每个三元组的分数计算是通过头实体h、关系r和尾实体t的嵌入向量之间的点乘得到的。这种模型在捕捉实体和关系之间复杂关系方面具有较强的表达能力。

尽管TransE和DistMult等知识图谱嵌入模型在捕捉实体和关系之间的语义关系上取得了一些成功,但仍然面临一些挑战。知识图谱的逻辑复杂性使得推理问题变得更为困难,而嵌入模型的训练代价较高,需要大量的标注数据。此外,由于知识图谱的语料相对有限,模型的泛化能力也成为一个需要解决的问题。

知识图谱嵌入模型是处理知识图谱中实体和关系表示的关键方法。尽管存在一些挑战,但通过不断的研究和创新,这些模型将在知识图谱领域发挥越来越重要的作用。未来的发展需要综合考虑模型的推理能力、训练代价以及数据的质量,以实现更加准确和泛化的知识图谱表示。

结语

向量表示在自然语言、知识图谱和图像视觉领域中的应用是多方面且重要的。通过学习语义信息,向量表示不仅使得模型更好地理解和处理数据,也为各个领域的问题提供了有效的解决方案。然而,面对知识图谱中的复杂逻辑、训练代价和语料不足等问题,仍需要不断的研究和创新,以进一步提升向量表示的性能和应用范围。随着深度学习的不断发展,相信向量表示将在更多领域中发挥其重要作用。