OpenCompass 大模型评测

- 关于测评的三个问题

- 为什么需要测评?

- 我们需要评测什么?

- 怎么测试大预言模型?

- 主流大模型评测框架

- OpenCompass能力框架

- OpenCompass评测流水线设计

随着人工智能技术的快速发展, 大规模预训练自然语言模型成为了研究热点和关注焦点。OpenAI于2018年提出了第一代GPT模型,开辟了自然语言模型生成式预训练的路线。沿着这条路线,随后又陆续发布了GPT-2和GPT-3模型。与此同时,谷歌也探索了不同的大规模预训练模型方案,例如如T5, Flan等。OpenAI在2022年11月发布ChatGPT,展示了强大的问答能力,逻辑推理能力和内容创作能力,将模型提升到了实用水平,改变人们对大模型能力的认知。在2023年4月,OpenAI发布了新升级的GPT-4模型,通过引入多模态能力,进一步拓展了大语言模型的能力边界,朝着通用人工智能更进一步。ChatGPT和GPT-4推出之后,微软凭借强大的产品化能力迅速将其集成进搜索引擎和Office办公套件中,形成了New Bing和 Office Copilot等产品。谷歌也迅速上线了基于自家大语言模型PaLM和PaLM-2的Bard,与OpenAI和微软展开正面竞争。国内的多家企业和研究机构也在开展大模型的技术研发,百度,阿里,华为,商汤,讯飞等都发布了各自的国产语言大模型,清华,复旦等高校也相继发布了GLM, MOSS等模型。

为了准确和公正地评估大模型的能力,国内外机构在大模型评测上开展了大量的尝试和探索。斯坦福大学提出了较为系统的评测框架HELM,从准确性,安全性,鲁棒性和公平性等维度开展模型评测。纽约大学联合谷歌和Meta提出了SuperGLUE评测集,从推理能力,常识理解,问答能力等方面入手,构建了包括8个子任务的大语言模型评测数据集。加州大学伯克利分校提出了MMLU测试集,构建了涵盖高中和大学的多项考试,来评估模型的知识能力和推理能力。谷歌也提出了包含数理科学,编程代码,阅读理解,逻辑推理等子任务的评测集Big-Bench,涵盖200多个子任务,对模型能力进行系统化的评估。在中文评测方面,国内的学术机构也提出了如CLUE,CUGE等评测数据集,从文本分类,阅读理解,逻辑推理等方面评测语言模型的中文能力。

随着大模型的蓬勃发展,如何全面系统地评估大模型的各项能力成为了亟待解决的问题。由于大语言模型和多模态模型的能力强大,应用场景广泛,目前学术界和工业界的评测方案往往只关注模型的部分能力维度,缺少系统化的能力维度框架与评测方案。OpenCompass提供设计一套全面、高效、可拓展的大模型评测方案,对模型能力、性能、安全性等进行全方位的评估。OpenCompass提供分布式自动化的评测系统,支持对(语言/多模态)大模型开展全面系统的能力评估。

关于测评的三个问题

为什么需要测评?

- 模型选型

- 模型能力提升

- 真实应用场景效果评测

我们需要评测什么?

- 知识、推理、语言

- 长文本、智能体、多轮对话

- 情感、认知、价值观

怎么测试大预言模型?

- 自动化客观评测

- 人机交互评测

- 基于大模型的大模型评测

主流大模型评测框架

OpenCompass能力框架

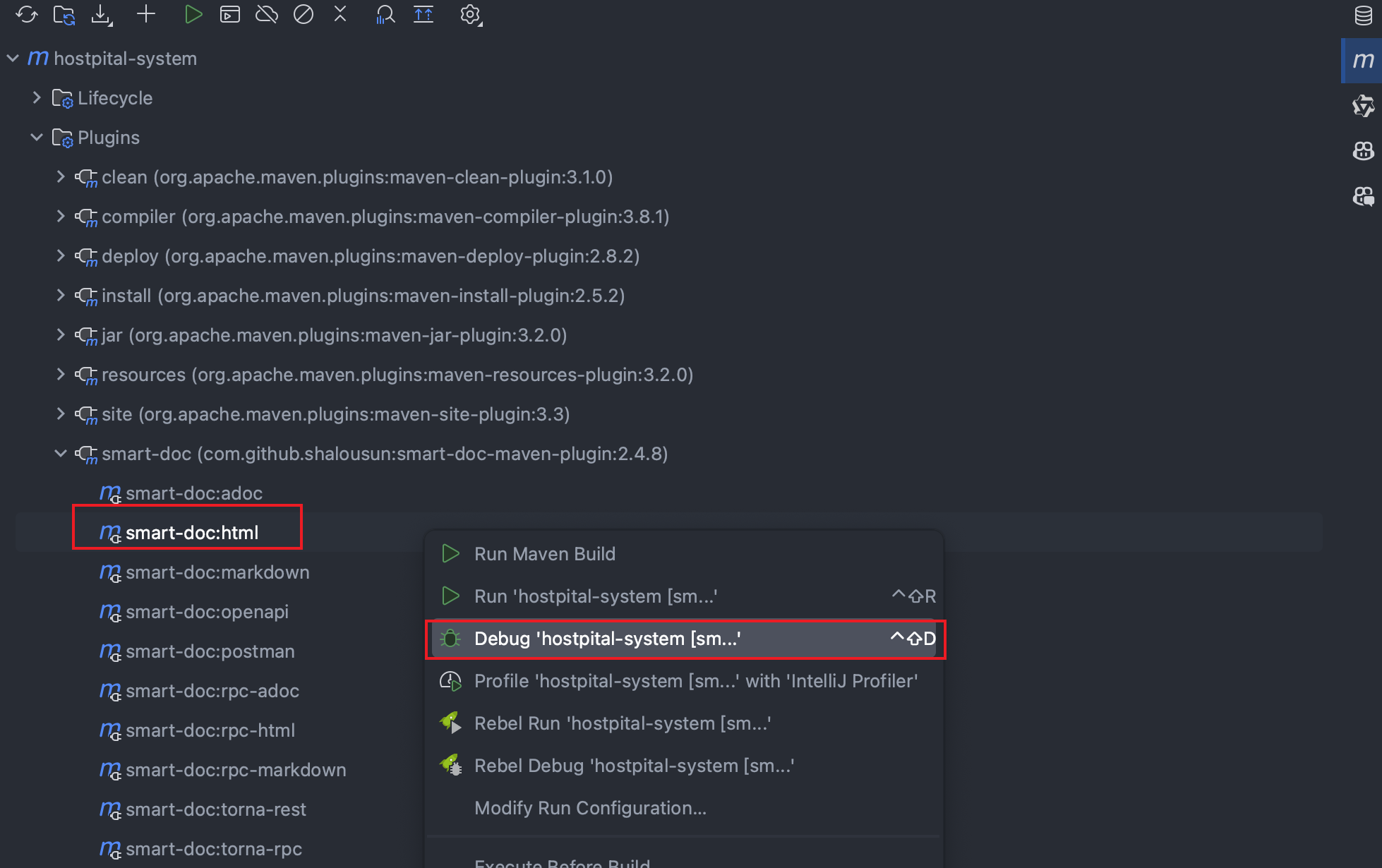

OpenCompass评测流水线设计

![[足式机器人]Part2 Dr. CAN学习笔记- 最优控制Optimal Control Ch07-1最优控制问题与性能指标](https://img-blog.csdnimg.cn/direct/795a53af3e9143c7b8b4dc4861f83c39.png#pic_center)