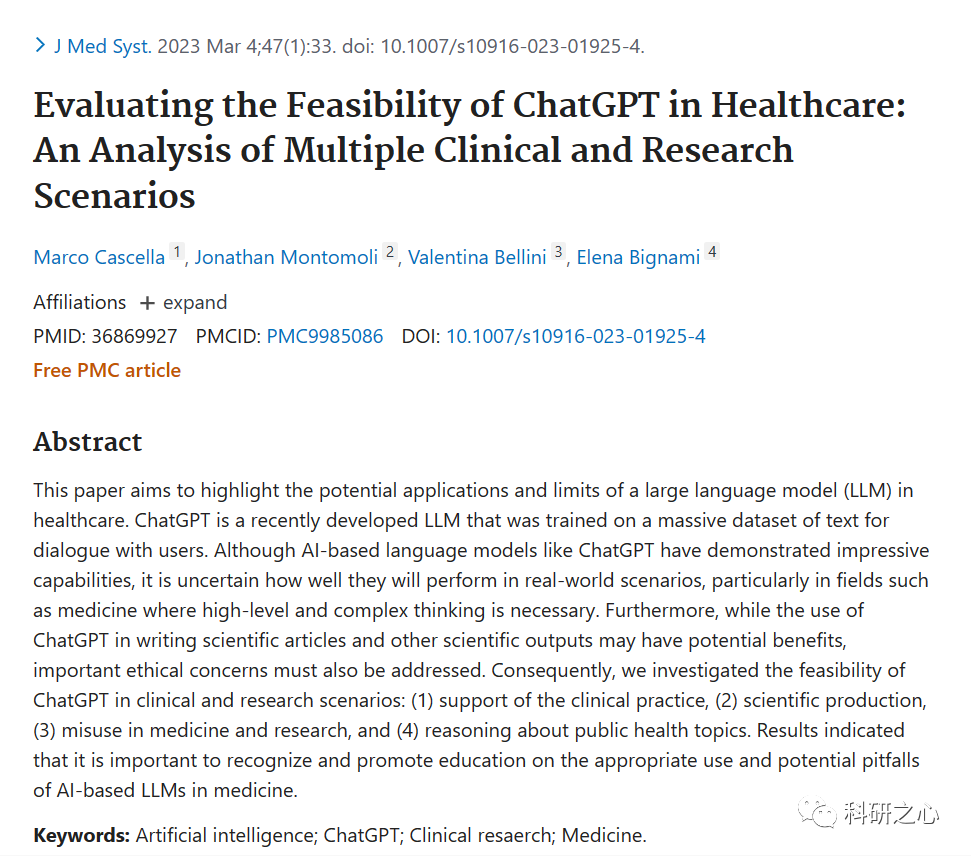

2023年4月发表在Journal Medical Systems的文献《Evaluating the Feasibility of ChatGPT in Healthcare: An Analysis of Multiple Clinical and Research Scenarios》(评估 ChatGPT 在医疗健康领域的可行性:对多种临床和研究场景的分析)介绍了以ChatGPT为代表的大型语言模型(LLM)在医疗健康的临床和科研场景领域的潜在应用和局限性。

这篇文章的主要内容是探讨以ChatGPT为代表的大型语言模型(LLM)在医疗领域的可能应用和局限性。

本文分析了ChatGPT在医疗领域的四个方面的可行性和挑战:支持临床实践,科学生产,医学和研究中的滥用,以及关于公共卫生话题的推理。

本文发现ChatGPT在医疗领域有一些潜在的优势,比如提供信息,服务,创新等。但也有一些严重的局限性和风险,比如缺乏专业知识,无法处理复杂情况,可能造成误导或危害等。

本文建议在使用ChatGPT之前,要进行充分的测试和评估,以及严格的监督和管理。同时,要注意伦理问题,保护用户的隐私和安全。最后,要对用户进行适当的教育和指导,让他们明白ChatGPT的优缺点和使用方法。

“科研之心”的观点是:

-

ChatGPT是一个有价值的医学科研工具,它可以帮助科研人员进行一些创新和高效的工作。比如,它可以生成科学文章,提供文献综述,辅助数据分析等。这些功能可以节省科研人员的时间和精力,让他们更专注于核心的问题和思想。

-

ChatGPT在医学科研结合不同学科的专业知识库进行微调,形成垂直领域的服务模型将会发挥更大的作用。

本文献提炼总结如下:

-

引言:介绍了LLM的基本概念和ChatGPT的特点,以及它们在自然语言处理(NLP)领域的应用。同时,也指出了在医学领域使用ChatGPT可能面临的挑战和风险,比如高水平和复杂的思维能力,以及重要的伦理问题。

-

支持临床实践:分析了ChatGPT在临床实践中的可能作用,比如提供诊断建议,回答常见问题,提供健康教育等。同时,也讨论了ChatGPT在临床实践中的局限性,比如缺乏专业知识,无法处理复杂情况,可能造成误导或误诊等。

-

科学生产:探讨了ChatGPT在科学生产中的潜在优势,比如生成科学文章,提供文献综述,辅助数据分析等。同时,也强调了ChatGPT在科学生产中的伦理问题,比如抄袭,造假,损害学术诚信等。

-

医学和研究中的滥用:警示了ChatGPT可能被滥用的风险,比如生成虚假或有害的医疗信息,误导公众或患者,干扰医疗决策等。同时,也建议了一些防范措施,比如加强监管,提高透明度,增加责任感等。

-

关于公共卫生话题的推理:评估了ChatGPT对公共卫生话题的推理能力,比如新冠疫情,疫苗接种,社交距离等。结果显示ChatGPT能够生成一些合理和准确的回答,但也存在一些错误和不一致的回答。因此,需要对ChatGPT的输出进行严格的验证和审查。

科研之心,致力于探索AI大模型与科研结合。科研之心为您提供最新的AI资讯、最实用的AI工具、最深入的AI分析,帮助您在科学研究中发掘AI的无限潜力。