前言

当你决定做一个网络爬虫的时候,就意味着你要面对一个很大的挑战——IP池和中间件。这两个东西听起来很大上,但其实就是为了让你的爬虫不被封杀了。下面我就来给你讲讲如何搞定这些东西。

第一步:创建爬虫IP池的详细过程

首先,你得有一批代理IP,这可不是随随便便就能搞到的。你可以花钱买,也可以去免费代理网站找,甚至还可以自己搭建代理。但是别忘了,这些IP得稳定、快速,并且得在不同的地方分布。

接下来,你要验证和筛选这些代理IP,不能用的得掉掉。你得发HTTP请求,看看响应状态码、响应时间,才能哪些IP可用,哪些慢如蜗牛、闲得发慌。

最后,你得把这些代理IP整合到你的爬虫里,这样每次请求换个IP,这样就成功被封了,也能提高爬取效率。这就需要写个中间件,让IP能动态切换,这样每次请求都使用不同的IP,降低被封的风险。

下面是一个简单的Python代码示例,演示了如何使用代理IP来发送HTTP请求。在这个示例中,我们使用了requests库来发送HTTP请求,并通过代理IP来访问目标网站。

import requests

# 代理信息

proxyHost = "www.16yun.cn"

proxyPort = "5445"

proxyUser = "16QMSOML"

proxyPass = "280651"

# 目标网站的URL

targetUrl = "http://example.com"

# 构造代理地址

proxyMeta = "http://%(user)s:%(pass)s@%(host)s:%(port)s" % {

"host": proxyHost,

"port": proxyPort,

"user": proxyUser,

"pass": proxyPass,

}

proxies = {

"http": proxyMeta,

"https": proxyMeta,

}

# 发送带代理的HTTP请求

response = requests.get(targetUrl, proxies=proxies)

# 输出响应内容

print(response.text)

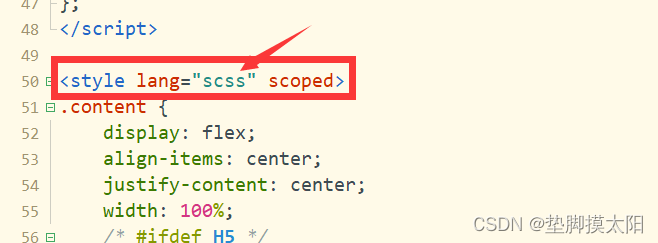

第二步:编写中间件附带实现代码流程

中间件在网络爬虫中扮演关键的角色,它可以用于处理请求、响应和异常。在这一部分,我们将详细介绍如何编写中间件来实现IP切换、请求重试和处理等功能。我们将附带异常实现代码流程,方便读卡器能够了解中间件的编写和使用方法。

# 导入必要的库

import random

from scrapy import signals

from scrapy.downloadermiddlewares.retry import RetryMiddleware

from scrapy.exceptions import NotConfigured

# 自定义的IP切换中间件

class CustomProxyMiddleware(object):

def process_request(self, request, spider):

# 在这里实现IP切换的逻辑,可以使用代理IP池中的IP来发送请求

proxy = get_random_proxy() # 从代理IP池中随机选择一个IP

request.meta['proxy'] = proxy

# 自定义的请求重试中间件

class CustomRetryMiddleware(RetryMiddleware):

def process_response(self, request, response, spider):

# 在这里实现请求重试的逻辑,可以根据响应状态码进行判断是否需要重试

if response.status in [500, 502, 503, 504]:

reason = 'HTTP状态码错误:%s' % response.status

return self._retry(request, reason, spider) or response

return response

# 自定义的异常处理中间件

class CustomExceptionMiddleware(object):

@classmethod

def from_crawler(cls, crawler):

if not crawler.settings.getbool('CUSTOM_EXCEPTION_ENABLED'):

raise NotConfigured

return cls()

def process_exception(self, request, exception, spider):

# 在这里实现异常处理的逻辑,可以根据不同的异常类型进行处理

if isinstance(exception, SomeSpecificException):

# 处理特定的异常

pass

return None

# 注册中间件

def spider_opened(self, spider):

spider.signals.connect(self.spider_opened, signal=signals.spider_opened)

spider.signals.connect(self.spider_closed, signal=signals.spider_closed)

第三步:配置爬虫框架

在网络爬虫开发中,选择合适的爬虫框架需要考虑核心。不同的框架各自具有各自的特点和适用场景,因此在选择和配置框架时需要进行自由选择。

Scrapy是一个功能强大的Python爬虫框架,它具有高效的数据提取能力和灵活的扩展性,适用于大规模数据提取和重构数据提取。配置Scrapy框架通常涉及定义爬虫的起始URL、数据提取规则和存储方式,同时可以通过设置中间件实现IP切换和请求重试等功能。

另一个常用的爬虫框架是Beautiful Soup,它是一个优秀的HTML和XML解析库,适用于快速解析网页内容并提取所需数据。配置Beautiful Soup框架通常包括解析HTML结构、定位目标数据处理和异常情况等步骤。

对于JavaScript渲染的页面,Puppeteer是一个强大的爬虫框架选择。可以模拟浏览器行为,对动态生成的内容进行抓取和处理。配置Puppeteer框架通常包括模拟用户操作、等待页面加载完成和处理JavaScript渲染等操作。

在高效选择和配置爬虫框架时,需要根据具体的抓取需求和目标网站特点进行综合考量。合理选择和配置爬虫框架可以提高开发效率和抓取效果,帮助开发者上手并开发出稳定的网络爬虫。

第四步:运行爬虫最后

在网络爬虫开发的最后阶段,我们需要运行并监控我们开发的爬虫,并处理可能出现的问题。首先,我们应该确保爬虫的运行环境配置正确,包括所需的依赖库和环境变量。接着,我们可以通过日志系统监控爬虫的运行状态,及时发现并解决异常情况。在处理可能遇到的问题时,我们需要考虑网络请求超时、页面结构变化、反爬虫策略等情况,通过设置合理的重试机制和异常处理来提高爬虫的稳定性。另外,合理的并发控制和请求频率也是限制爬虫稳定运行的重要因素。总之,通过详细介绍爬虫运行的流程和常见问题的处理方法,我们可以更好地面保障爬虫的稳定运行和数据的准确聚焦。