文章目录

- 前言

- 0、论文摘要

- 一、Introduction

- 1.1目标问题

- 1.2相关的尝试

- 1.3本文贡献

- 二.前提

- 三.本文方法

- 四 实验效果

- 4.1数据集

- 4.2 对比模型

- 4.3实施细节

- 4.4评估指标

- 4.5 实验结果

- 4.6 细粒度分析

- 五 总结

- 思考

前言

An Intelligent Tree Extractive Text Summarization Deep Learning (21)

0、论文摘要

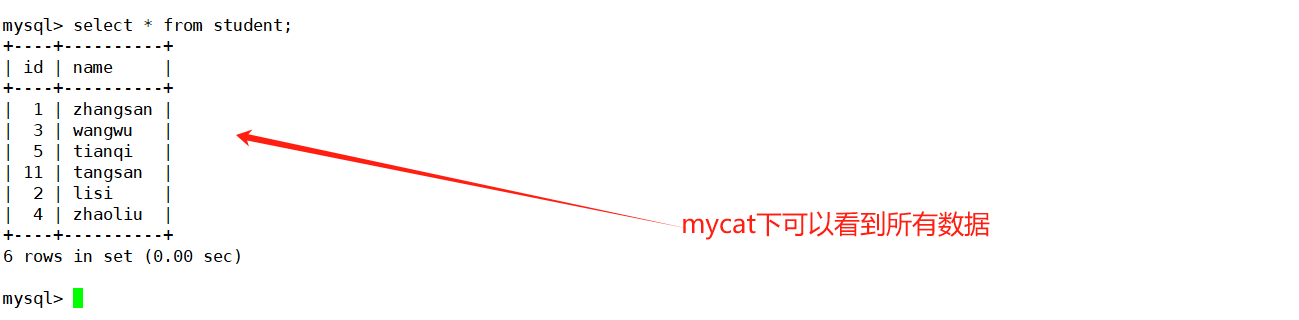

在最近的研究中,深度学习算法为自然语言提供了有效的表示学习模型。基于深度学习的模型比经典模型创建更好的数据表示。它们能够自动提取文本的分布式表示。在本研究中,我们引入了一种新的树提取文本摘要,其特征是拟合知识库训练模块中的文本结构表示,并且还解决了以前未解决的内存问题。所提出的模型采用树结构机制来生成短语和文本嵌入。所提出的架构模仿文本的树配置并提供更好的特征表示。它还采用了一种注意力机制,可以提供额外的信息源来进行更好的摘要提取。该新颖模型将文本摘要作为一个分类过程,其中模型计算短语和文本摘要关联的概率。

模型分类分为信息熵、显着性、冗余度、位置等多种特征识别。该模型在两个数据集上进行了评估,即多文档组合查询(MCQ)和双重注意组合数据集(DAC)数据集。

实验结果证明,我们提出的模型比其他模型具有更大的概括精度。

一、Introduction

1.1目标问题

文本摘要是语言处理中的一个重要研究课题。通过将冗长的文本缩减为更少的短语或更少的段落,这是应对信息过剩挑战的理想方法。智能平板电脑等移动设备的地位标志着文本摘要成为小屏幕和较少带宽能力的重要工具[1-3]。它也可以用作计算机的理解考试。为了生成可接受的摘要,深度学习方法必须理解文本并从中浓缩重要信息。当文本大小变大时,这些责任对于计算机来说是一个很大的问题

增加。尽管搜索引擎可以使用高级检索方法,但它们没有能力从多个来源提取数据并返回简短的有用响应。此外,还需要及时的工具来提取多个来源。这些警报引发了人们对计算机文本摘要模型的兴趣。当前的文本摘要技术依赖于使用文本统计特征的精细特征提取工程。这些系统很复杂,需要工程模型。此外,这些系统无法生成可理解的文本摘要。端到端训练模型在其他方面表现出更好的效果,例如人脸识别、机器翻译和物体识别。目前,神经摘要模型受到关注;提出了几种技术,并演示了它们在文本语料库中的用途[4-7]。

神经摘要有两种模型:抽取式摘要和抽象式摘要。提取模型决定并连接文档中的相关短语以生成摘要,同时保留其原始内容。提取模型通常用于现实世界的应用[7-10]。提取模型的一个中心问题是确定定义关键信息的显着短语[11]。同时,提取摘要模型为原始文本构建了语义模型,并生成类似于人类的摘要。当前的抽象模型非常薄弱[12-15]。

尽管如此,神经模型在文本摘要中使用时仍然存在一些问题。这些模型缺乏文档内容的底层方面结构。因此,文本摘要仅使用不捕获多方面内容的表示向量空间[16]。另一个问题是神经架构是对循环网络(例如门控单元和术语记忆)的修改。理论上,这些网络可以记住计算的状态向量中先前的选择。但现实情况并非如此。此外,记住文档语义相对困难且不是必需的[17]。先前状态的加权表示向量将用作确定下一个状态的步骤的附加输入。因此,模型可以获得过去步骤中计算出的状态,因此最后一个状态将保存先前状态的信息[18]。

这项研究的主要贡献是引入了一种基于神经网络的摘要模型,通过将摘要视为分类过程来从文本中提取相关短语。该模型通过提取内容、重要性、冗余和位置等特征来计算每个短语作为短语成员的分数。我们提出的模型提高了效率和准确性:(i)首先它使用树文本表示; (ii) 在构建文本树时,对单词和短语使用了两种自注意力技术。这使得模型能够对重要内容做出强烈反应。

在这项研究中,出现了两个问题:(1)反映文本树以增强短语的嵌入结构以学习文本语义; (2)从文本中提取最重要的短语以生成首选摘要[18-22]。

1.2相关的尝试

1.3本文贡献

我们的研究与其他研究之间的主要区别是:我们提出的模型利用树结构自注意力技术来产生短语嵌入。增强自注意力技术可以提高性能并提供对摘要短语选择中高分短语的理解。为了测试我们的模型与最先进模型的性能比较,使用了两个数据集:MCQ 新闻和 DAC 集。我们的模型明显优于比较模型。

文章的结构安排如下。第 2 节详细描述了我们的摘要模型。第 3 节介绍了模拟结果。第 4 节描述了相关的比较模型。第 5 节给出了讨论和结论。

总之,我们的贡献如下:

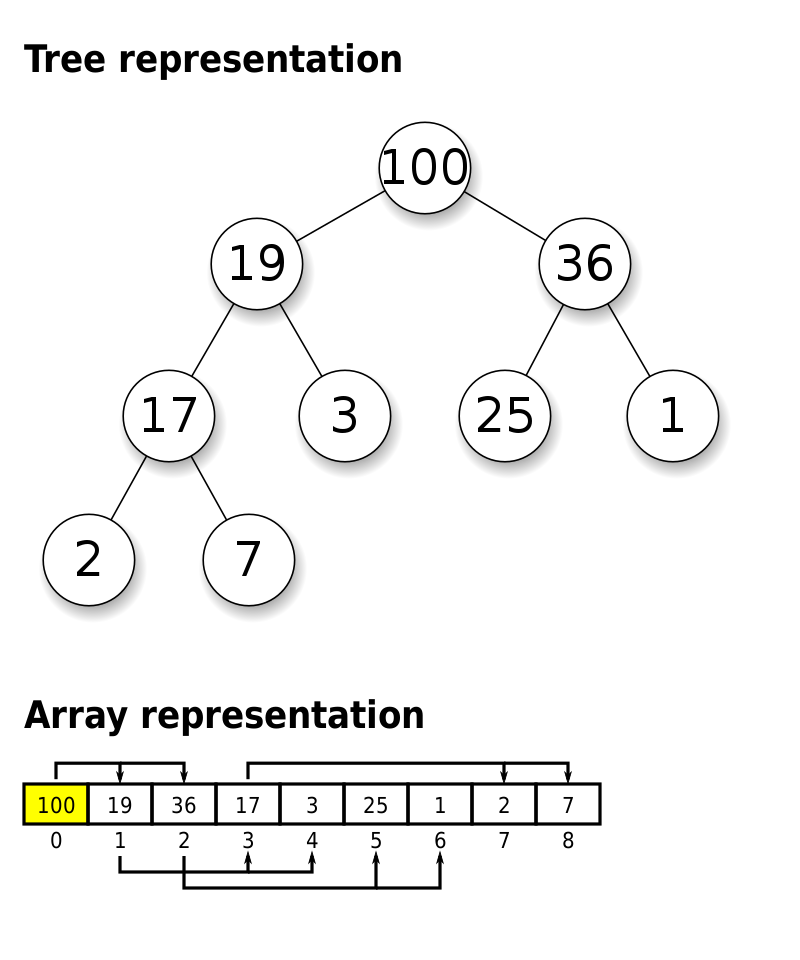

二.前提

三.本文方法

四 实验效果

4.1数据集

4.2 对比模型

4.3实施细节

4.4评估指标

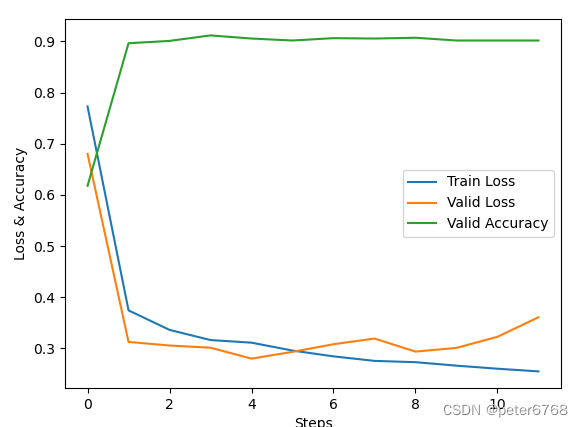

4.5 实验结果

4.6 细粒度分析

五 总结

我们提出的模型使用注意力技术来采用短语嵌入。这些实验描绘了我们模型的高性能结果。我们的结果强调,自注意力生成的嵌入提供了更好的状态表示并提高了摘要质量。我们的模型在 MCQ 和 DAC 数据集上比类似模型实现了更高的性能。这项工作在三个方面与其他模型不同。首先,它利用反映更好文档结构的树注意力模型。其次,它利用自注意力模块来生成有效的嵌入主题。第三,提取的特征在学习阶段进行扎根和加权,同时关注过去分类的短语。我们相信,将支持学习与短语到短语的训练目标相结合是未来研究的激励之路。另一项工作必须集中于建议除 ROUGE 分数之外的新评估指标,以改进摘要任务,特别是对于长短语。