前言

在日常App开发中,难免有些功能是需要借助NDK来完成的,比如现在常见的音视频处理等,今天就以ffmpeg入手,来学习下Android NDK开发的套路.

JNI和NDK

很多人并不清除JNI和NDK的概念,经常搞混这两样东西,先来看看它们各自的定义吧.

JNI和NDK

很多人并不清除JNI和NDK的概念,经常搞混这两样东西,先来看看它们各自的定义吧.

设计目的

标准的java类库不支持你的程序所需的特性。或者你已经有了一个用其他语言写成的库或程序,而你希望在java程序中使用它。或者是你需要一个高性能的库来完成一些操作.

使用步骤

- 编写带有native声明的方法的java类

- 使用javac命令编译所编写的java类

- 然后使用javah + java类名生成扩展名为h的头文件

- 使用C/C++实现本地方法

- 将C/C++编写的文件生成动态连接库*(在Android中就是.so库)

- java代码中调用native方法

NDK

NDK全称Native Development Kit,是Android的一个开发工具包,与Java并没有什么关系.

NDK的核心目的之一是让您将 C 和 C++ 源代码构建为可用于应用的共享库。嗯,就是它提供了交叉编译的功能.

CPU架构

我们都知道 CPU 是什么,那 CPU 架构到底是什么呢?回归到“架构”这个词本身含义,CPU 架构就是 CPU 的框架结构、设计方案,处理器厂商以某种架构为基础,生产自己的 CPU,就好比“总-分-总”是文章的一种架构,多篇文章可以都基于“总-分-总”架构。

常见的 CPU 架构有 x86、x86-64 以及 arm 等, x86-64 其实也是基于 x86 架构,只是在 x86 的基础上做了一些扩展,以支持 64 位程序的应用,常见的 Intel 、AMD 处理器都是基于 x86 架构的。

而 x86 架构主打的是 pc 端,对于移动端,arm 架构处于霸主地位 ,由于其体积小、低功耗、低成本、高性能的优点,被广泛应用在嵌入式系统中,目前大多数安卓、苹果手机的 CPU 都基于 arm 架构,此处所说的 arm 架构指 arm 系列架构,其中包括 ARMv5 、ARMv7 等等。

最后再看 Android 端 , Android 系统目前支持 ARMv5、ARMv7、ARMv8、 x86 、x86_64、MIPS 以及 MIPS64 共七种 CPU 架构,也就是说除此之外其他 CPU 架构的硬件并不能运行 Android 系统。

交叉编译

在某个平台上,编译该平台的可执行程序,叫做本地编译,比如在 Windows 平台上编译 Windows 自身的可执行程序;在 x86 平台上,编译 x86 平台自身的可执行程序。

在某个平台上,编译另一种平台的可执行程序,就是交叉编译,比如在 x86 平台上,编译 arm 平台的可执行程序,这也是 Android 端使用最多的交叉编译类型。

在交叉编译时,由于主机与目标的体系架构、环境不同,所以交叉编译比本地编译复杂很多,需要一些工具来解决主机与目标不同特性的问题,这些工具构成的工具集就叫做交叉编译链。

既然交叉编译比本地复杂很多,那为什么不使用本地编译,比如在 arm 平台编译 arm 平台的可执行程序呢?这是因为目标平台存储空间和计算能力通常是有限的,而编译过程需要较大的存储空间和较快的计算能力,但目标平台无法提供。

相关学习资料推荐,点击下方链接免费报名,先码住不迷路~】

音视频免费学习地址:FFmpeg/WebRTC/RTMP/NDK/Android音视频流媒体高级开发

【免费分享】音视频学习资料包、大厂面试题、技术视频和学习路线图,资料包括(C/C++,Linux,FFmpeg webRTC rtmp hls rtsp ffplay srs 等等)有需要的可以点击788280672加群免费领取~

项目中使用NDK

这里可以查看一篇官方文档,中文,写的很详细:向您的项目添加C和C++ 代码,强烈建议认真阅读下这部分文档

CMake

NDK的构建有两种方式,一种是早期使用的ndk-build,一种是在Android Studio2.2之后推荐使用的cmake,我们今天只说推荐的cmake这种方式.

CMakeLists.txt的写法

- add_library 使用指定的源文件将库添加到项目中

- 普通库

// 添加普通库的语法

add_library(<name> [STATIC | SHARED | MODULE]

[EXCLUDE_FROM_ALL]

[source1] [source2 ...])

// 创建ndk项目中默认生成的例子

add_library( # Sets the name of the library.

native-lib

# Sets the library as a shared library.

SHARED

# Provides a relative path to your source file(s).

src/main/cpp/native-lib.cpp )name属性没什么好说的,注意全局唯一就好.

[STATIC | SHARED | MODULE]的话是生成的库的类型,STATIC的话生成的是静态库,也就是.a后缀的.我们一般用的都是SHARED生成动态链接库,也就是.so后缀的.

导入库

// 语法

add_library(<name> <SHARED|STATIC|MODULE|OBJECT|UNKNOWN> IMPORTED

[GLOBAL])

// 导入编译好的ffmpeg样例

add_library( ffmpeg

SHARED

IMPORTED )

// 设置需要导入的ffmpeg位置

set_target_properties( ffmpeg

PROPERTIES IMPORTED_LOCATION

../../../../libs/armeabi-v7a/libffmpeg.so ) -

- 这种方式可以把我们在外部编译好的.so库导进来

- 还有几种我也没用过了,可以参考官方文档看下add_library

include_directories 用来导入相关头文件

include_directories(src/main/cpp)find_library用来引入NDK中提供的库.Android NDK 原生 API

find_library(

# 定义存储NDK库位置的路径变量的名称。

log-lib

# 指定CMake要查找的NDK库的名称。

log )target_link_libraries将导入的库和自己的原生库关联起来

target_link_libraries(

# 指定目标库。

native-lib

# 将目标库链接到NDK中包含的日志库。

${log-lib} )FFmpeg

FFmpeg是一套可以用来记录、处理数字音频、视频,并将其转换为流的开源框架,采用LPL或GPL许可证,提供了录制、转换以及流化音视频的完整解决方案。名称中的mpeg来自视频编码标准mpeg,而前缀FF是Fast Forward的首字母缩写.音视频处理的开源库,可以完成绝大多数音视频相关的功能.很多知名软件,开源库都是基于它进行的二次开发,比如bilibi的ijkPlayer.

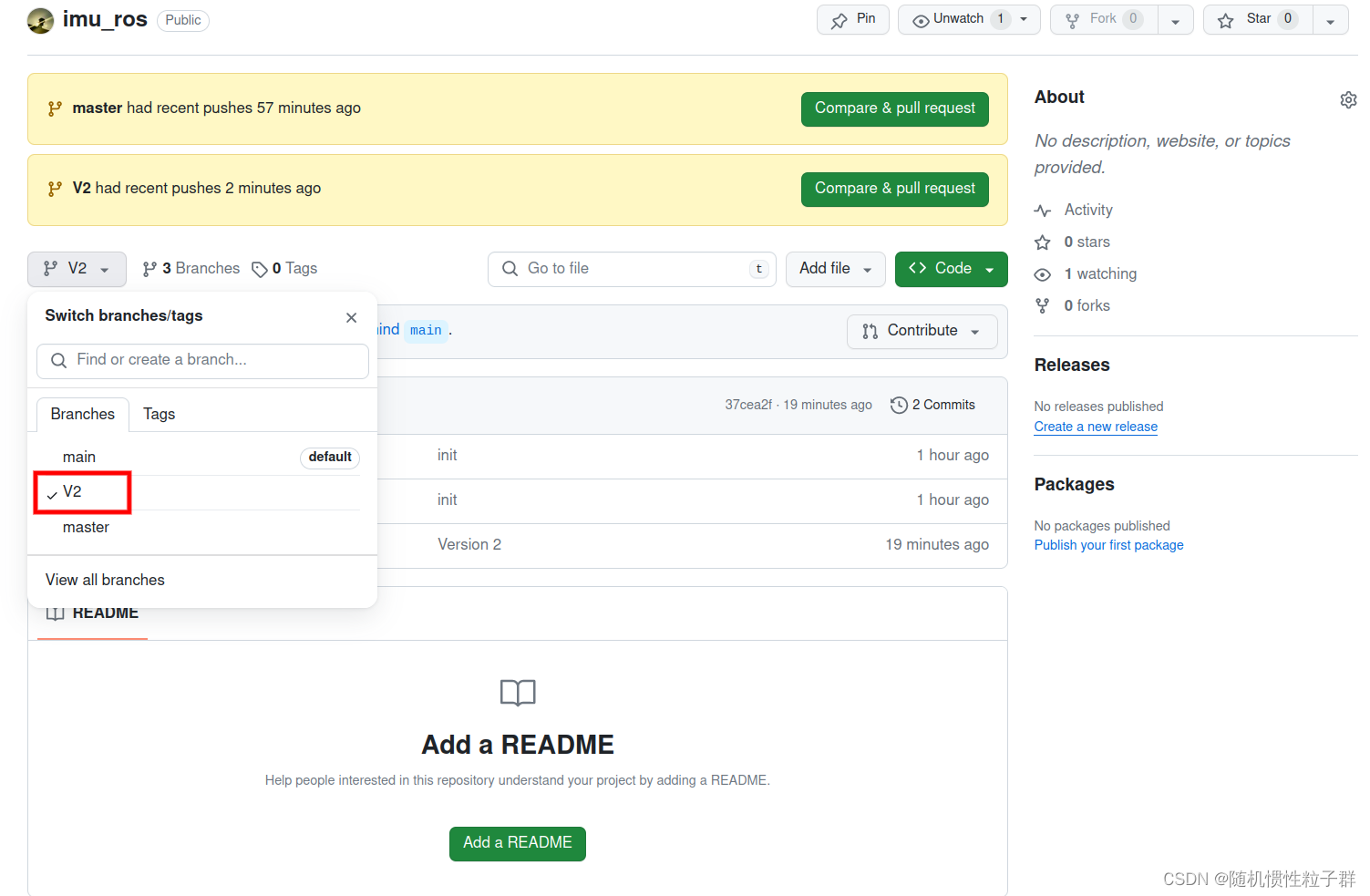

GitHub链接

编译FFmpeg

FFmpeg与大部分GNU软件的编译方式类似,都是通过configure脚本来实现编译前的定制,这种方式允许用户在编译前对软件进行裁剪,同时通过对最终运行到的系统及目标平台的配置来决定对某些模块设定合适的配置.所以这里是通过configure的方式来生成Makefile文件,然后使用make和make install编译和安装.

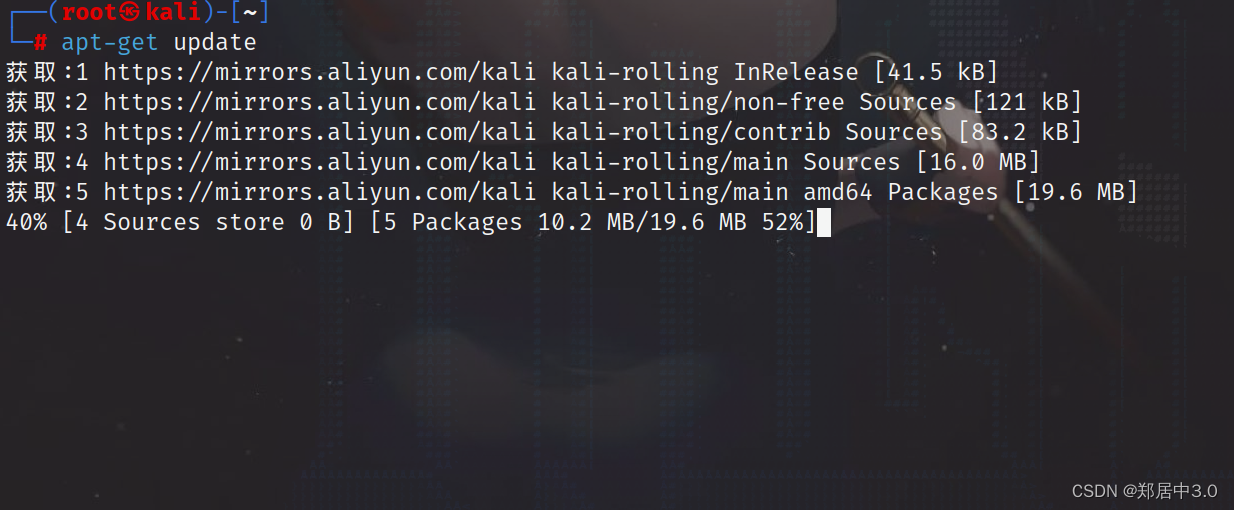

配置环境

首先我们需要先准备相关的编译环境,这里推荐在linux下进行编译,配置简单问题少.当然Mac也行,不推荐Windows.

- Linux环境(Ubuntu 16.04)

Windows的话下载个VMware Workstation,装个ubuntu还是方便的. - NDK环境 这里使用的是ndk-r17,附上相关下载链接NDK 下载

- 下载FFmpeg源码FFmpeg下载地址

修改configure文件

由于FFmpeg默认生成的库文件格式为libavcodec.so.xx.xx.x。其中的xx就是主副版本号,这种格式在Ubuntu下使用是没有问题的,但是在Android下开发使用,并不把其作为有效的库文件。所以需要修改其他生成的文件名的格式。

通过修改configure文件要实现,打开configure,找到如下内容:

SLIBNAME_WITH_MAJOR='$(SLIBNAME).$(LIBMAJOR)'

LIB_INSTALL_EXTRA_CMD='?(RANLIB)"$(LIBDIR)/$(LIBNAME)"'

SLIB_INSTALL_NAME='$(SLIBNAME_WITH_VERSION)'

SLIB_INSTALL_LINKS='$(SLIBNAME_WITH_MAJOR)$(SLIBNAME)'修改为:

SLIBNAME_WITH_MAJOR='$(SLIBPREF)$(FULLNAME)-$(LIBMAJOR)$(SLIBSUF)'

LIB_INSTALL_EXTRA_CMD='?(RANLIB)"$(LIBDIR)/$(LIBNAME)"'

SLIB_INSTALL_NAME='$(SLIBNAME_WITH_MAJOR)'

SLIB_INSTALL_LINKS='$(SLIBNAME)'

编写脚本文件 在FFmpeg根目录下创建build.sh脚本文件,来更方便的配置configure.如下:

#!/bin/bash

# 配置NDK路径

NDK=/home/xinyang/develop/android-ndk-r17

# 指定了交叉编译环境,使其在编译过程中能够引用到 NDK 提供的原生标头和共享库文件

SYSROOT=$NDK/platforms/android-23/arch-arm/

TOOLCHAIN=$NDK/toolchains/arm-linux-androideabi-4.9/prebuilt/linux-x86_64

# 声明方法

function build_one

{

./configure \

--prefix=$PREFIX \ # 设置输出路径

--enable-shared \ # 打开动态库输出

--disable-static \ # 关闭静态库输出

--disable-doc \ # 关闭不需要的功能

--disable-ffmpeg \

--disable-ffplay \

--disable-ffprobe \

--disable-avdevice \

--disable-symver \

--cross-prefix=$TOOLCHAIN/bin/arm-linux-androideabi- \ # 指定交叉编译工具链

--target-os=linux \ # 目标系统 android基于linux 所以这里指定为linux

--arch=armeabi-v7a \ # 目标平台架构

--enable-cross-compile \# 开启交叉编译

--sysroot=$SYSROOT \ # 交叉编译环境

--extra-cflags="-Os -fpic $ADDI_CFLAGS" \

--extra-ldflags="$ADDI_LDFLAGS" \

$ADDITIONAL_CONFIGURE_FLAG

make clean

make

make install

}

CPU=armeabi-v7a

PREFIX=$(pwd)/android/$CPU

ADDI_CFLAGS="-marm"

build_one--cross-prefix

类似于通配符方式指定 bin 目录下以 arm-linux-androideabi- 开头的交叉编译工具,假如不支持这种配置方式则需分别指定:

- CC:$TOOLCHAIN/bin/arm-linux-androideabi-gcc 编译器,对C源文件进行编译处理,生成汇编文件.

- CXX:$TOOLCHAIN/bin/arm-linux-androideabi-g++

- AR:$TOOLCHAIN/bin/arm-linux-androideabi-ar 打包器,用于库操作,可以通过该工具从一个库中删除或者增加目标代码模块.

- LD:$TOOLCHAIN/bin/arm-linux-androideabi-ld 链接器,为前面生成的目标代码分配地址空间,将多个目标文件链接成一个库或是可执行文件.

执行脚本cd 到ffmpeg目录下

chmod 777 build.sh首先修改下脚本文件的可执行权限

./build.sh- 然后执行脚本,整个过程比较慢,耐心等待就好,整个过程大概需要5-10分钟.编译完成后就可以看到如下图,其中

include中是一些头文件,lib中就是生成的.so动态库了

集成FFmpeg

到这里就可以把生成的.so文件集成到我们的项目中了,来看看步骤:

- 项目关联NDK,按这里的教程执行向您的项目添加C和C++ 代码;

- 拷贝生成的.so文件到

libs目录下(或是jniLibs); - 拷贝生成的

include文件夹到cpp目录; - 拷贝

ffmpeg\fftools目录下文件到cpp目录; - 编写

native方法

package com.xinyang.ndkdemo;

public class FFmpegCmd {

static {

System.loadLibrary("ffmpeg");

}

public native static void handle();

}在cpp目录下创建ffmpeg_cmd.c文件,实现native方法,这里可以采用javah生成头文件再实现的方式,也可以直接在java类中使用快捷键提示,直接生成方法:

#include <jni.h>

#include <malloc.h>

#include <string.h>

#include <android/log.h>

#include "ffmpeg/ffmpeg.h"

JNIEXPORT void JNICALL Java_com_xinyang_ndkdemo_FFmpegCmd_handle

(JNIEnv *env, jclass obj){

char info[40000] = {0};

av_register_all();

AVCodec *c_temp = av_codec_next(NULL);

while(c_temp != NULL){

if(c_temp->decode!=NULL){

sprintf(info,"%s[Dec]",info);

}else{

sprintf(info,"%s[Enc]",info);

}

switch(c_temp->type){

case AVMEDIA_TYPE_VIDEO:

sprintf(info,"%s[Video]",info);

break;

case AVMEDIA_TYPE_AUDIO:

sprintf(info,"%s[Audio]",info);

break;

default:

sprintf(info,"%s[Other]",info);

break;

}

sprintf(info,"%s[%10s]\n",info,c_temp->name);

c_temp=c_temp->next;

}

__android_log_print(ANDROID_LOG_INFO,"myTag","info:\n%s",info);

}这段程序用于输出 FFmpeg 支持的编解码信息,通过 < android/log.h > 的 __android_log_print 方法可以直接将信息输出到 Android Studio 的 logcat 。

编辑CMakeLists.txt导入相关.so文件,使用add_library导入库的方式把生成的.so文件依次导入,使用include_directories导入头文件,最后再用target_link_libraries把导入的库和生成的目标库关联起来,如下所示:

# For more information about using CMake with Android Studio, read the

# documentation: https://d.android.com/studio/projects/add-native-code.html

# Sets the minimum version of CMake required to build the native library.

cmake_minimum_required(VERSION 3.4.1)

# Creates and names a library, sets it as either STATIC

# or SHARED, and provides the relative paths to its source code.

# You can define multiple libraries, and CMake builds them for you.

# Gradle automatically packages shared libraries with your APK.

add_library( # Sets the name of the library.

ffmpeg

# Sets the library as a shared library.

SHARED

# Provides a relative path to your source file(s).

src/main/cpp/ffmpeg_cmd.c

src/main/cpp/ffmpeg/cmdutils.c

src/main/cpp/ffmpeg/ffmpeg.c

src/main/cpp/ffmpeg/ffmpeg_filter.c

src/main/cpp/ffmpeg/ffmpeg_opt.c

)

include_directories(src/main/cpp)

include_directories(src/main/cpp/include)

add_library(

avutil-55

SHARED

IMPORTED

)

set_target_properties( avutil-55

PROPERTIES IMPORTED_LOCATION

../../../../libs/armeabi-v7a/libavutil-55.so )

add_library(

avcodec-57

SHARED

IMPORTED

)

set_target_properties( avcodec-57

PROPERTIES IMPORTED_LOCATION

../../../../libs/armeabi-v7a/libavcodec-57.so )

add_library(

avformat-57

SHARED

IMPORTED

)

set_target_properties( avformat-57

PROPERTIES IMPORTED_LOCATION

../../../../libs/armeabi-v7a/libavformat-57.so )

add_library(

avdevice-57

SHARED

IMPORTED

)

set_target_properties( avdevice-57

PROPERTIES IMPORTED_LOCATION

../../../../libs/armeabi-v7a/libavdevice-57.so )

add_library(

swresample-2

SHARED

IMPORTED

)

set_target_properties( swresample-2

PROPERTIES IMPORTED_LOCATION

../../../../libs/armeabi-v7a/libswresample-2.so )

add_library(

swscale-4

SHARED

IMPORTED

)

set_target_properties( swscale-4

PROPERTIES IMPORTED_LOCATION

../../../../libs/armeabi-v7a/libswscale-4.so )

add_library(

postproc-54

SHARED

IMPORTED

)

set_target_properties( postproc-54

PROPERTIES IMPORTED_LOCATION

../../../../libs/armeabi-v7a/libpostproc-54.so )

add_library(

avfilter-6

SHARED

IMPORTED

)

set_target_properties( avfilter-6

PROPERTIES IMPORTED_LOCATION

../../../../libs/armeabi-v7a/libavfilter-6.so )

# Searches for a specified prebuilt library and stores the path as a

# variable. Because CMake includes system libraries in the search path by

# default, you only need to specify the name of the public NDK library

# you want to add. CMake verifies that the library exists before

# completing its build.

find_library( # Sets the name of the path variable.

log-lib

# Specifies the name of the NDK library that

# you want CMake to locate.

log )

# Specifies libraries CMake should link to your target library. You

# can link multiple libraries, such as libraries you define in this

# build script, prebuilt third-party libraries, or system libraries.

target_link_libraries( # Specifies the target library.

ffmpeg

avutil-55

avcodec-57

avformat-57

avdevice-57

swresample-2

swscale-4

postproc-54

avfilter-6

# Links the target library to the log library

# included in the NDK.

${log-lib} )试着调用native方法,在logcat中查看具体输出信息,如下:

总结

总的来说使用CMake方式还是比较简单的,编写CMakeLists.txt文件,在gradle中指定文件位置就好.重点在于相关库的交叉编译及编写调用相关api文件的C文件,这里就需要一些C的基础了.

原文 Android中集成FFmpeg及NDK基础知识 - 掘金