在文本分类任务做科研写论文的时候,我们有时候需要对对数据集的大小进行分析,如果你想统计CSV文件中某一列英语句子的单词个数(不包含标题),可以使用Python的split()函数将句子拆分为单词,并计算单词的个数,具体实现代码和结果分析如下。

目录

一、Python实现

二、测试结果

一、Python实现

import csv

# 读取CSV文件

filename = 'your_file.csv' # 请替换成你的CSV文件路径

with open(filename, 'r', newline='', encoding='utf-8') as csvfile:

reader = csv.reader(csvfile)

next(reader) # 跳过标题行

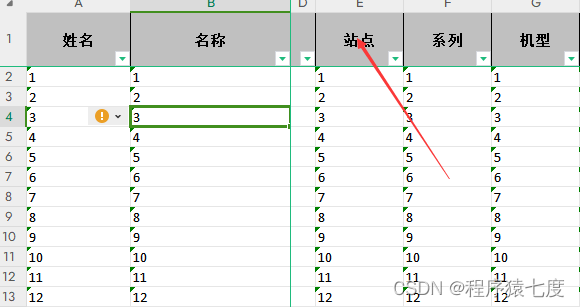

word_counts = [len(row[1].split()) for row in reader] # 假设你想要获取第二列句子的单词个数

# 统计单词个数

total_sentences = len(word_counts)

average_words = sum(word_counts) / total_sentences

# 打印结果

print("句子总数:", total_sentences)

print("平均单词数:", average_words)二、测试结果

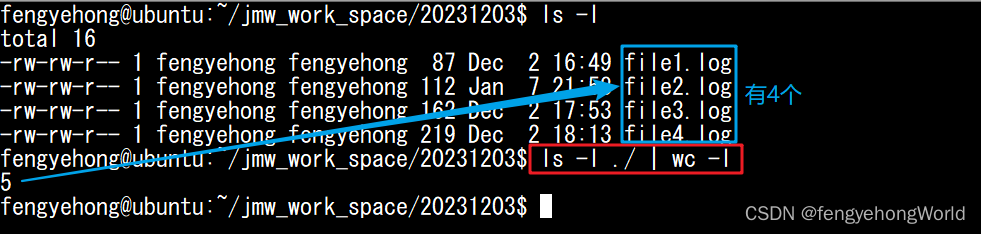

下面对一个英文句子长度统计,按照上述方法

print(len('watching and loving the Thunderbirds.'.split()))输出结果:5 ,是正确的

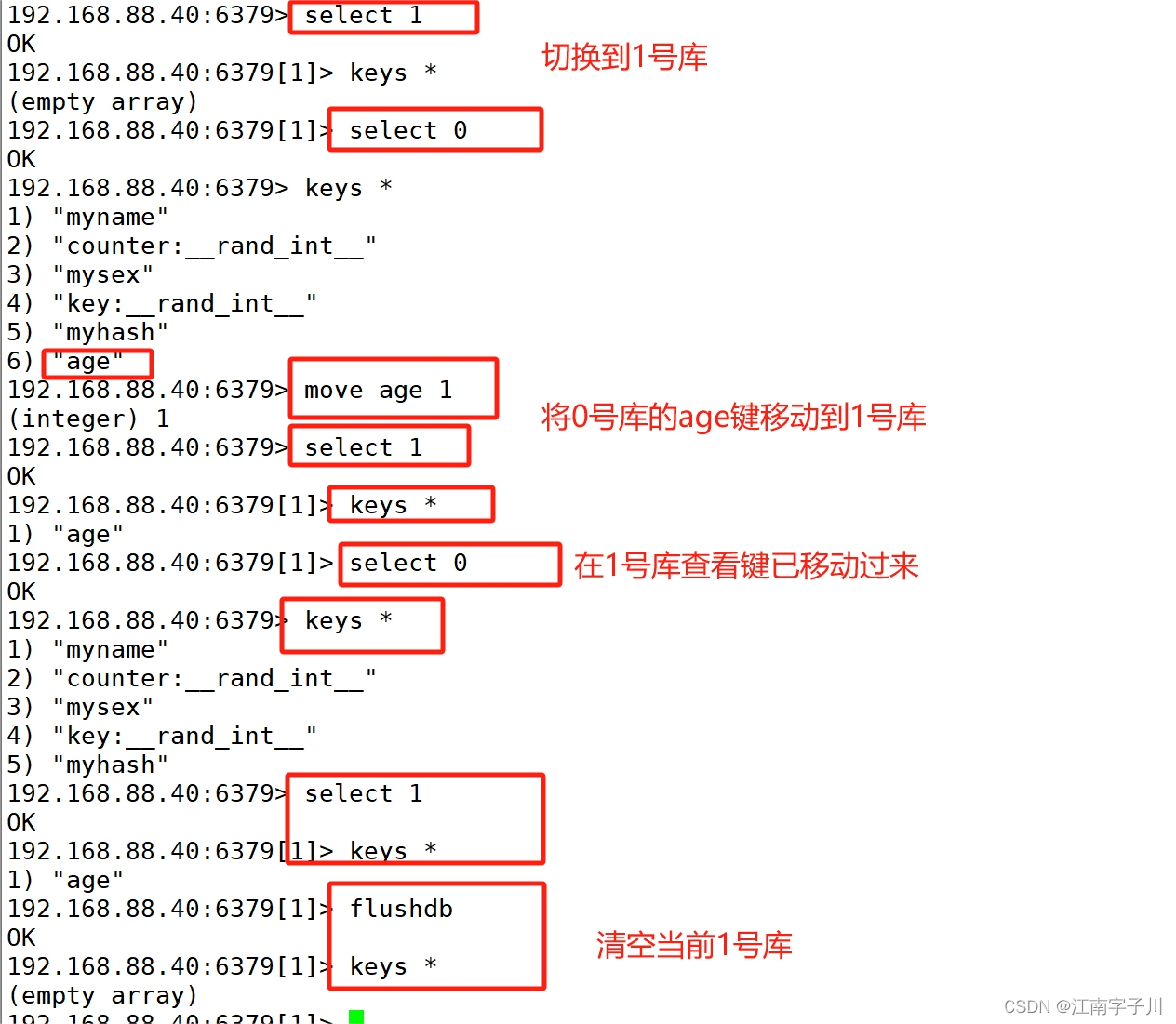

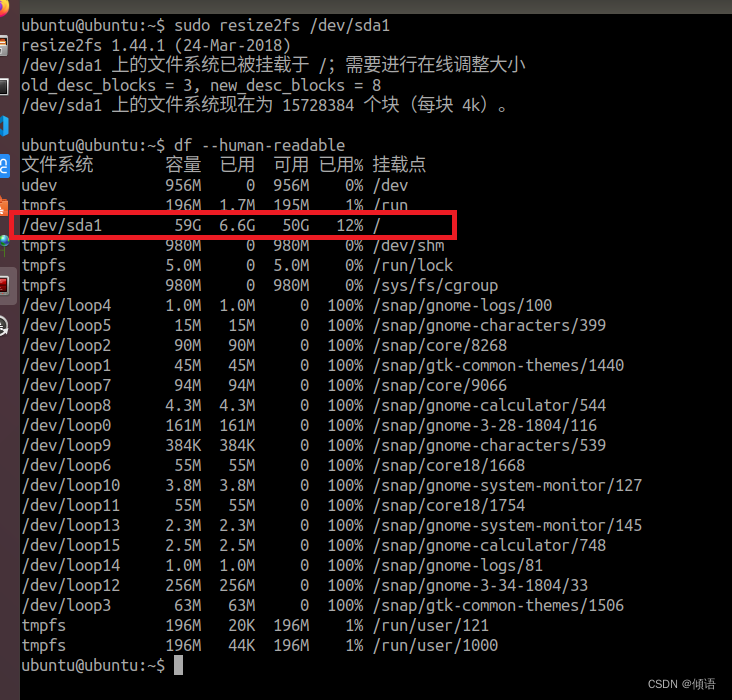

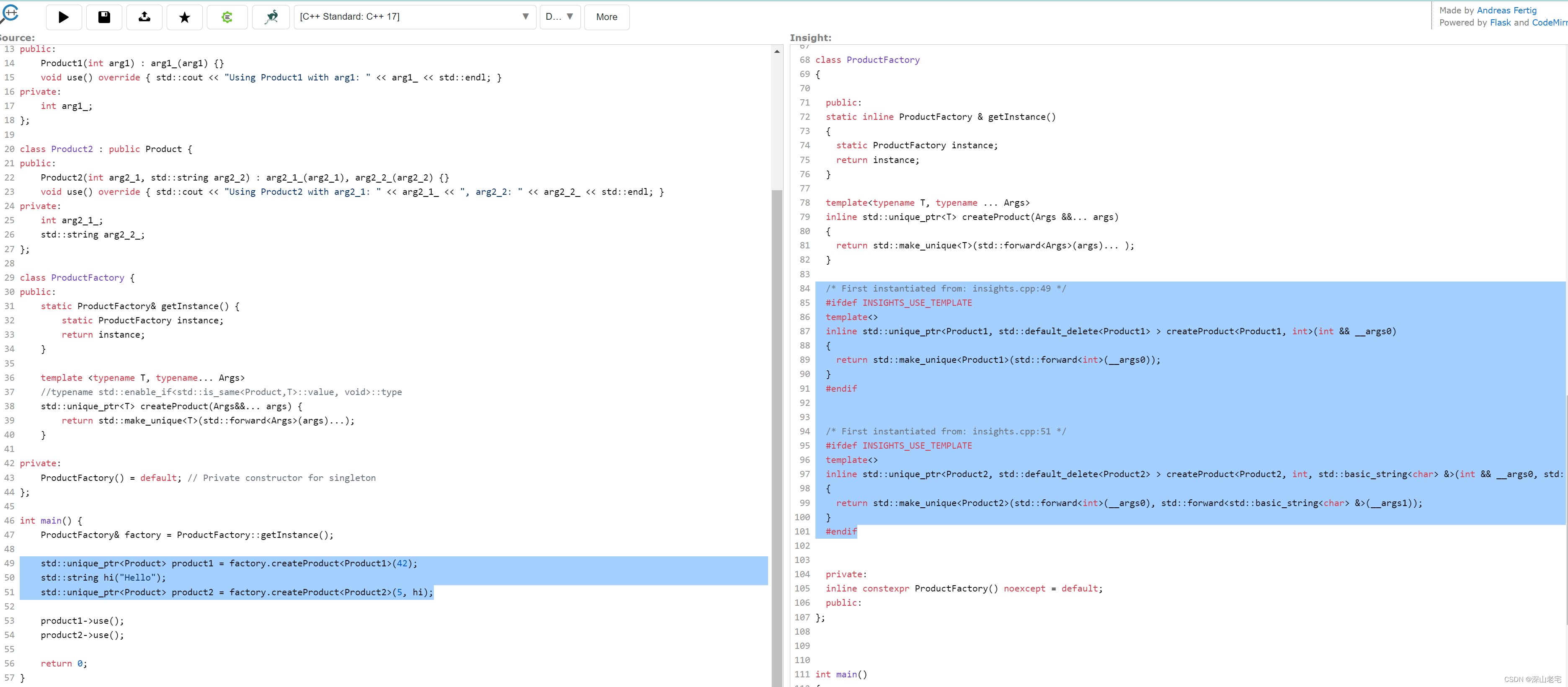

同时我用上述方法统计GLUE等相关数据集的训练集和测试集平均长度结果如下: