神经网络所处理的数据类型都为tensor类型数据,我们首先需要导入库torch

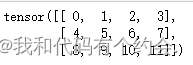

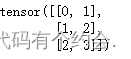

import torch使用 arange 创建一个行向量 x。这个行向量包含以0开始的前12个整数,它们默认创建为整数。除非额外指定,新的张量将存储在内存中,并采用基于CPU的计算。

x = torch.arange(12)

x![]()

可以通过张量的shape属性来访问张量(沿每个轴的长度)的形状 。

x.shape![]()

如果只想知道张量中元素的总数,即形状的所有元素乘积,可以检查它的大小(size)。numel即Number of elements的缩写

x.numel() ![]()

要想改变一个张量的形状而不改变元素数量和元素值,可以调用reshape函数。

X = x.reshape(3, 4)

X

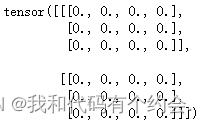

有时,我们希望使用全0、全1、其他常量,或者从特定分布中随机采样的数字来初始化矩阵。 我们可以创建一个形状为(2,3,4)的张量,其中所有元素都设置为0。

torch.zeros((2, 3, 4))

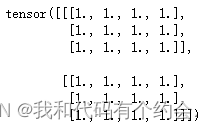

同样,我们可以创建一个形状为(2,3,4)的张量,其中所有元素都设置为1。

torch.ones((2, 3, 4))

每个元素都从均值为0、标准差为1的标准高斯分布(正态分布)中随机采样。

torch.randn(3, 4)

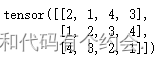

通过提供包含数值的Python列表(或嵌套列表),来为所需张量中的每个元素赋予确定值

torch.tensor([[2, 1, 4, 3], [1, 2, 3, 4], [4, 3, 2, 1]])

对于任意具有相同形状的张量, 常见的标准算术运算符(+、-、、/和*)都可以被升级为按元素运算。 我们可以在同一形状的任意两个张量上调用按元素操作。

x = torch.tensor([1.0, 2, 4, 8])

y = torch.tensor([2, 2, 2, 2])

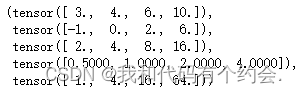

x + y, x - y, x * y, x / y, x ** y # **运算符是求幂运算

“按元素”方式可以应用更多的计算,包括像求幂这样的一元运算符。

torch.exp(x)![]()

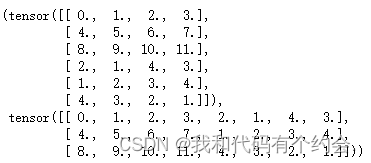

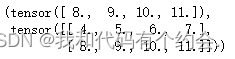

我们也可以把多个张量连结(concatenate)在一起, 把它们端对端地叠起来形成一个更大的张量。 我们只需要提供张量列表,并给出沿哪个轴连结。 要连接那一维指定那一维

X = torch.arange(12, dtype=torch.float32).reshape((3,4))

Y = torch.tensor([[2.0, 1, 4, 3], [1, 2, 3, 4], [4, 3, 2, 1]])

torch.cat((X, Y), dim=0), torch.cat((X, Y), dim=1)

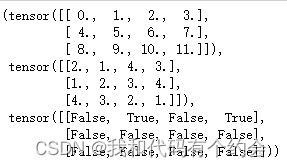

有时,我们想通过逻辑运算符构建二元张量。 以X == Y为例: 对于每个位置,如果X和Y在该位置相等,则新张量中相应项的值为1。 这意味着逻辑语句X == Y在该位置处为真,否则该位置为0。

X,Y,X == Y

对张量中的所有元素进行求和,会产生一个单元素张量。

X.sum()![]()

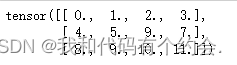

在大多数情况下,我们将沿着数组中长度为1的轴进行广播,如下例子:

a = torch.arange(3).reshape((3, 1))

b = torch.arange(2).reshape((1, 2))

a, b

由于a和b分别是3x1和1x2矩阵,如果让它们相加,它们的形状不匹配。 我们将两个矩阵广播为一个更大的3x2矩阵,如下所示:矩阵a将复制列, 矩阵b将复制行,然后再按元素相加。

a + b

就像在任何其他Python数组中一样,张量中的元素可以通过索引访问。 与任何Python数组一样:第一个元素的索引是0,最后一个元素索引是-1; 可以指定范围以包含第一个元素和最后一个之前的元素。

如下所示,我们可以用[-1]选择最后一个元素,可以用[1:3]选择第二个和第三个元素:

X[-1], X[1:3]

除读取外,我们还可以通过指定索引来将元素写入矩阵。

X[1, 2] = 9

X

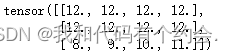

如果我们想为多个元素赋值相同的值,我们只需要索引所有元素,然后为它们赋值。 例如,[0:2, :]访问第1行和第2行,其中“:”代表沿轴1(列)的所有元素。 虽然我们讨论的是矩阵的索引,但这也适用于向量和超过2个维度的张量。

X[0:2, :] = 12

X

将深度学习框架定义的张量转换为NumPy张量(ndarray)很容易,反之也同样容易。 torch张量和numpy数组将共享它们的底层内存,就地操作更改一个张量也会同时更改另一个张量。

A = X.numpy()

B = torch.tensor(A)

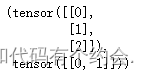

type(A), type(B)要将大小为1的张量转换为Python标量,我们可以调用item函数或Python的内置函数

a = torch.tensor([3.5])

a, a.item(), float(a), int(a)