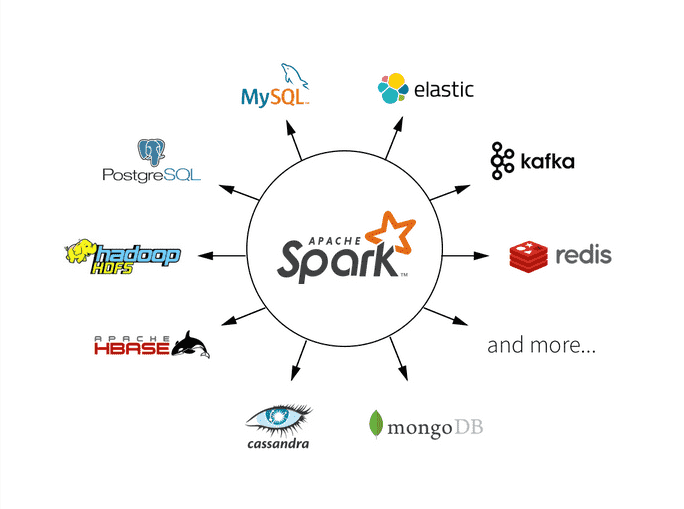

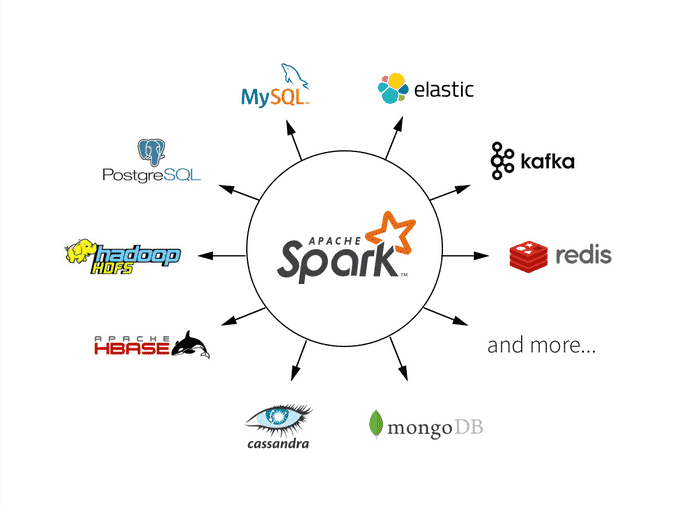

Apache Spark是一个强大的分布式计算框架,用于处理大规模数据。了解Spark应用程序的结构和驱动程序是构建高效应用的关键。本文将深入探讨Spark应用程序的组成部分,以及如何编写一个Spark驱动程序来处理数据和执行计算。

Spark应用程序的结构

Spark应用程序通常由以下几个主要组成部分构成:

1 驱动程序(Driver Program)

驱动程序是Spark应用程序的核心组件,它负责协调和管理应用程序的执行。驱动程序通常位于集群的一个节点上,并负责分配任务给集群中的各个工作节点。驱动程序还维护应用程序的状态和元数据信息。

2 Spark上下文(SparkContext)

Spark上下文是与Spark集群通信的主要入口点。在驱动程序中,您需要创建一个SparkContext对象,它将用于与集群通信,设置应用程序的配置选项,并创建RDD(弹性分布式数据集)。

from pyspark import SparkContext

sc = SparkContext("local", "MyApp")

3 RDD(弹性分布式数据集)

RDD是Spark的核心数据抽象,用于表示分布式数据集。RDD是不可变的、分区的、可并行处理的数据集合,可以通过转换操作和行动操作进行操作。RDD可以从外部数据源创建,也可以通过转换操作从现有RDD派生而来。

data = [1, 2, 3, 4, 5]

rdd = sc.parallelize(data)

4 转换操作(Transformations)

转换操作是对RDD进行变换的操作,它们创建一个新的RDD作为结果。常见的转换操作包括map、filter、reduceByKey等,用于对数据进行过滤、映射和聚合。

result_rdd = rdd.map(lambda x: x * 2)

5 行动操作(Actions)

行动操作是触发计算并返回结果的操作。行动操作会触发Spark作业的执行,例如count、collect、saveAsTextFile等。行动操作会从集群中收集结果并返回给驱动程序。

count = result_rdd.count()

编写Spark驱动程序

下面将演示如何编写一个简单的Spark驱动程序来执行一个Word Count示例。这个示例将统计文本文件中每个单词的出现次数。

from pyspark import SparkContext

# 创建SparkContext

sc = SparkContext("local", "WordCountExample")

# 读取文本文件

text_file = sc.textFile("sample.txt")

# 切分文本为单词

words = text_file.flatMap(lambda line: line.split(" "))

# 计数每个单词出现的次数

word_counts = words.countByValue()

# 打印结果

for word, count in word_counts.items():

print(f"{word}: {count}")

# 停止SparkContext

sc.stop()

在这个示例中,首先创建了一个SparkContext对象,然后使用textFile方法读取文本文件,切分文本为单词,并使用countByValue操作计算每个单词的出现次数。最后,打印结果并停止SparkContext。

性能优化和注意事项

在编写Spark应用程序时,需要考虑性能优化和一些注意事项:

1 持久化(Persistence)

在迭代计算中,可以使用persist操作将RDD的中间结果缓存到内存中,以避免重复计算。这可以显著提高性能。

rdd.persist()

2 数据分区和并行度

合理设置数据分区和并行度可以充分利用集群资源,提高计算性能。可以使用repartition操作来调整数据分区。

rdd = rdd.repartition(100)

3 数据倾斜处理

处理数据倾斜是一个重要的性能优化问题。可以使用reduceByKey的变体来减轻数据倾斜。

word_counts = words.map(lambda word: (word, 1)).reduceByKey(lambda a, b: a + b)

Spark集群与部署模式

在构建Spark应用程序时,需要考虑如何部署应用程序到Spark集群上。Spark支持多种部署模式,包括本地模式、独立集群模式、YARN模式等。选择合适的部署模式取决于需求和集群环境。

-

本地模式:用于本地开发和测试,Spark应用程序在本地机器上运行,不需要搭建集群。

-

独立集群模式:在独立的Spark集群上运行应用程序,适用于生产环境。您需要配置Spark的独立集群管理器,如Spark Standalone或Mesos。

-

YARN模式:将Spark应用程序提交到Hadoop集群上的YARN资源管理器。这种模式适用于与Hadoop生态系统集成的场景。

根据需求和集群环境,选择合适的部署模式,并在驱动程序中进行相应的配置。

Spark作业的监控和调优

在生产环境中,监控和调优Spark作业是非常重要的。Spark提供了一些工具和界面,帮助监控作业的执行情况,识别性能问题并采取措施进行调优。

-

Spark UI:通过Spark UI,可以查看作业的进度、任务的执行情况、内存使用情况等信息。这个界面对于监控作业非常有帮助。

-

Spark事件日志:Spark可以将作业的事件日志写入文件,可以分析这些日志以了解作业的性能瓶颈。

-

资源管理和配置:调优Spark作业还涉及到资源管理和Spark的配置。可以为每个作业分配适当的资源,调整内存和CPU的分配,并配置Spark参数以提高性能。

示例:使用Spark Streaming处理实时数据

除了批处理作业外,Spark还支持流处理作业。以下是一个示例,演示如何使用Spark Streaming处理实时数据:

from pyspark import SparkContext

from pyspark.streaming import StreamingContext

# 创建SparkContext

sc = SparkContext("local", "StreamingExample")

# 创建StreamingContext,每隔1秒处理一批数据

ssc = StreamingContext(sc, 1)

# 创建一个数据流,从TCP套接字读取数据

lines = ssc.socketTextStream("localhost", 9999)

# 切分每行文本为单词并计数

words = lines.flatMap(lambda line: line.split(" "))

word_counts = words.countByValue()

# 打印结果

word_counts.pprint()

# 启动流处理

ssc.start()

ssc.awaitTermination()

在这个示例中,首先创建了一个StreamingContext,用于处理实时数据流。然后,创建了一个数据流,从TCP套接字读取数据,切分文本为单词并计数,最后打印结果。流处理作业在每隔1秒处理一批数据。

总结

本文深入探讨了Spark应用程序的结构和驱动程序,并提供了一个完整的示例来演示如何编写一个Spark驱动程序。还讨论了性能优化、部署模式、监控和调优以及流处理作业等关键概念。

希望本文帮助大家更好地理解Spark应用程序的构建和执行,以及如何应对不同的部署和调优需求。