在大数据领域,Spark和Hadoop是两个备受欢迎的分布式数据处理框架,它们在处理大规模数据时都具有重要作用。本文将深入探讨Spark与Hadoop之间的关系和区别,以帮助大家的功能和用途。

Spark和Hadoop简介

1 Hadoop

Hadoop是一个由Apache基金会维护的开源分布式数据处理框架。它包括两个核心组件:

- Hadoop分布式文件系统(HDFS):用于存储大规模数据的分布式文件系统。

- Hadoop MapReduce:用于分布式数据处理的编程模型和框架。

Hadoop最初是为批处理任务设计的,适用于对大规模数据进行批处理分析。

2 Spark

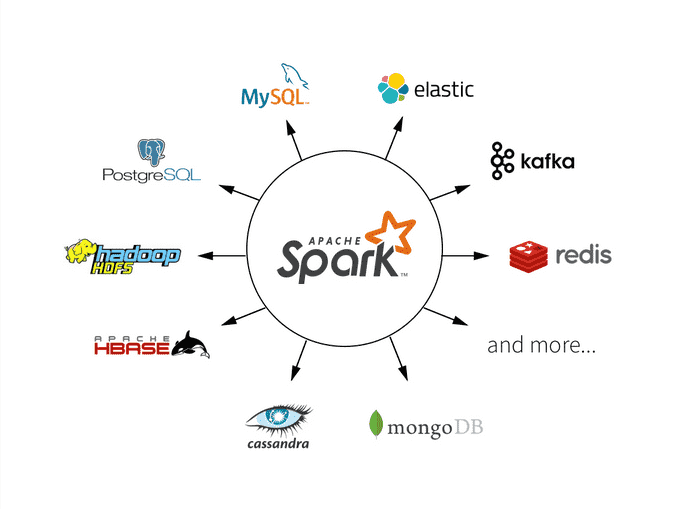

Spark也是一个由Apache基金会维护的开源分布式数据处理框架,但它提供了比Hadoop更多的灵活性和性能。Spark的核心特点包括:

- 基于内存的计算:Spark将数据存储在内存中,因此可以更快地处理数据。

- 多种API:Spark支持多种编程语言(如Scala、Java、Python)和API(如RDD、DataFrame、Streaming等)。

- 支持交互式查询:Spark允许用户在数据上运行SQL查询和实时流式处理。

Spark与Hadoop的关系

Spark与Hadoop之间存在密切的关系,事实上,Spark可以与Hadoop生态系统无缝集成。下面是一些Spark与Hadoop之间的关系:

1 Spark运行在Hadoop上

Spark可以运行在Hadoop集群之上,并与Hadoop的HDFS集成。这意味着可以使用Hadoop集群来存储和管理大规模数据,然后使用Spark来执行更高效的数据处理任务。

以下是一个使用Spark读取HDFS上的数据的示例代码:

from pyspark import SparkContext

sc = SparkContext("local", "HDFS Example")

hdfs_path = "hdfs://<HDFS_MASTER>:<HDFS_PORT>/path/to/your/data"

data = sc.textFile(hdfs_path)

2 Spark与Hive、HBase等整合

Spark可以与Hive(用于数据仓库)和HBase(用于NoSQL存储)等Hadoop生态系统中的其他工具无缝集成。这可以在Spark中查询Hive表或与HBase进行交互,以实现更复杂的数据处理需求。

以下是一个使用Spark连接Hive并查询数据的示例代码:

from pyspark.sql import SparkSession

spark = SparkSession.builder \

.appName("Hive Integration") \

.config("spark.sql.warehouse.dir", "/user/hive/warehouse") \

.enableHiveSupport() \

.getOrCreate()

result = spark.sql("SELECT * FROM my_hive_table")

3 Spark取代了Hadoop MapReduce

尽管Spark可以与Hadoop MapReduce共存,但在很多情况下,Spark已经取代了Hadoop MapReduce作为首选的数据处理引擎。Spark的内存计算和多API支持使其更适用于各种处理需求,而且性能更好。

以下是一个使用Spark来执行Word Count任务的示例代码,与传统的Hadoop MapReduce代码进行对比:

from pyspark import SparkContext

sc = SparkContext("local", "Word Count")

text_file = sc.textFile("hdfs://<HDFS_MASTER>:<HDFS_PORT>/path/to/your/textfile.txt")

word_counts = text_file.flatMap(lambda line: line.split(" ")) \

.map(lambda word: (word, 1)) \

.reduceByKey(lambda a, b: a + b)

word_counts.saveAsTextFile("hdfs://<HDFS_MASTER>:<HDFS_PORT>/path/to/your/output")

Spark与Hadoop的区别

虽然Spark与Hadoop有许多关系,但它们之间也存在一些重要的区别:

1 计算模型

- Hadoop使用批处理的MapReduce计算模型,适用于离线数据分析任务。

- Spark支持批处理、交互式查询、流式处理和机器学习等多种计算模型,更加灵活。

2 数据处理速度

- Spark使用内存计算,因此通常比Hadoop MapReduce更快。

- Hadoop MapReduce对于大规模离线批处理任务仍然是一个强大的选择。

3 编程接口

- Hadoop MapReduce需要编写更多的样板代码,相对较复杂。

- Spark提供多种编程语言和API,更容易上手。

Spark与Hadoop的适用场景

了解Spark与Hadoop的关系和区别后,还需要,以便更好地决定何时使用哪个框架。

1 使用Spark的场景

- 迭代算法:对于需要多次迭代的算法,如机器学习和图处理,Spark的内存计算特性可以显著提高性能。

- 实时数据处理:Spark Streaming和Structured Streaming支持实时数据处理,适用于需要快速响应数据的应用。

- 复杂数据流处理:如果需要进行复杂的数据流处理,例如窗口操作、状态管理和事件时间处理,Spark提供了强大的工具。

- 多种数据源:Spark支持多种数据源,包括HDFS、Kafka、Cassandra等,使其适用于多样化的数据存储和处理需求。

- 交互式查询:Spark SQL允许用户在数据上运行SQL查询,适用于需要交互式分析的场景。

2 使用Hadoop的场景

- 大规模批处理:如果有大规模的离线批处理任务,Hadoop MapReduce可能仍然是不错的选择。

- 成本敏感性:Hadoop通常在硬件成本较低的环境中运行,适用于对硬件资源敏感的情况。

- 稳定性与成熟性:Hadoop经过多年的发展和测试,被广泛认为是一个稳定和成熟的大数据框架。

- 整合Hive和HBase:如果已经在生产环境中使用Hive或HBase,那么Hadoop可能是更自然的选择,因为它们与Hadoop生态系统更紧密集成。

示例应用场景

为了更好地说明Spark和Hadoop的使用场景,以下是两个示例应用场景:

示例一:实时广告点击分析

假设正在构建一个广告点击分析平台,需要实时处理海量点击数据并生成实时报告。在这种情况下,Spark是更合适的选择,因为它支持实时数据处理,能够快速处理大量的事件流,并且具有易于使用的API。可以使用Spark Streaming或Structured Streaming来处理实时数据,并使用Spark SQL来查询和分析数据,最终生成实时报告。

示例二:离线批处理数据清洗

假设需要定期对大规模数据进行离线批处理数据清洗,以准备数据用于机器学习模型的训练。在这种情况下,Hadoop MapReduce可能是更合适的选择,因为它可以在廉价硬件上运行,并且适用于离线批处理任务。可以将数据存储在HDFS上,然后使用Hadoop MapReduce作业来清洗和准备数据。

总结

Spark与Hadoop都是强大的大数据处理框架,它们在大数据领域扮演着不同但重要的角色。了解它们之间的关系和区别以及适用场景对于在项目中做出正确的决策至关重要。根据具体需求和项目特点,可以灵活地选择使用Spark、Hadoop,或者两者的组合,以最大程度地发挥它们的优势。

无论选择哪个框架,都应该深入学习其文档和示例,以充分了解其功能和用法。大数据处理领域变化迅速,不断出现新的工具和技术,因此持续学习和更新知识是至关重要的。