🍎个人主页

🏆个人专栏:日常聊聊

⛳️ 功不唐捐,玉汝于成

目录

编辑

简介

步骤

1. 安装依赖库

2. 创建目录

3. 发送HTTP请求并解析页面

4. 查找图片标签并下载图片

注意事项

结语

我的其他博客

简介

网络爬虫是一种自动获取网页信息的程序,而Python由于其简洁而强大的语法,常被用于编写网络爬虫。在本博客中,我们将介绍一个简单的Python网络爬虫示例,用于爬取图片。该示例使用了第三方库

requests来发送HTTP请求,以及BeautifulSoup来解析HTML页面。

步骤

1. 安装依赖库

确保你已经安装了以下依赖库:

pip install requests beautifulsoup4

2. 创建目录

创建一个目录用于保存下载的图片,我们在示例中将其命名为downloaded_images。

import os

if not os.path.exists('downloaded_images'):

os.makedirs('downloaded_images')

3. 发送HTTP请求并解析页面

使用requests库发送HTTP请求获取页面内容,然后使用BeautifulSoup解析HTML页面。

import requests

from bs4 import BeautifulSoup

url = 'https://example.com' # 替换为实际的目标网站URL

response = requests.get(url)

html_content = response.text

soup = BeautifulSoup(html_content, 'html.parser')

4. 查找图片标签并下载图片

找到页面中的所有图片标签,遍历这些标签并下载图片。

from urllib.parse import urljoin

img_tags = soup.find_all('img')

for img_tag in img_tags:

img_url = img_tag.get('src')

img_url = urljoin(url, img_url)

img_data = requests.get(img_url).content

img_name = os.path.join('downloaded_images', os.path.basename(img_url))

with open(img_name, 'wb') as img_file:

img_file.write(img_data)

print(f'图片保存成功:{img_name}')

注意事项

- 实际网站可能有不同的HTML结构和图片链接格式,根据目标网站的具体情况进行适当的修改。

- 合法使用爬虫,尊重网站的robots.txt文件,避免对目标网站造成不必要的压力。

结语

这个简单的网络爬虫示例演示了如何使用Python获取网页内容并下载图片。通过学习这个例子,你可以进一步了解网络爬虫的基本原理和Python中常用的爬虫工具。在实际应用中,请确保遵守相关法律法规和网站的使用规定。希望这个博客能帮助你入门网络爬虫的世界!

我的其他博客

探索灵活性与可维护性的利器:策略(Strategy)模式详解-CSDN博客

深入探讨敏捷开发项目管理流程与Scrum工具:构建高效团队与卓越产品的秘诀-CSDN博客

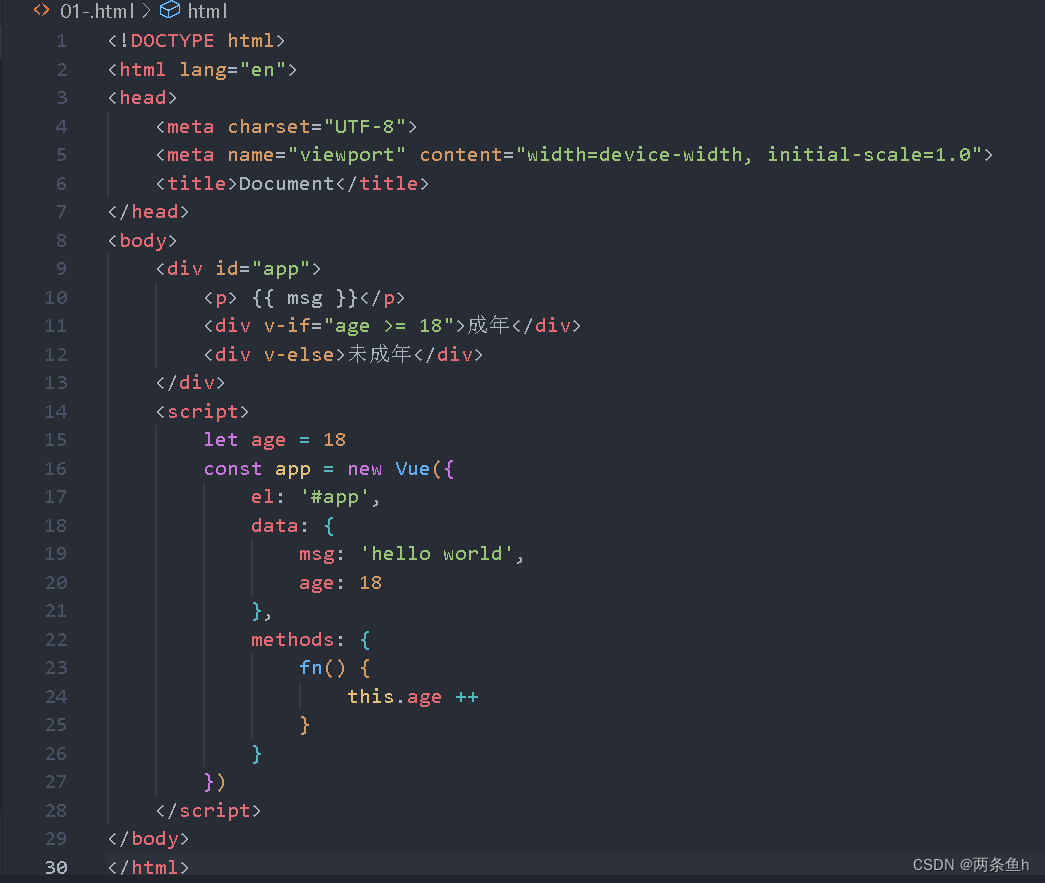

vue的生命周期-CSDN博客

什么是tomcat?tomcat是干什么用的?-CSDN博客

Linux 压缩、解压文件的 4 种方式。tar、gzip、gunzip、zip、unzip、7z命令使用方法-CSDN博客

腾讯-轻量应用服务器centos7中宝塔安装MySQL8.0出现内存不足-CSDN博客

JVM的类的生命周期-CSDN博客

多线程------Future异步任务-CSDN博客