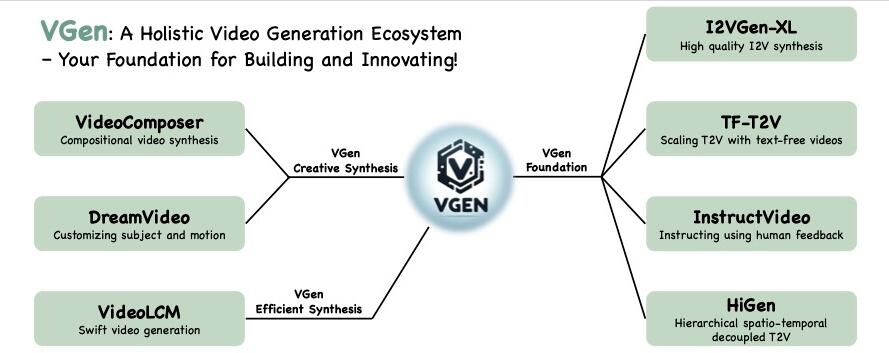

受益于扩散模型快速发展,视频合成近年来取得了显著进步。然而,在语义准确性、清晰度和时空连续性方面仍存在挑战。这主要源于缺乏良好对齐的文本视频数据以及视频的复杂结构,使得模型难以同时确保卓越的语义和质量。

阿里团队提出了一种级联I2VGen-XL方法,通过解耦这两个因素来增强模型性能,并通过利用静态图像作为关键引导形式来确保输入数据的对齐。I2VGen-XL由两个阶段组成:

基础阶段:通过使用两个分层编码器,保证连贯的语义并保留输入图像的内容。

细化阶段:通过合并额外的简短文本来增强视频的细节,并将分辨率提高到1280×720。

为了提高多样性,阿里团队收集了约3.5亿个单镜头文本-视频对和60亿个文本-图像对来优化模型。通过这种方式,I2VGen-XL可以同时增强生成视频的语义准确性、细节连续性和清晰度。

通过大量实验,阿里团队研究了I2VGen-XL的基本原理,并将其与当前顶级方法进行了比较,证明了其在各种数据上的有效性,并公开源代码和模型。