前言

自动驾驶行业想要在开发板上部署一套算法还是需要花费很大功夫的,因为计算资源的限制以及实时性要求高。并不像在服务器端部署算法那样粗犷。接下来就记录一下YOLO系列部署的过程,后期会把开发板上的问题都记录在此。

一、部署环境

计算平台:orin

算力:254 TOPS

系统环境:Ubuntu 20.04

Cuda:11.4

cudnn:8.3.2

TensorRT:

ros:noetic

二、拉取代码

1.克隆YOLOv5源码

git clone https://github.com/ultralytics/yolov5.git

自定义数据的训练可以参考博客:yolov5训练过程

2.克隆下载tensorrtx

git clone https://github.com/wang-xinyu/tensorrtx.git

三、模型转化

1.生成yolov5s.wts文件

将tensorrt/yolov5下的gen_wts.py 复制yolov5项目目录下,执行如下命令就会生成yolov5s.wts模型

python gen_wts.py --weights weights/yolov5s.pt

2.编译

接下来在tensorrt目录下进行编译,

mkdir build && cd build

cmake .. && make

编译通过后会生成yolov5_cls,yolov5_det,yolov5_seg 可执行文件

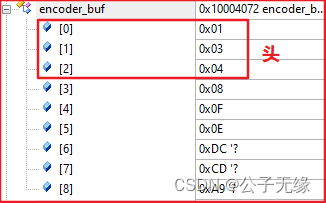

3.生成TensorRT加速engine

通过编译后,使用可执行文件进行加速模型的转化

sudo ./yolov5_det -s yolov5s.wts yolov5s.engine s

此时,生成了上图的yolov5_engin模型,接下来就可以进行模型推理了

./yolov5_seg -d yolov5s.engine ../samples

四、问题

1.yolov5分割暂时还没有跑通;

./yolov5_seg -d yolov5s.engine ../samples

报如下错误:

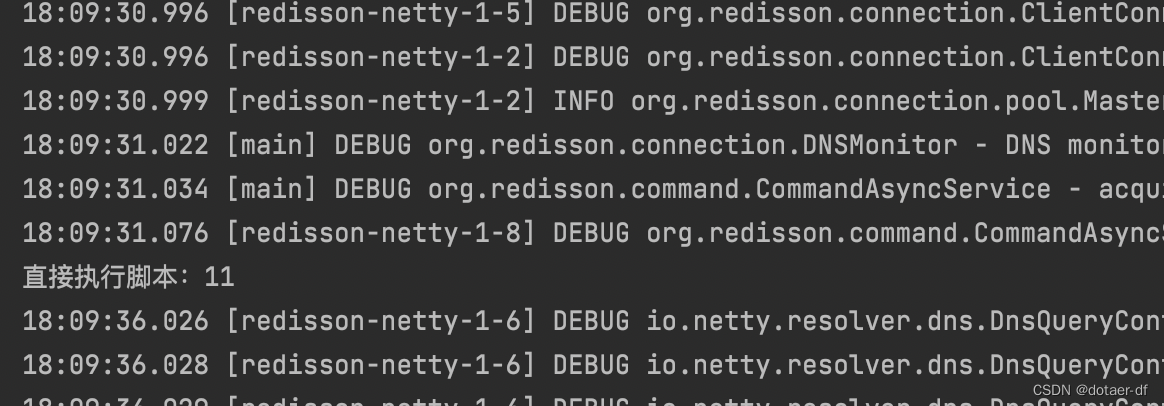

[12/30/2022-16:03:31] [W] [TRT] TensorRT was linked against cuBLAS/cuBLAS LT 11.8.0 but loaded cuBLAS/cuBLAS LT 11.6.5

[12/30/2022-16:03:32] [W] [TRT] TensorRT was linked against cuBLAS/cuBLAS LT 11.8.0 but loaded cuBLAS/cuBLAS LT 11.6.5

yolov5_seg: /home/maxsense/yolov5_trt/tensorrtx/yolov5/yolov5_seg.cpp:341: int main(int, char**): Assertion `engine->getNbBindings() == 3’ failed.

Aborted (core dumped)

2.计划把yolov7 部署到Orin 嵌入式平台上;

五、小技巧

查看cudnn版本

ldconfig -v | grep cudnn