注意力机制的用法与思考

好多同学问我加了CA注意力机制,CBAM注意力机制,都没有涨点,然后就在不停地换不同的注意力机制,其实并不是这样的。今天和大家讨论一下注意力机制的用法与思考。

(一)添加位置

大家的注意力机制都加在哪里呢?

以YOLOv8为例,说几个可能性

1.backbone所有的卷积后面,这就包括conv和c2f后面

2.head所有的卷积后面

3.back所有的conv后面

4.backbone所有的c2f后面

5.head所有的conv后面

6.head所有的c2f后面

7.SPPF后面

8.所有的c2f后面

9.所有的conv后面

10.所有的c2f和conv后面

简单列举了一下几个位置,大家可以回想一下,自己做实验如何做的,是不是只是固定位置,不断地去换注意力机制呢,不妨就用一个注意力机制,去不断的尝试,总会有提升的,当然这些实验结果要保存,这都是可以写到论文里的消融实验部分,能增加工作量,也使自己添加的位置能够有理由进行去说明。

(二)拼接位置

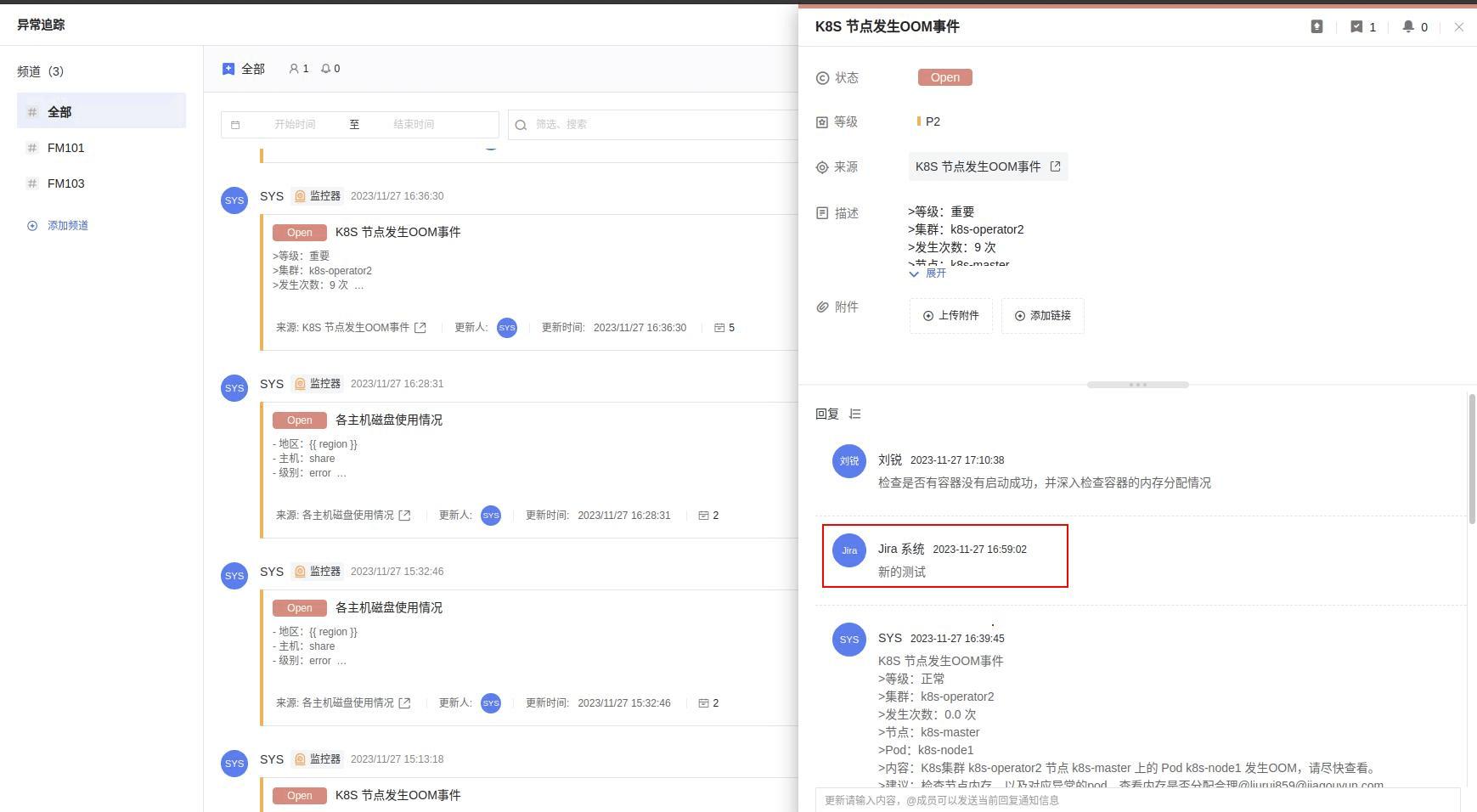

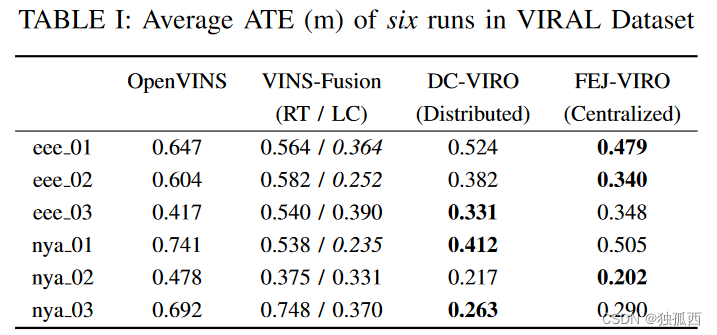

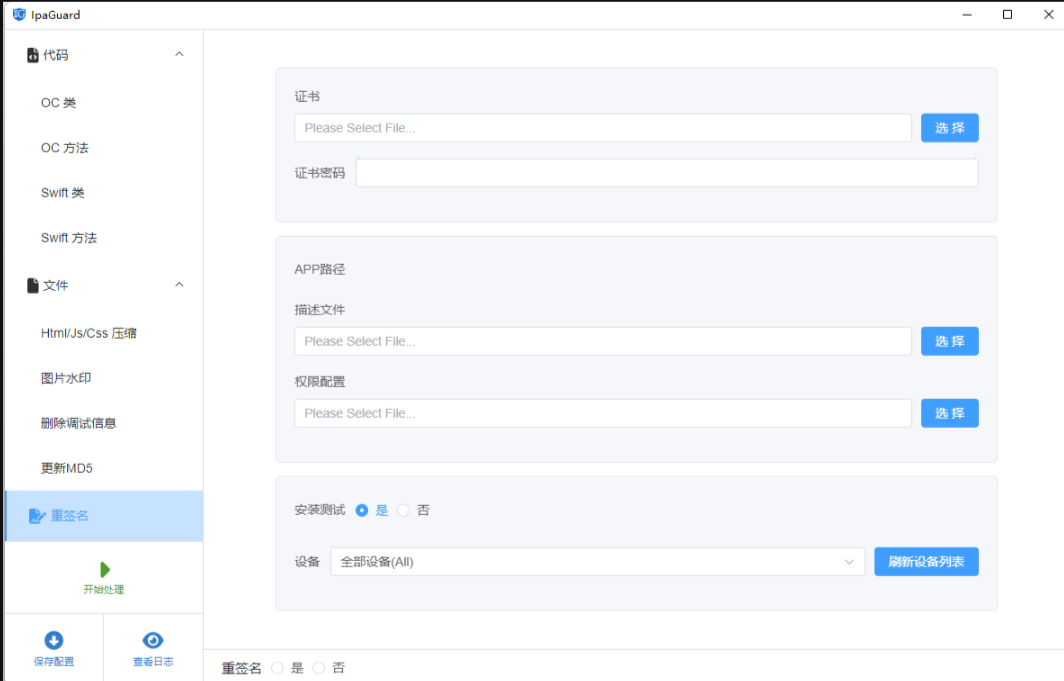

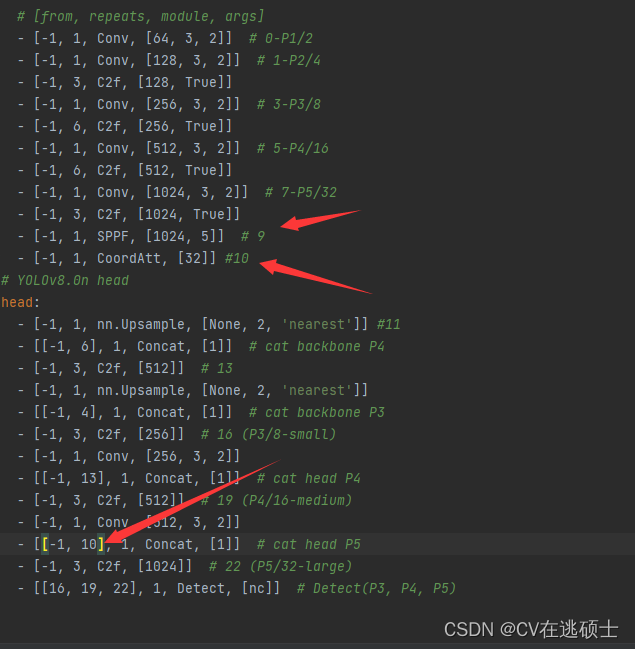

大家知道,YOLOv8有好几层需要拼接,这就涉及到一个问题,比如下面这个配置文件

大家可以看到,其实第21层的拼接有两种选择,一种是连接到第9层的SPPF,一种是第10层的CA注意力机制,链接不同地方,结果肯定会不同。

(三)添加方式

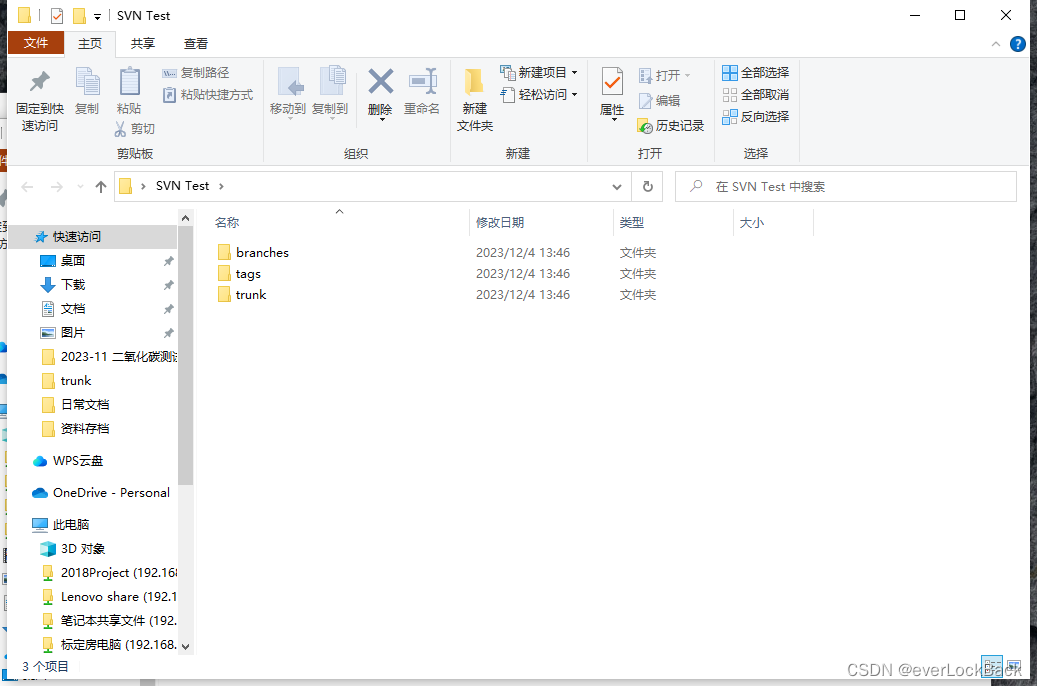

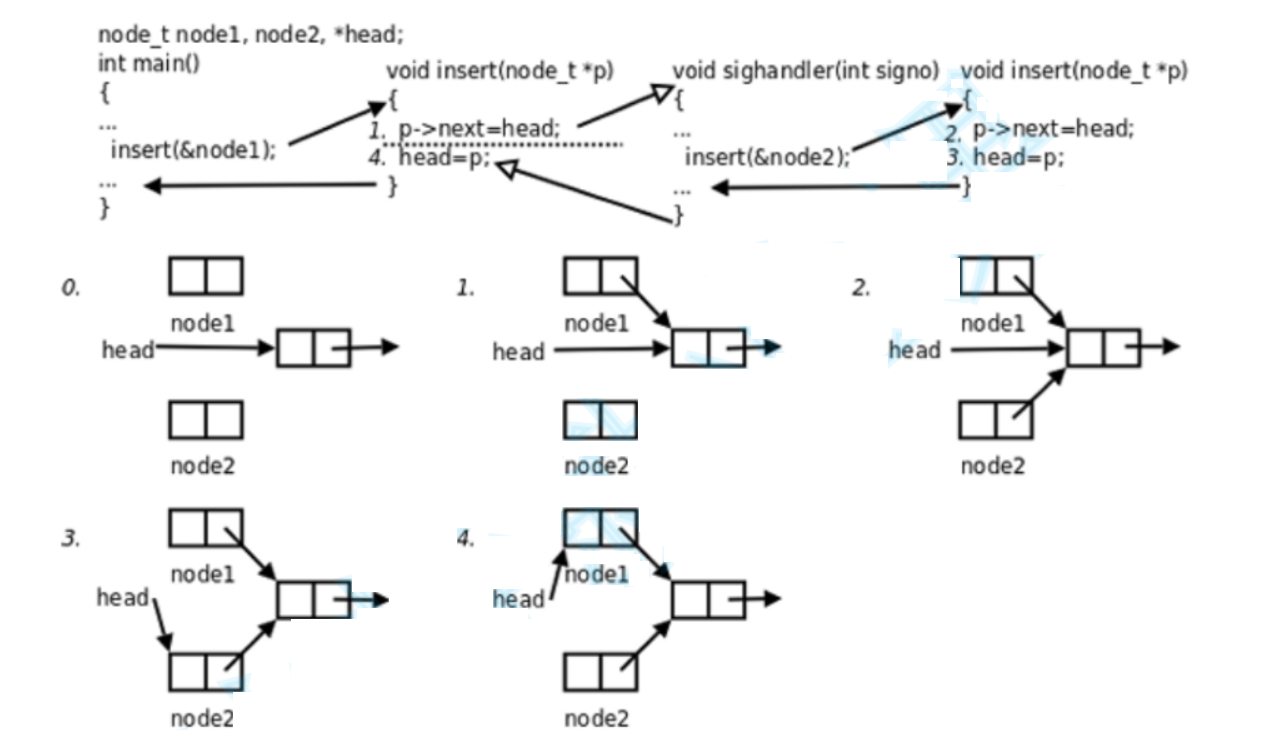

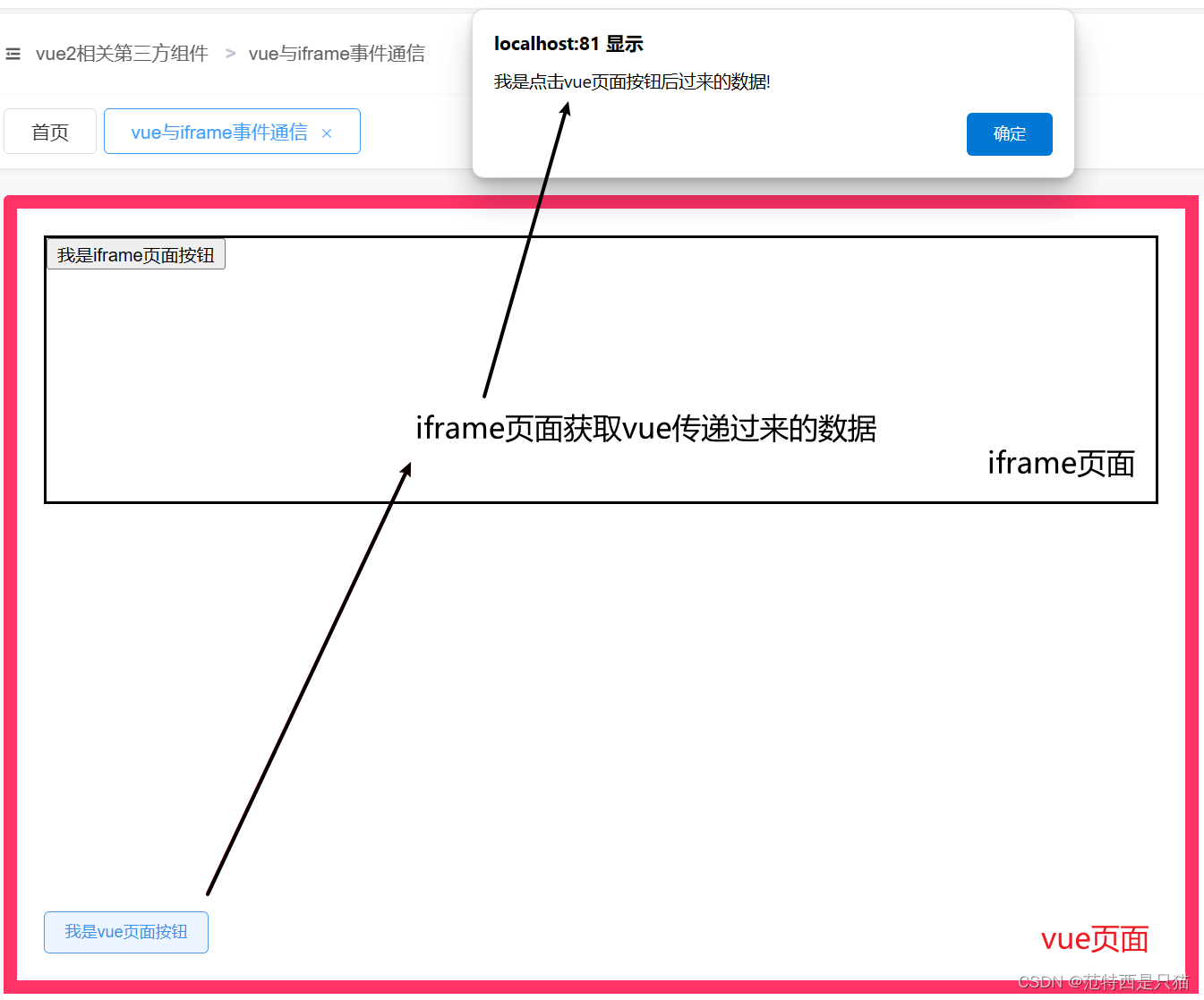

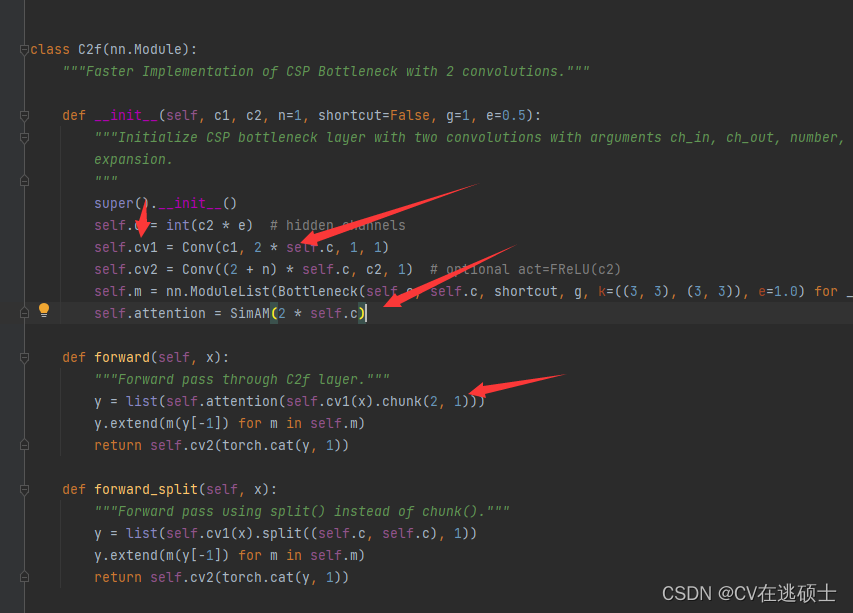

想必各位同学一般会在yaml添加,我给大家提供一下一个新的思路,比如下图

我们可以在c2f的某一个卷积后面加上注意力机制,这样yaml配置文件就不需要发生任何改变,而且效果其实和在yaml文件添加也不会一样,具体效果如何,大家需要自己尝试。

(四)思考

果其实和在yaml文件添加也不会一样,具体效果如何,大家需要自己尝试。

(四)思考

今天给大家列举了几种添加方式,希望大家能够找到自己的想法,比如,我可以将注意力机制融入到SPPF里面?在c2f第二个卷积后面添加?还有就是,其他模型也同理,我们改进的模块也同理,改进大家常常会全部替换,不妨试试只替换backbone或者head或许涨点更高呢?等等等等,这些都是注意力机制的常见用法,不知大家看了这篇文章有没有收获呢。