llama.cpp是当前最火热的大模型开源推理框架之一,支持了非常多的LLM的量化推理,生态比较完善,是个人学习和使用的首选。最近阿里开源了通义千问大语言模型,在众多榜单上刷榜了,是当前最炙手可热的开源中文大语言模型。今天在github上看到前几天llama.cpp已经支持Qwen的推理了,但是由于是近期才开源的,网上还没有太多使用llama.cpp来推理通义千问的实例。本着学习的目的,今天就来实操一下,作为记录,也给需要的同学一些参考。由于最大的Qwen-72B太大了,下载需要较久时间,这里我们使用的是次一级的Qwen-14B的版本。

前提条件

已正确安装llama.cpp

能够访问HuggingFace

原始模型下载

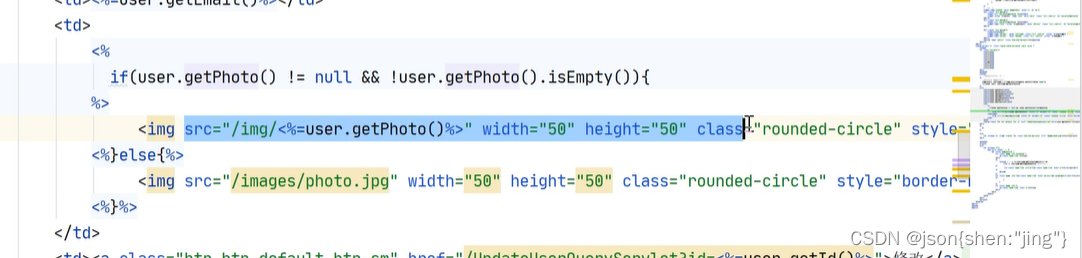

通义千问模型在https://huggingface.co/Qwen/Qwen-14B-Chat/tree/main下载。

模型和相关代码配置文件

需要下载的文件包括:

模型文件 model-00001-of-00015 , … , model-00001-of-00015等

代码文件configuration_qwen.py,modeling_qwen.py,tokenization_qwen.py

配置文件config.json,tokenizer_config.json,model.safetensors.index.json

将上述文件下载到llama.cpp项目的models目录下,这里我放到了models/Qwen/14B/目录下。

需要魔法上网,不然国内无法顺利下载。

代码和配置都需要下载完全,不然llama.cpp转换的时候会报错。

模型格式转换

下载下来的模型是HuggingFace的格式,需要将HuggingFace的safetensors格式的模型文件转换成gguf格式才能使用llama.cpp推理。在llama.cpp项目根木目录执行转换脚本:

python convert-hf-to-gguf.py --model /workspace/Codes/llama.cpp/models/Qwen/14B

得到输出为:

Loading model: 14B

gguf: This GGUF file is for Little Endian only

Set model parameters

Set model tokenizer

gguf: Adding 151387 merge(s).

gguf: Setting special token type bos to 151643

...

...

blk.39.ffn_gate.weight, n_dims = 2, torch.bfloat16 --> float16

output_norm.weight, n_dims = 1, torch.bfloat16 --> float32

output.weight, n_dims = 2, torch.bfloat16 --> float16

Model successfully exported to '/workspace/Codes/llama.cpp/models/Qwen/14B/ggml-model-f16.gguf'

提示将模型格式转换成fp16的gguf格式即为转换成功。转换成功后,models/Qwen/14B/就会得到ggml-model-f16.gguf模型文件。

若在转换过程中报错提示缺少transformers和tiktoken等库,按提示pip install即可。

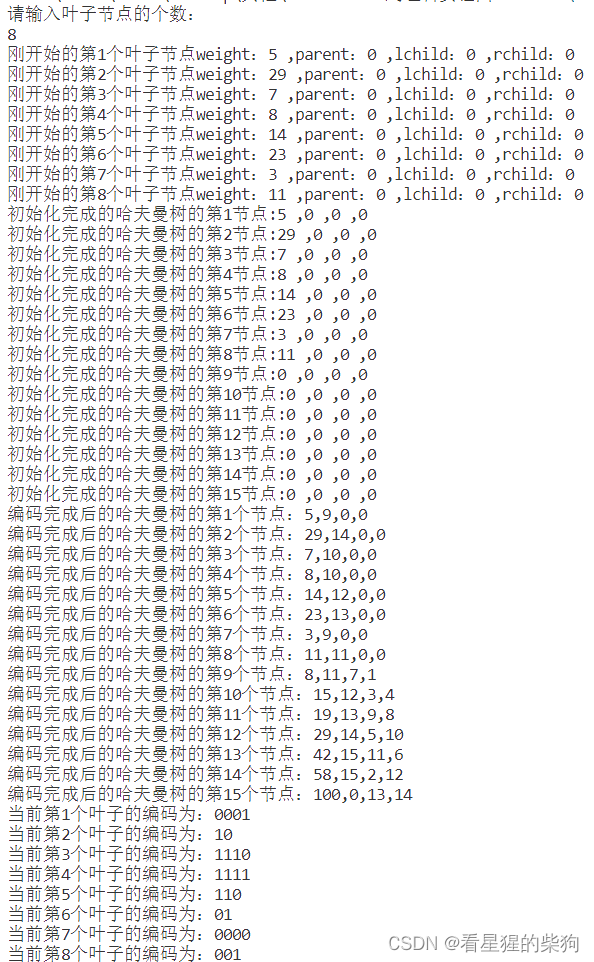

模型量化

格式转换后得到的是模型参数是fp16的,推理所需的资源还是比较多,速度相对较慢。想要进一步降低推理所需计算资源,需要对fp16的gguf模型进行量化。llama.cpp提供了多种量化方式,包括INT4,INT8量化及其各种变体。这里以INT4为例来进行量化,执行如下命令:

./quantize models/Qwen/14B/ggml-model-f16.gguf q4_0 # q4_0代表进行INT4量化

得到输出为:

ggml_init_cublas: GGML_CUDA_FORCE_MMQ: no

ggml_init_cublas: CUDA_USE_TENSOR_CORES: yes

ggml_init_cublas: found 1 CUDA devices:

Device 0: NVIDIA GeForce RTX 4070, compute capability 8.9

main: build = 1601 (5a7d312)

...

...

[ 321/ 323] blk.39.ffn_gate.weight - [ 5120, 13696, 1, 1], type = f16, quantizing to q4_0 .. size = 133.75 MiB -> 37.62 MiB | hist: 0.036 0.016 0.025 0.039 0.057 0.077 0.096 0.111 0.117 0.111 0.097 0.077 0.057 0.039 0.025 0.021

[ 322/ 323] output_norm.weight - [ 5120, 1, 1, 1], type = f32, size = 0.020 MB

[ 323/ 323] output.weight - [ 5120, 152064, 1, 1], type = f16, quantizing to q6_K .. size = 1485.00 MiB -> 609.08 MiB | hist:

llama_model_quantize_internal: model size = 27023.93 MB

llama_model_quantize_internal: quant size = 7794.73 MB

llama_model_quantize_internal: hist: 0.036 0.016 0.025 0.039 0.056 0.077 0.096 0.112 0.118 0.112 0.096 0.077 0.056 0.039 0.025 0.021

main: quantize time = 41580.08 ms

main: total time = 41580.08 ms

执行完成之后,会在models/Qwen/14B/目录下生成ggml-model-Q4_0.gguf文件

ggml-model-Q4_0.gguf

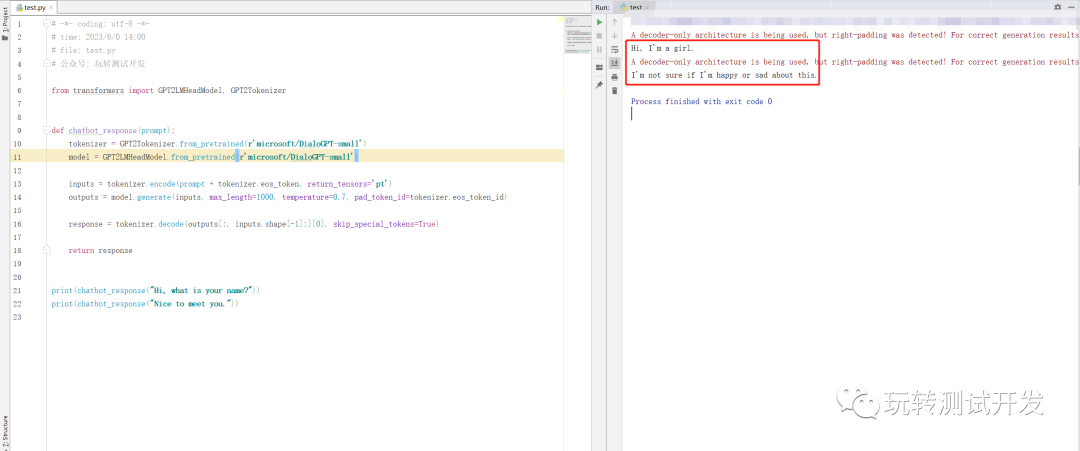

部署推理量化模型

得到我们想要的INT4量化的模型后就可以部署推理了。llama.cpp项目编译生成的main可执行文件是推理的入口,可以直接在命令行运行main文件执行推理。同时,llama.cpp也提供了多个执行脚本,能够更方便进行推理。这里以examples/chat.sh为例,将chat.sh脚本内的./main的参数修改为如下,指定使用我们生成的量化模型的路径:

./main -m ./models/Qwen/14B/ggml-model-Q4_0.gguf -c 512 -b 1024 -n 256 --keep 48 \

--repeat_penalty 1.0 --color -i \

-r "User:" -f prompts/chat-with-bob.txt

然后在项目根目录命令行执行:

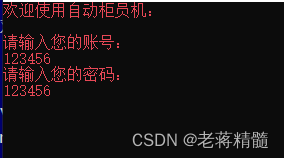

sh examples/chat.sh

回车执行后即可进入到聊天界面,现在可以和千问14B聊天了。

可以看出,千问的回答还是挺现实的哈哈哈。这里还有更多的聊天玩法,还可以部署成server形式,通过web界面来聊天,在这里不展开。

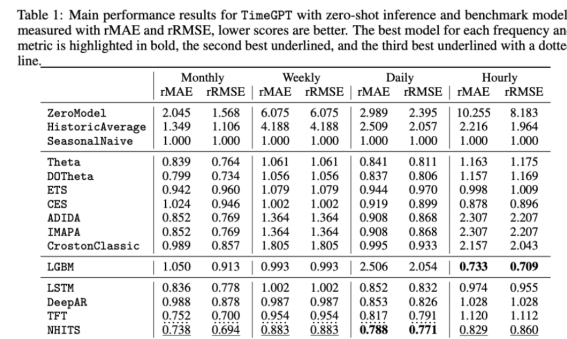

简单精度评测

光会聊天还不行,害得客观验证一下模型回答的质量。llama.cpp提供了perplexity可执行文件来验证模型的PPL精度,这里以wikitext语料来简单测试一下千问14B的性能(通义千问可能更偏向于中文,wikitext-2多数都是英文语料)。需要先下载解压wikitext-2到本地,这里解压到了llama.cpp/wikitext-2-raw/目录下,运行一下命令:

./perplexity -m models/Qwen/14B/ggml-model-Q4_0.gguf -f wikitext-2-raw/wiki.test.raw

在本地的4070上跑完测试大概需要26min左右,PPL为7.8242 +/- 0.05521,作为对比llama2-7B INT4量化版本的PPL大概为PPL = 7.8803 +/- 0.05373左右,千问14B并没有比llama2-7B提升太多,猜测可能是千问的训练数据英文较少的缘故还是我测试不当?希望知道的大佬指正。当然PPL只能作为一个参考,并不能全面地衡量模型的真正性能。

Qwen-14B-q4_0精度PPL

最后再增加一个INT8量化的对比结果:

| Model / PPL | INT4 | INT8 |

|---|---|---|

| Qwen-14B | 7.8242 +/- 0.05521 | 7.6019 +/- 0.05281 |

| llama | 7.8803 +/- 0.05373 | 7.6350 +/- 0.05166 |

到此,llama.cpp部署通义千问模型算是初步完成了,希望能帮助到需要的同学。后续还有很多可以做的,需要更深度的学习探索。