本期为TechBeat人工智能社区第551期线上Talk。

北京时间11月29日(周三)20:00,UC Santa Barbara博士生—许闻达的Talk将准时在TechBeat人工智能社区开播!

他与大家分享的主题是: “细粒度可解释评估初探”,分享了他们团队在具备解释性的细粒度评估模型的一系列研究成果。

Talk·信息

▼

主题:细粒度可解释评估初探

嘉宾:加州大学圣塔芭芭拉分校博士生 许闻达

时间:北京时间 11月29日(周三)20:00

地点:TechBeat人工智能社区

点击下方链接,即可观看视频!

TechBeatTechBeat是荟聚全球华人AI精英的成长社区,每周上新来自顶尖大厂、明星创业公司、国际顶级高校相关专业在读博士的最新研究工作。我们希望为AI人才打造更专业的服务和体验,加速并陪伴其成长。![]() https://www.techbeat.net/talk-info?id=829

https://www.techbeat.net/talk-info?id=829

Talk·介绍

▼

迎接大语言模型时代的同时,面临着NLP中一项令人头疼的大问题:评估文本生成质量。挑战源自于文本的丰富多样性和评估过程中固有的主观性。虽然人工评估目前看来是最可靠的策略,但却因为高昂的成本和主观性的存在而被人诟病。因此,我们急需一种自动化评估模式,这已经成为当前的首要任务之一。

近期,大家注意到,学术界在开发可学习的评估模型上,无论在有监督还是无监督方面,都取得了显著的突破。但遗憾的是,由于评估模型的分数缺乏有效的校准,这些模型仍然无法清晰、直观地告诉我们问题在哪,至此仍缺乏足够的可解释性。

在研究中,我们的团队工作出色,设计了一套具备解释性的细粒度评估模型。我们通过充分利用生成错误的位置、类别和错误程度,来替代染繁复杂的质量分数,让用户能快速掌握文本质量的情况和所在短板。更为惊喜的是,我们发现这些指标不仅能帮助人类理解错误产生的原因, 它还像一位深思熟虑的老师耐心引导学生一样,能利用这些反馈指导大语言模型的生成,从而进一步提升其性能。

Talk大纲

1、近年来可学习评测的发展,以及在大语言模型时代,评测的重要性

2、我们最近在可学习,解释评估上的突破,和其所带来的意义

3、可解释评测带来的细粒度反馈可以如何提升大语言模型的性能

Talk·预习资料

▼

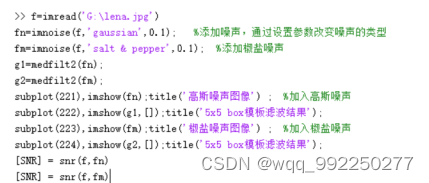

文章链接:https://arxiv.org/abs/2305.14282

文章链接: https://arxiv.org/pdf/2311.09336

文章链接:https://arxiv.org/abs/2212.09305

Talk·提问交流

▼

在Talk界面下的【交流区】参与互动!留下你的打call🤟和问题🙋,和更多小伙伴们共同讨论,被讲者直接翻牌解答!

你的每一次贡献,我们都会给予你相应的i豆积分,还会有惊喜奖励哦!

Talk·嘉宾介绍

▼

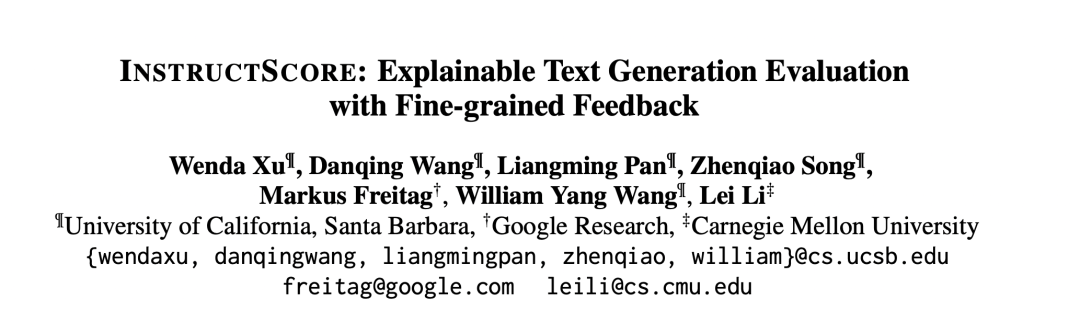

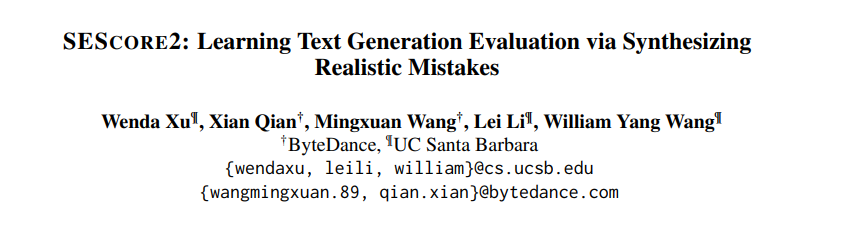

许闻达

UC Santa Barbara 博士生

许闻达目前是UCSB计算机系博四的学生,导师是UCSB NLP 的王威廉教授和CMU LTI的李磊教授。博士期间主要的研究方向是文本生成评估和大语言模型对齐。以前,于UC Davis获得本科学位,隶属于UC Davis的Computer vision组,主要研究方向为图像分割和无人驾驶。本科所做的Visual SLAM和道路规划曾获得年度最佳毕业设计奖。

以第一作者身份在多个定会发表过多篇论文, 包括AAAI, EMNLP和ACL,并以协作作者身份发表多篇论文。并在字节谷歌等研究院实习。担任多个顶会的审稿人,包括AAAI, EMNLP和ACL。

个人主页:

TechBeat

关于TechBeat人工智能社区

▼

TechBeat(www.techbeat.net)隶属于将门创投,是一个荟聚全球华人AI精英的成长社区。

我们希望为AI人才打造更专业的服务和体验,加速并陪伴其学习成长。

期待这里可以成为你学习AI前沿知识的高地,分享自己最新工作的沃土,在AI进阶之路上的升级打怪的根据地!

更多详细介绍>>TechBeat,一个荟聚全球华人AI精英的学习成长社区