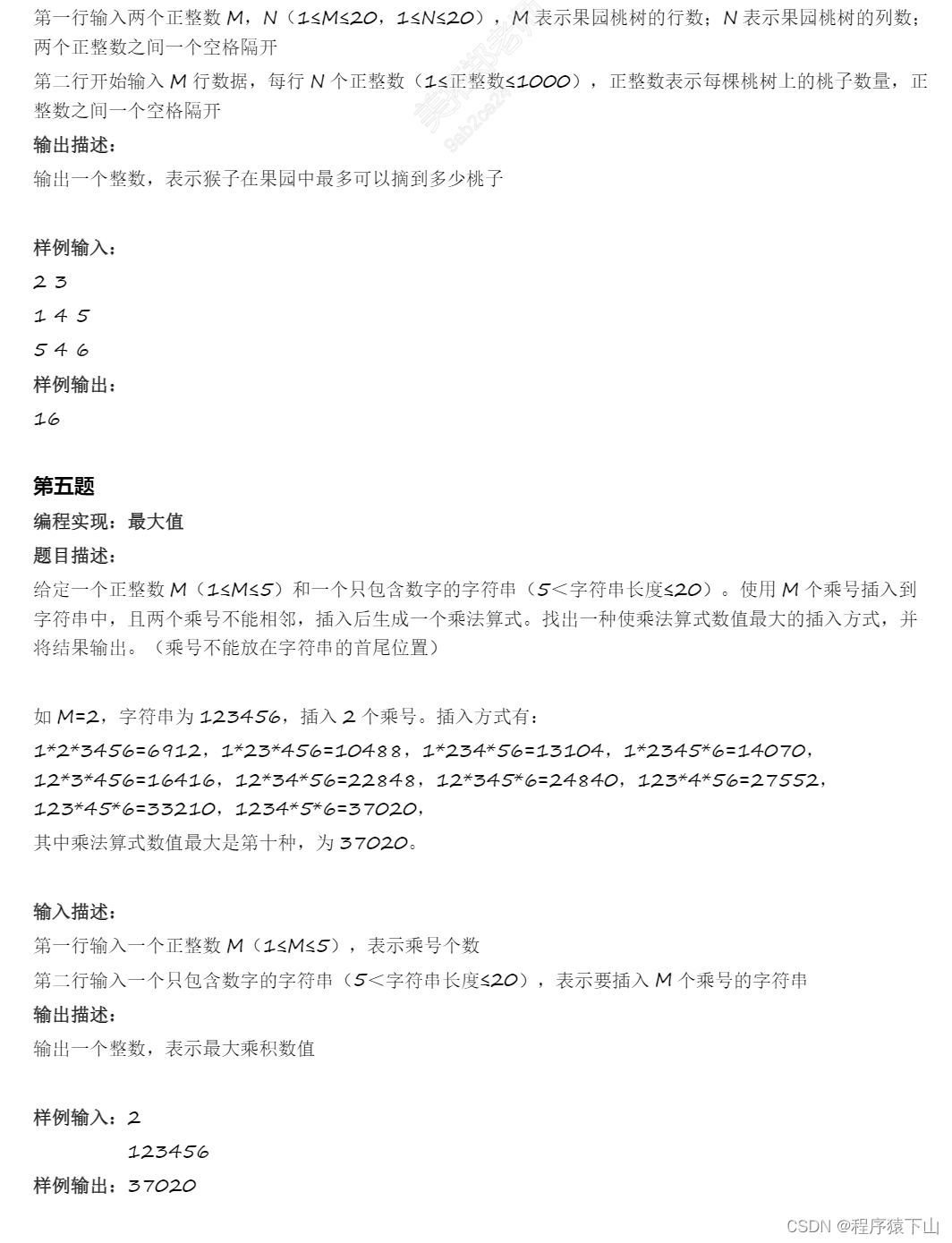

参考:LLMs之RAG:LangChain-Chatchat(一款中文友好的全流程本地知识库问答应用)的简介(支持 FastChat 接入的ChatGLM-2/LLaMA-2等多款主流LLMs+多款embe_一个处女座的程序猿的博客-CSDN博客

1、安装过程中出现了 GPU驱动版本 是11.8 而

python -c "import torch; print(torch.version.cuda)" 返回是 12.1 ,驱动也无法升级,所以重新申请了阿里云的机器 重新安装

2、程序下载 模型下载:

git clone https://www.modelscope.cn/Jerry0/m3e-base.git

git clone https://www.modelscope.cn/qwen/Qwen-7B-Chat-Int4.git

git clone https://github.com/imClumsyPanda/langchain-ChatGLM.git

3、创建conda环境

conda create -n pytorch python=3.8

进入:conda activate pytorch

nvcc --version

pip3 install --upgrade pip

python -c "import torch; print(torch.version.cuda)"

python -c "import torch; print(torch.cuda.is_available())"

cd langchain-ChatGLM

# 安装全部依赖

$ pip install -r requirements.txt

# 默认依赖包括基本运行环境(FAISS向量库)。如果要使用 milvus/pg_vector 等向量库,请将 requirements.txt 中相应依赖取消注释再安装。

安装后出现

ls -l /usr/local | grep cuda conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidia

4、git lfs install

pip install modelscope

pip install auto-gptq optimum

git clone -b v1.0.8 https://github.com/Dao-AILab/flash-attention

cd flash-attention && pip install .

---该安装模型了