随着人工智能领域的迅猛发展,神经网络成为实现各种复杂任务的有力工具。其中,激活函数及其非线性化特性扮演着至关重要的角色。本文将深入探讨激活函数的基本概念、作用原理以及常见的几种激活函数,并介绍它们在神经网络中发挥的重要作用。

第一节:激活函数的基本概念和作用

激活函数是神经网络的一种数学函数,通常应用于神经元的输出层,用于为输入信号引入非线性性质。相较于线性函数,激活函数能够帮助神经网络更好地模拟人类大脑的工作方式。具体来说,激活函数能够通过引入非线性,解决线性函数无法解决的问题,如实现非线性决策边界和处理非线性数据。

第二节:常见的激活函数

1. 阶跃函数(Step Function):阶跃函数是最简单的激活函数之一,其输出只有两种取值,0和1。它将输入信号转化为二进制信号,用于二分类问题。然而,其缺点是它的导数几乎处处为零,导致训练过程中的梯度消失问题。

2. sigmoid函数(Sigmoid Function):sigmoid函数具有S形曲线,将输入映射到0到1之间的连续值。它常用于解决二分类和多分类问题。然而,sigmoid函数也存在梯度消失和梯度爆炸等问题,并且当输入值远离0时,输出的梯度趋近于0,导致反向传播过程中的训练速度减慢。

3. 双曲正切函数(Tanh Function):双曲正切函数与sigmoid函数类似,但其输出值范围是-1到1之间。相比于sigmoid函数,tanh函数没有那么容易饱和,且其输出值的均值接近于0,适用于训练中心化数据集。然而,它仍然存在梯度消失的问题。

4. ReLU函数(Rectified Linear Unit Function):ReLU函数是一种简单且广泛使用的激活函数。其表达式为f(x) = max(0, x),即当输入大于0时输出输入值,否则输出0。ReLU函数解决了梯度消失问题,同时计算速度也较快。然而,当输入小于等于0时,ReLU函数的梯度为0,导致神经元无法更新权重,称为“死亡神经元”。

第三节:非线性化在神经网络中的重要性

神经网络之所以能够完成复杂的任务,得益于激活函数带来的非线性性质。如果没有激活函数,多层神经网络就只是由一系列线性函数组成,无论多少层,整个网络都可以简化为一个线性函数。而引入非线性化的激活函数,使得神经网络可以表达更加复杂的函数关系,拥有更强的拟合能力。

非线性化的激活函数在以下几个方面发挥重要作用:

1. 扩展网络的表示能力:通过引入非线性性质,激活函数使神经网络能够学习到非线性的复杂函数,扩展了网络的表示能力。

2. 实现非线性决策边界:对于分类问题,激活函数能够帮助神经网络学习到非线性决策边界,提高分类准确性。

3. 处理非线性数据:很多现实世界的数据具有非线性关系,激活函数能够帮助神经网络更好地处理这些复杂的非线性数据。

4. 缓解梯度消失问题:激活函数的非线性特性可以缓解梯度消失问题,使得反向传播过程中的梯度能够更好地传递。

结论:

激活函数是神经网络中的关键元素,通过引入非线性性质,它为神经网络赋予了非常重要的功能。不同的激活函数具有不同的特点和适用场景,选择适当的激活函数可以提高神经网络的性能。通过研究激活函数及其非线性化特性,可以进一步推动神经网络领域的发展,帮助我们更好地利用神经网络来解决实际问题。

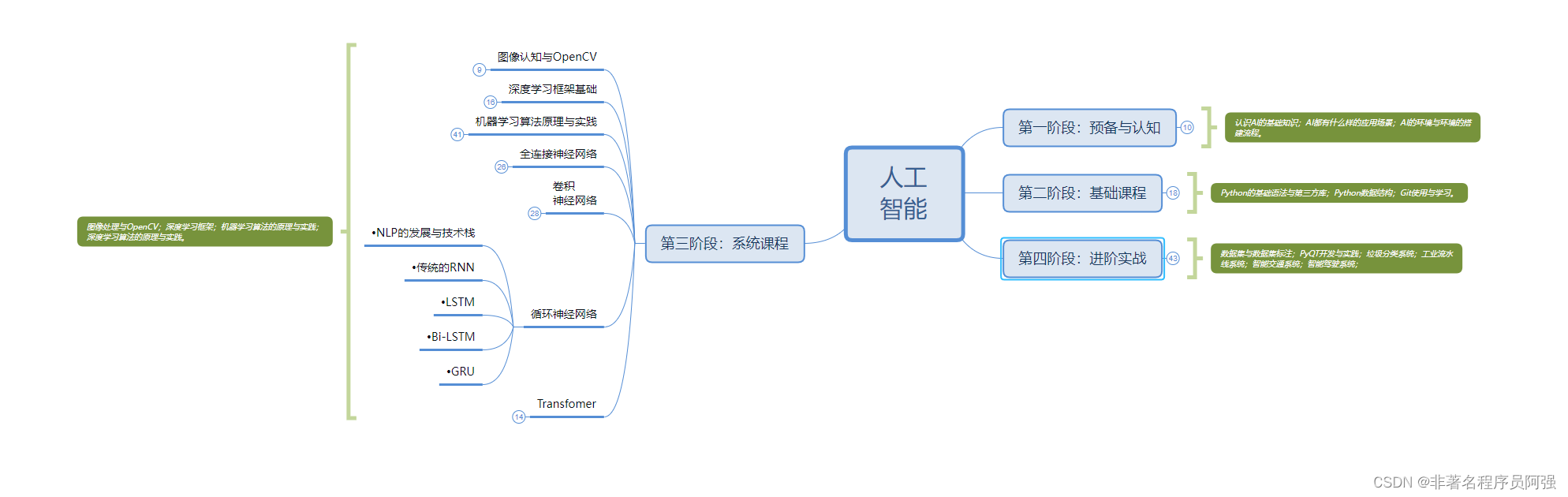

人工智能的学习之路非常漫长,不少人因为学习路线不对或者学习内容不够专业而举步难行。不过别担心,我为大家整理了一份600多G的学习资源,基本上涵盖了人工智能学习的所有内容。点击下方链接,0元进群领取学习资源,让你的学习之路更加顺畅!记得点赞、关注、收藏、转发哦!扫码进群领资料