初始化Spark Sql

package pbcp_2023.clear_data

import org.apache.spark.SparkConf

import org.apache.spark.sql.SparkSession

import org.apache.spark.sql.functions.{current_date, current_timestamp}

object twe_2 {

def main(args: Array[String]): Unit = {

val con = new SparkConf().setMaster("local[*]").setAppName("one")

System.setProperty("HADOOP_USER_NAME", "root")

val sc = new SparkSession.Builder()

.config(con)

.enableHiveSupport()

.getOrCreate()

import sc.implicits._

val list = List("date").toDF()

}

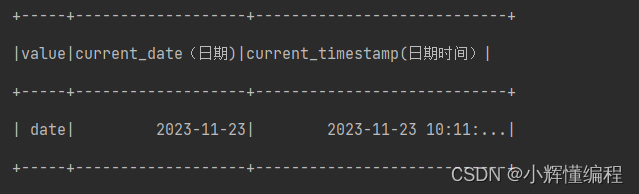

}1.current_date和current_timestamp

current_date:取得当前日期

current_timestamp: 取得当期时间日期

import sc.implicits._

val list = List("date").toDF()

// current_date 当前日期

// current_timestamp 当前时间日期

list.withColumn("current_date(日期)",current_date())

.withColumn("current_timestamp",current_timestamp())

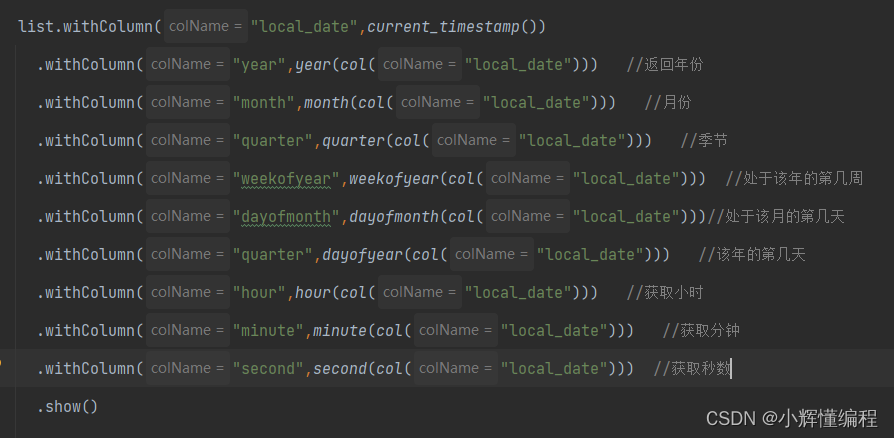

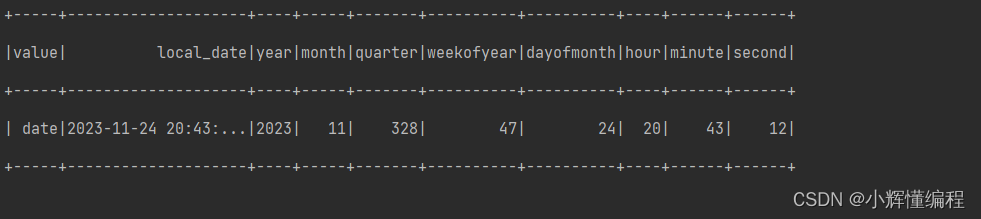

current_timestamp(): 这个函数用于获取当前的日期和时间戳。year(col("local_date")): 这个函数会提取出"local_date"列中的年份。month(col("local_date")): 这个函数会提取出"local_date"列中的月份。quarter(col("local_date")): 这个函数会根据"local_date"列中的日期信息,将日期划分为哪个季度。weekofyear(col("local_date")): 这个函数会提取出"local_date"列中该年度的第几周。dayofmonth(col("local_date")): 这个函数会提取出"local_date"列中该月的第几天。dayofyear(col("local_date")): 这个函数会提取出"local_date"列中该年的第几天。hour(col("local_date")): 这个函数会提取出"local_date"列中的小时数。minute(col("local_date")): 这个函数会提取出"local_date"列中的分钟数。second(col("local_date")): 这个函数会提取出"local_date"列中的秒数。