ComfyUI 是一个基于节点流程式的stable diffusion AI 绘图工具WebUI, 你可以把它想象成集成了stable diffusion功能的substance designer, 通过将stable diffusion的流程拆分成节点,实现了更加精准的工作流定制和完善的可复现性。但节点式的工作流也提高了一部分使用门槛。

同时,因为内部生成流程做了优化,生成图片时的速度相较于webui又10%~25%的提升(根据不同显卡提升幅度不同),生成大图片的时候不会爆显存,只是图片太大时,会因为切块运算的导致图片碎裂。

下载安装

https://github.com/comfyanonymous/ComfyUI![]() https://github.com/comfyanonymous/ComfyUI

https://github.com/comfyanonymous/ComfyUI

配置模型

将checkpoint模型放入ComfyUI\models\checkpoints目录

ComfyUI与WebUI之间共享模型

在ComfyUI目录中将extra_model_paths.yaml.example文件复制一份,重命名为将extra_model_paths.yaml

修改a111的base_path路径为WebUI路径

启动

运行run_nvidia_gpu.bat启动ComfyUI

更新

如果后面需要更新ComfyUI,可以直接使用update_comfyui.bat,就不需要重新下载和配置了

使用

鼠标右键呼出节点目录,可以直接在目录中选择节点。

鼠标双击呼出节点搜索窗口,知道节点名称的话,直接搜索比较快。

连接好节点网络,通过点击面板右侧的工具栏中的 Queue Prompt,就能开始图片生成了。

通过使用鼠标点击拖动节点上的输出输入点,即可创建连线。

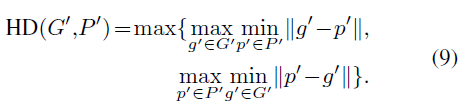

一般的的节点网络包括:

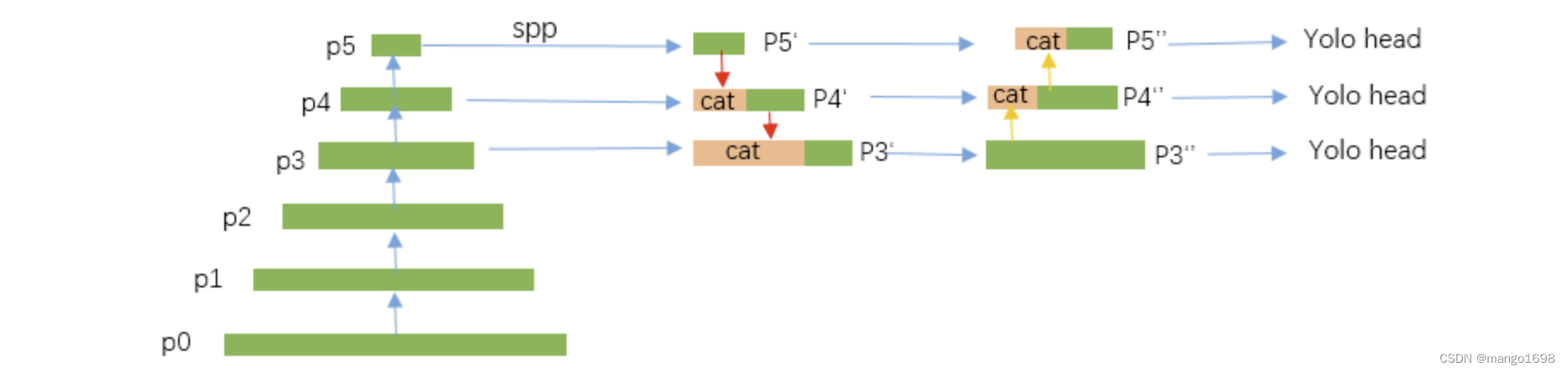

- 输入阶段:模型输入,图片输入等。负责载入模型和图片。

- Clip阶段:clip跳过,clip编码器,lora,controlnet都在这个阶段。

- Unet阶段:ksampler节点,负责在潜空间生成图片。参数和webui中的生成参数基本上相同。

- Vae解码阶段:将生成的图片从潜空间转换成RGB色彩空间。Vae解码节点可以链接不同的VAE来得到不同的解码结果。

- 保存和后处理阶段:预览,保存,后处理

![[MySQL] MySQL 表的增删查改](https://img-blog.csdnimg.cn/5c67abcd3dac4a119c643865e33383ba.png)