paper | proj | code

- 提出一种基于K-Planes的4D point cloud Representation;

- 提出一种Hybrid appearance model,包含image blending model和SH model。其中,image blending model将3D点映射回原图中求得,SH model通过模型预测求得。

- 提出一种可导的深度排序算法,训练时通过Pytorch计算,渲染时通过OpenGL计算,实现GPU支持的快速光栅化。

- 提出一系列减少推理渲染的方法:

- 提前计算点的位置、密度、颜色系数和blending系数等;

- 减少光栅化每个像素所需要的点数;

- 将模型从32-bit float降为16-bit

目录

摘要

方法

Modeling Dynamic Scenes with Point Clouds

Differentiable Depth Peeling

Training

Inference

实验

Datasets and metrics

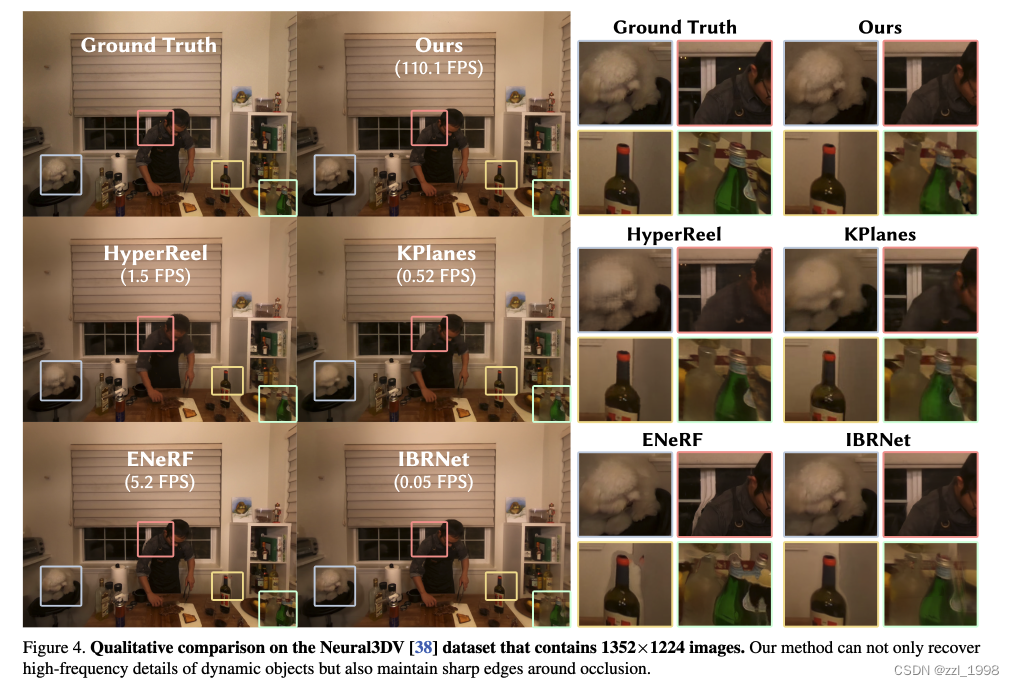

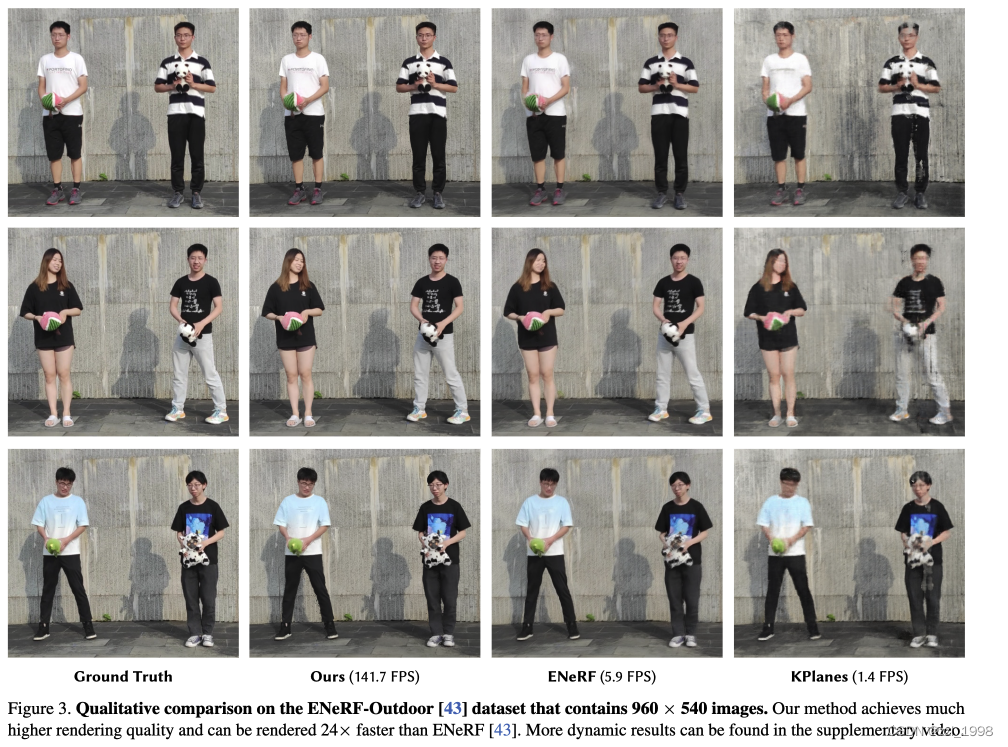

Comparison Experiments

Ablation Studies

Storage analysis.

Rendering Speed Analysis

摘要

- 现有问题:动态场景中,渲染高分辨率图片很慢;

- 本文:

- 提出基于K-Planes的4D point cloud Representation,支持硬件光栅化,实现快速渲染;

- 提出一种hybrid appearance model,在提高渲染质量的同时,保证渲染效率;

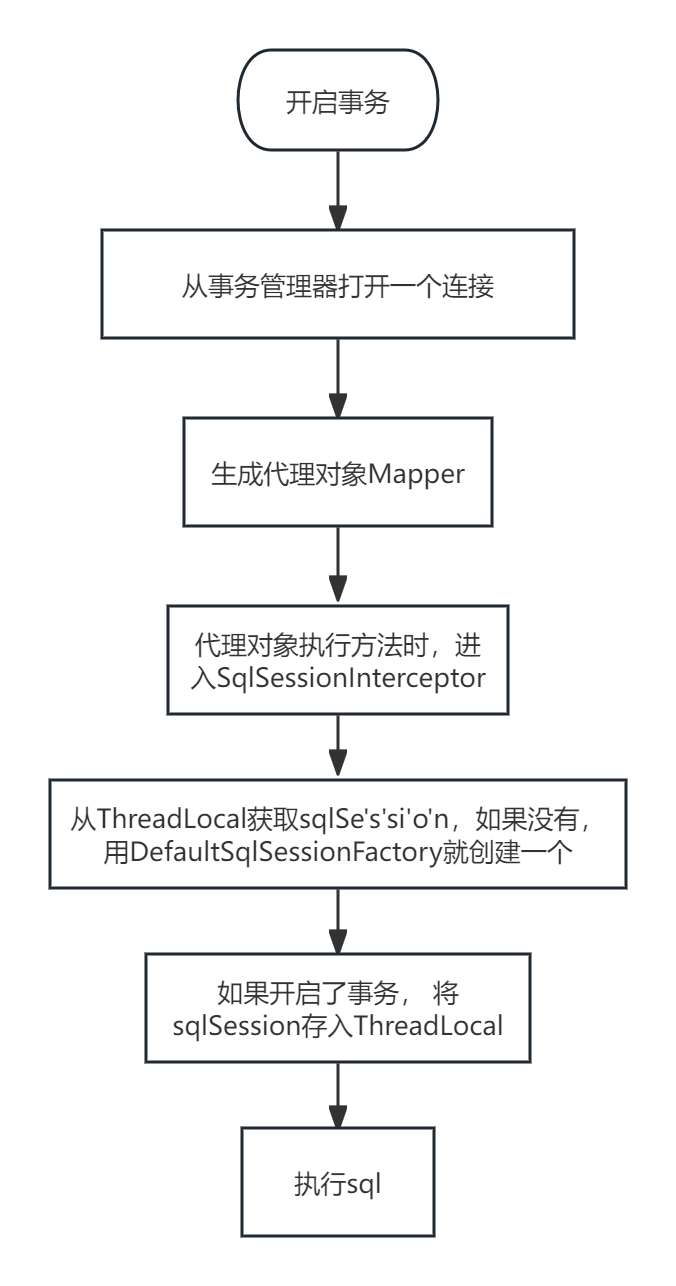

- 设计一种可导的深度排序算法(deep peeling algorithm),实现从RGB视频中快速建模;

- 实验证明,在一张4090 GPU上,可以实现对1080分辨率的400FPS渲染,4K分辨率的80FPS渲染。

方法

Modeling Dynamic Scenes with Point Clouds

- 通过space-carving algorithm从视频中提取粗点云序列;

- 点特征通过K-Planes表达,给定坐标和时间

,可得特征:

- 点特征送入Radius MLP和Density MLP,预测该点的密度

和半径

;

- 该点的颜色通过两个模型计算,分别是离散的image blending model和连续的SH model。

- image blending model是指,给定空间中任意一点,可投影到输入图片上,检索对应RGB值。在本文中,多张图片检索的RGB值,通过网络预测加权系数,加权求和以得到该点的

。由于检索图像与视角无关,本文仅考虑与视角最近的

张图片。image blending model除系数外,可以提前计算。因此,可以在提高视觉质量的同时,不增加过多计算。

- SH model,则是将点特征送入SH MLP,预测得到

。

- 最终,该点颜色由以下公式计算:

- image blending model是指,给定空间中任意一点,可投影到输入图片上,检索对应RGB值。在本文中,多张图片检索的RGB值,通过网络预测加权系数,加权求和以得到该点的

![]()

Differentiable Depth Peeling

- 对于像素

,首先找到距离该点相机视角最近的

个点。

- 用体渲染的方式,通过

个点计算该点颜色。首先计算密度,其中

是将点投影到2D图像上:

- 在训练中,本文基于PyTorch实现

。在推理阶段,本文用OpenGL计算。

- 最终,该像素点颜色:

Training

包含三个损失:

- MSE Loss:

- LPIPS Loss

- Mask 损失:

- 最终训练损失为:

![]()

Inference

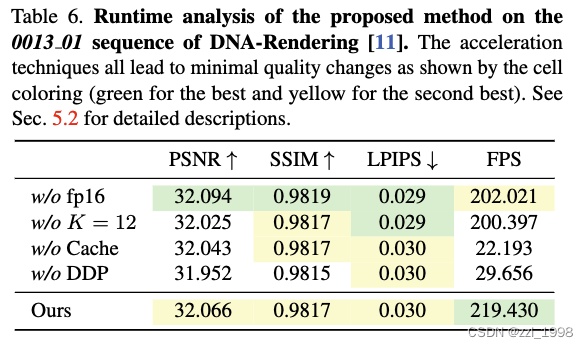

通过三个方法加速推理:

- 提前计算点位置,半径,密度,SH系数和color blending系数;

- 将模型从32-bit floats转为16-bits,可以增加20FPS;

- 将渲染时的超参数K从15降低为12,可以在不影响视觉质量的情况下,增加20FPS;

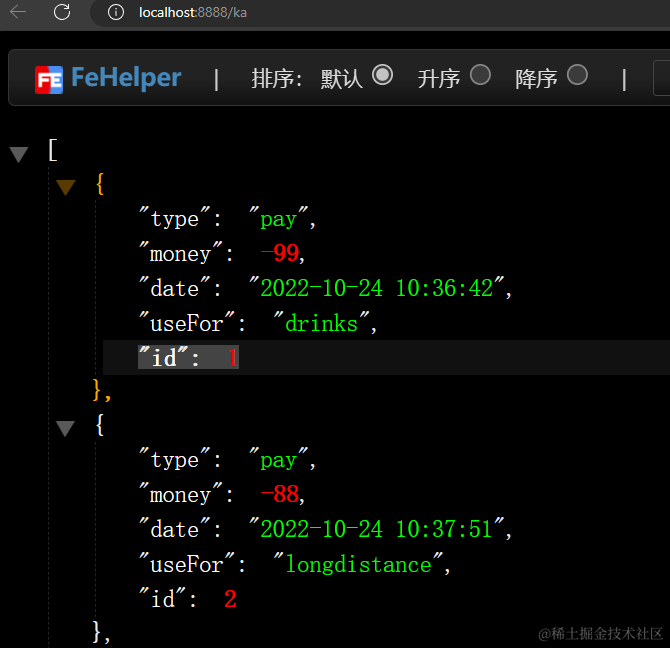

实验

Datasets and metrics

- DNA-Rendering:15 FPS, 10 s, 60 views, 4K/2K相机,训练分辨率为1024 x 1224 / 1125 x 1536

- ENeRF-Outdoor:30 FPS, 1080p相机,训练分辨率为960 x 540

- NHR:训练分辨率为512 x 612 / 384 x 512

- Neural3DV:训练分辨率为1352 x 1224

Comparison Experiments

Ablation Studies

- Ablation study on the 4D embedding. w/o f

- Ablation study on the hybrid appearance model. w/.o

- Ablation study on loss functions.

Storage analysis.

Rendering Speed Analysis