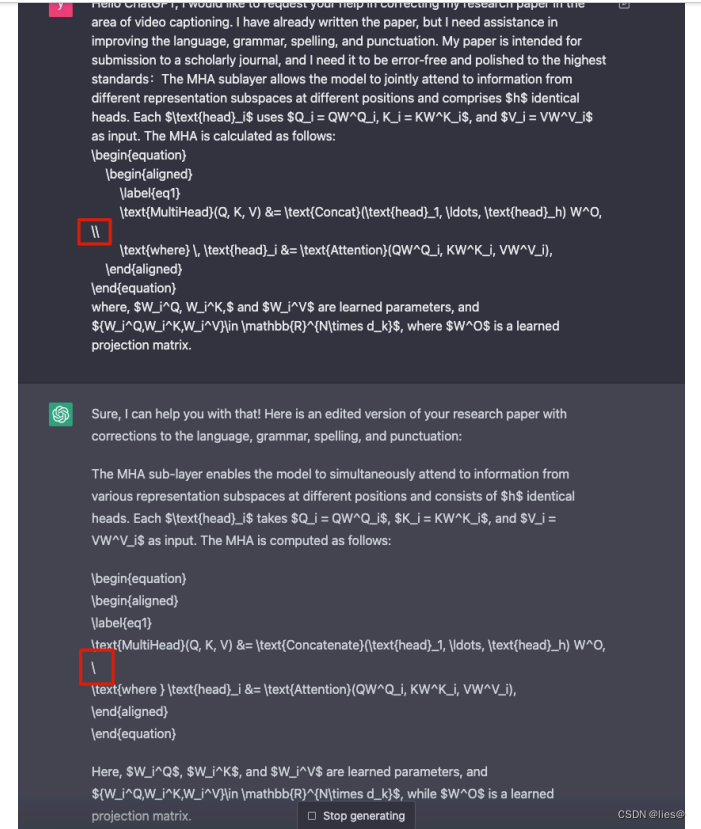

🚀🚀🚀本文改进:深入分析了现有线性注意力方法的缺陷,并提出了一个全新的聚焦的线性注意力模块(Focused Linear Attention),同时具有高效性和很强的模型表达能力。

🚀🚀🚀YOLOv8-seg创新专栏:http://t.csdnimg.cn/KLSdv

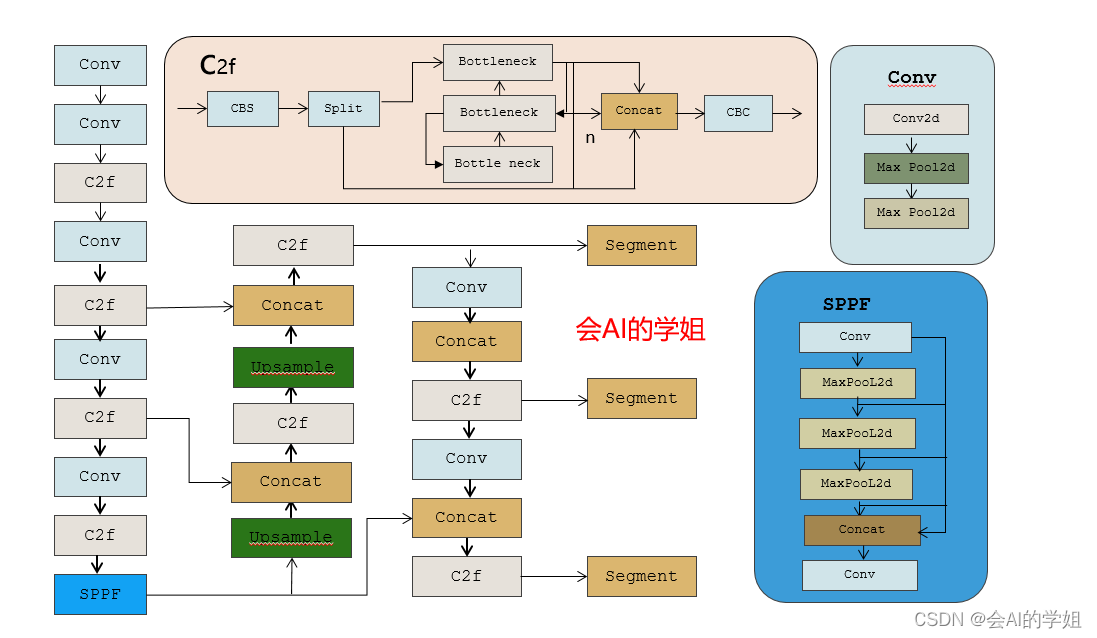

学姐带你学习YOLOv8,从入门到创新,轻轻松松搞定科研;

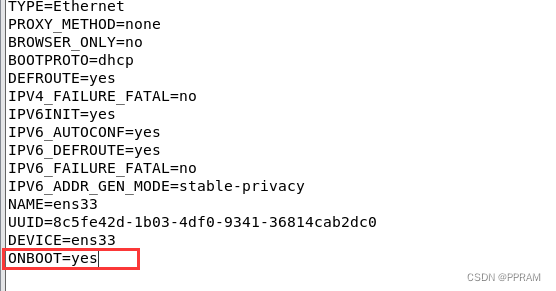

1)手把手教你如何训练YOLOv8-seg;

2)模型创新,提升分割性能;

3)独家自研模块助力分割;

1.Focused Linear Attention介绍

论文: https://arxiv.org/pdf/2308.00442.pdf