在一个使用requests库的conda食谱构建过程中,我们注意到存在一个文件下载问题。该文件是从https://dakota.sandia.gov/sites/default/files/distributions/public/dakota-6.5-public.src.tar.gz下载的。使用curl和urllib2库可以正确下载文件,但使用requests-2.12.1库下载时,文件大小却增加了170MB。我们尝试了多个文件,但只有这个文件存在这个问题。

解决方案:

经过分析,我们怀疑这个问题可能与文件压缩有关。因此,我们首先使用curl命令获取文件的响应头,然后使用requests库获取相同文件的响应头,将两个响应头进行比较,发现requests库的响应头中多了一个"Content-Encoding: x-gzip"字段。因此,我们猜测可能是因为requests库默认使用了gzip压缩,导致文件大小增加。

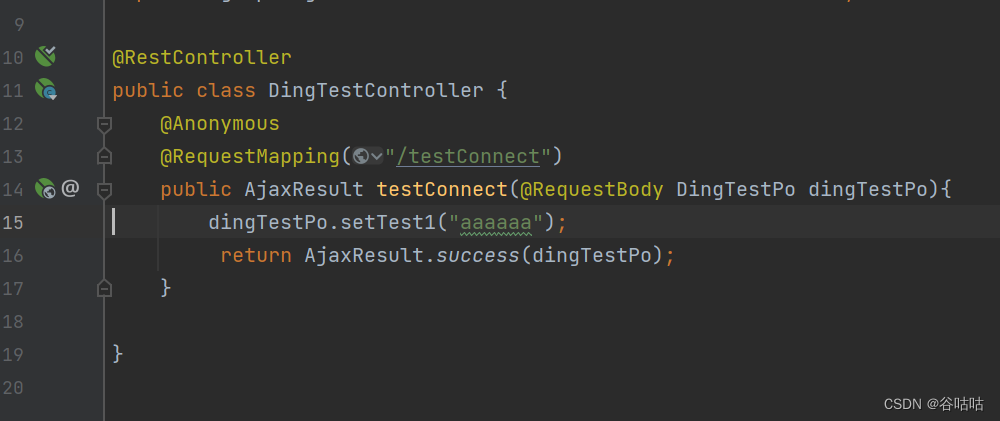

为了解决这个问题,我们需要在使用requests库下载文件时,明确设置"Accept-Encoding: identity",告诉服务器不要使用gzip压缩。修改后的代码如下:

def download_file(url, fn):

headers = {'Accept-Encoding': 'identity'}

r = requests.get(url, stream=True, headers=headers)

with open(fn, 'wb') as f:

for chunk in r.iter_content(chunk_size=1024):

if chunk:

f.write(chunk)

使用修改后的代码重新下载文件,文件大小恢复正常,问题得到解决。

总结:

使用requests库下载文件时,需要注意设置"Accept-Encoding"头,避免因为默认使用gzip压缩导致文件大小增加的问题。同时,也需要根据服务器的响应头信息,灵活设置请求头,确保请求的正确性。这不仅可以提高下载效率,还可以避免因为文件压缩问题导致的文件损坏、下载不完整等问题。希望本文能帮助到有需要的朋友,如果有任何疑问,欢迎留言讨论。

![锐捷网络NBR700G 信息泄露漏洞复现 [附POC]](https://img-blog.csdnimg.cn/9bdee1fe95f84be7a91fad3a522c1ee7.png)