原创

作者 | 王二狗英伟达又一次打了所有人措手不及!

就在昨晚,老黄发布了新一代史上最强 AI芯片 NVIDIA HGX™ H200 。

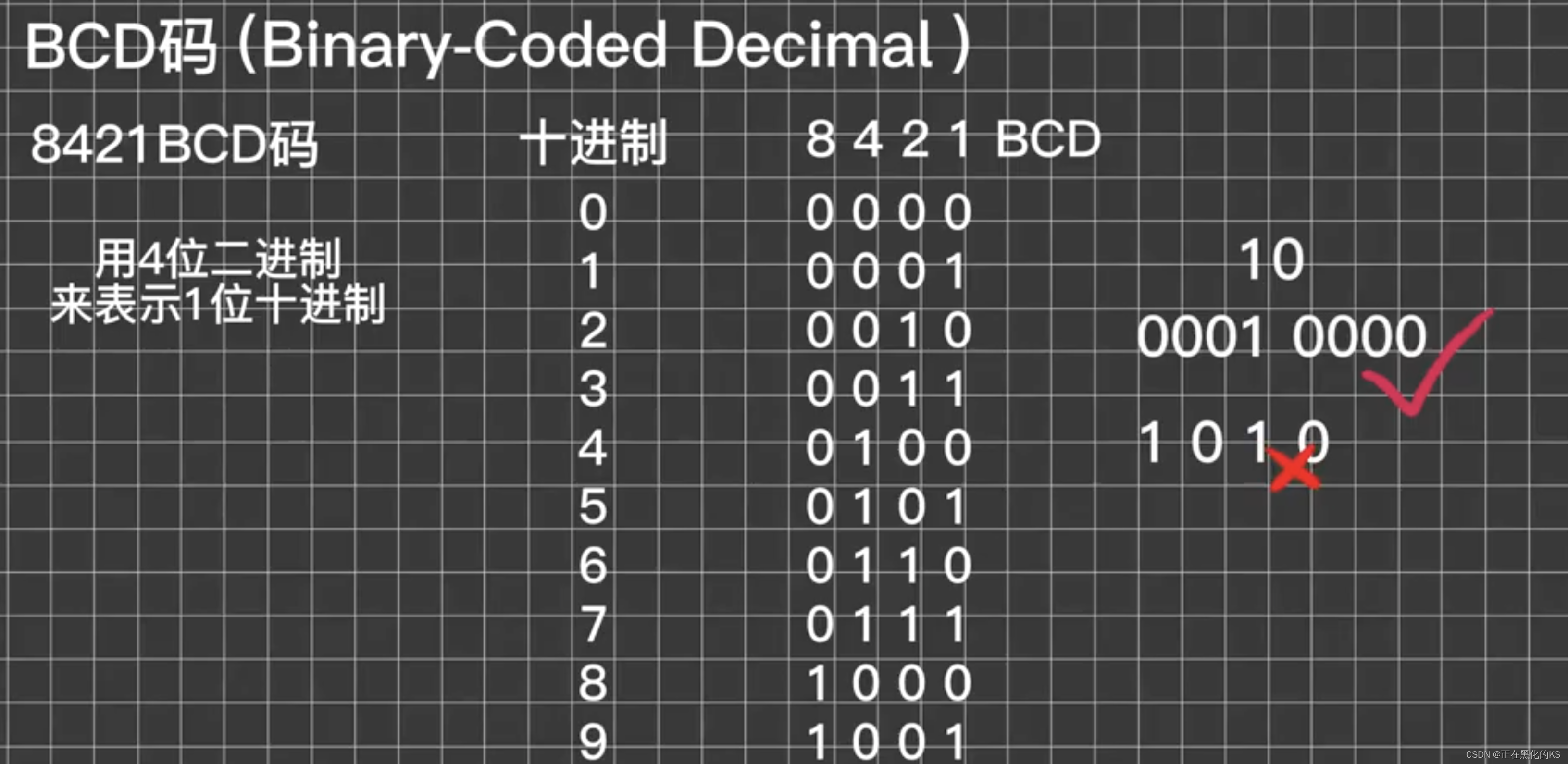

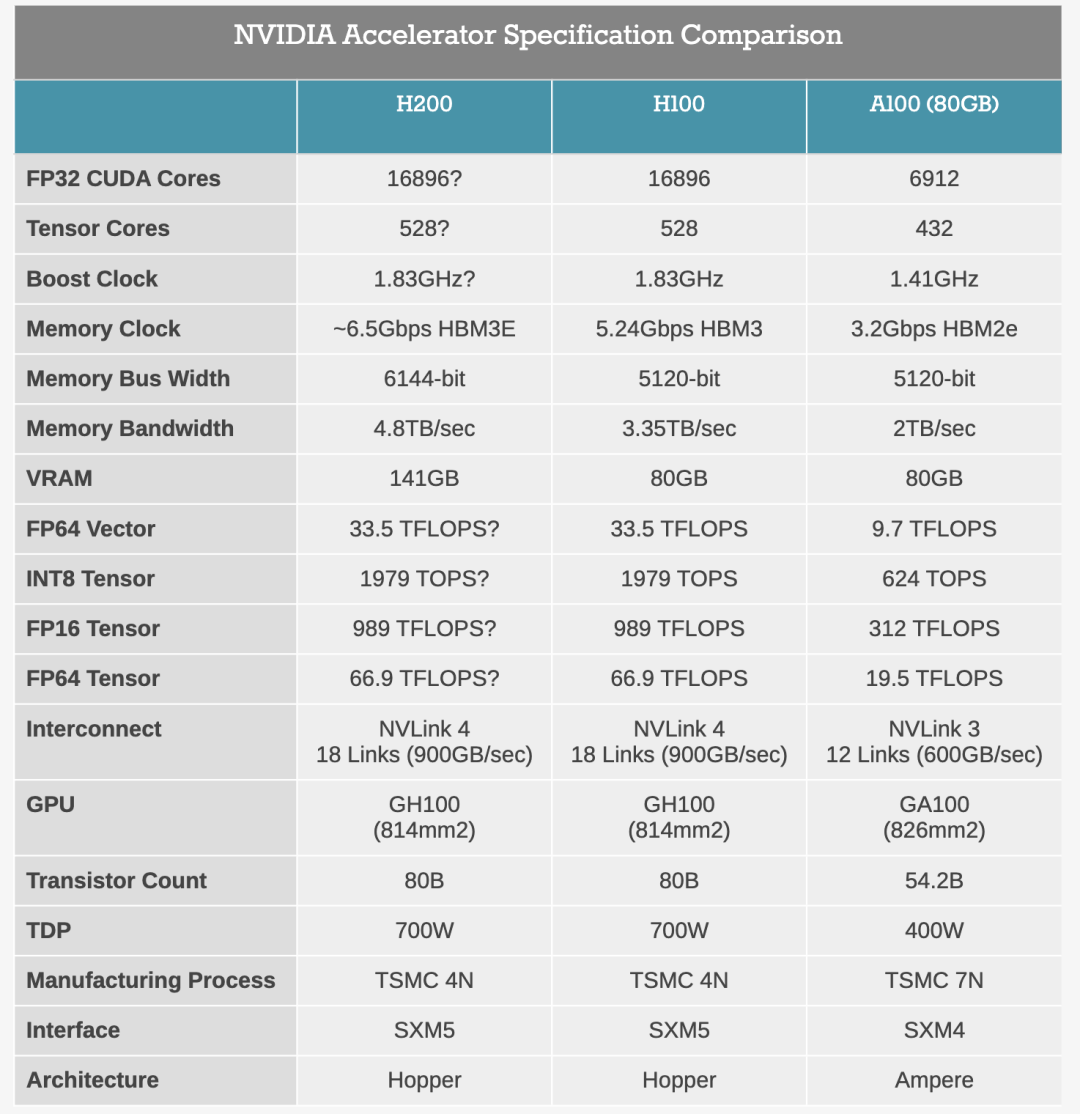

141 GB 超大显存!带宽增加 2.4 倍

H200 拥有141GB 显存!相比之前的 H100和A100,容量几乎翻倍!

NVIDIA H200 是首款提供 HBM3e 的 GPU,借助 HBM3e,NVIDIA H200 以每秒 4.8 TB 的速度提供 141GB 显存,带宽增加 2.4 倍。

H200可以轻松加速生成式 AI 和大语言模型,同时推进 HPC 工作负载的科学计算。

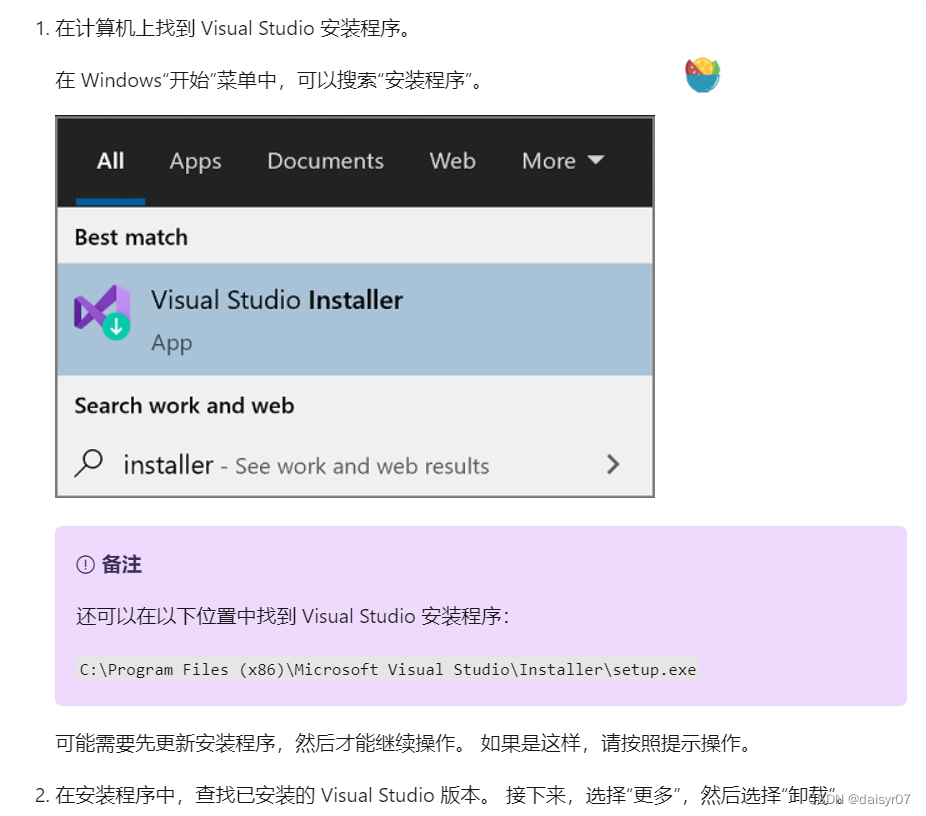

下面是H200和H100以及A100显卡的各参数对比图,可以清晰帮助大家看出H200各方面带来的提升。

兼容H100系统,轻松训练ChatGPT,Llama 2推理速度翻倍!

NVIDIA H200将在具有四路和八路配置的NVIDIA HGX H200服务器主板中提供,这些主板与HGX H100系统的硬件和软件兼容。它还可用于 8 月份发布的采用 HBM3e 的 NVIDIA GH200 Grace Hopper™ 超级芯片。

HGX H200 由 NVIDIA NVLink™ 和 NVSwitch™ 高速互连提供支持,可为各种应用工作负载提供最高性能,八路 HGX H200 提供超过 32 petaflops 的 FP8 深度学习计算和 1.1TB 聚合高带宽内存,可在生成式 AI 和 HPC 应用中实现最高性能。

大模型研究测试传送门

GPT-4传送门(免墙,可直接测试,遇浏览器警告点高级/继续访问即可):

http://hujiaoai.cn

对超过 1750 亿参数的ChatGPT等大语言模型进行训练和推理也不在话下!

具体到训练大模型方面有何提升呢?

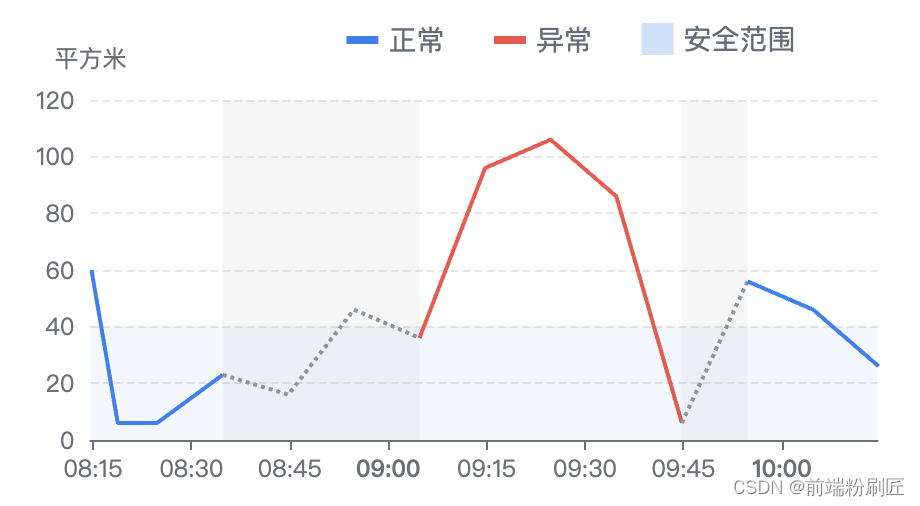

英伟达进行了官方测试——相比 H100 ,Llama 2的推理速度几乎翻倍!。

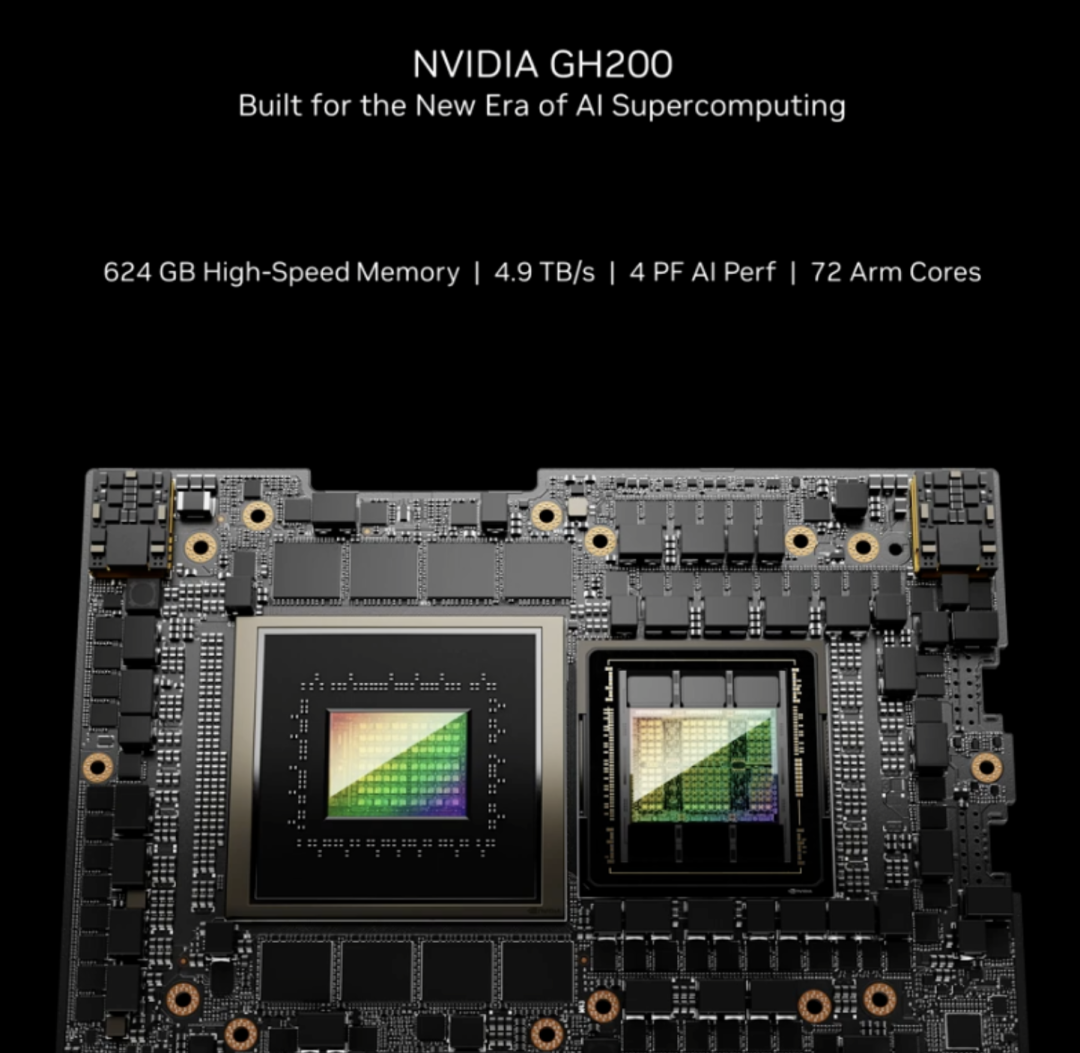

当用H200与英伟达GraceCPU搭配使用时,就能组成性能更强的GH200 Grace Hopper超级芯片,专为应用于大型HPC和AI应用!

新一代超算要来了!

NVIDIA还宣布与 Jupiter 合作赢得了一项新的超级计算机设计。根据 EuroHPC 联合组织的订购,Jupiter 将成为由 23,762 个 GH200 节点构建的新型超级计算机。

一旦上线,Jupiter 将成为迄今为止最大的基于 Hopper 的超级计算机,并且是第一台明确(且公开)针对标准 HPC 工作负载以及已经出现的低精度张量驱动的 AI 工作负载的超级计算机。

什么时候发货?

英伟达表示,H200将于2024年第二季度开始在全球服务器制造商和云服务提供商处发售。

首批部署H200的云服务提供商包括CoreWeave、Lambda、Vultr、AWS、谷歌云、微软Azure和甲骨文等。

国内大模型厂商怎么办?

真是不对比不知道差距啊!

英伟达发布了史上最强显卡H200 ,国内厂商能买到货吗!

估计是不抱希望了!

美国前阵子命令英伟达立即停止对华销售高性能AI芯片,国内多家大厂提前下单的超50亿美元芯片订单不知道还能不能收到货。

而这次的H200太强了,后面铁定上禁售名单。

另一方面,前几天英伟达绕过禁售令,将推出三款中国特供版AI芯片。

现在来看,都是鸡肋啊。

众所周知,搞大模型是离不开高性能显卡的,国内百模大战相比OpenAI最新发布的GPT-4 turbo没有一个能打的。

可以预料,本次H200发布之后,国内大模型相比国外的差距只会越来越大~

参考资料

https://arstechnica.com/information-technology/2023/11/nvidia-introduces-its-most-powerful-gpu-yet-designed-for-accelerating-ai/

https://nvidianews.nvidia.com/news/nvidia-supercharges-hopper-the-worlds-leading-ai-computing-platform?ncid=so-twit-685372

![idea报[Ubuntu] File watcher failed repeatedly and has been disabled](https://img-blog.csdnimg.cn/d6833dbb1ba144a28c9a360400751beb.png)