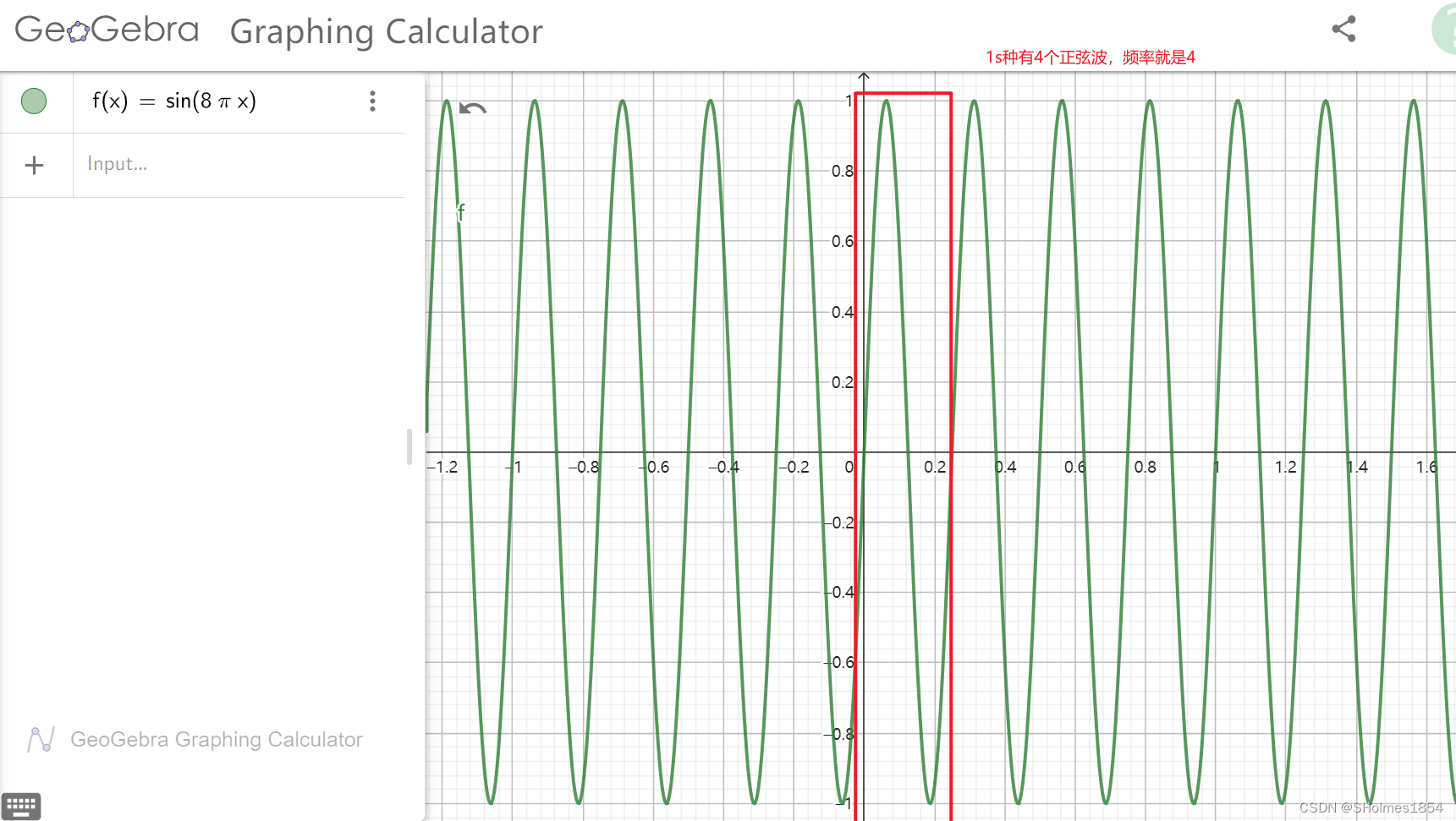

生成式AI和AIGC:

生成式AI所生成的内容就是AIGC

AI的Venn图:

注意:

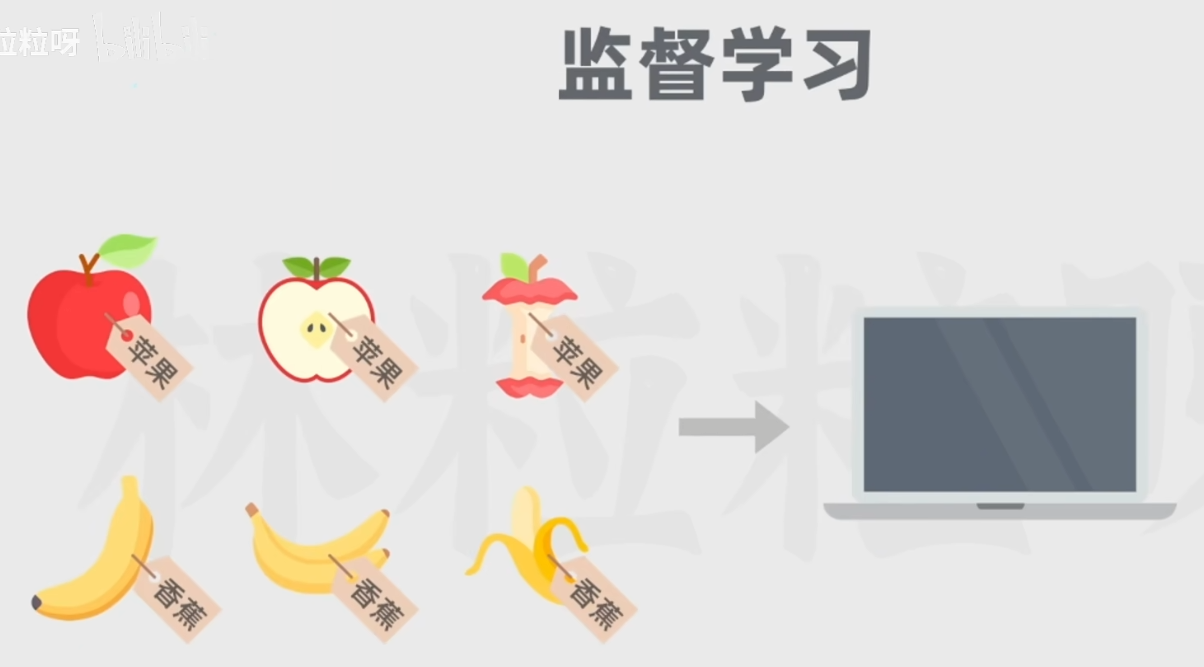

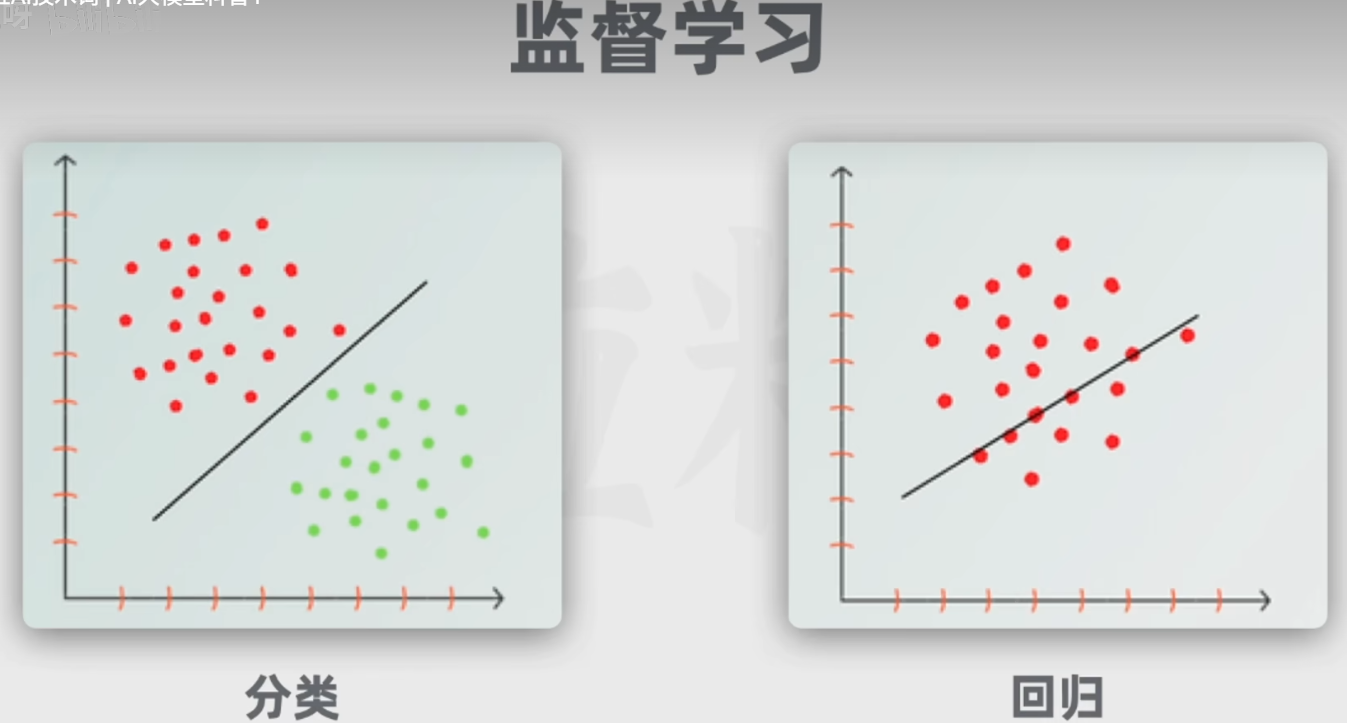

监督学习(训练数据带标签):

经典的监督学习任务包括分类(划分类别)和回归(预测):

无监督学习(不带标签):一般处理聚类任务

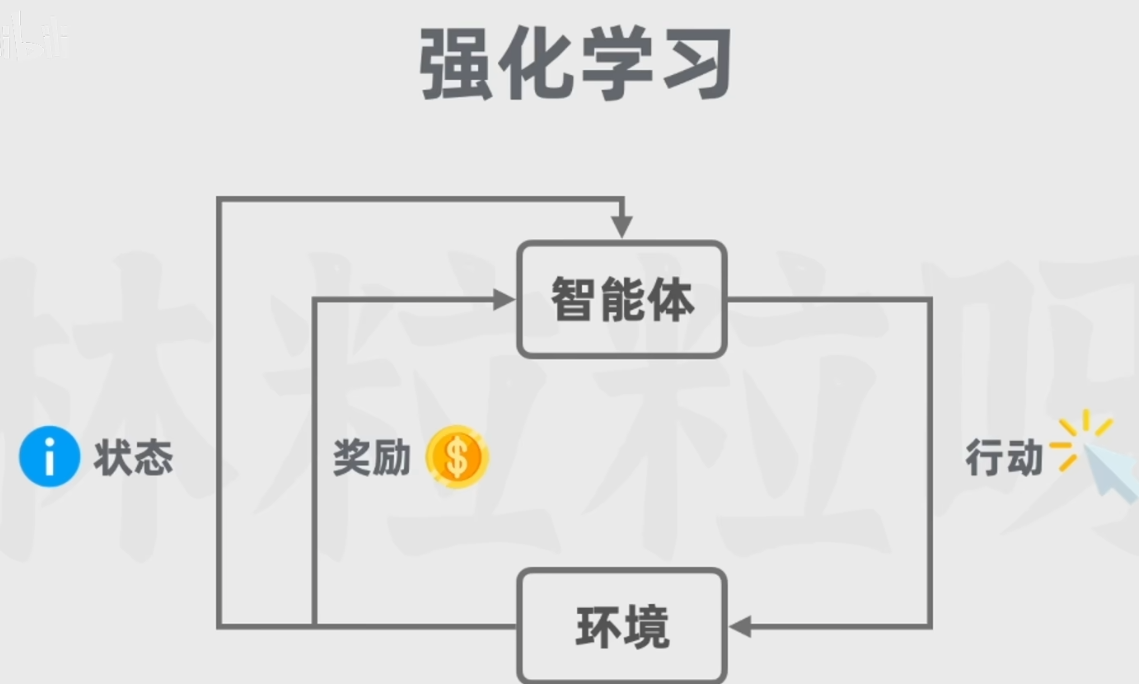

强化学习:

强化学习是一种通过主体(Agent)与环境(Environment)交互而进行学习的方法。它既不属于有监督学习,也不属于无监督学习。它的目标是要通过与环境(Environment)交互,根据环境的反馈(Reward),优化自己的策略(Policy),再根据策略行动(Action),以获得更多更好的反馈奖励(Reward)。

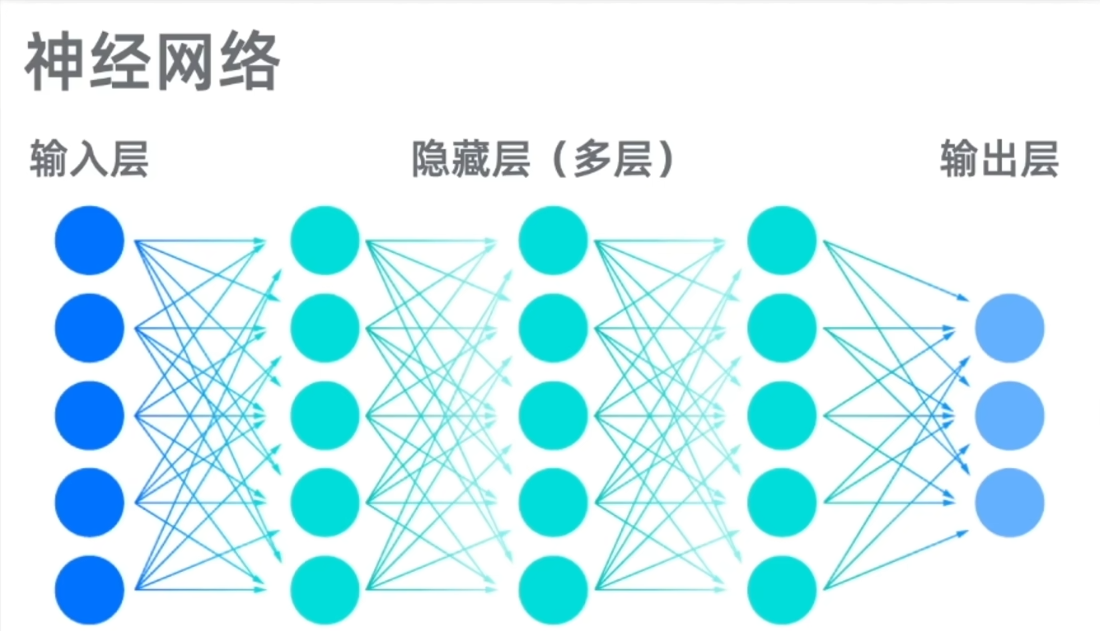

深度学习:

引入了神经元和神经网络的概念。

而生成式AI和大语言模型LLM都属于深度学习的一种应用,后者专门用于自然语言处理任务。

LLM中的大:参数多,高达数十亿;用于训练的数据多;

并非所有的生成式AI都属于大语言模型,如图像的扩散模型,并不输出文本;

大语言模型也不属于生成式AI,比如谷歌的BERT,不擅长长文本生成工作。

大语言模型LLM简介:

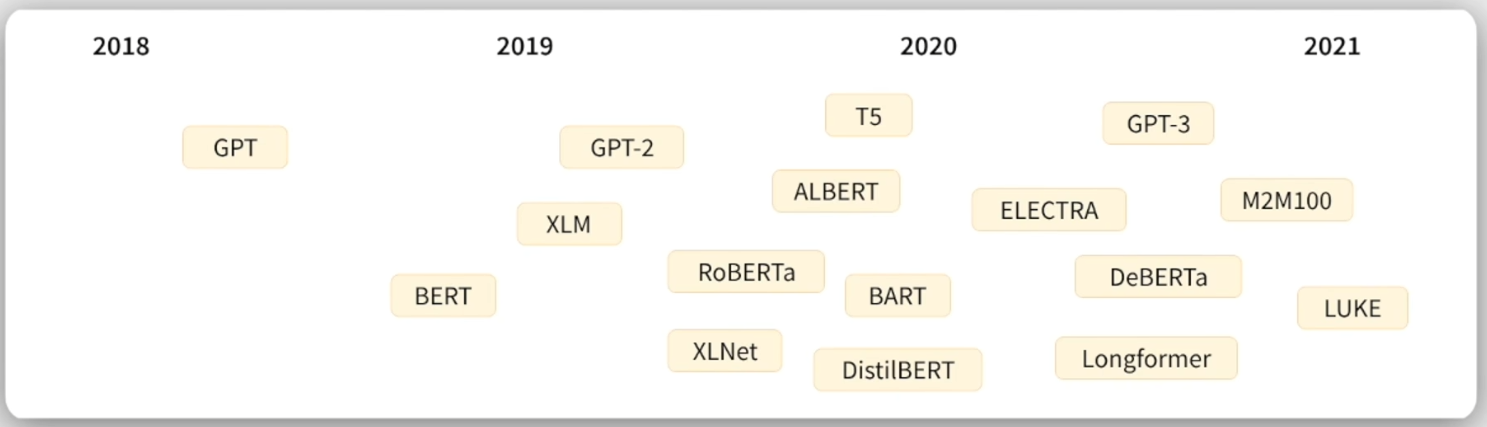

模型参数逐渐增加(泛化能力更强):

技术发展里程碑:

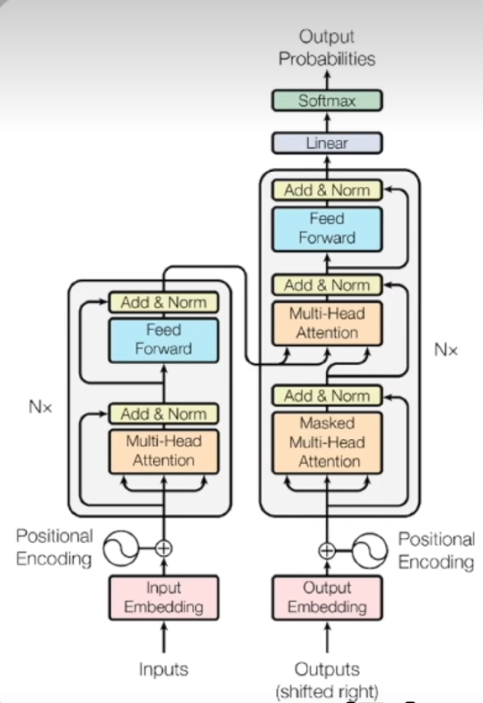

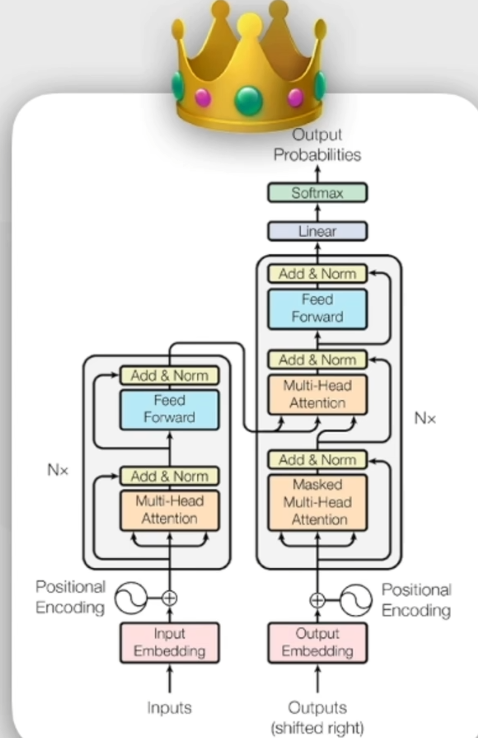

2017年6月,谷歌团队发表论文,提出transformer架构:

AI对话产品发展历程:

GPT全称:(生成式预训练Transformer)

GPT全称:(生成式预训练Transformer)

Transformer提出之前语言模型的主流架构:

Transformer提出之前语言模型的主流架构:

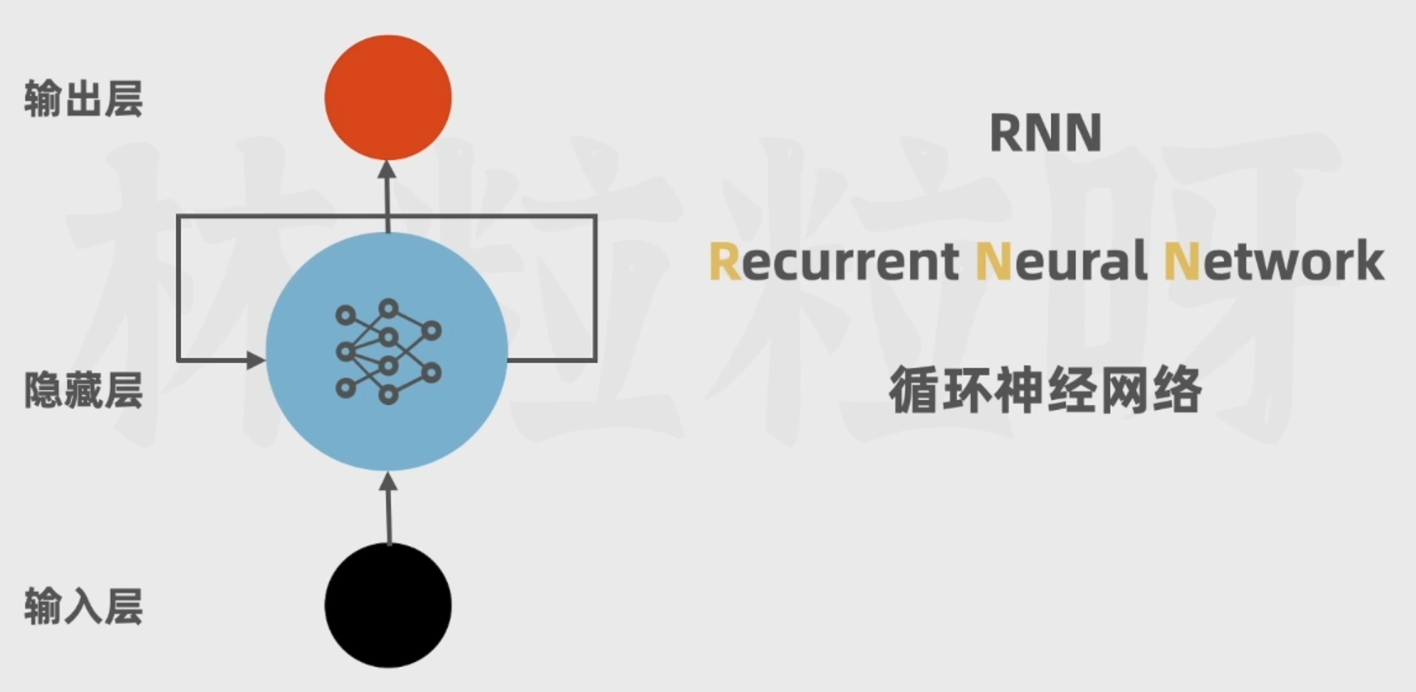

RNN(循环神经网络):

缺点:

无法并行运算,处理效率低;

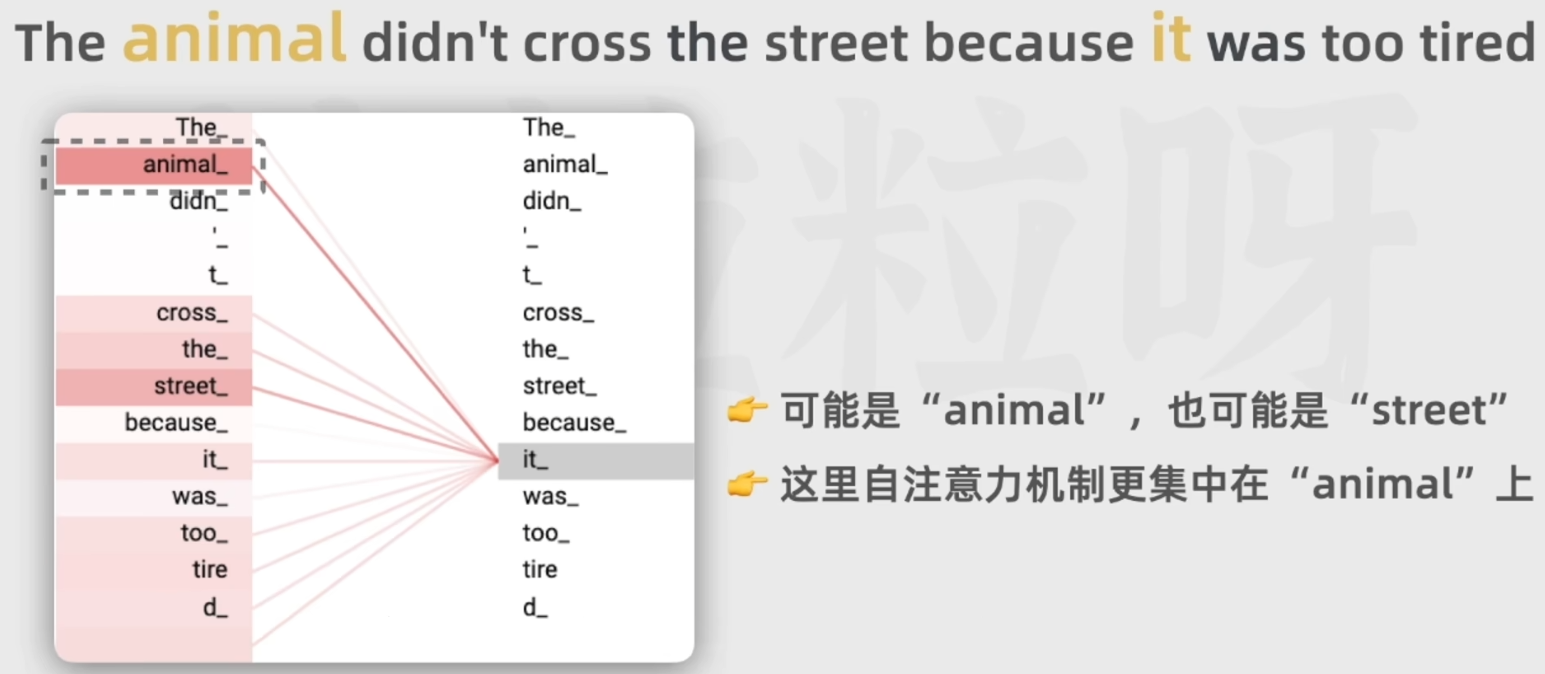

不擅长处理长文本,难以捕获长距离的语义关系;比如下面这个例子:

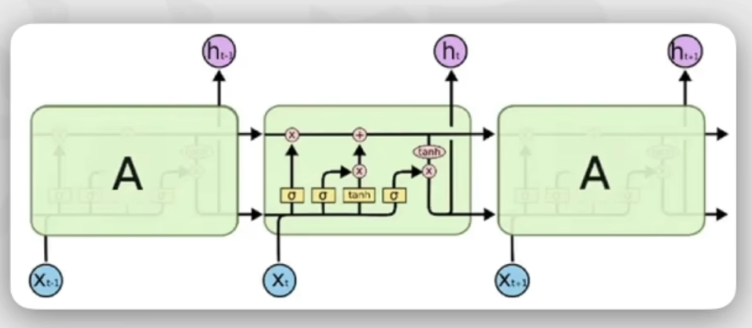

LSTM(长短时记忆网络):

缺点:

仍然无法解决并行计算问题;

对于超长序列,仍然不能有很好的效果。

Transformer:

引入自注意力机制:计算得到每一个词和其余所有词的相关性;

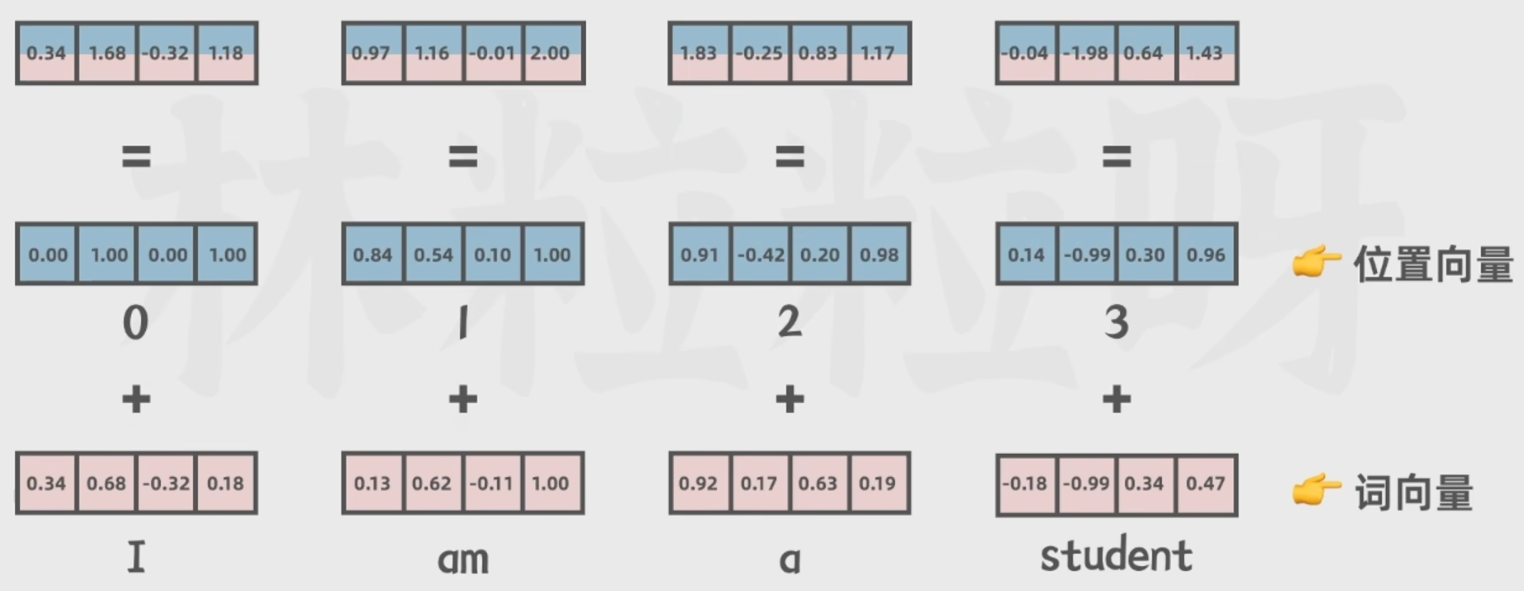

位置编码:规定了词在句子中出现的顺序,便于并行训练,提高速度。

有能力学习输入序列中的所有词的相关性和上下文,不会收到短时记忆的影响;

包括词向量(文本转换为数据)和位置向量(标注在句子中出现的顺序):