目录

1. BiFPN

1.1 FPN的演进

2. YOLOv8改进之更换BiFPN并融合P2小目标检测层

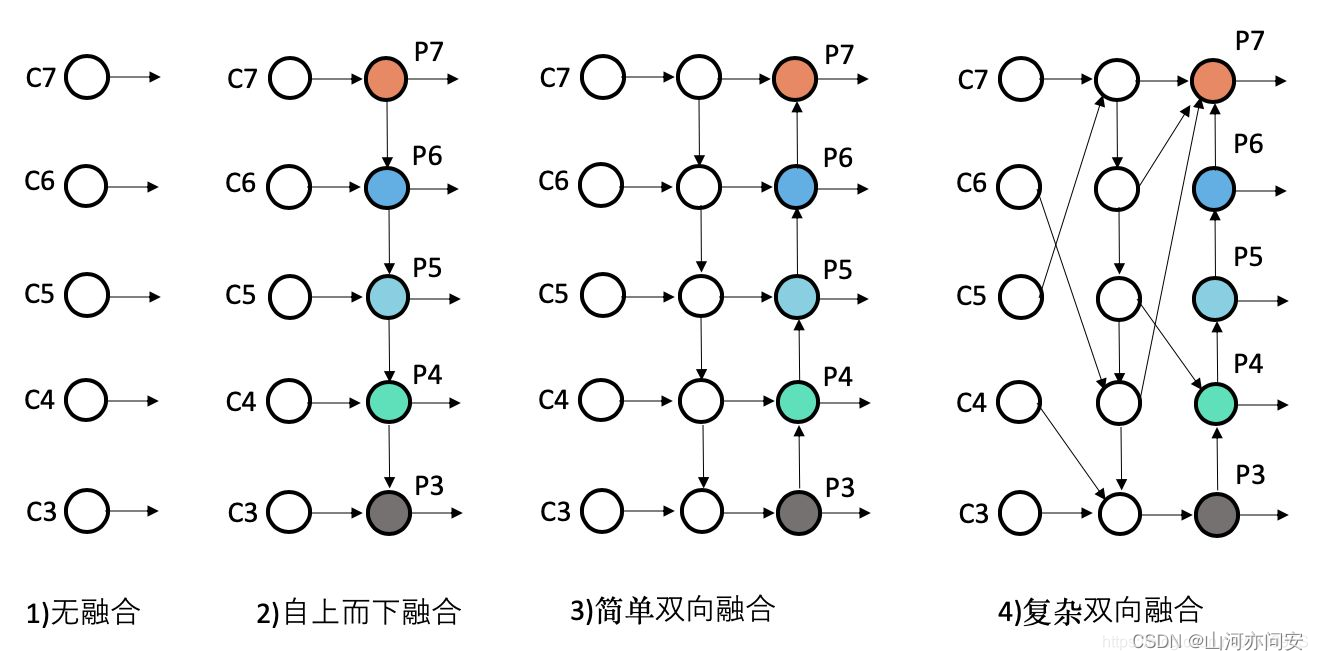

1. BiFPN

BiFPN(Bi-directional Feature Pyramid Network)是一种用于目标检测和语义分割任务的神经网络架构,旨在改善特征金字塔网络(Feature Pyramid Network, FPN)的性能。FPN是一种用于处理多尺度信息的网络结构,通常与骨干网络(如ResNet或EfficientNet)结合使用,以生成不同分辨率的特征金字塔,从而提高对象检测和分割的性能。BiFPN在此基础上进行了改进,以更好地捕获多尺度信息和提高模型性能。

以下是BiFPN的关键特点和工作原理:

-

双向连接: BiFPN引入了双向连接,允许信息在不同分辨率级别之间双向传播。这有助于更好地融合低级别和高级别特征,并促进了特征的上下文传播,从而提高了对象检测和分割的准确性。

-

自适应特征调整: BiFPN采用自适应的特征调整机制,可以学习权重,以调整不同层级的特征以更好地匹配不同任务的需求。这有助于改进特征融合的效果。

-

模块化设计: BiFPN的模块化设计使其易于嵌入到各种深度神经网络架构中,例如单发射点(Single Shot MultiBox Detector, SSD)、YOLO(You Only Look Once)、以及Mask R-CNN等。

-

高效性: BiFPN被设计为高效的模型,具有较少的参数和计算复杂度,使其适用于嵌入式设备和实际部署。

-

提高性能: BiFPN的引入通常能够显著提高对象检测和分割任务的性能,特别是对于小目标或复杂场景,其性能改进尤为显著。

总的来说,BiFPN是一种改进的特征金字塔网络结构,通过双向连接、自适应特征调整和模块化设计,提高了对象检测和语义分割任务的性能,使得神经网络能够更好地理解和解释多尺度信息,从而在计算机视觉任务中发挥更大的作用。

1.1 FPN的演进

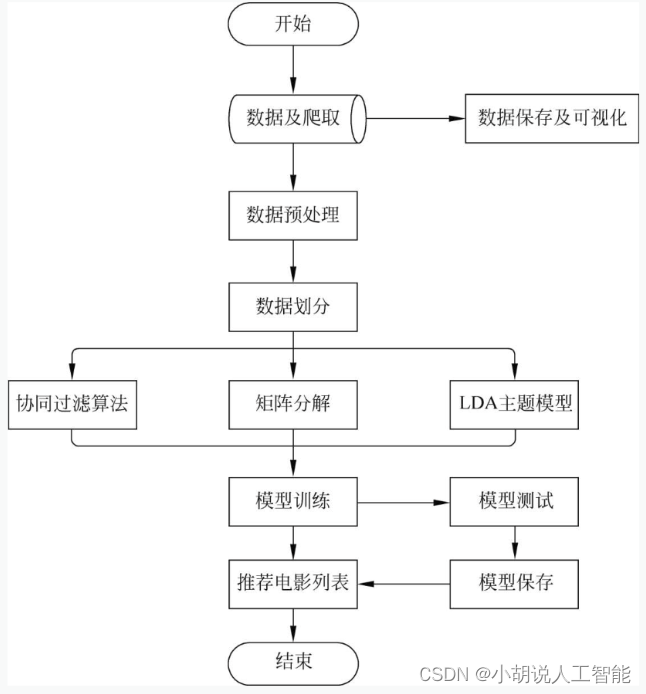

物体检测性能提升,一般主要通过数据增强、改进Backbone、改进FPN、改进检测头、改进loss、改进后处理等6个常用手段。

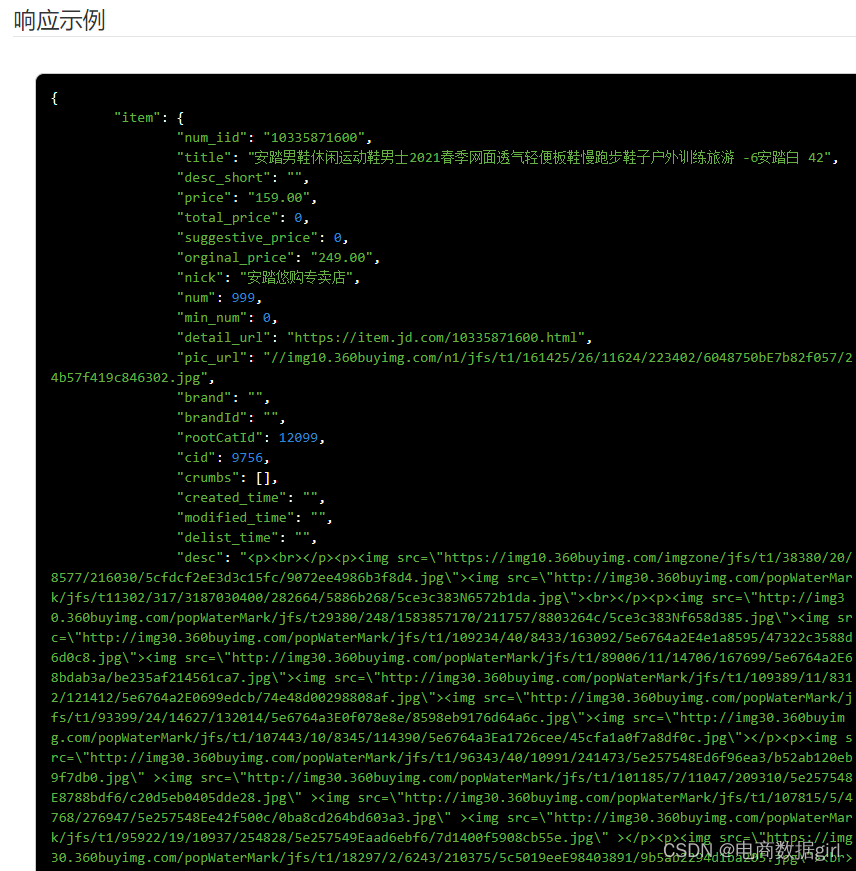

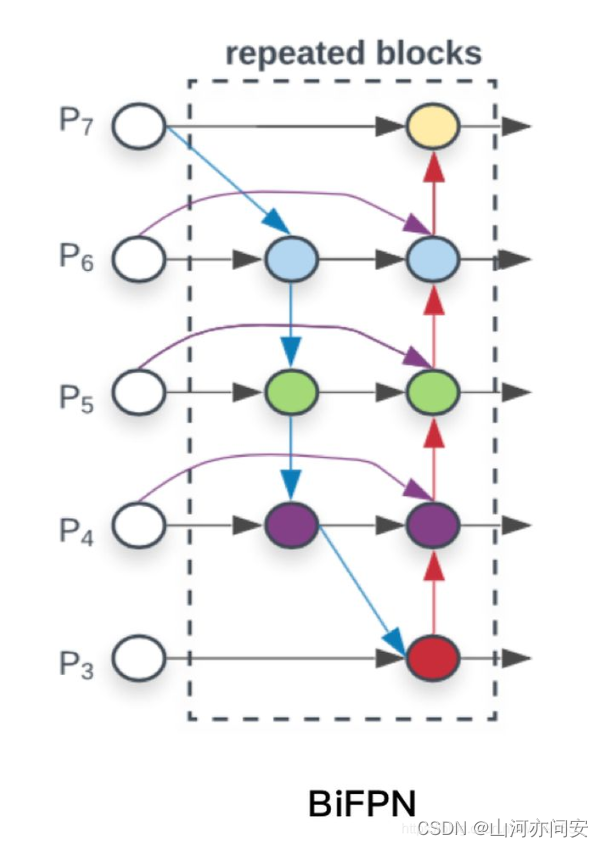

BiFPN的结构图如下所示:

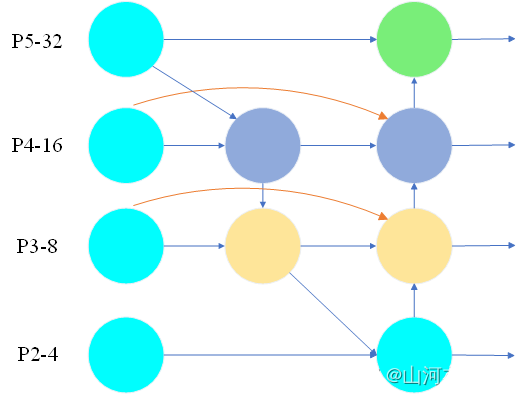

2. YOLOv8改进之更换BiFPN并融合P2小目标检测层

YOLOv8的改进,更换BiFPN(Bi-directional Feature Pyramid Network)并融合P2小目标检测层,具有以下好处:

-

提高小目标检测准确性: 引入P2小目标检测层使YOLOv8能够更有效地检测小目标物体。小目标通常在图像中占据较少的像素,因此更容易被忽略或误判。通过专门的P2层,YOLOv8能够更敏锐地检测和定位小目标,提高了小目标检测的准确性。

-

更好的多尺度信息融合: BiFPN的引入允许信息在不同分辨率级别之间双向传播,从而更好地融合多尺度信息。这有助于模型更全面地理解不同大小的目标,提高了对多尺度物体的检测性能。同时,它还改进了对物体的上下文理解,有助于减少误报或漏报。

这里不需要注册,只需要yaml文件即可,代码如下:

# Ultralytics YOLO 🚀, AGPL-3.0 license

# YOLOv8 object detection model with P3-P5 outputs. For Usage examples see https://docs.ultralytics.com/tasks/detect

# Parameters

nc: 80 # number of classes

scales: # model compound scaling constants, i.e. 'model=yolov8n.yaml' will call yolov8.yaml with scale 'n'

# [depth, width, max_channels]

n: [0.33, 0.25, 1024] # YOLOv8n summary: 225 layers, 3157200 parameters, 3157184 gradients, 8.9 GFLOPs

s: [0.33, 0.50, 1024] # YOLOv8s summary: 225 layers, 11166560 parameters, 11166544 gradients, 28.8 GFLOPs

m: [0.67, 0.75, 768] # YOLOv8m summary: 295 layers, 25902640 parameters, 25902624 gradients, 79.3 GFLOPs

l: [1.00, 1.00, 512] # YOLOv8l summary: 365 layers, 43691520 parameters, 43691504 gradients, 165.7 GFLOPs

x: [1.00, 1.25, 512] # YOLOv8x summary: 365 layers, 68229648 parameters, 68229632 gradients, 258.5 GFLOPs

# YOLOv8.0n backbone

backbone:

# [from, repeats, module, args]

- [-1, 1, Conv, [64, 3, 2]] # 0-P1/2

- [-1, 1, Conv, [128, 3, 2]] # 1-P2/4

- [-1, 3, C2f, [128, True]]

- [-1, 1, Conv, [256, 3, 2]] # 3-P3/8

- [-1, 6, C2f, [256, True]]

- [-1, 1, Conv, [512, 3, 2]] # 5-P4/16

- [-1, 6, C2f, [512, True]]

- [-1, 1, Conv, [1024, 3, 2]] # 7-P5/32

- [-1, 3, C2f, [1024, True]]

- [-1, 1, SPPF, [1024, 5]] # 9

# YOLOv8.0n head

head:

- [4, 1, Conv, [256]] # 10

- [6, 1, Conv, [256]] # 11

- [9, 1, Conv, [256]] # 12

- [-1, 1, nn.Upsample, [None, 2, 'nearest']]

- [[-1, 11], 1, Concat, [1]]

- [-1, 3, C2f, [256]] # 15

- [-1, 1, nn.Upsample, [None, 2, 'nearest']]

- [[-1, 10], 1, Concat, [1]]

- [-1, 3, C2f, [256]]

- [-1, 1, nn.Upsample, [None, 2, 'nearest']] #19

- [2, 1, Conv, [256]]

- [[-1, 19], 1, Concat, [1]]

- [-1, 3, C2f, [256]] #22

- [-1, 1, Conv, [256, 3, 2]]

- [[-1, 10, 18], 1, Concat, [1]]

- [-1, 3, C2f, [256]] # 25

- [-1, 1, Conv, [256, 3, 2]]

- [[-1, 11, 15], 1, Concat, [1]]

- [-1, 3, C2f, [256]] # 28

- [-1, 1, Conv, [256, 3, 2]]

- [[-1, 12], 1, Concat, [1]]

- [-1, 3, C2f, [256]] # 31

- [[22, 25, 28,31], 1, Detect, [nc]] # Detect(P2, P3, P4, P5)